【项目系列】十次方项目(一):后端

第1章 - 项目介绍和工程搭建

学习目标:

- 了解十次方项目需求;

- 了解前后端分离开发模式

- 理解RESTful

- 完成项目开发环境搭建

- 完成父工程、公共模块和文章微服务的搭建

- 掌握mybatis plus的使用,并开发完成文章微服务中文章的增删改查功能

- 掌握公共异常处理类的使用

1 十次方项目需求分析

1.1 项目介绍

十次方是程序员的专属社交平台,包括头条、问答、活动、交友、吐槽、招聘六大频道。

十次方名称的由来:2的10次方为1024,程序员都懂的。

如果你是一位技术大咖,那么赶快发布文章,增加知名度吧。

如果你是一名技术小白,那么赶快到问答频道寻求帮助的,这里高手如云哦!

如果你不想错过各种技术交流会,那么请经常关注活动频道吧。

如果你还是单身,那么赶快到交友频道找到你心仪的另一半。

如果你有太多的苦恼,那么赶快吐个槽吧。

如果你正在找工作或是想跳槽拿高薪,那么来招聘频道淘金吧。

1.2 项目需求

详见: 资源\文档\十次方需求规格说明书.docx

2 系统设计

2.1 开发模式

十次方项目采用前后端分离的开发模式

2.2 技术选型

后端:springboot + springcloud + mybatis plus + mysql5.7

前端:nodejs + NUXT + elementUI + vue

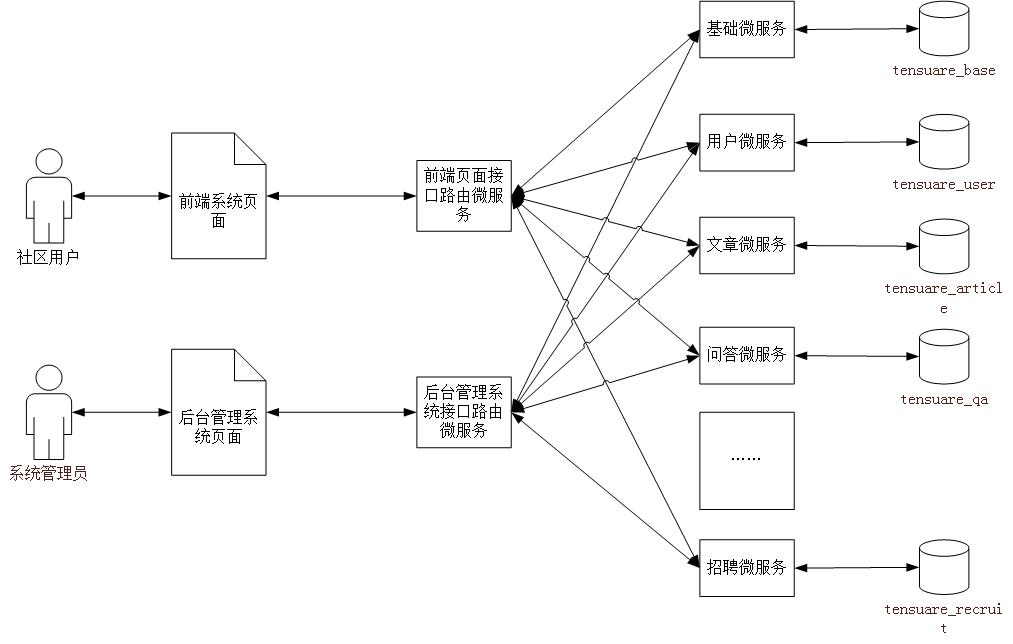

2.3 技术架构

采用前后端分离的系统架构

2.4 微服务模块划分

| 模块名称 | 模块中文名称 |

|---|---|

| tensquare_common | 公共模块 |

| tensquare_base | 基础微服务 |

| tensquare_article | 文章微服务 |

| tensquare_friend | 交友微服务 |

| tensquare_gathering | 活动微服务 |

| tensquare_qa | 问答微服务 |

| tensquare_recruit | 招聘微服务 |

| tensquare_user | 用户微服务 |

| tensquare_spit | 吐槽微服务 |

| tensquare_search | 搜索微服务 |

| tensquare_web | 前台微服务网关 |

| tensquare_manager | 后台微服务网关 |

| tensquare_eureka | 注册中心 |

| tensquare_config | 配置中心 |

| tensquare_sms | 短信微服务 |

| tensquare_notice | 消息通知微服务 |

2.5 数据库表结构分析

采用的分库分表设计,每个微服务模块为1个独立的数据库。

tensquare_article 文章

tensquare_base 基础

tensquare_friend 交友

tensquare_gathering 活动

tensquare_qa 问答

tensquare_recruit 招聘

tensquare_user 用户

tensquare_spit 吐槽

详见 资源\文档\十次方数据库文档.xlsx

2.6 API文档

课程提供了前后端开发接口文档(采用Swagger语言进行编写),并与Nginx进行了整 合。双击Nginx执行文件启动后,在地址栏输入http://localhost:801 即可访问API文档

前后端约定的返回码列表:

| 状态描述 | 返回码 |

|---|---|

| 成功 | 20000 |

| 失败 | 20001 |

| 用户名或密码错误 | 20002 |

| 权限不足 | 20003 |

| 远程调用失败 | 20004 |

| 重复操作 | 20005 |

3 RESTful架构说明

3.1 何为RESTful

RESTful架构是目前最流行的一种互联网软件架构

是Roy Thomas Fielding在他2000年的博士论文中提出的

是Representational State Transfer的缩写,翻译过来是”表现层状态转化”

是所有Web应用都应该遵守的架构设计指导原则

7个HTTP方法:GET、POST、PUT、DELETE、PATCH、HEAD、OPTIONS

3.2 接口规范

十次方项目使用GET、POST、PUT、DELETE四种方法

幂等性:不论你请求多少次,资源的状态是一样的。

3.2.1 GET

- 安全且幂等

- 获取表示

- 变更时获取表示(缓存)

==适合查询类的接口使用==

3.2.2 POST

- 不安全且不幂等

- 使用服务端管理的(自动产生)的实例号创建资源

- 创建子资源

- 部分更新资源

- 如果没有被修改,则不过更新资源(乐观锁)

==适合数据提交类的接口使用==

3.2.3 PUT

- 不安全但幂等

- 用客户端管理的实例号创建一个资源

- 通过替换的方式更新资源

- 如果未被修改,则更新资源(乐观锁)

==适合更新数据的接口使用==

3.2.4 DELETE

- 不安全但幂等

- 删除资源

==适合删除数据的接口使用==

请求返回响应码:

| 代码 | 含义 |

|---|---|

| ==200== | (OK)- 如果现有资源已被更改 |

| 201 | (created)- 如果新资源被创建 |

| 202 | (accepted)- 已接受处理请求但尚未完成(异步处理) |

| 301 | (Moved Permanently)- 资源的URI被更新 |

| 303 | (See Other)- 其他(如,负载均衡) |

| ==400== | (bad request)- 指代坏请求 |

| ==404== | (not found)- 资源不存在 |

| 406 | (not acceptable)- 服务端不支持所需表示 |

| 409 | (conflict)- 通用冲突 |

| 412 | (Precondition Failed)- 前置条件失败(如执行条件更新时的冲突) |

| 415 | (unsupported media type)- 接受到的表示不受支持 |

| ==500== | (internal server error)- 通用错误响应 |

| 503 | (Service Unavailable)- 服务当前无法处理请求 |

4 项目开发准备

4.1 开发环境

- 虚拟系统环境 VMware Workstation

- 虚拟机系统 CentOS 7

- 容器 docker

- JDK1.8

- 数据库 mysql 5.7

- 开发工具 idea

- 项目构建工具 maven

所有的第三方工具如mysql等都是运行在docker容器中的

1 | 注:虚拟机的帐户名root 密码itcast |

4.2 mysql建库建表

进入安装了docker的虚拟机中,按以下顺序执行命令

(1)下载镜像(此步可省略)

1 | docker pull centos/mysql‐57‐centos7 |

注:docker默认从国外的镜像网站拉取镜像,速度很慢。可以使用国内的阿里云镜像加速站点提升镜像拉取速度。具体步骤可以参考文档

docker配置国内镜像加速站点.pdf

(2)创建容器

1 | docker run -di --name=tensquare_mysql -p 3306:3306 -e MYSQL_ROOT_PASSWORD=root centos/mysql-57-centos7 |

(3)连接MYSQL ,并执行资料中的建表脚本,创建article数据库

4.3 接口测试工具postman

postman是一款强大网页调试工具

- 能够发送任何类型的HTTP 请求 (GET,HEAD, POST,PUT。。。)

- 附带任意数量的参数

5 项目工程搭建

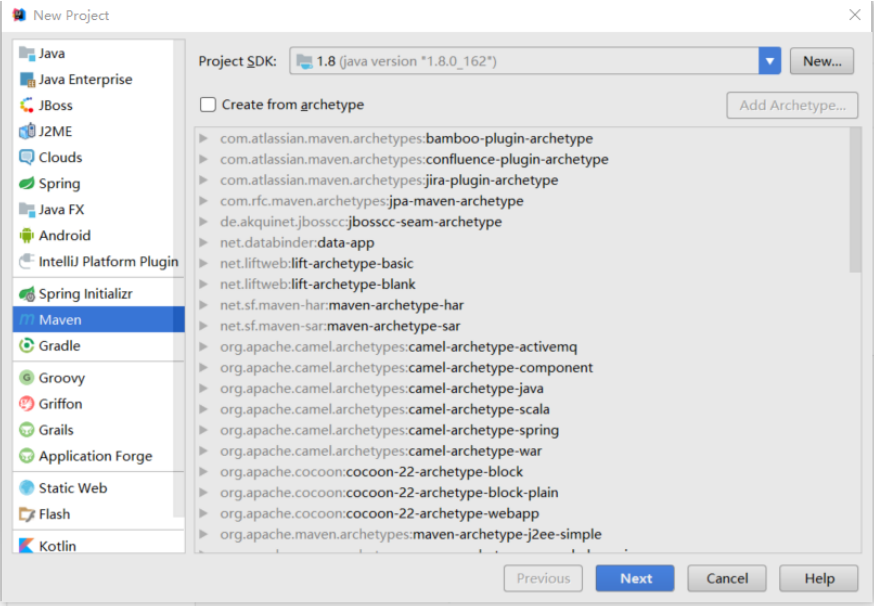

5.1 父工程搭建

创建项目类型为maven的父工程

打开idea开发工具

选择菜单file-new project ,弹出窗口中左侧菜单选择Maven ,点击next按钮

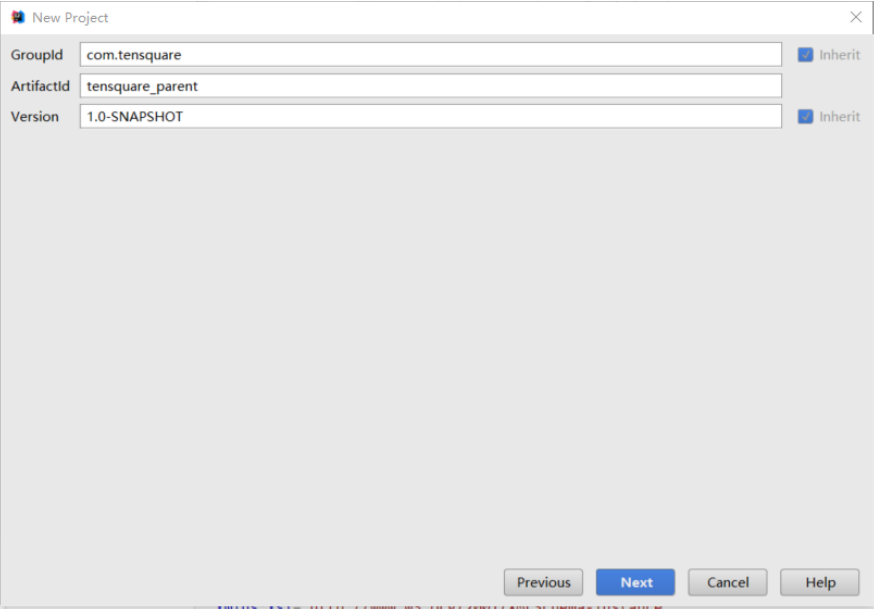

GroupId填写com.tensquare,ArtifacetId填写tensquare_parent,点击next按钮

点击Finish 完成

修改pom.xml文件,添加以下内容

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68<parent>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-parent</artifactId>

<version>2.1.4.RELEASE</version>

<relativePath/>

</parent>

<properties>

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

<project.reporting.outputEncoding>UTF-8</project.reporting.outputEncoding>

<java.version>1.8</java.version>

<maven.compiler.source>1.8</maven.compiler.source>

<maven.compiler.target>1.8</maven.compiler.target>

<mybatisplus-spring-boot-starter.version>1.0.5</mybatisplus-spring-boot-starter.version>

<mybatisplus.version>2.2.0</mybatisplus.version>

<fastjson.version>1.2.39</fastjson.version>

<gson.version>2.8.0</gson.version>

</properties>

<dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

<scope>test</scope>

</dependency>

</dependencies>

<repositories>

<repository>

<id>spring-snapshots</id>

<name>Spring Snapshots</name>

<url>https://repo.spring.io/snapshot</url>

<snapshots>

<enabled>true</enabled>

</snapshots>

</repository>

<repository>

<id>spring-milestones</id>

<name>Spring Milestones</name>

<url>https://repo.spring.io/milestone</url>

<snapshots>

<enabled>false</enabled>

</snapshots>

</repository>

</repositories>

<pluginRepositories>

<pluginRepository>

<id>spring-snapshots</id>

<name>Spring Snapshots</name>

<url>https://repo.spring.io/snapshot</url>

<snapshots>

<enabled>true</enabled>

</snapshots>

</pluginRepository>

<pluginRepository>

<id>spring-milestones</id>

<name>Spring Milestones</name>

<url>https://repo.spring.io/milestone</url>

<snapshots>

<enabled>false</enabled>

</snapshots>

</pluginRepository>

</pluginRepositories>

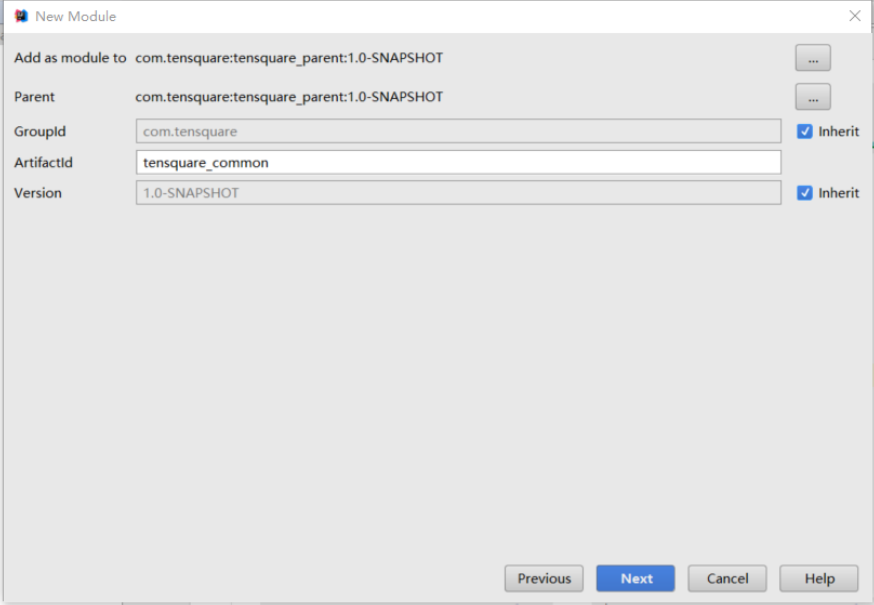

5.2 搭建公共子模块

5.2.1 搭建子模块步骤

右键点击父工程tensquare_parent,选择 New -> Module 弹出窗口选择Maven ,点击next按钮

ArtifacetId填写tensquare_common,点击next按钮

点击finish

5.2.2 创建公共实体类和工具类

新建com.tensquare.entity包,包下创建Result类,用于controller返回结果

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56public class Result {

private boolean flag;//是否成功

private Integer code;// 返回码

private String message;//返回信息

private Object data;// 返回数据

public Result(boolean flag, Integer code, String message, Object data) {

super();

this.flag = flag;

this.code = code;

this.message = message;

this.data = data;

}

public Result() { }

public Result(boolean flag, Integer code, String message) {

super();

this.flag = flag;

this.code = code;

this.message = message;

}

public boolean isFlag() {

return flag;

}

public void setFlag(boolean flag) {

this.flag = flag;

}

public Integer getCode() {

return code;

}

public void setCode(Integer code) {

this.code = code;

}

public String getMessage() {

return message;

}

public void setMessage(String message) {

this.message = message;

}

public Object getData() {

return data;

}

public void setData(Object data) {

this.data = data;

}

}创建类PageResult ,用于返回分页结果

1

2

3

4

5

6

7

8

9

10

11

12public class PageResult<T> {

private Long total;

private List<T> rows;

public PageResult(Long total, List<T> rows) {

super();

this.total = total;

this.rows = rows;

}

//getter and setter ....

}返回码定义类

1

2

3

4

5

6

7

8public class StatusCode {

public static final int OK=20000;//成功

public static final int ERROR =20001;//失败

public static final int LOGINERROR =20002;//用户名或密码错误

public static final int ACCESSERROR =20003;//权限不足

public static final int REMOTEERROR =20004;//远程调用失败

public static final int REPERROR =20005;//重复操作

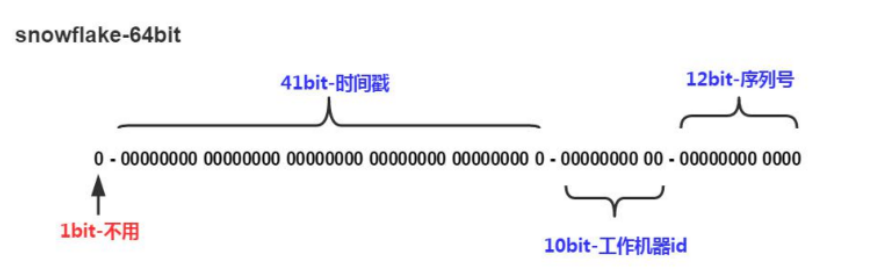

}分布式ID生成器

课程中已经提供了分布式ID生成器

资源\微服务相关\工具类\IdWorker.java

tensquare_common工程创建util包,将IdWorker.java直接拷贝到tensquare_common工程的util包中。

不能使用数据库本身的自增功能来产生主键值,原因是生产环境为分片部署的。

使用snowflake (雪花)算法(twitter出品)生成***唯一***的主键值

- 41bit的时间戳可以支持该算法使用到2082年

- 10bit的工作机器id可以支持1024台机器

- 序列号支持1毫秒产生4096个自增序列id

- 整体上按照时间自增排序

- 整个分布式系统内不会产生ID碰撞

- 每秒能够产生26万ID左右

6 文章微服务-文章管理

6.1 模块搭建

在tensquare_parent项目下创建tensquare_article模块,创建过程参考第4.2节公共子模块的创建过程

修改tensquare_article模块的pom.xml文件,添加以下依赖

1

2

3

4

5

6

7

8

9

10

11<dependencies>

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

</dependency>

<dependency>

<groupId>com.tensquare</groupId>

<artifactId>tensquare_common</artifactId>

<version>1.0-SNAPSHOT</version>

</dependency>

</dependencies>创建com.tensquare.article包,并创建BaseApplication启动类

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17package com.tensquare.article;

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.context.annotation.Bean;

import util.IdWorker;

@SpringBootApplication

public class ArticleApplication {

public static void main(String[] args) {

SpringApplication.run(ArticleApplication.class, args);

}

@Bean

public IdWorker idWorker(){

return new IdWorker(1,1);

}

}在resources文件夹下创建application.yml,并添加以下内容

1

2

3

4

5

6

7

8

9

10server:

port: 9004

spring:

application:

name: tensquare-article #指定服务名

datasource:

driver-class-name: com.mysql.jdbc.Driver

url: jdbc:mysql://192.168.200.129:3306/tensquare_article?characterEncoding=utf-8

username: root

password: root

6.2 文章管理-CRUD

6.2.1 表结构分析

tensquare_article数据库,tb_article表

| 文章表 | tb_article | ||

|---|---|---|---|

| 字段名称 | 字段含义 | 字段类型 | 备注 |

| id | ID | 文本 | |

| columnid | 专栏ID | 文本 | |

| userid | 用户ID | 文本 | |

| title | 文章标题 | 文本 | |

| content | 文章内容 | 文本 | |

| image | 文章封面 | 文本 | |

| createtime | 发表日期 | 日期 | |

| updatetime | 修改日期 | 日期 | |

| ispublic | 是否公开 | 文本 | 0:不公开 |

| istop | 是否置顶 | 文本 | 0:不置顶 |

| visits | 浏览量 | 整型 | |

| thumbup | 点赞数 | 整型 | |

| comment | 评论数 | 整型 | |

| state | 审核状态 | 文本 | 0:未审核 1:已审核 |

| channelid | 所属频道 | 整型 | 关联频道表ID |

| url | URL地址 | 文本 | |

| type | 文章类型 | 文本 | 0:分享 |

6.2.2 集成mybatis plus

mybatis plus概述

- 是对Mybatis框架的二次封装和扩展

- 纯正血统:完全继承原生 Mybatis 的所有特性

- 最少依赖:仅仅依赖Mybatis以及Mybatis-Spring

- 性能损耗小:启动即会自动注入基本CURD ,性能无损耗,直接面向对象操作

- 自动热加载:Mapper对应的xml可以热加载,大大减少重启Web服务器时间,提升开发效率

- 性能分析:自带Sql性能分析插件,开发测试时,能有效解决慢查询

- 全局拦截:提供全表delete、update操作智能分析阻断

- 避免Sql注入:内置Sql注入内容剥离器,预防Sql注入攻击

在pom.xml文件中引入相关依赖

1

2

3

4

5

6

7

8

9

10

11

12<!-- mybatis-plus begin -->

<dependency>

<groupId>com.baomidou</groupId>

<artifactId>mybatisplus-spring-boot-starter</artifactId>

<version>${mybatisplus-spring-boot-starter.version}</version>

</dependency>

<dependency>

<groupId>com.baomidou</groupId>

<artifactId>mybatis-plus</artifactId>

<version>${mybatisplus.version}</version>

</dependency>

<!-- mybatis-plus end -->在配置文件application.yml中添加相关配置

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15# Mybatis-Plus 配置

mybatis-plus:

# mapper-locations: classpath:/mapper/*Mapper.xml

#实体扫描,多个package用逗号或者分号分隔

typeAliasesPackage: com.tensquare.article.pojo

global-config:

id-type: 1 #0:数据库ID自增 1:用户输入id

db-column-underline: false

refresh-mapper: true

configuration:

map-underscore-to-camel-case: true

cache-enabled: true #配置的缓存的全局开关

lazyLoadingEnabled: true #延时加载的开关

multipleResultSetsEnabled: true #开启延时加载,否则按需加载属性

log-impl: org.apache.ibatis.logging.stdout.StdOutImpl #打印sql语句,调试用修改启动类,增加Mapper扫描注解

1

2

3

4

5

6

7

8

9

10

11

12

13@SpringBootApplication

//Mapper扫描注解

@MapperScan("com.tensquare.article.dao")

public class ArticleApplication {

public static void main(String[] args) {

SpringApplication.run(ArticleApplication.class, args);

}

@Bean

public IdWorker idWorker() {

return new IdWorker(1, 1);

}

}

6.2.3 实现查询所有文章和根据id号查询文章功能

在com.tensquare.article包下面创建pojo包,并创建Article实体类

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35package com.tensquare.article.pojo;

import com.baomidou.mybatisplus.annotations.TableId;

import com.baomidou.mybatisplus.annotations.TableName;

import com.baomidou.mybatisplus.enums.IdType;

import java.io.Serializable;

import java.util.Date;

@TableName("tb_article")

public class Article implements Serializable {

@TableId(type = IdType.INPUT)

private String id;//ID

private String columnid; //专栏ID

private String userid; //用户ID

private String title; //标题

private String content; //文章正文

private String image; //文章封面

private Date createtime; //发表日期

private Date updatetime; //修改日期

private String ispublic; //是否公开

private String istop; //是否置顶

private Integer visits; //浏览量

private Integer thumbup; //点赞数

private Integer comment; //评论数

private String state; //审核状态

private String channelid; //所属频道

private String url; //URL

private String type; //类型

//getters and setters

}编写数据访问接口dao

1

2public interface ArticleDao extends BaseMapper<Article> {

}编写service

1

2

3

4

5

6

7

8

9

10

11

12

13

14@Service

public class ArticleService {

@Autowired

private ArticleDao articleDao;

public List<Article> findAll() {

return articleDao.selectList(null);

}

public Article findById(String id) {

return articleDao.selectById(id);

}

}编写controller

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19@RestController

@RequestMapping("/article")

public class ArticleController {

@Autowired

private ArticleService articleService;

@RequestMapping(method = RequestMethod.GET)

public Result findAll() {

List list = articleService.findAll();

return new Result(true, StatusCode.OK, "查询成功", list);

}

@RequestMapping(value = "/{id}", method = RequestMethod.GET)

public Result findById(@PathVariable String id) {

Article Article = articleService.findById(id);

return new Result(true, StatusCode.OK, "查询成功", Article);

}

}

6.2.4 添加文章、修改文章和删除文章

添加文章 ArticleController中添加代码

1

2

3

4

5

6

7//新增标签数据接口

@RequestMapping(method = RequestMethod.POST)

public Result add(@RequestBody Article article) {

articleService.add(article);

return new Result(true, StatusCode.OK, "添加成功");

}ArticleService中添加代码

1

2

3

4

5

6

7@Autowired

private IdWorker idWorker;

public void add(Article article) {

article.setId(idWorker.nextId() + "");

articleDao.insert(article);

}修改文章

ArticleController中添加代码

1

2

3

4

5

6

7//修改标签数据接口

@RequestMapping(value = "{id}", method = RequestMethod.PUT)

public Result update(@PathVariable String id, @RequestBody Article article) {

article.setId(id);

articleService.update(article);

return new Result(true, StatusCode.OK, "修改成功");

}ArticleService中添加代码

1

2

3

4

5

6

7

8

9

10public void update(Article article) {

//根据id号更新

//方法1

articleDao.updateById(article);

//方法2

EntityWrapper wrapper = new EntityWrapper<Article>();

wrapper.eq("id", article.getId());

articleDao.update(article, wrapper);

}删除文章

ArticleController中添加代码

1

2

3

4

5

6

7//删除文章数据接口

@RequestMapping(value = "{id}", method = RequestMethod.DELETE)

public Result delete(@PathVariable String id) {

articleService.delete(id);

return new Result(true, StatusCode.OK, "删除成功");

}ArticleService中添加代码

1

2

3public void delete(String id) {

articleDao.deleteById(id);

}

6.2.5 条件查询和分页

条件查询

使用Mybatis Plus 提供的EntityWrapper对象封装where查询条件,例如以下使用方式:

1

2

3

4

5EntityWrapper wrapper = new EntityWrapper<Article>();

wrapper.eq("id", article.getId());

//动态sql,例如<if test="null != field"> and field='xxx' </if>

wrapper.eq(null != map.get(field), field, map.get(field));分页

- 使用 Mybatis Plus 提供的Page对象

- 向Mybatis Plus中注入PaginationInterceptor插件

- 新建config包,创建MybatisPlusConfig对象,添加下面的代码

1

2

3

4

5

6

7

8@Configuration

public class MybatisPlusConfig {

@Bean

public PaginationInterceptor paginationInterceptor() {

return new PaginationInterceptor();

}

}完整代码

ArticleController中添加代码

1

2

3

4

5@RequestMapping(value="/search/{page}/{size}", method = RequestMethod.POST)

public Result search(@RequestBody Map map, @PathVariable int page, @PathVariable int size) {

Page page1 = articleService.search(map, page, size);

return new Result(true, StatusCode.OK, "查询成功", new PageResult((int) page1.getTotal(), page1.getRecords()));

}ArticleService中添加代码

1

2

3

4

5

6

7

8

9

10

11

12

13public Page search(Map map, int page, int size) {

EntityWrapper wrapper = new EntityWrapper<Article>();

Set<String> fieldSet = map.keySet();

for(String field : fieldSet) {

//wrapper.eq(field, map.get(field));

wrapper.eq(null != map.get(field), field, map.get(field));

}

Page page1 = new Page(page, size);

List list = articleDao.selectPage(page1, wrapper);

page1.setRecords(list);

return page1;

}

6.3 公共异常处理类

为了使代码容易维护,减少冗余,我们创建一个类集中处理异常

在com.tensquare.user.controller包下创建公共异常处理类BaseExceptionHandler,并添加代码

1 | @ControllerAdvice |

ArticleController中添加测试代码

1 | @RequestMapping(value="/exception", method = RequestMethod.GET) |

6.4 跨域处理

何谓跨域

浏览器从一个域名的网页去请求另一个域名的资源时,域名、端口、协议任一不同,都是跨域 。

十次方项目是采用前后端分离开发的,也是前后端分离部署的,必然会存在跨域问题。

如何解决跨域

只需要在controller类上添加注解

@CrossOrigin即可!

第2章 - MongoDB和评论管理

学习目标:

- 了解什么是MongoDB

- 掌握MongoDB的安装

- 掌握MongoDB的常用命令

- 掌握mongodb-driver的基本使用

- 掌握SpringDataMongoDB的使用

- 能够实现文章评论功能开发

1 MongoDB简介

1.1 文章评论数据分析

文章评论两项功能存在以下特点:

- 数据量大

- 写入操作频繁

- 价值较低

对于这样的数据,我们更适合使用MongoDB来实现数据的存储

1.2 什么是MongoDB

MongoDB是一个基于分布式文件存储的数据库。由C++语言编写。旨在为WEB应用提供可扩展的高性能数据存储解决方案。 MongoDB是一个介于关系数据库和非关系数据库之间的产品,是非关系数据库当中功能最丰富,最像关系数据库的。它支持的数据结构非常松散,是类似json的bson格式,因此可以存储比较复杂的数据类型。

1.3 MongoDB特点

Mongo最大的特点是它支持的查询语言非常强大,其语法有点类似于面向对象的查询语言,几乎可以实现类似关系数据库单表查询的绝大部分功能,而且还支持对数据建立索引。

它的特点是高性能、易部署、易使用,存储数据非常方便。主要功能特性有:

- 面向集合存储,易存储对象类型的数据。

- 模式自由。

- 支持动态查询。

- 支持完全索引,包含内部对象。

- 支持查询。

- 支持复制和故障恢复。

- 使用高效的二进制数据存储,包括大型对象(如视频等)。

- 自动处理碎片,以支持云计算层次的扩展性。

- 支持RUBY,PYTHON,JAVA,C++,PHP,C#等多种语言。

- 文件存储格式为BSON(一种JSON的扩展)。

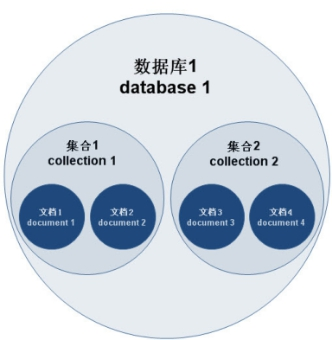

1.5 MongoDB体系结构

MongoDB 的逻辑结构是一种层次结构。主要由:文档(document)、集合(collection)、数据库(database)这三部分组成的。逻辑结构是面向用户的,用户使用 MongoDB 开发应用程序使用的就是逻辑结构。

- MongoDB 的文档(document),相当于关系数据库中的一行记录。

- 多个文档组成一个集合(collection),相当于关系数据库的表。

- 多个集合(collection),逻辑上组织在一起,就是数据库(database)。

- 一个 MongoDB 实例支持多个数据库(database)。

文档(document)、集合(collection)、数据库(database)的层次结构如下图:

| MongoDb | 关系型数据库Mysql |

|---|---|

| 数据库(databases) | 数据库(databases) |

| 集合(collections) | 表(table) |

| 文档(document) | 行(row) |

1.6 MongoDB数据类型

| 数据类型 | 描述 |

|---|---|

| String | 字符串。存储数据常用的数据类型。在 MongoDB 中,UTF-8 编码的字符串才是合法的。 |

| Integer | 整型数值。用于存储数值。根据你所采用的服务器,可分为 32 位或 64 位。 |

| Boolean | 布尔值。用于存储布尔值(真/假)。 |

| Double | 双精度浮点值。用于存储浮点值。 |

| Array | 用于将数组或列表或多个值存储为一个键。 |

| Timestamp | 时间戳。记录文档修改或添加的具体时间。 |

| Object | 用于内嵌文档。 |

| Null | 用于创建空值。 |

| Date | 日期时间。用 UNIX 时间格式来存储当前日期或时间。你可以指定自己的日期时间:创建 Date 对象,传入年月日信息。 |

| Object ID | 对象 ID。用于创建文档的 ID。 |

| Binary Data | 二进制数据。用于存储二进制数据。 |

| Code | 代码类型。用于在文档中存储 JavaScript 代码。 |

| Regular expression | 正则表达式类型。用于存储正则表达式。 |

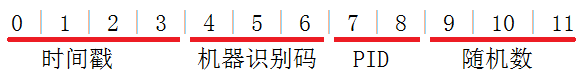

特殊说明:

ObjectId

ObjectId 类似唯一主键,可以很快的去生成和排序,包含 12 bytes,含义是:

- 前 4 个字节表示创建 unix 时间戳,格林尼治时间 UTC 时间,比北京时间晚了 8 个小时

- 接下来的 3 个字节是机器标识码

- 紧接的两个字节由进程 id 组成 PID

- 最后三个字节是随机数

MongoDB 中存储的文档必须有一个 _id 键。这个键的值可以是任何类型的,默认是个 ObjectId 对象

时间戳

BSON 有一个特殊的时间戳类型,与普通的日期类型不相关。时间戳值是一个 64 位的值。其中:

- 前32位是一个 time_t 值【与Unix新纪元(1970年1月1日)相差的秒数】

- 后32位是在某秒中操作的一个递增的序数

在单个 mongod 实例中,时间戳值通常是唯一的。

日期

表示当前距离 Unix新纪元(1970年1月1日)的毫秒数。日期类型是有符号的, 负数表示 1970 年之前的日期。

2 MongoDB基本使用

2.1 window系统MongoDB安装

安装

安装资料中的

mongodb-win32-x86_64-2008plus-ssl-3.2.10-signed.msi按照提示步骤安装即可。安装完成后,软件会安装在C:\Program Files\MongoDB 目录中

我们要启动的服务程序就是C:\Program Files\MongoDB\Server\3.2\bin目录下的mongod.exe,为了方便我们每次启动,我们可以像配置jdk一样,将C:\Program Files\MongoDB\Server\3.2\bin 设置到环境变量path中。

- 启动

- 创建一个文件夹

d:\data,用于存放数据的目录data - 打开命令行窗口,执行以下命令

1 | mongod --dbpath=D:\data |

我们在启动信息中可以看到,mongoDB的默认端口是27017,如果我们想改变默认的启动端口,可以通过–port来指定端口,例如

1 | mongod --dbpath=D:\data -port 8989 |

- 登录

再打开一个新的命令行窗口,执行以下命令:()

1 | mongo 127.0.0.1:27017 |

以上命令中,如果ip是本地服务,端口号是27017,则后面的127.0.0.1:27017可以省略

- 退出

1 | exit |

2.2 Docker 环境下MongoDB安装

在Linux虚拟机中创建mongo容器,命令如下:

1 | docker run -id --name mongo -p 27017:27017 mongo |

在Window命令行窗口出入登录命令:

1 | mongo 192.168.200.128 |

2.3 常用命令

2.3.1 选择和创建数据库

选择和创建数据库的语法格式:

1 | use 数据库名称 |

如果数据库存在则选择该数据库,如果数据库不存在则自动创建。以下语句创建commentdb数据库:

1 | use commentdb |

查看数据库:

1 | show dbs |

查看集合,需要先选择数据库之后,才能查看该数据库的集合:

1 | show collections |

2.3.2 插入与查询文档

选择数据库后,使用集合来对文档进行操作,插入文档语法格式:

1 | db.集合名称.insert(数据); |

插入以下测试数据:

1 | db.comment.insert({content:"十次方课程",userid:"1011"}) |

查询集合的语法格式:

1 | db.集合名称.find() |

查询spit集合的所有文档,输入以下命令:

1 | db.comment.find() |

发现文档会有一个叫_id的字段,这个相当于我们原来关系数据库中表的主键,当你在插入文档记录时没有指定该字段,MongoDB会自动创建,其类型是ObjectID类型。如果我们在插入文档记录时指定该字段也可以,其类型可以是ObjectID类型,也可以是MongoDB支持的任意类型。

输入以下测试语句:

1 | db.comment.insert({_id:"1",content:"到底为啥出错",userid:"1012",thumbup:2020}); |

按一定条件来查询,比如查询userid为1013的记录,只要在find()中添加参数即可,参数也是json格式,如下:

1 | db.comment.find({userid:'1013'}) |

只需要返回符合条件的第一条数据,我们可以使用findOne命令来实现:

1 | db.comment.findOne({userid:'1013'}) |

返回指定条数的记录,可以在find方法后调用limit来返回结果,例如:

1 | db.comment.find().limit(2) |

2.3.3 修改与删除文档

修改文档的语法结构:

1 | db.集合名称.update(条件,修改后的数据) |

修改_id为1的记录,点赞数为1000,输入以下语句:

1 | db.comment.update({_id:"1"},{thumbup:1000}) |

执行后发现,这条文档除了thumbup字段其它字段都不见了。

为了解决这个问题,我们需要使用修改器$set来实现,命令如下:

1 | db.comment.update({_id:"2"},{$set:{thumbup:2000}}) |

删除文档的语法结构:

1 | db.集合名称.remove(条件) |

以下语句可以将数据全部删除,慎用~

1 | db.comment.remove({}) |

删除条件可以放到大括号中,例如删除thumbup为1000的数据,输入以下语句:

1 | db.comment.remove({thumbup:1000}) |

2.3.4 统计条数

统计记录条件使用count()方法。以下语句统计spit集合的记录数:

1 | db.comment.count() |

按条件统计 ,例如统计userid为1013的记录条数:

1 | db.comment.count({userid:"1013"}) |

2.3.5 模糊查询

MongoDB的模糊查询是通过正则表达式的方式实现的。格式为:

1 | /模糊查询字符串/ |

查询评论内容包含“流量”的所有文档,代码如下:

1 | db.comment.find({content:/流量/}) |

查询评论内容中以“加班”开头的,代码如下:

1 | db.comment.find({content:/^加班/}) |

2.3.6 大于 小于 不等于

<, <=, >, >= 这个操作符也是很常用的,格式如下:

1 | db.集合名称.find({ "field" : { $gt: value }}) // 大于: field > value |

查询评论点赞数大于1000的记录:

1 | db.comment.find({thumbup:{$gt:1000}}) |

2.3.7 包含与不包含

包含使用$in操作符

查询评论集合中userid字段包含1013和1014的文档:

1 | db.comment.find({userid:{$in:["1013","1014"]}}) |

不包含使用$nin操作符

查询评论集合中userid字段不包含1013和1014的文档:

1 | db.comment.find({userid:{$nin:["1013","1014"]}}) |

2.3.8 条件连接

我们如果需要查询同时满足两个以上条件,需要使用$and操作符将条件进行关联(相当于SQL的and)。格式为:

1 | $and:[ {条件},{条件},{条件} ] |

查询评论集合中thumbup大于等于1000 并且小于2000的文档:

1 | db.comment.find({$and:[ {thumbup:{$gte:1000}} ,{thumbup:{$lt:2000} }]}) |

如果两个以上条件之间是或者的关系,我们使用操作符进行关联,与前面and的使用方式相同,格式为:

1 | $or:[ {条件},{条件},{条件} ] |

查询评论集合中userid为1013,或者点赞数小于2000的文档记录:

1 | db.comment.find({$or:[ {userid:"1013"} ,{thumbup:{$lt:2000} }]}) |

2.3.9 列值增长

对某列值在原有值的基础上进行增加或减少,可以使用$inc运算符:

1 | db.comment.update({_id:"2"},{$inc:{thumbup:1}}) |

2.4 可视化工具robomongo

Mongodb有很多可视化工具,这里我们使用robomongo,可以访问官网:https://robomongo.org/

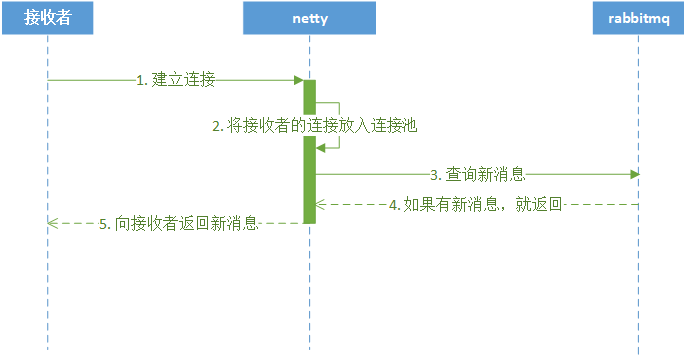

我们可以看到有两个版本Studio 3T和Robo 3T

Studio 3T是一个功能很强大的收费版。。。

Robo 3T前身就是Robomongo,是一个免费的可视化工具,我们使用他可以很轻松的进行Mongodb的管理。

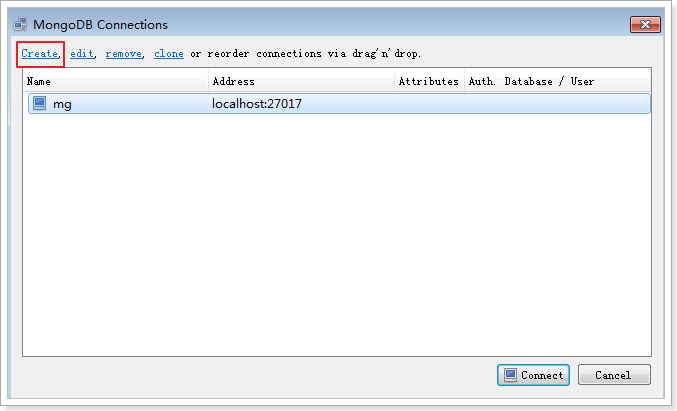

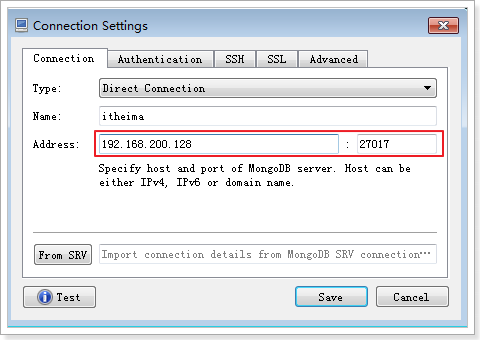

在资料中找到robo3t-1.3.1-windows-x86_64-7419c406.exe并双击安装。打开后看到以下界面:

点击Create创建连接,进行如下配置即可:

3 mongodb-driver使用

mongodb-driver是mongo官方推出的java连接mongoDB的驱动包,相当于JDBC驱动。我们现在来使用mongodb-driver完成对Mongodb的操作。

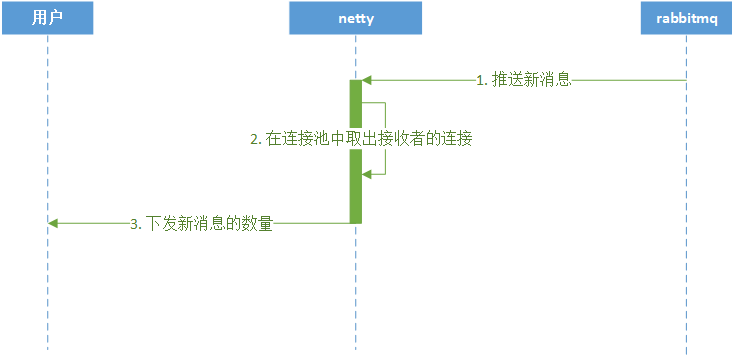

3.1 环境准备

创建工程,并添加以下依赖:

1 | <dependency> |

3.2 使用mongodb-driver

3.2.1 查询所有

1 | @Test |

3.2.2 根据_id查询

每次使用都要用到MongoCollection,进行抽取:

1 | private MongoClient client; |

测试根据_id查询:

1 | @Test |

3.2.3 新增

1 | @Test |

3.2.4 修改

1 | @Test |

3.2.5 删除

1 | @Test |

4 文章评论实现

SpringDataMongoDB是SpringData家族成员之一,用于操作MongoDb的持久层框架,封装了底层的mongodb-driver。本功能使用SpringDataMongoDB进行开发

4.1 需求分析

评论集合结构:

| 专栏文章评论 | comment | ||

|---|---|---|---|

| 字段名称 | 字段含义 | 字段类型 | 备注 |

| _id | ID | 文本 | |

| articleid | 文章ID | 文本 | |

| content | 评论内容 | 文本 | |

| userid | 评论人ID | 文本 | |

| parentid | 评论ID | 文本 | 如果为0表示文章的顶级评论 |

| publishdate | 评论日期 | 日期 | |

| thumbup | 点赞数 | 数字 |

需要实现以下功能:

- 基本增删改查API

- 根据文章id查询评论

- 评论点赞

4.2 开发准备

在文章微服务添加依赖:

1 | <dependency> |

添加配置文件:

1 | data: |

4.3 功能实现

4.3.1 基本增删改查API

创建实体类:

1 | public class Comment implements Serializable { |

在com.tensquare.article.repository包中编写CommentRepository,注意不要和MyBatis的接口放在一个包:

1 | public interface CommentRepository extends MongoRepository<Comment, String> { |

编写Service:

1 | @Service |

编写Controller:

1 | @RestController |

4.3.2 根据文章id查询评论

编写Controller

1 | //根据文章id查询评论列表 |

编写Service

1 | public List<Comment> findByarticleId(String articleId) { |

编写dao

1 | public interface CommentDao extends MongoRepository<Comment, String> { |

4.3.4 评论点赞

先根据评论的id查询,再对点赞数加一

编写service

1 | public void thumbup(String id) { |

编写Controller

1 | //评论点赞 |

以上操作需要操作两次数据库,性能较低,service方法优化如下:

1 | @Autowired |

4.3.5 不能重复点赞

点赞功能完成后,发现可以重复点赞,我们应该改为一个人只能点赞一次。

可以使用评论id+用户id进行标记,一个用户只能点赞一次。可以使用redis保存点赞信息,速度较快

pom.xml添加依赖:

1 | <dependency> |

在Linux虚拟机中创建redis容器:

1 | docker run -id --name=tensquare_redis -p 6379:6379 redis |

配置文件添加配置:

1 | redis: |

修改Controller方法:

1 | @Autowired |

第3章 - 即时通讯和接口加密

学习目标:

- 了解即时通讯业务场景和需求;

- 了解短连接和长连接

- 了解websocket协议

- 使用环信im云实现十次方即时通讯功能

- 了解接口加密业务需求

- 掌握常用加密算法和密钥格式

- 实现十次方的接口加密微服务

1 即时通讯的业务场景和需求

即时通信(Instant Messaging,简称IM)是一个允许两人或多人使用网络实时的传递文字消息、文件、语音与视频交流。 即时通讯技术应用于需要实时收发消息的业务场景。

现在各种各样的即时通讯软件也层出不穷:

客服系统

直播互动

抖音 全民直播 斗鱼

社交APP

微信 陌陌

智能硬件,物联网

摩拜单车 小黄车

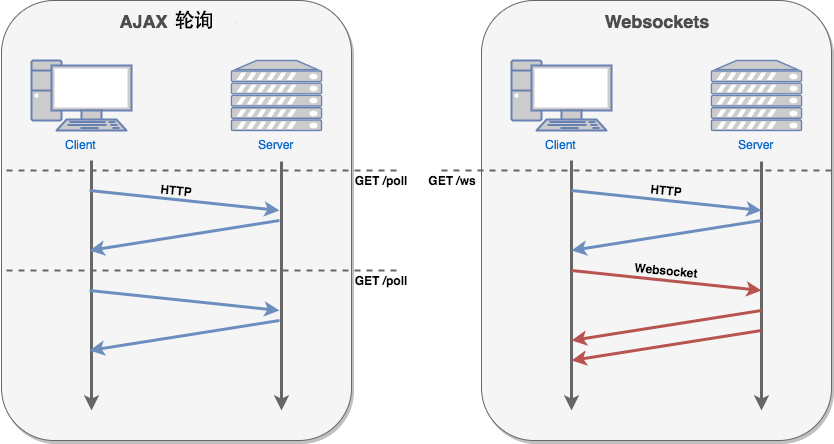

2 短连接和长连接

即时通讯使用的是长连接,这里我们介绍一下短连接和长连接。

2.1 短连接

客户端和服务器每进行一次通讯,就建立一次连接,通讯结束就中断连接。

HTTP是一个简单的请求-响应协议,它通常运行在TCP之上。HTTP/1.0使用的TCP默认是短连接。

2.2 长连接

是指在建立连接后可以连续多次发送数据,直到双方断开连接。

HTTP从1.1版本起,底层的TCP使用的长连接。

使用长连接的HTTP协议,会在响应头加入代码:Connection:keep-alive

2.3 短连接和长连接的区别

2.3.1 通讯流程

短连接:创建连接 -> 传输数据 -> 关闭连接 长连接:创建连接 -> 传输数据 -> 保持连接 -> 传输数据 -> …… -> 关闭连接

2.3.2 适用场景

短连接:并发量大,数据交互不频繁情况

长连接:数据交互频繁,点对点的通讯

2.3.3 通讯方式

| 方式 | 说明 |

|---|---|

| 短连接 | 我跟你发信息,必须等到你回复我或者等了一会等不下去了,就结束通讯了 |

| 长连接 | 我跟你发信息,一直保持通讯,在保持通讯这个时段,我去做其他事情的当中你回复我了,我能立刻你回复了我什么,然后可以回应或者不回应,继续做事 |

3 websocket协议

3.1 何为websocket协议

WebSocket 是 HTML5 开始提供的一种在单个 TCP 连接上进行全双工通讯的协议。

- 何谓全双工:全双工(Full Duplex)是通讯传输的一个术语。双方在通信时允许数据在两个方向上同时传输,它在能力上相当于两个单工通信方式的结合。全双工指可以同时进行信号的双向传输。指A→B的同时B→A,就像是双向车道。

- 单工就就像是汽车的单行道,是在只允许甲方向乙方传送信息,而乙方不能向甲方传送 。

参考资料:https://baike.baidu.com/item/%E5%85%A8%E5%8F%8C%E5%B7%A5/310007?fr=aladdin

在 WebSocket中,浏览器和服务器只需要完成一次握手,就可以创建持久性的连接,并进行双向数据传输。

在推送功能的实现技术上,相比使用Ajax 定时轮询的方式(setInterval),WebSocket 更节省服务器资源和带宽。

服务器向客户端发送数据的功能是websocket协议的典型使用场景

3.2 websocket常用事件方法

以下 API 用于创建 WebSocket 对象。

1 | var Socket = new WebSocket(url, [protocol] ); |

WebSocket 事件

以下是 WebSocket 对象的相关事件。假定我们使用了以上代码创建了 Socket 对象:

| 事件 | 事件处理程序 | 描述 |

|---|---|---|

| open | Socket.onopen | 连接建立时触发 |

| message | Socket.onmessage | 客户端接收服务端数据时触发 |

| error | Socket.onerror | 通信发生错误时触发 |

| close | Socket.onclose | 连接关闭时触发 |

WebSocket 方法

| 方法 | 描述 |

|---|---|

| Socket.send() | 使用连接发送数据 |

| Socket.close() | 关闭连接 |

使用资料中的案例Spring-websocket演示WebSocket

4 十次方的im功能

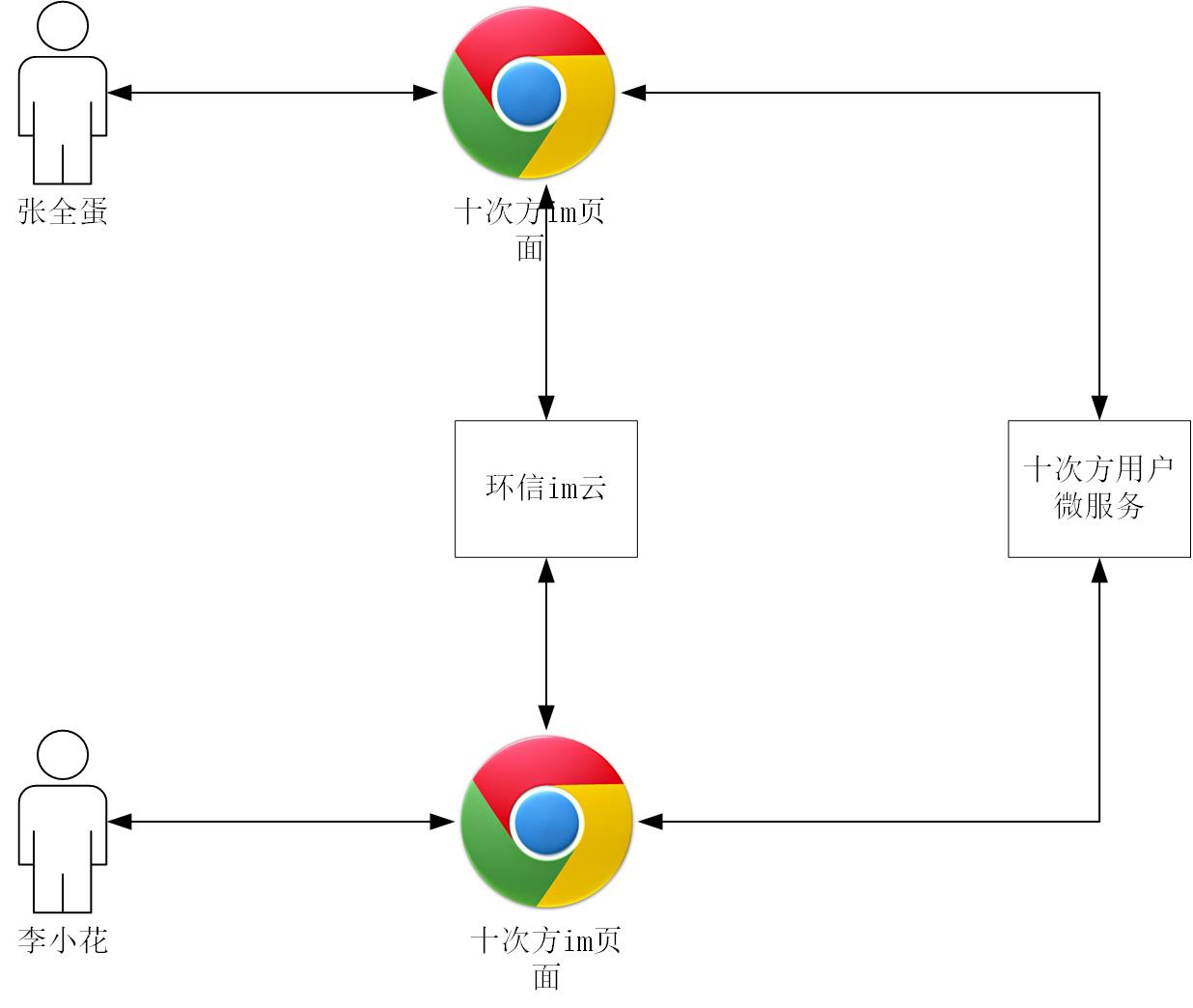

4.1 系统设计

4.1.1 技术选型

- 环信im云

- 前端框架 vue

4.1.2 架构设计

前端页面使用十次方用户微服务认证用户身份,使用环信im云进行即时消息通信。

4.2 环境和工具

- nodejs

- npm

- 前端框架 vue

- 开发工具 vscode

4.3 环信im云介绍

环信im云是即时通讯云 PaaS 平台,开发者可以通过简单的SDK和REST API对接。

- 支持安卓,iOS,Web等客户端SDK对接

- 提供单聊,群聊,聊天室等即时通讯功能

- 支持富媒体消息,实时音视频和各种自定义的扩展消息

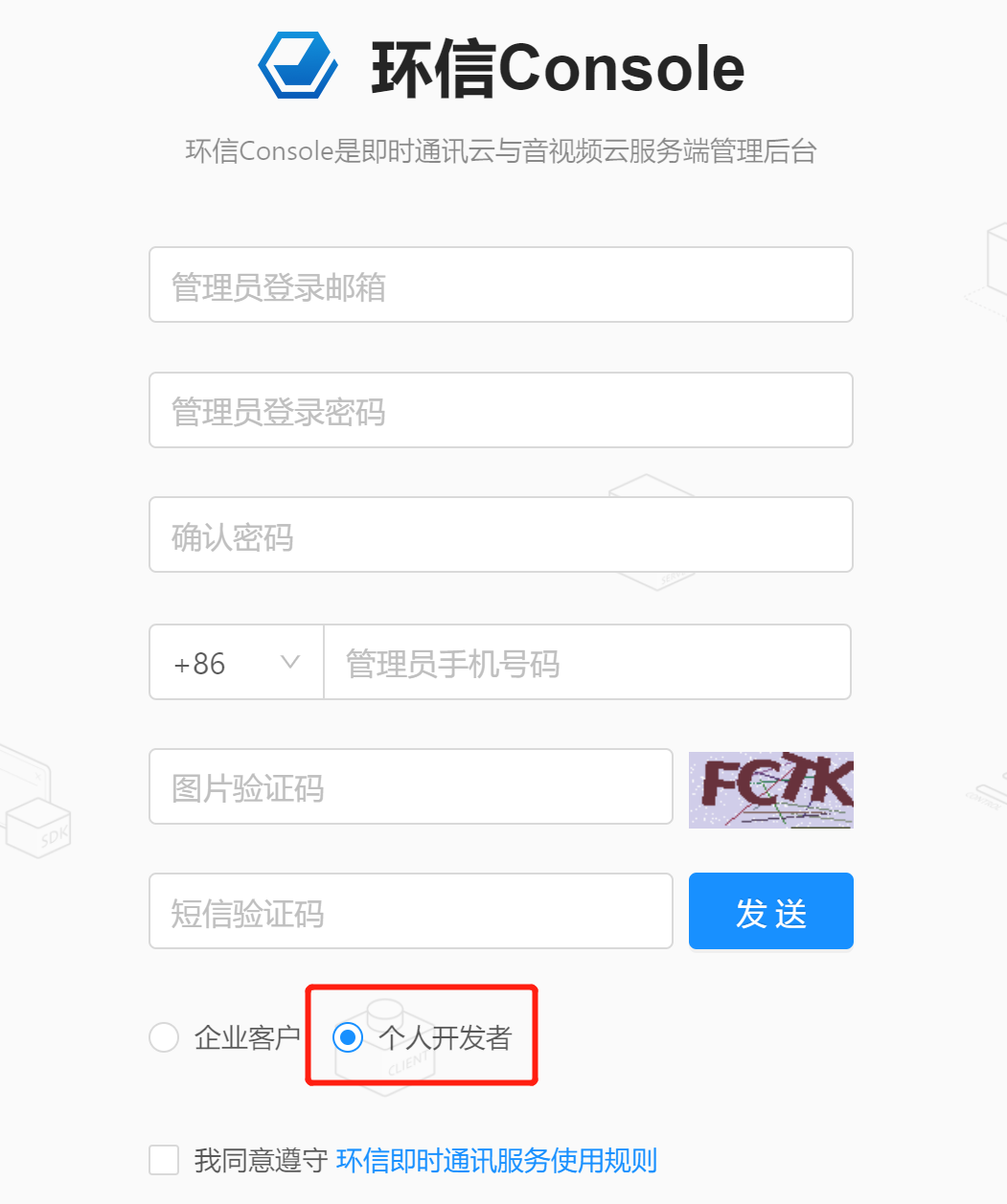

4.3.1 注册账号

网址:https://console.easemob.com/user/register

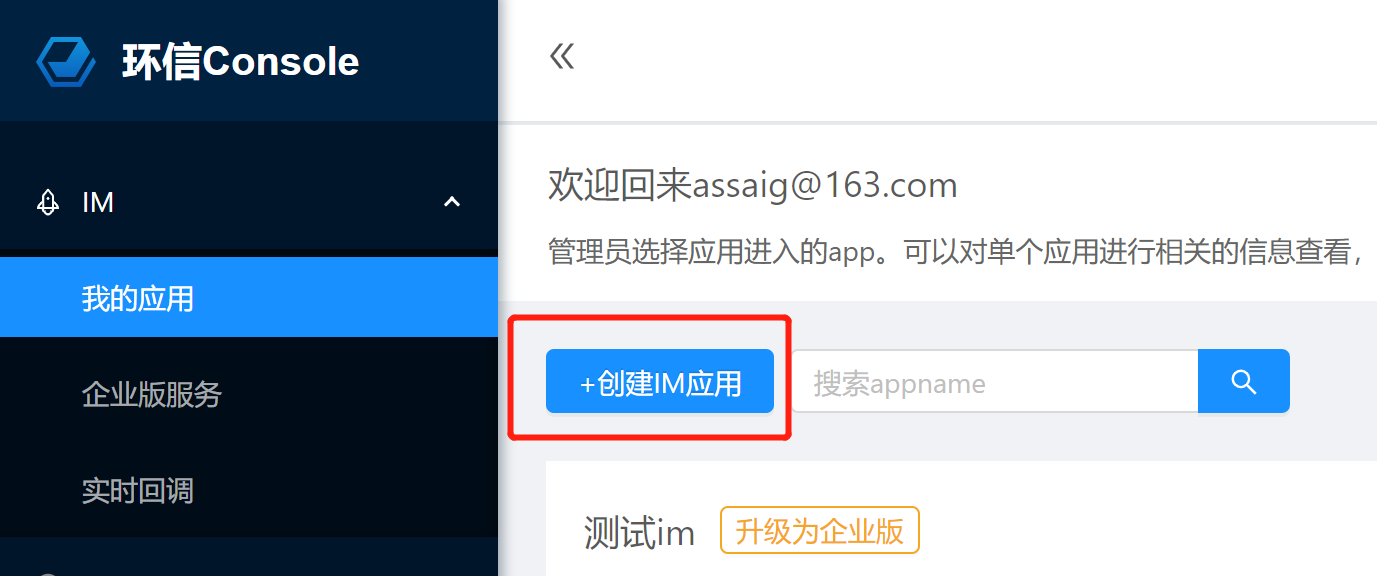

4.3.2 创建应用

- 登录环信im云,按照下图进行操作

输入appname后,appkey会自动生成

进入刚才创建的应用,获取appkey,orgname,client id,client secret等字段

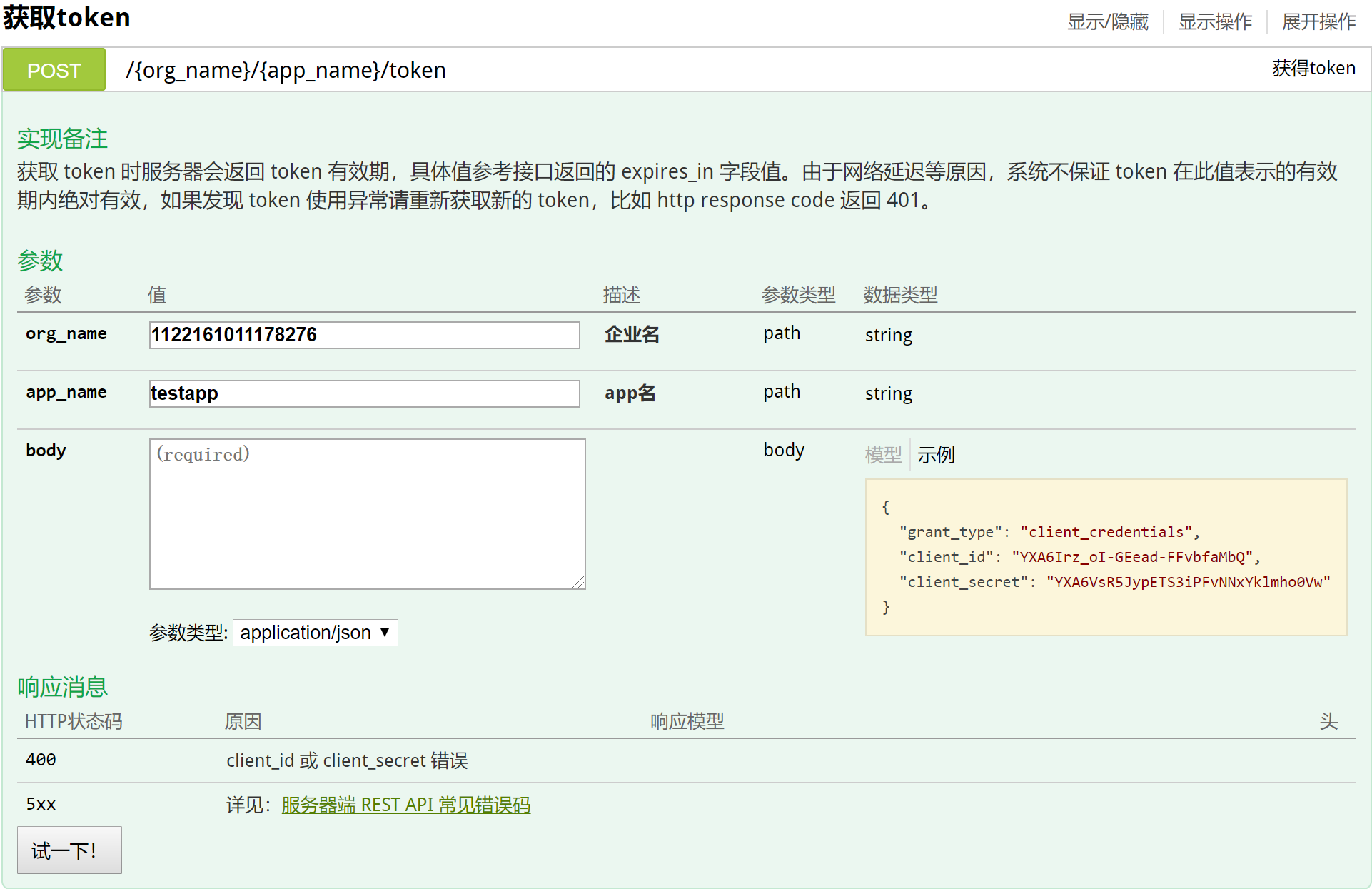

4.3.3 接口测试-获取token

使用环信提供的swagger接口调试页面测试接口

页面网址:http://api-docs.easemob.com/#/%E8%8E%B7%E5%8F%96token

使用postman测试接口

注意:请求方式选择POST

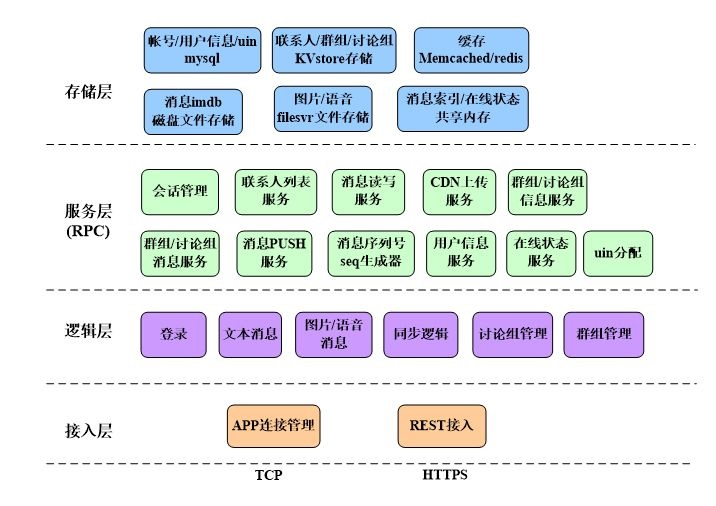

4.3.4 im系统架构

4.4 十次方即时通讯功能

4.4.1 用户微服务实现

1) 创建tensquare_user子模块

创建Maven工程

2) 在pom.xml中添加依赖

1 | <dependencies> |

3) 编写application.yml配置文件

1 | server: |

4)编写MyBatis配置Bean

1 | @Configuration |

5) 编写引导类

1 | @SpringBootApplication |

6) 编写pojo

1 | @TableName("tb_user") |

7) 编写dao

1 | public interface UserDao extends BaseMapper<User> { |

8) 编写service

1 | @Service |

9) 编写controller

1 | @RestController |

4.4.2 即时通讯前端准备

访问环信IM开发文档–> Web客户端 –> SDK集成介绍 –》Web IM 集成介绍

或者直接访问http://docs-im.easemob.com/im/web/intro/integration

- 按照文档,使用git下载集成案例:

1 | $ git clone https://github.com/easemob/webim.git |

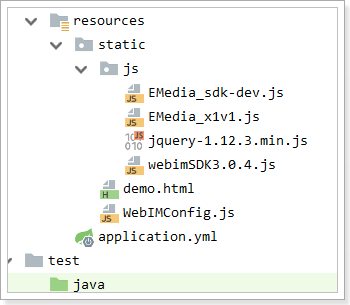

复制案例中的\webim\sdk目录下的所有js文件到项目resources\static\js中

复制webim\simpleDemo中的资料到resources\static中

效果如下:

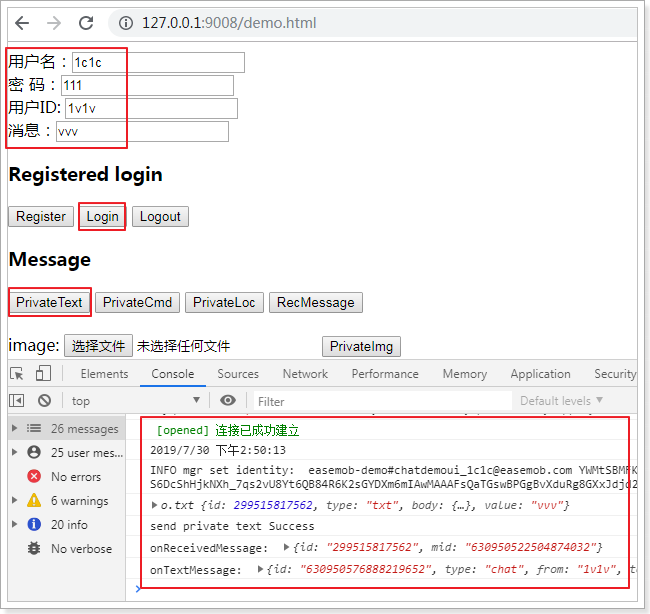

测试demo.html,确认即时通讯的用户登录,发文本消息,效果如下

4.4.3 发送和接收消息

复制Spring-websocket项目中的chatroom.jsp改造为chatroom.html,根据demo.html案例实现用户注册和登录和即时消息功能。最终效果:

1 | <!DOCTYPE HTML PUBLIC "-//W3C//DTD HTML 4.01 Transitional//EN"> |

5 接口加密

5.1 业务场景介绍

数据安全性 - 抓包工具

wireshark fiddler charles

wireshark fiddler charles

系统明文传输的数据会被不明身份的人用抓包工具抓取,从而威胁系统和数据的安全性

5.2 加密方式

5.2.1 摘要算法

消息摘要是把任意长度的输入揉和而产生长度固定的信息。

消息摘要算法的主要特征是加密过程不需要密钥,并且经过加密的数据无法被解密,只有输入相同的明文数据经过相同的消息摘要算法才能得到相同的密文。消息摘要算法不存在密钥的管理与分发问题,适合于分布式网络上使用。

消息摘要的主要特点有:

- 无论输入的消息有多长,计算出来的消息摘要的长度总是固定的。

- 消息摘要看起来是“随机的”。这些数据看上去是胡乱的杂凑在一起的。

- 只要输入的消息不同,对其进行摘要后产生的摘要消息也必不相同;但相同的输入必会产生相同的输出。

- 只能进行正向的消息摘要,而无法从摘要中恢复出任何消息,甚至根本就找不到任何与原信息相关的信息。

- 虽然“碰撞”是肯定存在的,但好的摘要算法很难能从中找到“碰撞”。即无法找到两条不同消息,但是它们的摘要相同。

常见的摘要算法:CRC、MD5、SHA等

5.2.2 对称加密

对称加密的特点:

- 速度快,通常在消息发送方需要加密大量数据时使用。

- 密钥是控制加密及解密过程的指令。

- 算法是一组规则,规定如何进行加密和解密。

典型应用场景:离线的大量数据加密(用于存储的)

常用的加密算法:DES、3DES、AES、TDEA、Blowfish、RC2、RC4、RC5、IDEA、SKIPJACK等。

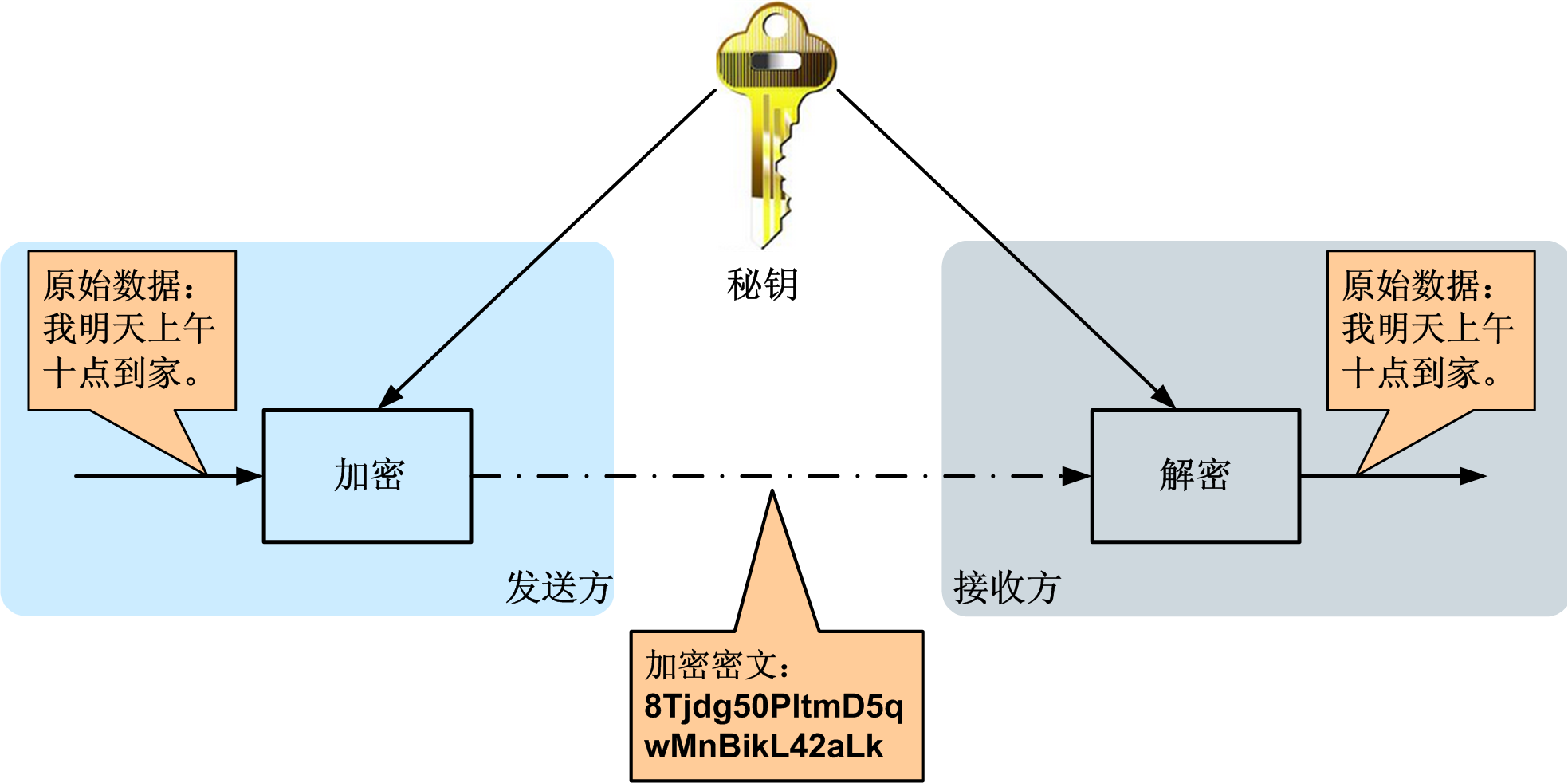

对称加密的工作过程如下图所示

加密的安全性不仅取决于加密算法本身,密钥管理的安全性更是重要。如何把密钥安全地传递到解密者手上就成了必须要解决的问题。

5.2.3 非对称加密

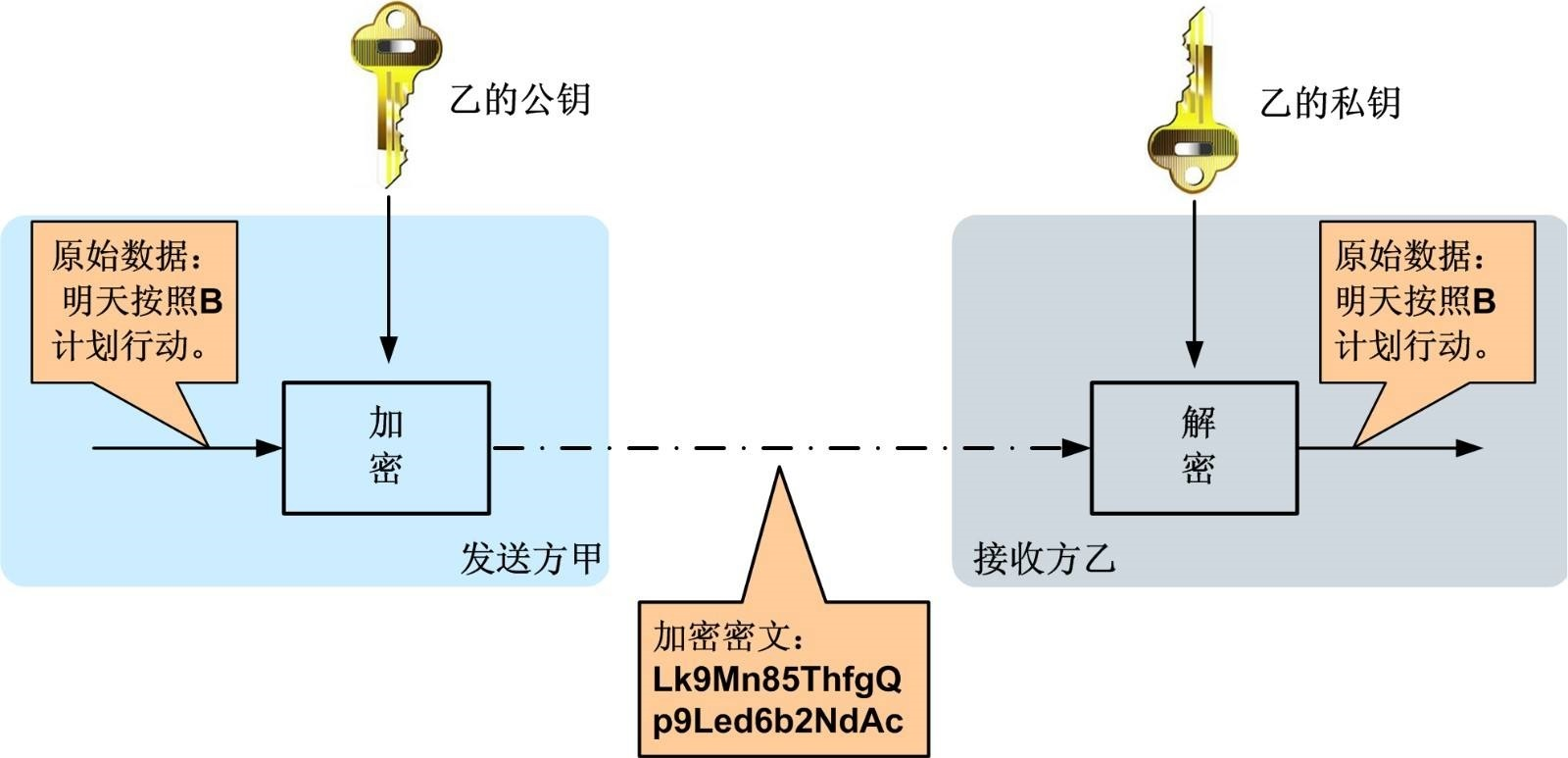

非对称加密算法是一种密钥的保密方法,加密和解密使用两个不同的密钥,公开密钥(publickey:简称公钥)和私有密钥(privatekey:简称私钥)。公钥与私钥是一对,如果用公钥对数据进行加密,只有用对应的私钥才能解密。

非对称加密算法的特点:

- 算法强度复杂

- 加密解密速度没有对称密钥算法的速度快

经典应用场景:数字签名(私钥加密,公钥验证)

常用的算法:RSA、Elgamal、背包算法、Rabin、D-H、ECC(椭圆曲线加密算法)。

非对称加密算法示意图如下

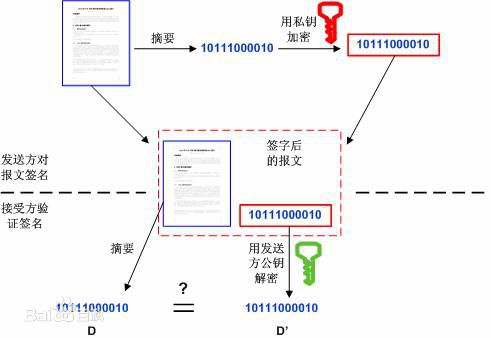

5.2.4 数字签名

数字签名(又称公钥数字签名)是一种类似写在纸上的普通的物理签名,是使用了公钥加密领域的技术实现,用于鉴别数字信息的方法。

数字签名通常使用私钥生成签名,使用公钥验证签名。

签名及验证过程:

- 发送方用一个哈希函数(例如MD5)从报文文本中生成报文摘要,然后用自己的私钥对这个摘要进行加密

- 将加密后的摘要作为报文的数字签名和报文一起发送给接收方

- 接收方用与发送方一样的哈希函数从接收到的原始报文中计算出报文摘要,

- 接收方再用发送方的公用密钥来对报文附加的数字签名进行解密

- 如果这两个摘要相同、接收方就能确认该数字签名是发送方的。

数字签名验证的两个作用:

- 确定消息确实是由发送方签名并发出来的

- 确定消息的完整性

5.3 OpenSSL生成rsa密钥对

5.3.1 RSA算法的密钥格式

密钥长度介于 512 - 65536 之间(JDK 中默认长度是1024),且必须是64 的倍数。密钥的常用文件格式有pem(文本存储)或者der(二进制存储)。

当使用Java API生成RSA密钥对时,公钥以X.509格式编码,私钥以PKCS#8格式编码

RSA使用pkcs协议定义密钥的存储结构等内容

| 协议 | 说明 |

|---|---|

| PKCS#1 | 定义了RSA公钥函数的基本格式标准,特别是数字签名。 |

| PKCS#2 | 涉及了RSA的消息摘要加密,已被并入PKCS#1中。 |

| PKCS#3 | Diffie-Hellman密钥协议标准。 |

| PKCS#4 | 最初是规定RSA密钥语法的,现已经被包含进PKCS#1中。 |

| PKCS#5 | 基于口令的加密标准,描述了使用由口令生成的密钥来加密8位位组串并产生一个加密的8位位组串的方法。PKCS#5可以用于加密私钥,以便于密钥的安全传输(这在PKCS#8中描述)。 |

| PKCS#6 | 扩展证书语法标准,定义了提供附加实体信息的X.509证书属性扩展的语法。 |

| PKCS#7 | 密码消息语法标准。为使用密码算法的数据规定了通用语法,比如数字签名和数字信封。 |

| PKCS#8 | 私钥信息语法标准。定义了私钥信息语法和加密私钥语法,其中私钥加密使用了PKCS#5标准。 |

| PKCS#9 | 可选属性类型。 |

| PKCS#10 | 证书请求语法标准。 |

| PKCS#11 | 密码令牌接口标准。 |

| PKCS#12 | 个人信息交换语法标准。 |

| PKCS#13 | 椭圆曲线密码标准。 |

| PKCS#14 | 伪随机数产生标准。 |

| PKCS#15 | 密码令牌信息语法标准。 |

- pkcs标准详细说明:https://www.rfc-editor.org/search/rfc_search_detail.php?title=pkcs&pubstatus%5B%5D=Any&pub_date_type=any

- RSA官方网站:https://www.rsa.com

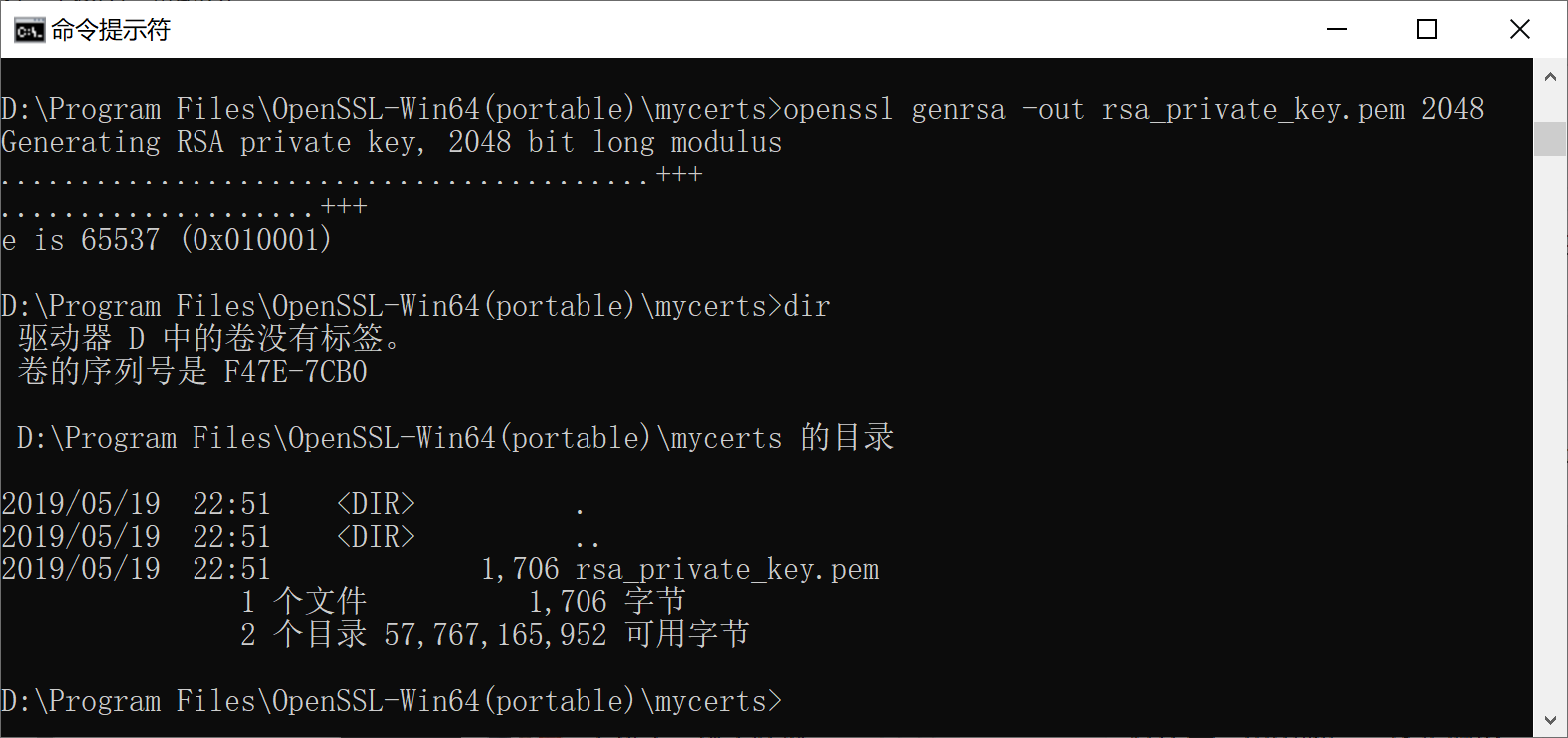

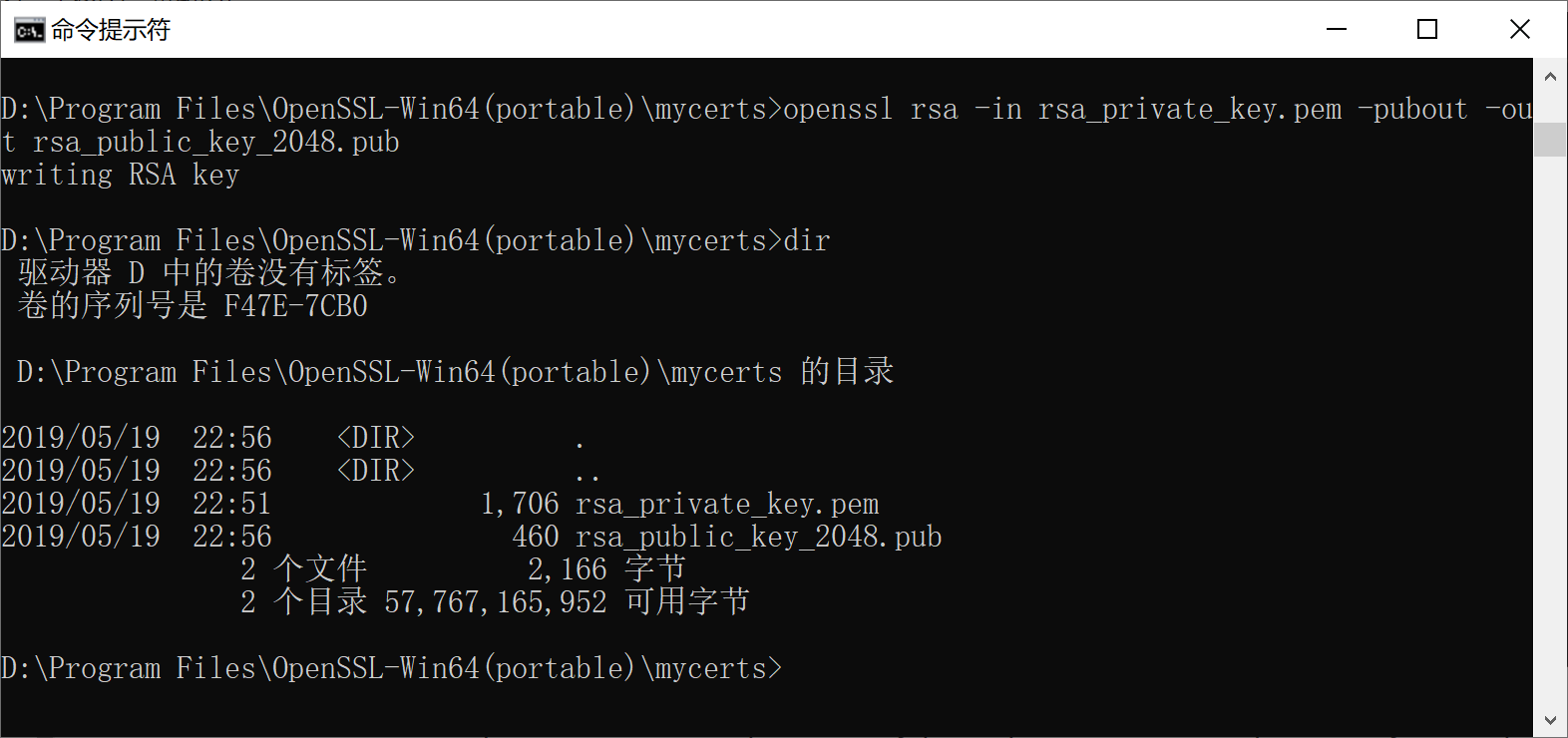

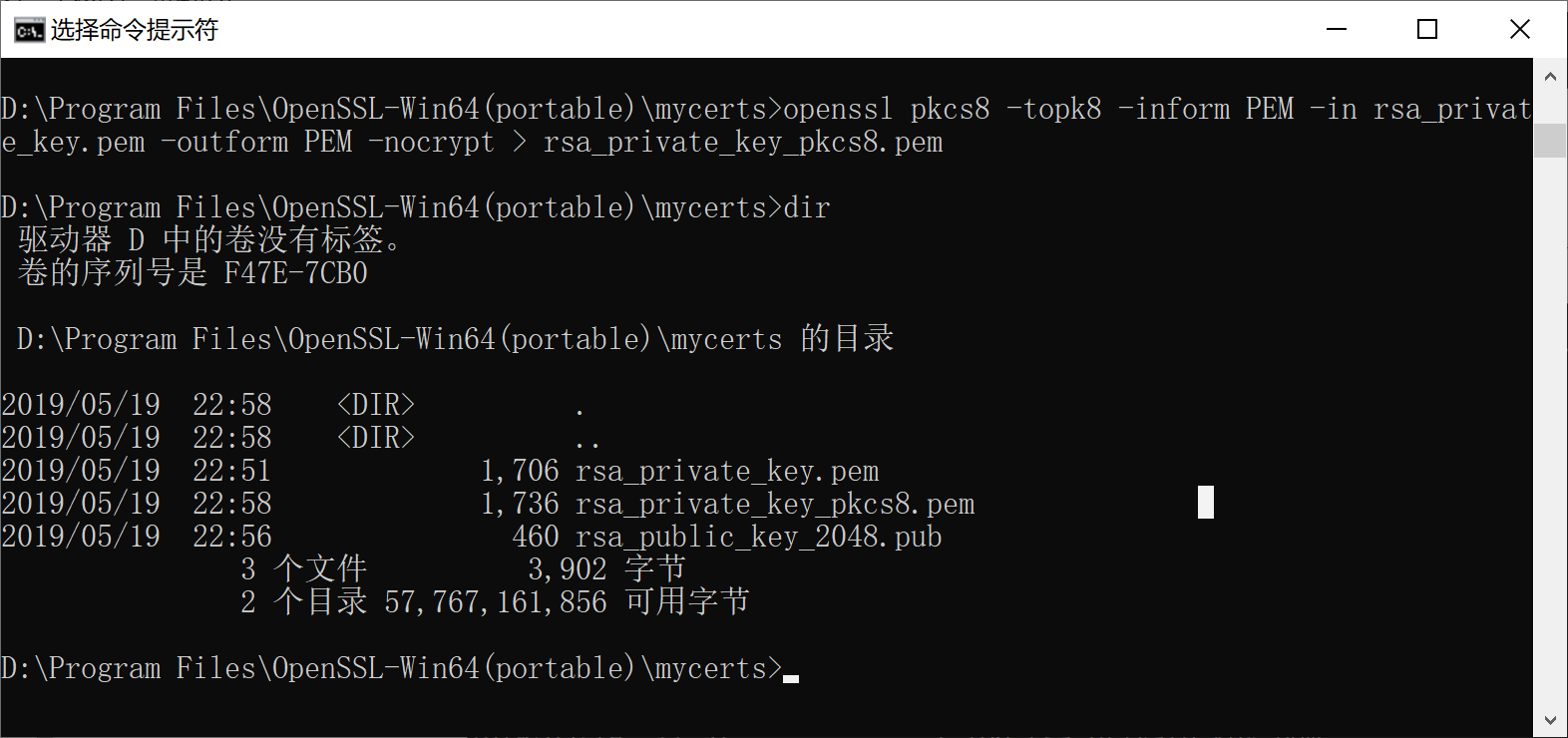

5.3.2 openssl生成rsa密钥对的命令

openssl genrsa -out ../mycerts/rsa_private_key.pem 2048

生成rsa私钥,文本存储格式,长度2048

openssl rsa -in ../mycerts/rsa_private_key.pem -pubout -out ../mycerts/rsa_public_key_2048.pub

根据私钥生成对应的公钥

openssl pkcs8 -topk8 -inform PEM -in ../mycerts/rsa_private_key.pem -outform PEM -nocrypt > ../mycerts/rsa_private_key_pkcs8.pem

私钥转化成pkcs8格式

5.4 搭建接口加密微服务

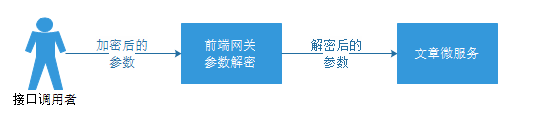

接口加解密请求参数的流程

5.4.1 修改tensquare_parent

在十次方parent父工程pom.xml中添加SpringCloud依赖

1 | <dependencyManagement> |

5.4.2 创建Eureka微服务

创建Maven工程tensquare_eureka,在pom.xml中添加以下依赖:

1 | <dependencies> |

添加配置文件:

1 | server: |

编写启动类:

1 | @SpringBootApplication |

5.4.3 修改文章微服务

在pom.xml中添加Eureka依赖

1 | <dependency> |

修改配置文件,使用Eureka

1 | eureka: |

在ArticleApplication添加@EnableEurekaClient依赖

1 | @SpringBootApplication |

5.4.3 创建tensquare_encrypt网关服务

在tensquare_parent父工程下新建tensquare_encrypt子模块,并按下面的步骤添加配置和代码

在pom.xml文件中添加以下配置

1

<dependencies>

1

<dependency>

1

<groupId>org.springframework.cloud</groupId>

1

<artifactId>spring-cloud-starter-netflix-eureka-client</artifactId>

1

</dependency>

1

<dependency>

1

<groupId>org.springframework.cloud</groupId>

1

<artifactId>spring-cloud-starter-netflix-zuul</artifactId>

1

</dependency>

1

</dependencies>

在resource文件夹下新建application.yml文件,并添加如下配置

1

server:

1

port: 9013

1

spring:

1

application:

1

name: tensquare-encrypt

1

zuul:

1

routes:

1

tensquare-article: #文章

1

path: /article/** #配置请求URL的请求规则

1

serviceId: tensquare-article #指定Eureka注册中心中的服务id

1

strip-prefix: true

1

sentiviteHeaders:

1

customSensitiveHeaders: true

1

1

eureka:

1

client:

1

service-url:

1

defaultZone: http://127.0.0.1:6868/eureka/

1

instance:

1

prefer-ip-address: true

1

新建com.tensquare.encrypt包,并在包下新建启动类EncryptApplication,添加如下代码

1

package com.tensquare.encrypt;

1

1

import org.springframework.boot.SpringApplication;

1

import org.springframework.boot.autoconfigure.SpringBootApplication;

1

import org.springframework.cloud.netflix.eureka.EnableEurekaClient;

1

import org.springframework.cloud.netflix.zuul.EnableZuulProxy;

1

1

@SpringBootApplication

1

@EnableEurekaClient

1

@EnableZuulProxy

1

public class EncryptApplication {

1 | public static void main(String[] args) { |

}

1 | 4. 将rsa相关的工具类复制到在com.tensquare.encrypt包下 |

编写filter

在com.tensquare.encrypt包下新建filters包,然后新建过滤器类RSARequestFilter,添加下面的代码

1

package com.tensquare.encrypt.filters;

1

1

import com.google.common.base.Strings;

1

import com.netflix.zuul.ZuulFilter;

1

import com.netflix.zuul.context.RequestContext;

1

import com.netflix.zuul.http.HttpServletRequestWrapper;

1

import com.netflix.zuul.http.ServletInputStreamWrapper;

1

import com.tensquare.encrypt.rsa.RsaKeys;

1

import com.tensquare.encrypt.service.RsaService;

1

import org.springframework.beans.factory.annotation.Autowired;

1

import org.springframework.cloud.netflix.zuul.filters.support.FilterConstants;

1

import org.springframework.http.MediaType;

1

import org.springframework.stereotype.Component;

1

import org.springframework.util.StreamUtils;

1

1

import javax.servlet.ServletInputStream;

1

import javax.servlet.http.HttpServletRequest;

1

import javax.servlet.http.HttpServletResponse;

1

import java.io.IOException;

1

import java.io.InputStream;

1

import java.nio.charset.Charset;

1

import java.util.HashMap;

1

1

@Component

1

public class RSARequestFilter extends ZuulFilter {

1

1

@Autowired private RsaService rsaService;

1

1

@Override

1

public String filterType() {

1

return FilterConstants.PRE_TYPE;

1

}

1

1

@Override

1

public int filterOrder() {

1

return FilterConstants.PRE_DECORATION_FILTER_ORDER + 1;

1

}

1

1

@Override

1

public boolean shouldFilter() {

1

return true;

1

}

1

1

@Override

1

public Object run() {

1

RequestContext ctx = RequestContext.getCurrentContext();

1

HttpServletRequest request = ctx.getRequest();

1

HttpServletResponse response = ctx.getResponse();

1

1

try {

1

1

String decryptData = null;

1

HashMap dataMap = null;

1

String token = null;

1

1

String url = request.getRequestURL().toString();

1

InputStream stream = ctx.getRequest().getInputStream();

1

String requestParam = StreamUtils.copyToString(stream, Charsets.UTF_8);

1

1

if(!Strings.isNullOrEmpty(requestParam)) {

1

System.out.println(String.format("请求体中的密文: %s", requestParam));

1

decryptData = rsaService.RSADecryptDataPEM(requestParam, RsaKeys.getServerPrvKeyPkcs8());

1

1

System.out.println(String.format("解密后的内容: %s", decryptData));

1

}

1

1

System.out.println(String.format("request: %s >>> %s, data=%s", request.getMethod(), url, decryptData));

1

1

if(!Strings.isNullOrEmpty(decryptData)) {

1

System.out.println("json字符串写入request body");

1

final byte[] reqBodyBytes = decryptData.getBytes();

1

ctx.setRequest(new HttpServletRequestWrapper(request) {

1

@Override

1

public ServletInputStream getInputStream() throws IOException {

1

return new ServletInputStreamWrapper(reqBodyBytes);

1

}

1

1

@Override

1

public int getContentLength() {

1

return reqBodyBytes.length;

1

}

1

1

@Override

1

public long getContentLengthLong() {

1

return reqBodyBytes.length;

1

}

1

});

1

}

1

1

System.out.println("转发request");

1

// 设置request请求头中的Content-Type为application/json,否则api接口模块需要进行url转码操作

1

ctx.addZuulRequestHeader("Content-Type", String.valueOf(MediaType.APPLICATION_JSON) + ";charset=UTF-8");

1

1

} catch (Exception e) {

1

System.out.println(this.getClass().getName() + "运行出错" + e.getMessage());

1

}

1

1

return null;

1

}

1

}

将openssl生成的公钥和私钥添加进RsaKeys中

公钥变量:

private static final String serverPubKey私钥变量:

private static final String serverPrvKeyPkcs8测试请求参数加解密微服务

启动tensquare_eureka,tensquare_article,tensquare_encrypt,使用EncryptTest类加密请求参数,然后使用postman进行接口调用测试

第4章 - 消息通知系统

学习目标:

- 了解消息通知系统的业务场景

- 了解消息通知和即时通讯区别

- 实现消息通知微服务的基本功能

- 实现文章订阅和群发消息

- 实现文章点赞和点对点消息

- 了解基于数据库实现的通知系统的问题

- 了解通知系统的改进方案

1 消息通知的业务场景

消息通知微服务的定位是“平台内”的“消息”功能,分为全员消息,订阅类消息,点对点消息。例如系统通知,私信,@类消息

全员消息

系统通知,活动通知,管理员公告等全部用户都会收到的消息

订阅类消息

关注某一类数据的用户,该类数据有更新时向用户发送的消息。例如关注某位大v的微博,公众号,订阅某位知名作家的专栏

点对点消息

某位用户对另外一位用户进行操作后,系统向被操作的用户发送的消息。例如点赞,发红包。

2 消息通知与即时通讯的区别

| 即时通信 | 消息通知 | |

|---|---|---|

| 传输的内容 | 包括文字聊天、语音消息发送、文件传输、音视频播放等吗,内容极其丰富。 | 以文字,超链接为主,辅以图片,不能再多了。 |

| 核心需求点 | 要求连接稳定可靠。就像网络游戏,如果总是掉线,你还玩的下去吗? | 要求消息的高送达率,也就是说“这件事儿一定要想尽办法通知到对方”。对延时要求不高。 |

| 系统建设成本 | 存储成本高(图片,视频等)。基于TCP协议,需建设或租用多线机房,基建成本高。 | 一般只保存文本消息,存储成本低。可根据用户量自由调整服务器集群配置。 |

| 交互方式 | 任何消息均可回复 | 消息一般被设计为“仅通知,不需要回复” |

| 技术实现 | XMPP,MQTT,Strophe等全双工长连接协议 | JMS,AMQP,http等等各种协议 |

3 搭建消息通知微服务

3.1 业务分析

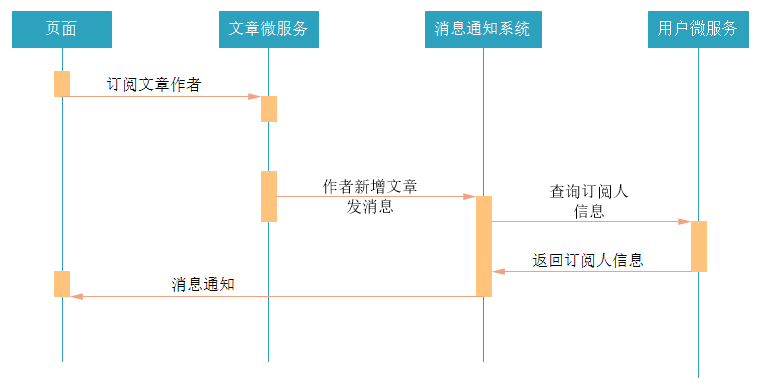

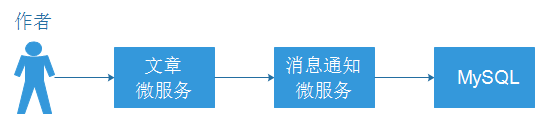

用户可以对文章作者进行订阅,当被订阅的用户发布新的文章时,可以通过消息通知系统发送消息给订阅者。

流程如下:

3.2 表结构分析

把资料中的sql脚本导入到数据库中,创建数据库和表。

十次方消息通知微服务总共需要两张数据库表,tb_notice 和 tb_notice_fresh。

消息通知表 tb_notice

保存用户的消息通知

字段名 类型 字段说明 id int ID receiverId varchar 接收消息用户的ID(userId) operatorId varchar 进行操作用户的ID action varchar 操作类型(评论,点赞等) targetType varchar 被操作的对象,例如文章,评论等 targetId varchar 被操作对象的id,例如文章的id,评论的id createtime datetime 发表日期 type varchar 消息通知类型 state varchar 状态:0 未读;1 已读 待推送消息表 tb_notice_fresh

保存准备推送给用户的消息通知

字段名 类型 字段说明 userId varchar 用户ID noticeId varchar 通知id

3.2 搭建消息通知微服务

在tensquare_parent父工程下创建tensquare_notice子模块

修改pom.xml文件,添加下面的配置

1

<dependencies>

1

<!-- mybatis-plus begin -->

1

<dependency>

1

<groupId>com.baomidou</groupId>

1

<artifactId>mybatisplus-spring-boot-starter</artifactId>

1

<version>${mybatisplus-spring-boot-starter.version}</version>

1

</dependency>

1

<dependency>

1

<groupId>com.baomidou</groupId>

1

<artifactId>mybatis-plus</artifactId>

1

<version>${mybatisplus.version}</version>

1

</dependency>

1

<!-- mybatis-plus end -->

1

<dependency>

1

<groupId>com.alibaba</groupId>

1

<artifactId>druid-spring-boot-starter</artifactId>

1

<version>1.1.9</version>

1

</dependency>

1

<dependency>

1

<groupId>mysql</groupId>

1

<artifactId>mysql-connector-java</artifactId>

1

</dependency>

1

<dependency>

1

<groupId>com.tensquare</groupId>

1

<artifactId>tensquare_common</artifactId>

1

<version>1.0-SNAPSHOT</version>

1

</dependency>

1

<dependency>

1

<groupId>org.springframework.boot</groupId>

1

<artifactId>spring-boot-starter-data-redis</artifactId>

1

</dependency>

1

<dependency>

1

<groupId>org.springframework.cloud</groupId>

1

<artifactId>spring-cloud-starter-netflix-eureka-client</artifactId>

1

</dependency>

1

<dependency>

1

<groupId>org.springframework.cloud</groupId>

1

<artifactId>spring-cloud-starter-openfeign</artifactId>

1

</dependency>

1

</dependencies>

在resources文件夹下添加application.yml文件,并添加下面的配置

1

server:

1

port: 9014

1

spring:

1

application:

1

name: tensquare-notice

1

datasource:

1

driver-class-name: com.mysql.jdbc.Driver

1

url: jdbc:mysql://192.168.200.128:3306/tensquare_notice?characterEncoding=utf-8

1

username: root

1

password: root

1

redis:

1

host: 192.168.200.128

1

# Mybatis-Plus 配置

1

mybatis-plus:

1

# mapper-locations: classpath:/mapper/*Mapper.xml

1

#实体扫描,多个package用逗号或者分号分隔

1

typeAliasesPackage: com.tensquare.notice.pojo

1

global-config:

1

id-type: 1 #0:数据库ID自增 1:用户输入id

1

db-column-underline: false

1

refresh-mapper: true

1

configuration:

1

map-underscore-to-camel-case: true

1

cache-enabled: true #配置的缓存的全局开关

1

lazyLoadingEnabled: true #延时加载的开关

1

multipleResultSetsEnabled: true #开启延时加载,否则按需加载属性

1

log-impl: org.apache.ibatis.logging.stdout.StdOutImpl #打印sql语句,调试用

1

eureka:

1

client:

1

service-url:

1

defaultZone: http://127.0.0.1:6868/eureka/

1

instance:

1

prefer-ip-address: true

创建启动类

新建com.tensquare.notice包,并在该包下新建NoticeApplication,添加如下代码

1

@SpringBootApplication

1

@EnableEurekaClient

1

@EnableFeignClients

1

public class NoticeApplication {

1

1

public static void main(String[] args) {

1

SpringApplication.run(NoticeApplication.class, args);

1

}

1

1

@Bean

1

public IdWorker idWorkker(){

1

return new IdWorker(1, 1);

1

}

1

}

编写pojo

1

@TableName("tb_notice")

1

public class Notice implements Serializable {

1

1

@TableId(type = IdType.INPUT)

1

private String id;//ID

1

1

private String receiverId;//接收消息的用户ID

1

private String operatorId;//进行操作的用户ID

1

1

@TableField(exist = false)

1

private String operatorName;//进行操作的用户昵称

1

private String action;//操作类型(评论,点赞等)

1

private String targetType;//对象类型(评论,点赞等)

1

1

@TableField(exist = false)

1

private String targetName;//对象名称或简介

1

private String targetId;//对象id

1

private Date createtime;//创建日期

1

private String type; //消息类型

1

private String state; //消息状态(0 未读,1 已读)

1

1

//set get...

1

}

1

@TableName("tb_notice_fresh")

1

public class NoticeFresh {

1

1

private String userId;

1

private String noticeId;

1

1

//set get...

1

}

1

编写dao

1

public interface NoticeDao extends BaseMapper<Notice> {

1

}

1

public interface NoticeFreshDao extends BaseMapper<NoticeFresh> {

1

}

com.tensquare.notice.config添加配置

1

@Configuration

1

//配置Mapper包扫描

1

@MapperScan("com.tensquare.notice.dao")

1

public class MyBatisPlusConfig {

1

1

@Bean

1

public PaginationInterceptor createPaginationInterceptor() {

1

return new PaginationInterceptor();

1

}

1

}

1

3.3 实现基本增删改查功能

需要实现功能:

- 根据id查询消息通知

- 根据条件分页查询消息通知

- 新增通知

- 修改通知

- 根据用户id查询该用户的待推送消息(新消息)

- 删除待推送消息(新消息)

编写Controller

1 | @RestController |

编写Service

1 | @Service |

3.4 完善返回的消息内容

数据库表设计的时候,为了提高性能,并没有保存用户昵称,文章标题等信息,只保存了主键id。但用户在查看消息的时候,只有id是很难阅读的,所以需要根据id,把用户昵称,文章标题等信息查询,并在返回消息之前设置到消息中。

由于消息通知微服务需要调用其他微服务获取字段信息,所以需要做 feign client 调用。

1) com.tensquare.notice.client包下添加ArticleClient和UserClient

1 | @FeignClient(value="tensquare-article") |

2) 修改用户微服务,添加根据id查询用户

编写Controller,添加以下逻辑

1 | /** |

编写Service,添加以下逻辑

1 | public User selectById(String id) { |

3) 改造消息通知微服务,获取消息内容数据

修改com.tensquare.notice.service中的NoticeService,增加getNoticeInfo方法,修改selectById和selectList查询方法,为以下内容:

1 | /** |

4)测试功能

需要开启tensquare-eureka,tensquare-user,tensquare-article,tensquare-notice四个微服务进行测试

4 文章订阅 - 实现群发消息功能

4.1 订阅文章作者

用户在登录十次方以后,可以查看文章。如果觉得文章好,可以订阅文章作者,从而可以收到这个作者发布的新文章的消息。所以需要完成根据文章id,订阅文章作者。

1) 功能分析

- 用户之间的文章订阅关系的数据存放在redis中。

- 用户订阅文章作者,则系统将作者的id放入用户自己的订阅集合(set类型),同时系统将用户的id放入文章作者的订阅者集合中。

- 由于redis的set集合,其中的数据是不重复的,所以不用担心重复数据的问题。

2) 代码实现

需要在tensquare_article微服务中添加根据文章id订阅文章作者的功能,在ArticleController中添加以下代码:

1 | /** |

编写ArticleService

1 | public Boolean subscribe(String userId, String articleId) { |

3) 启动微服务测试功能

需要开启tensquare-eureka,tensquare-article

4.2 新增文章群发消息

新增文章后,需要通知订阅的用户,文章微服务需要调用消息通知微服务,创建消息。

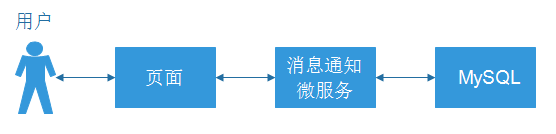

用户登录十次方后,访问的前端页面,页面需要定时轮询通知接口,获取消息。(接口已完成)

1) 新增NoticeClient,调用消息通知微服务

pom.xml添加依赖

1 | <dependency> |

启动类添加注解

1 | @EnableFeignClients |

在com.tensquare.article.client中编写NoticeClient,把消息通知的Notice类复制到文章微服务

1 | @FeignClient(value = "tensquare-notice") |

2) 修改ArticleService的save方法,进行消息通知

1 | public void save(Article article) { |

5 文章点赞 - 实现点对点消息功能

5.1 实现文章点赞

编写ArticleController添加点赞方法:

1 | //文章点赞 |

编写ArticleService:

1 | public void thumbup(String articleId) { |

5.2 实现点赞消息通知

修改ArticleService的点赞方法,增加消息通知:

1 | public void thumbup(String articleId,String userid) { |

6 基于db实现的通知系统存在的问题

6.1 消息通知系统的构成

一个消息通知系统,其主要的构成有消息发送者,消息存储,消息接收者,新消息提醒机制

6.1.1 消息发送者

消息是由系统的操作者发出的吗?不一定。

消息发送的常规流程:

系统的开发者设置了某种消息发送的规则,规则中包含一些条件

规则中的条件都满足后,触发系统生成消息数据

系统将消息数据保存并推送给接收者

以前面文章订阅群发消息作来举例的话

规则:

1.1 用户订阅文章作者

1.2 文章作者发布了新文章

上面规则中的两个条件都满足后,系统就生成消息通知并推送给接收者,告诉接收者有新的文章

在这个例子中,消息真正的发送者是消息通知系统,而非操作者。

用户提前为系统设定好规则,系统按照规则发送消息。

6.1.2 消息存储

消息通知的存储包含消息通知实体数据的存储和新消息提醒数据的存储。

- 消息通知实体数据保存在tb_notice表中的数据

- 新消息提醒数据保存在tb_notice_fresh表中的数据

6.1.3 消息接收者

也就是消息的阅读者,是一条消息通知的最终目的地。

6.1.4 新消息提醒机制

系统产生新的消息通知后,必须有一个合理的机制或者方法来告知接收者有新的消息。否则接收者会郁闷且痛苦地在茫茫的数据海洋中手动去查找新消息。可以使用以下两种方式提醒新消息:

提醒新消息的数量

消息通知列表中新消息置顶并标记

6.2 现在消息通知存在的问题

6.2.1 数据库访问压力大

用户的通知消息和新通知提醒数据都放在数据库中,数据库的读写操作频繁,尤其是tb_notice_refresh表,访问压力大。

6.2.2 服务器性能压力大

采用页面轮询调接口的方式实现服务器向用户推送消息通知,服务器的接口访问压力大。

6.2.3 改进的方法

- 使用 rabbitmq 实现新消息提醒数据的缓存功能,替代tb_notice_refresh表

- 使用全双工长连接的方式实现服务器向用户推送最新的消息通知,替换轮询

- 页面使用websocket

- 微服务端使用异步高性能框架netty

第5章 - 消息通知系统改进

学习目标:

- 了解最新消息上线主动索取方案

- 了解最新消息由系统主动推送方案

- 实现最新消息由RabbitMQ处理

- 了解IO编程和NIO编程

- 了解Netty的作用

- 了解Netty的核心组件

- 实现整合Netty和WebSocket

- 实现点对点消息的改进

1 获取新消息通知的两种模式

用户获取新的消息通知有两种模式

- 上线登录后向系统主动索取

- 在线时系统向接收者主动推送新消息

新消息提醒功能需要定时轮询接口的方式太低效,改进点如下

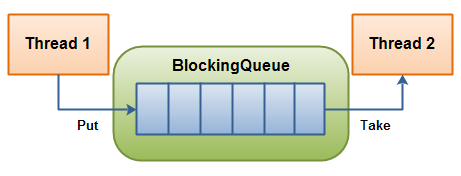

将新消息提醒数据由tb_notice_fresh表转移到rabbitmq中,减轻数据库访问压力

将轮询接口的伪推送改进为真正的使用全双工长连接进行的推送

2.1 消息通知微服务加入netty框架,为页面中的websocket连接提供接入服务

2.2 netty框架与rabbitmq对接,接收并下发新消息提醒数据

2.2 将页面中的定时轮询接口代码替换为websocket连接和事件处理

1.1 上线登录后向系统索取

此模式是接受者请求系统,系统将新的消息通知返回给接收者的模式,流程如下:

- 接收者向服务端netty请求WebSocket连接

- Netty服务吧连接放到自己的连接池中

- Netty根据接受者信息向RabbitMQ查询消息

- 如果有新消息,返回新消息通知

- 使用WebSocket连接向,接收者返回新消息的数量

1.2 在线时系统向接收者主动推送

此模式是系统将新的消息通知返回给接收者的模式,流程如下:

- RabbitMQ将新消息数据推送给Netty

- Netty从连接池中取出接收者的WebSocket连接

- Netty通过接收者的WebSocket连接返回新消息的数量

2 文章订阅群发消息改进

文章订阅群发消息的改进步骤:

- 准备RabbitMQ消息中间件

- 改进文章订阅功能,创建RabbitMQ队列存放新消息通知

- 改进发布文章后群发消息通知功能

- 整合Netty和WebSocket实现双向通信

在虚拟机中启动RabbitMQ

1 | docker run -id --name=tensquare_rabbit -p 5671:5671 -p 5672:5672 -p 4369:4369 -p 15672:15672 -p 25672:25672 rabbitmq:management |

访问地址:http://192.168.200.128:15672

登录账号: guest

登录密码: guest

2.1 文章订阅功能改进

2.1.1 修改文章微服务配置文件

因为文章订阅功能需要增加Rabbitmq的交换机和队列的绑定、解绑等相关操作,所以需要让tensquare_article微服务具备操作Rabbitmq的能力。

修改tensquare_article微服务的application.yml配置文件,文件位置如下

在该文件中添加Rabbitmq相关的配置

1 | rabbitmq: |

然后修改tensquare_article微服务的pom.xml项目配置文件,添加如下依赖

1 | <dependency> |

2.1.2 修改文章订阅功能代码

在ArticleService中原有的subscribe方法中,增加了几个业务逻辑

- 定义Rabbitmq的direct类型的交换机

- 定义用户的Rabbitmq队列

- 将队列通过路由键绑定或解绑direct交换机

改进后完整的subscribe方法如下

1 | public Boolean subscribe(String userId, String articleId) { |

2.2 发布文章触发群发消息

在原有的处理逻辑中,增加向交换机发送Rabbitmq消息的业务逻辑,文章作者的用户id作为路由键。修改ArticleService中的 save方法,在新增方法的最后面添加下面的代码:

1 | //入库成功后,发送mq消息,内容是消息通知id |

删除消息通知微服务中的 新的通知提醒消息入库 逻辑,因为现在新通知由RabbitMQ发送。修改tensquare_notice微服务的NoticeService方法:

1 | @Transactional |

3 IO编程

在开始了解Netty之前,先来实现一个客户端与服务端通信的程序,使用传统的IO编程和使用NIO编程有什么不一样。

3.1 传统IO编程

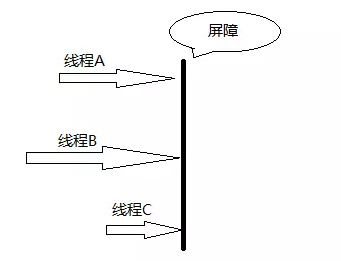

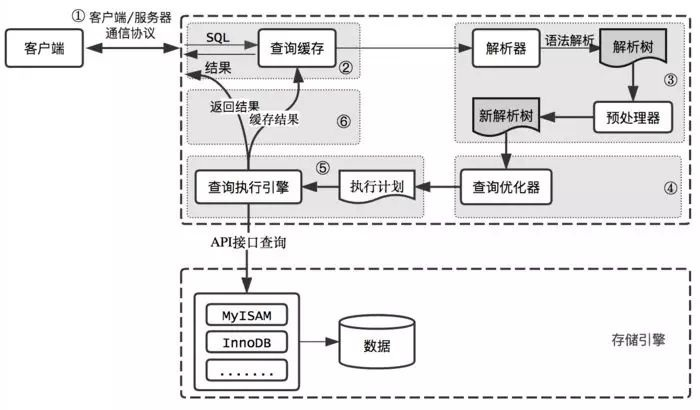

每个客户端连接过来后,服务端都会启动一个线程去处理该客户端的请求。阻塞I/O的通信模型示意图如下:

业务场景:客户端每隔两秒发送字符串给服务端,服务端收到之后打印到控制台。

服务端实现:

1 | public class IOServer { |

客户端实现:

1 | public class MyClient { |

从服务端代码中我们可以看到,在传统的IO模型中,每个连接创建成功之后都需要一个线程来维护,每个线程包含一个while死循环。

如果在用户数量较少的情况下运行是没有问题的,但是对于用户数量比较多的业务来说,服务端可能需要支撑成千上万的连接,IO模型可能就不太合适了。

如果有1万个连接就对应1万个线程,继而1万个while死循环,这种模型存在以下问题:

- 当客户端越多,就会创建越多的处理线程。线程是操作系统中非常宝贵的资源,同一时刻有大量的线程处于阻塞状态是非常严重的资源浪费。并且如果务器遭遇洪峰流量冲击,例如双十一活动,线程池会瞬间被耗尽,导致服务器瘫痪。

- 因为是阻塞式通信,线程爆炸之后操作系统频繁进行线程切换,应用性能急剧下降。

- IO编程中数据读写是以字节流为单位,效率不高。

3.2 NIO编程

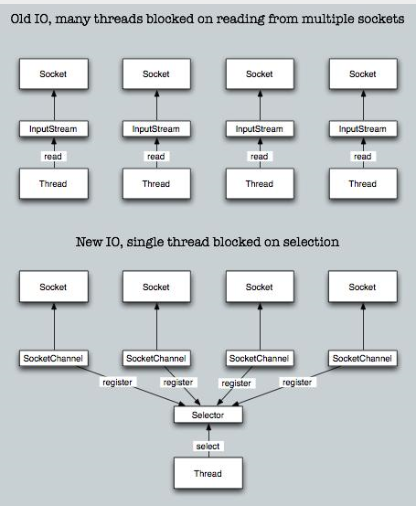

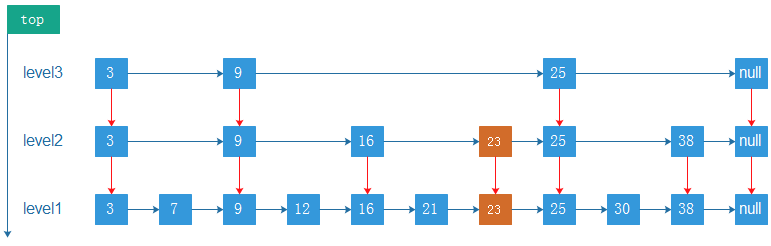

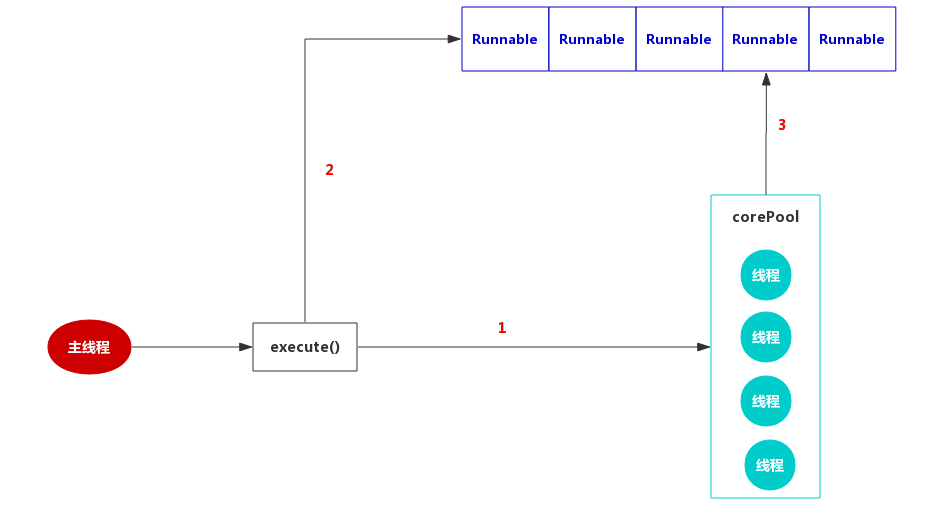

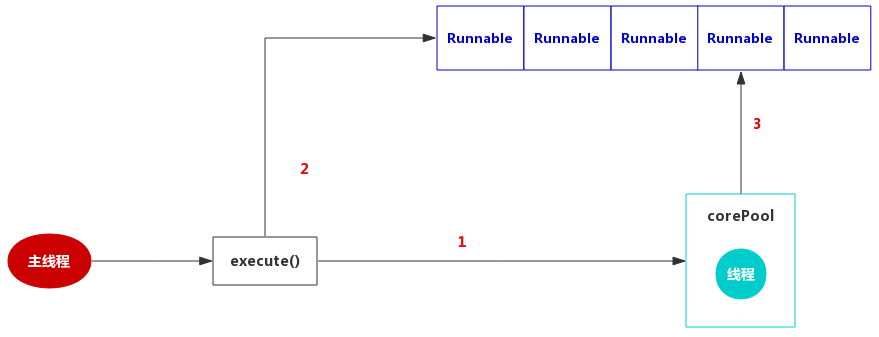

NIO,也叫做new-IO或者non-blocking-IO,可理解为非阻塞IO。NIO编程模型中,新来一个连接不再创建一个新的线程,而是可以把这条连接直接绑定到某个固定的线程,然后这条连接所有的读写都由这个线程来负责,我们用一幅图来对比一下IO与NIO:

如上图所示,IO模型中,一个连接都会创建一个线程,对应一个while死循环,死循环的目的就是不断监测这条连接上是否有数据可以读。但是在大多数情况下,1万个连接里面同一时刻只有少量的连接有数据可读,因此,很多个while死循环都白白浪费掉了,因为没有数据。

而在NIO模型中,可以把这么多的while死循环变成一个死循环,这个死循环由一个线程控制。这就是NIO模型中选择器(Selector)的作用,一条连接来了之后,现在不创建一个while死循环去监听是否有数据可读了,而是直接把这条连接注册到选择器上,通过检查这个选择器,就可以批量监测出有数据可读的连接,进而读取数据。

举个栗子,在一家餐厅里,客人有点菜的需求,一共有100桌客人,有两种方案可以解决客人点菜的问题:

方案一:

每桌客人配一个服务生,每个服务生就在餐桌旁给客人提供服务。如果客人要点菜,服务生就可以立刻提供点菜的服务。那么100桌客人就需要100个服务生提供服务,这就是IO模型,一个连接对应一个线程。

方案二:

一个餐厅只有一个服务生(假设服务生可以忙的过来)。这个服务生隔段时间就询问所有的客人是否需要点菜,然后每一时刻处理所有客人的点菜要求。这就是NIO模型,所有客人都注册到同一个服务生,对应的就是所有的连接都注册到一个线程,然后批量轮询。

这就是NIO模型解决线程资源受限的方案,实际开发过程中,我们会开多个线程,每个线程都管理着一批连接,相对于IO模型中一个线程管理一条连接,消耗的线程资源大幅减少。

NIO的三大核心组件:通道(Channel)、缓冲(Buffer)、选择器(Selector)

通道(Channel)

是传统IO中的Stream(流)的升级版。Stream是单向的、读写分离(inputstream和outputstream),Channel是双向的,既可以进行读操作,又可以进行写操作。

缓冲(Buffer)

Buffer可以理解为一块内存区域,可以写入数据,并且在之后读取它。

选择器(Selector)

选择器(Selector)可以实现一个单独的线程来监控多个注册在她上面的信道(Channel),通过一定的选择机制,实现多路复用的效果。

NIO相对于IO的优势:

- IO是面向流的,每次都是从操作系统底层一个字节一个字节地读取数据,并且数据只能从一端读取到另一端,不能前后移动流中的数据。NIO则是面向缓冲区的,每次可以从这个缓冲区里面读取一块的数据,并且可以在需要时在缓冲区中前后移动。

- IO是阻塞的,这意味着,当一个线程读取数据或写数据时,该线程被阻塞,直到有一些数据被读取,或数据完全写入,在此期间该线程不能干其他任何事情。而NIO是非阻塞的,不需要一直等待操作完成才能干其他事情,而是在等待的过程中可以同时去做别的事情,所以能最大限度地使用服务器的资源。

- NIO引入了IO多路复用器selector。selector是一个提供channel注册服务的线程,可以同时对接多个Channel,并在线程池中为channel适配、选择合适的线程来处理channel。由于NIO模型中线程数量大大降低,线程切换效率因此也大幅度提高。

和前面一样的场景,使用NIO实现(复制代码演示效果即可):

1 | public class NIOServer { |

4 Netty

4.1 为什么使用Netty

我们已经有了NIO能够提高程序效率了,为什么还要使用Netty?

简单的说:Netty封装了JDK的NIO,让你用得更爽,你不用再写一大堆复杂的代码了。

官方术语:Netty是一个异步事件驱动的网络应用框架,用于快速开发可维护的高性能服务器和客户端。

下面是使用Netty不使用JDK原生NIO的一些原因:

- 使用JDK自带的NIO需要了解太多的概念,编程复杂

- Netty底层IO模型随意切换,而这一切只需要做微小的改动,就可以直接从NIO模型变身为IO模型

- Netty自带的拆包解包,异常检测等机制,可以从NIO的繁重细节中脱离出来,只需要关心业务逻辑

- Netty解决了JDK的很多包括空轮询在内的bug

- Netty底层对线程,selector做了很多细小的优化,精心设计的线程模型做到非常高效的并发处理

- 自带各种协议栈让你处理任何一种通用协议都几乎不用亲自动手

- Netty社区活跃,遇到问题随时邮件列表或者issue

- Netty已经历各大rpc框架,消息中间件,分布式通信中间件线上的广泛验证,健壮性无比强大

和IO编程一样的案例:

添加Netty依赖

1 | <dependency> |

服务端:

1 | public class NettyServer { |

客户端:

1 | public class NettyClient { |

4.2 Netty的事件驱动

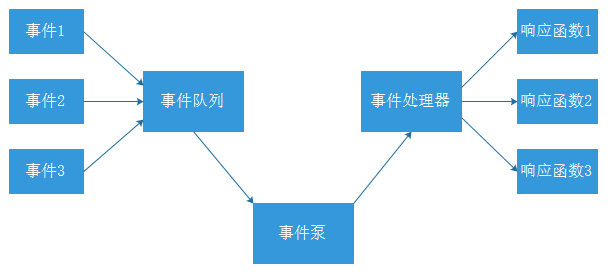

例如很多系统都会提供 onClick() 事件,这个事件就代表鼠标按下事件。事件驱动模型的大体思路如下:

- 有一个事件队列;

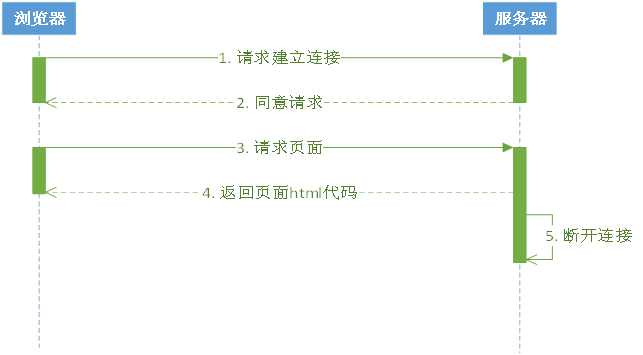

- 鼠标按下时,往事件队列中增加一个点击事件;

- 有个事件泵,不断循环从队列取出事件,根据不同的事件,调用不同的函数;

- 事件一般都各自保存各自的处理方法的引用。这样,每个事件都能找到对应的处理方法;

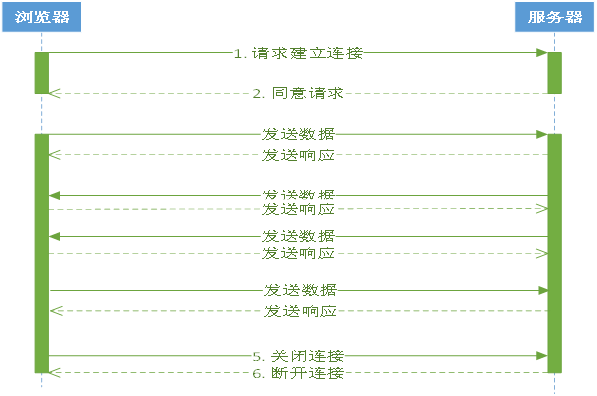

为什么使用事件驱动?

程序中的任务可以并行执行

任务之间高度独立,彼此之间不需要互相等待

在等待的事件到来之前,任务不会阻塞

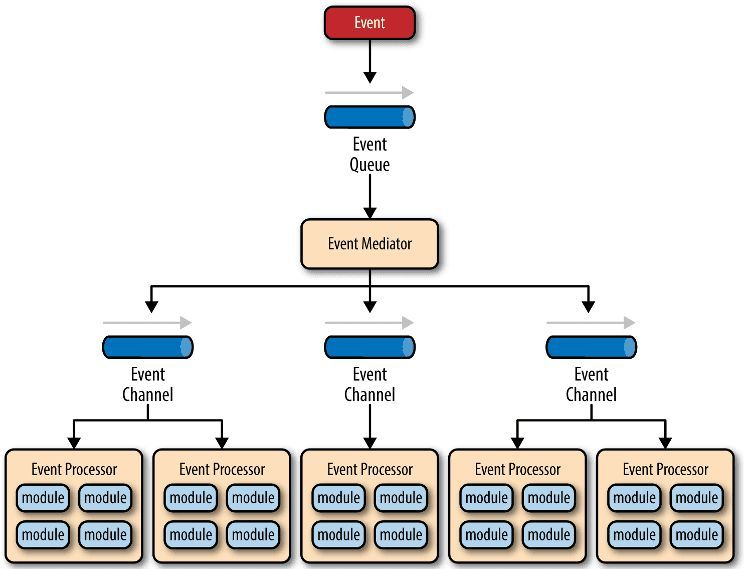

Netty使用事件驱动的方式作为底层架构,包括:

- 事件队列(event queue):接收事件的入口。

- 分发器(event mediator):将不同的事件分发到不同的业务逻辑单元。

- 事件通道(event channel):分发器与处理器之间的联系渠道。

- 事件处理器(event processor):实现业务逻辑,处理完成后会发出事件,触发下一步操作。

4.4 核心组件

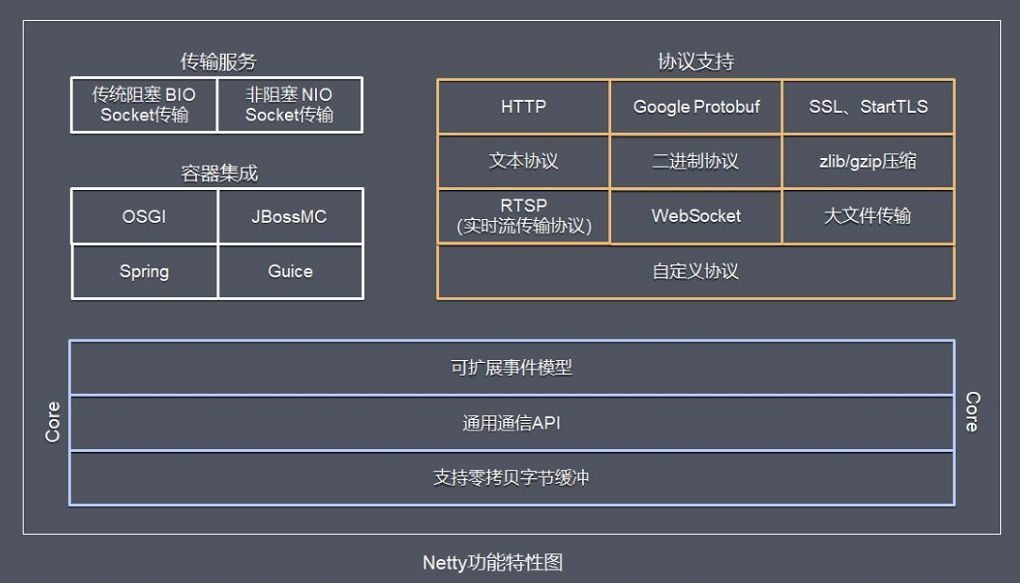

Netty 的功能特性图:

Netty 功能特性:

- 传输服务,支持 BIO 和 NIO。

- 容器集成:支持 OSGI、JBossMC、Spring、Guice 容器。

- 协议支持:HTTP、Protobuf、二进制、文本、WebSocket 等,支持自定义协议。

BIO和NIO的区别:

| 场景 | BIO | NIO |

|---|---|---|

| 有新连接请求时 | 开一个新的线程处理 | 使用多路复用原理,一个线程处理 |

| 适用场景 | 连接数小且固定 | 连接数特别多,连接比较短(轻操作)的场景 |

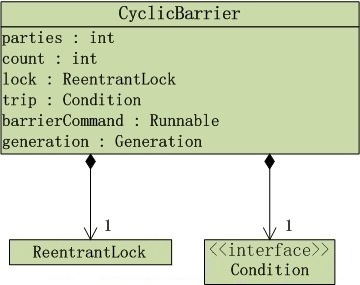

Netty框架包含如下的组件:

ServerBootstrap :用于接受客户端的连接以及为已接受的连接创建子通道,一般用于服务端。

Bootstrap:不接受新的连接,并且是在父通道类完成一些操作,一般用于客户端的。

Channel:对网络套接字的I/O操作,例如读、写、连接、绑定等操作进行适配和封装的组件。

EventLoop:处理所有注册其上的channel的I/O操作。通常情况一个EventLoop可为多个channel提供服务。

EventLoopGroup:包含有多个EventLoop的实例,用来管理 event Loop 的组件,可以理解为一个线程池,内部维护了一组线程。

ChannelHandler和ChannelPipeline:例如一个流水线车间,当组件从流水线头部进入,穿越流水线,流水线上的工人按顺序对组件进行加工,到达流水线尾部时商品组装完成。流水线相当于

ChannelPipeline,流水线工人相当于ChannelHandler,源头的组件当做event。ChannelInitializer:用于对刚创建的channel进行初始化,将ChannelHandler添加到channel的ChannelPipeline处理链路中。

ChannelFuture:与jdk中线程的Future接口类似,即实现并行处理的效果。可以在操作执行成功或失败时自动触发监听器中的事件处理方法。

上面的Netty框架包含如下的组件大概看的有点蒙,我们对之前编写的代码加上注释:

服务端:

1 | public class NettyServer { |

客户端:

1 | public class NettyClient { |

5 整合Netty和WebSocket

我们需要使用netty对接websocket连接,实现双向通信,这一步需要有服务端的netty程序,用来处理客户端的websocket连接操作,例如建立连接,断开连接,收发数据等。

5.1 修改配置

修改消息通知微服务模块tensquare_notice的pom文件,添加下面的dependency依赖

1

<dependency>

1

<groupId>org.springframework.boot</groupId>

1

<artifactId>spring-boot-starter-amqp</artifactId>

1

</dependency>

1

<dependency>

1

<groupId>io.netty</groupId>

1

<artifactId>netty-all</artifactId>

1

<version>4.1.5.Final</version>

1

</dependency>

修改application.yml文件,添加下面的配置

1

rabbitmq:

1

host: 192.168.200.128

这样消息通知微服务就引入了netty框架,并且具有了和Rabbitmq交互的能力

5.2 实现Netty的整合

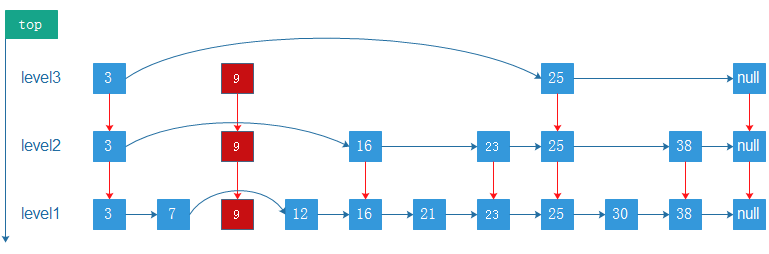

5.2.1 整合分析

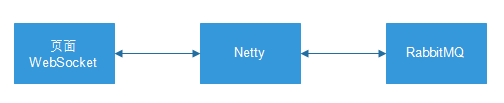

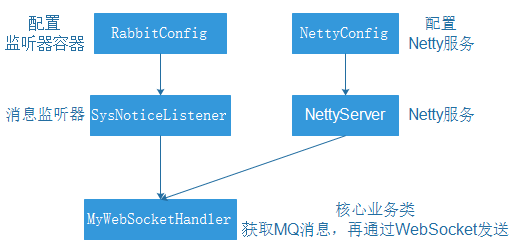

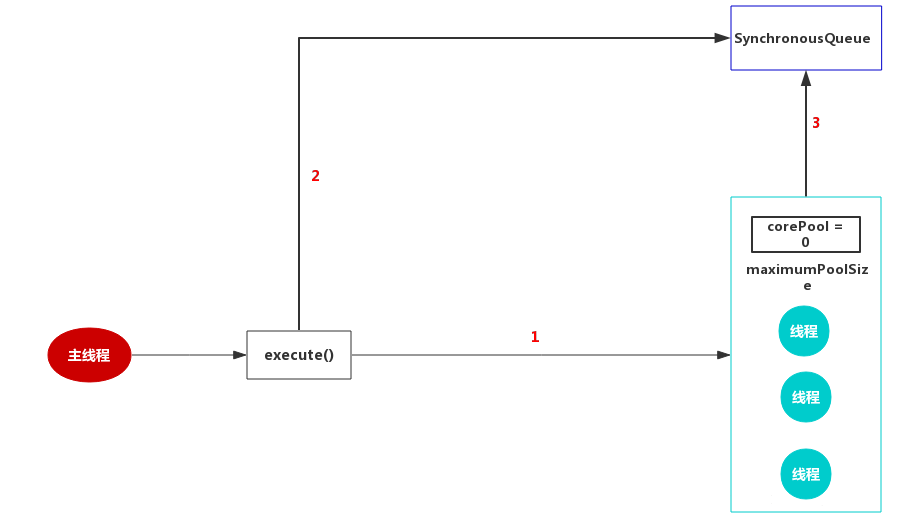

现在的通讯模式如下:

因为使用到了WebSocket和Netty,整合方式和以前有所不同,整合步骤:

- 编写

NettyServer,启动Netty服务。 - 使用配置Bean创建Netty服务。编写

NettyConfig。 - 编写和WebSocket进行通讯处理类

MyWebSocketHandler,进行MQ和WebSocket的消息处理。 - 使用配置Bean创建Rabbit监听器容器,使用监听器。编写

RabbitConfig。 - 编写Rabbit监听器

SysNoticeListener,用来获取MQ消息并进行处理。

五个类的关系如下图:

5.2.2 实现整合

1) 复制资料中的ApplicationContextProvider.java到com.tensquare.notice.config

这个类是工具类,作用是获取Spring容器中的实例

2) 编写NettyServer

com.tensquare.notice.netty

1 | public class NettyServer { |

3) 编写NettyConfig

在com.tensquare.notice.config中编写

1 | @Configuration |

4) 编写MyWebSocketHandler

com.tensquare.notice.netty

1 | public class MyWebSocketHandler extends SimpleChannelInboundHandler<TextWebSocketFrame> { |

5) 编写RabbitConfig

在com.tensquare.notice.config中编写

1 | @Configuration |

6) 编写SysNoticeListener

在com.tensquare.notice.listener中编写:

1 | public class SysNoticeListener implements ChannelAwareMessageListener { |

1) 复制资料中的工具config、listener、netty到tensquare_notice的com.tensquare.notice包中

MyWebSocketHandler中的channelRead0是核心代码,需要根据业务场景进行修改

2) 修改启动类,添加Netty服务的启动

1 | public static void main(String[] args) { |

3) 复制工具中的index.html到resources的static中,这个html是测试页面

4) 启动tensquare-eureka,tensquare-user,tensquare-article,tensquare-notice四个微服务进行测试

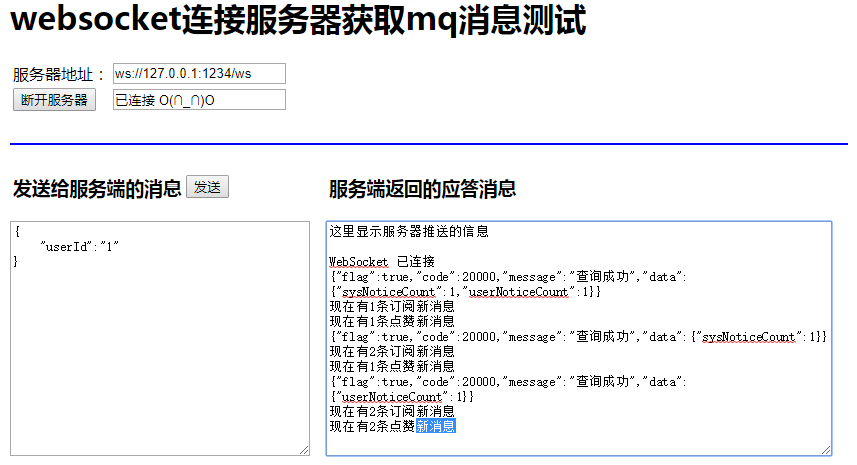

当新增一个文章数据的时候,就会发消息,最终页面显示的效果:

6 文章点赞点对点消息改进

6.1 文章点赞功能改进

在ArticleService中原有的thumbup方法中,增加向用户的点对点消息队列发送消息的功能

改进后完整的代码如下

1 | //文章点赞 |

6.2 消息通知改进

1) 在com.tensquare.notice.listeners包下新建 UserNoticeListener类,添加如下代码

1 | public class UserNoticeListener implements ChannelAwareMessageListener { |

2) RabbitConfig改造如下

1 | @Configuration |

3) MyWebSocketHandler改造如下

1 | public class MyWebSocketHandler extends SimpleChannelInboundHandler<TextWebSocketFrame> { |

6.3 测试点对点消息

1) 启动tensquare-eureka,tensquare-user,tensquare-article,tensquare-notice四个微服务进行测试

当作者的文章被点赞时,会收到点赞的新消息提示,最终页面显示的效果:

第6章 - Redis分布式缓存

学习目标:

- 掌握Redis性能测试

- 掌握Redis读写分离搭建

- 掌握Redis高可用Sentinel搭建

- 掌握Sentinel整合SpringBoot

- 掌握Redis内置集群搭建和维护

- 掌握内置集群整合SpringBoot

- 掌握twemProxy搭建Redis分片式集群

1. Redis读写分离

单机Redis的读写速度非常快,能够支持大量用户的访问。虽然Redis的性能很高,但是对于大型网站来说,每秒需要获取的数据远远超过单台redis服务所能承受的压力,所以我们迫切需要一种方案能够解决单台Redis服务性能不足的问题。

1.1 Redis性能测试

1.1.1 redis-benchmark

redis-benchmark是官方自带的Redis性能测试工具,用来测试Redis在当前环境下的读写性能。我们在使用Redis的时候,服务器的硬件配置、网络状况、测试环境都会对Redis的性能有所影响,我们需要对Redis实时测试以确定Redis的实际性能。

使用语法:

1 | redis-benchmark [参数] [参数值] |

参数说明:

| 选项 | 描述 | 默认值 |

|---|---|---|

| -h | 指定服务器主机名 | 127.0.0.1 |

| -p | 指定服务器端口 | 6379 |

| -s | 指定服务器 socket | |

| -c | 指定并发连接数 | 50 |

| -n | 指定请求数 | 10000 |

| -d | 以字节的形式指定 SET/GET 值的数据大小 | 2 |

| -k | 1=keep alive 0=reconnect | 1 |

| -r | SET/GET/INCR 使用随机 key, SADD 使用随机值 | |

| -P | 通过管道传输 请求 | 1 |

| -q | 强制退出 redis。仅显示 query/sec 值 | |

| –csv | 以 CSV 格式输出 | |

| -l | 生成循环,永久执行测试 | |

| -t | 仅运行以逗号分隔的测试命令列表。 | |

| -I | Idle 模式。仅打开 N 个 idle 连接并等待。 |

安装redis

在虚拟机中安装c++环境:

1 | yum install gcc-c++ |

安装Redis,依次执行以下命令:

1 | # 解压 |

执行以下命令,测试性能:

1 | # 执行测试性能命令 |

执行结果如下:

1 | ====== SET ====== |

在上面的测试结果中,我们关注GET结果最后一行 52110.47 requests per second ,即每秒GET命令处理52110.47个请求,即QPS5.2万。但这里的数据都只是理想的测试数据,测出来的QPS不能代表实际生产的处理能力。

1.1.2 TPS、QPS、RT

在描述系统的高并发能力时,吞吐量(TPS)、QPS、响应时间(RT)经常提到,我们先了解这些概念:

- 响应时间RT

- 吞吐量TPS

- 每秒查询率QPS

响应时间(RT)

响应时间是指系统对请求作出响应的时间。

直观上看,这个指标与人对软件性能的主观感受是非常一致的,因为它完整地记录了整个计算机系统处理请求的时间。由于一个系统通常会提供许多功能,而不同功能的业务逻辑也千差万别,因而不同功能的响应时间也不尽相同。

在讨论一个系统的响应时间时,通常是指该系统所有功能的平均时间或者所有功能的最大响应时间。

吞吐量TPS

吞吐量是指系统在单位时间内处理请求的数量。

对于一个多用户的系统,如果只有一个用户使用时系统的平均响应时间是t,当有你n个用户使用时,每个用户看到的响应时间通常并不是n×t,而往往比n×t小很多。这是因为在处理单个请求时,在每个时间点都可能有许多资源被闲置,当处理多个请求时,如果资源配置合理,每个用户看到的平均响应时间并不随用户数的增加而线性增加。

实际上,不同系统的平均响应时间随用户数增加而增长的速度也不大相同,这也是采用吞吐量来度量并发系统的性能的主要原因。一般而言,吞吐量是一个比较通用的指标,两个具有不同用户数和用户使用模式的系统,如果其最大吞吐量基本一致,则可以判断两个系统的处理能力基本一致。

每秒查询率QPS

每秒查询率QPS是对一个特定的查询服务器在规定时间内所处理流量多少的衡量标准,在互联网中,经常用每秒查询率来衡量服务器的性能。对应fetches/sec,即每秒的响应请求数,也即是最大吞吐能力。

1.1.3 测算Redis性能

在实际生产中,我们需要关心在应用场景中,redis能够处理的QPS是多少。我们需要估计生产的报文大小,使用benchmark工具指定-d数据块大小来模拟:

1 | ./redis-benchmark -t get -n 100000 -c 100 -d 2048 |

测试结果:

1 | ====== GET ====== |

测得的QPS是4.2万

我们也可以使用redis客户端登陆到redis服务中,执行info命令查看redis的其他信息,执行命令:

1 | # 使用Redis客户端 |

查看结果(摘取部分结果):

1 | connected_clients:101 #redis连接数 |

1.2 Redis读写分离

在前面我们已经测试过,如果只有一台服务器,QPS是4.2万,而在大型网站中,可能要求更高的QPS,很明显,一台服务器就不能满足需要了。

1 | Redis在知乎的规模: |

我们可以对读写能力扩展,采用读写分离的方式解决性能瓶颈。运行新的服务器(称为从服务器),让从服务器与主服务器进行连接,然后主服务器发送数据副本,从服务器通过网络根据主服务器的数据副本进行准实时更新(具体的更新速度取决于网络带宽)。

这样我们就有额外的从服务器处理读请求,通过将读请求分散到不同的服务器上面进行处理, 用户可以从新添加的从服务器上获得额外的读查询处理能力。

redis已经发现了这个读写分离场景特别普遍,自身集成了读写分离供用户使用。我们只需在redis的配置文件里面加上一条,slaveof host port语句配置即可,我们现在开始配置主从环境。

执行命令:

1 | # 复制redis |

分别连接主库(6379)和从库(6380),测试发现主库的写操作,从库立刻就能看到相同的数据。但是在从库进行写操作,提示 READONLY You can't write against a read only slave 不能写数据到从库。

现在我们就可以通过这种方式配置多个从库读操作,主库进行写操作,实现读写分离,以提高redis的QPS。

1.3 Redis同步原理

通过上面的例子,我们知道redis的主从复制,主服务器执行写操作命令,从服务器会通过主服务器的数据的变化,同步数据到从服务器。但是如果主服务器下线,从服务器无法连接主服务器,那么数据同步该如何拿到不能连接主服务器这段时间的命令呢?

主从复制中的主从服务器双方的数据库将保存相同的数据,概念上将这种现象称作数据库状态一致。

Redis数据库持久化有两种方式:RDB全量持久化和AOF增量持久化。

数据同步步骤:

redis2.8版本之前使用旧版复制功能SYNC,这是一个非常耗费资源的操作

- 主服务器需要执行BGSAVE命令来生成RDB文件,这个生成操作会耗费主服务器大量量的的CPU、内存和磁盘读写资源。

- 主服务器将RDB文件发送给从服务器,这个发送操作会耗费主从服务器大量的网络带宽和流量,并对主服务器响应命令

- 请求的时间产生影响:接收到RDB文件的从服务器在载入文件的过程是阻塞的,无法处理命令请求

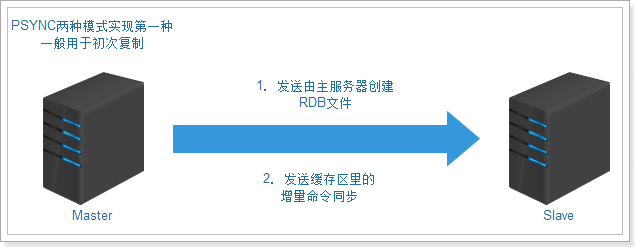

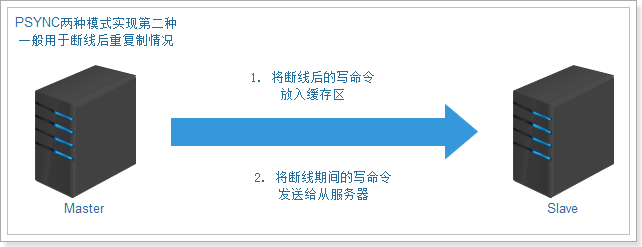

2.8之后使用PSYNC,具有完整重同步和部分重同步两种模式部分重同步两种模式。

第一种完整重同步:

第二种部分重同步:

功能由以下三个部分构成:

1) 主服务的复制偏移量(replication offset)和从服务器的复制偏移量量。

2) 主服务器的复制积压缓冲区(replication backlog),默认大小为1M。

3) 服务器的运行ID,用于存储服务器标识:

如果从服务器断线重新连接,获取主服务器的运行ID与重接后的主服务器运行ID进行对比,

判断是不是原来的主服务器,从而决定是执行部分重同步,还是执行完整重同步。

2. Redis高可用Sentinel

2.1 高可用介绍

高可用是分布式系统架构设计中必须考虑的因素之一,它是通过架构设计减少系统不能提供服务的时间。保证高可用通常遵循下面几点:

- 单点是系统高可用的大敌,应该尽量在系统设计的过程中避免单点。

- 通过架构设计而保证系统高可用的,其核心准则是:冗余。

- 每次出现故障需要人工介入恢复,会增加系统不可用的时间,实现自动故障转移。

我们现在已经给Redis实现了主从复制,可将主节点数据同步给从节点,从节点此时有两个作用:

- 从节点扩展主节点的读能力,分担主节点读压力。

- 一旦主节点宕机,从节点作为主节点的备份可以随时顶上来。(高可用)

2.2 手动主从切换

2.2.1 环境准备

一旦主节点宕机,就需要把从节点晋升成主节点,同时需要修改应用方的主节点地址,还需要命令所有从节点去复制新的主节点,整个过程需要人工操作。我们再准备一个从服务,依次执行以下命令:

1 | cd /usr/local/redis/ |

分别进入一主两从服务,执行info命令,看到服务的状态:

主服务器:

1 | # Replication |

从服务器:

1 | # Replication |

2.2.2 主从切换

主服务下线

登录6379端口号的主服务,并执行shutdown命令,关闭这个主redis,进入6381从服务执行info命令,我们可以看到从服务的信息变为:

1 | # Replication |

可以看到主的状态由原来的up变为down,说明主服务下线了。

主从切换

现在可以把6380升级为主服务,执行命令:

1 | slaveof no one |

修改6381对应的主服务器,执行命令:

1 | slaveof 192.168.200.129 6380 |

再次执行info命令,可以看到主从服务器都切换成功。现在变成了一主一从,对外是正常的。

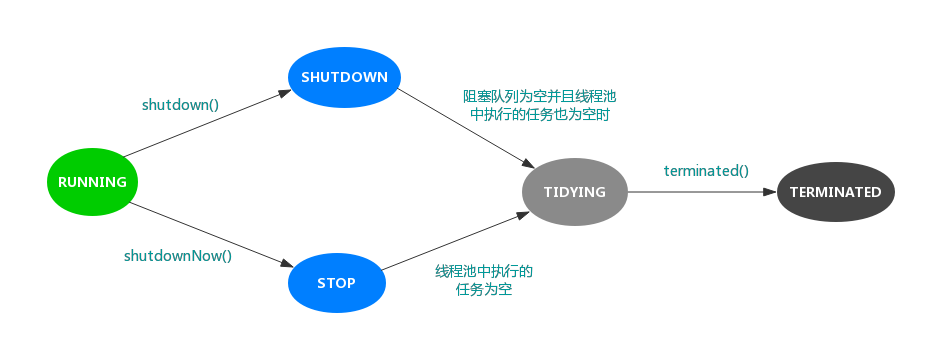

2.3 Sentinel实现高可用

2.3.1 Sentinel介绍

在前面的例子中,主节点宕机,需要把从节点晋升成主节点,同时需要修改应用方的主节点地址,还需要命令所有从节点去复制新的主节点。

这整个过程都是人工,费事费力,还会造成一段时间内服务不可用,而且需要人一直都在。这不是一种好的方式,更多时候,我们优先考虑Sentinel(哨兵)。

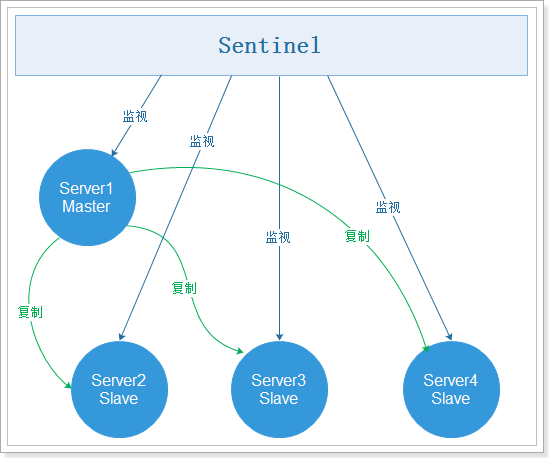

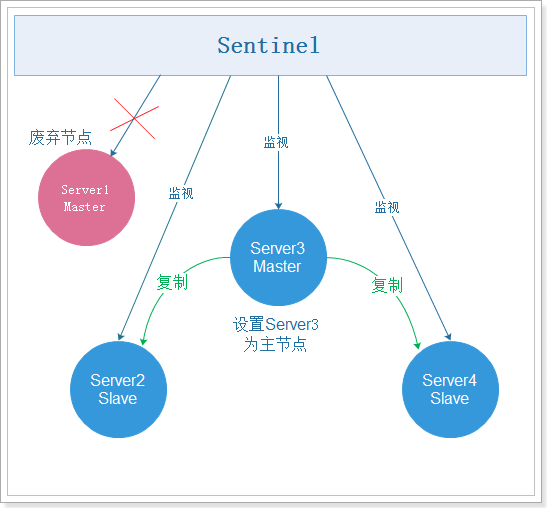

Sentinel工作模式:

2.3.2 Sentinel使用

2.3.2.1 安装

Sentinel在redis的安装包中有,我们直接使用就可以了,但是先需要修改配置文件,执行命令:

1 | cd /usr/local/redis/ |

在sentinel01.conf配置文件中添加:

1 | # 外部可以访问 |

参数说明:

sentinel monitor mymaster 192.168.200.129 6379 1

mymaster主节点名,可以任意起名,但必须和后面的配置保持一致。192.168.200.129 6379主节点连接地址。1将主服务器判断为失效需要投票,这里设置至少需要 1个 Sentinel 同意。sentinel down-after-milliseconds mymaster 10000

设置Sentinel认为服务器已经断线所需的毫秒数。

sentinel failover-timeout mymaster 60000

设置failover(故障转移)的过期时间。当failover开始后,在此时间内仍然没有触发任何failoer操作,当前 sentinel 会认为此次failoer失败。

sentinel parallel-syncs mymaster 1

设置在执行故障转移时, 最多可以有多少个从服务器同时对新的主服务器进行同步, 这个数字越小,表示同时进行同步的从服务器越少,那么完成故障转移所需的时间就越长。

如果从服务器允许使用过期数据集, 那么我们可能不希望所有从服务器都在同一时间向新的主服务器发送同步请求, 因为从服务器在载入主服务器发来的RDB文件时, 会造成从服务器在一段时间内不能处理命令请求。如果全部从服务器一起对新的主服务器进行同步, 那么就可能会造成所有从服务器在短时间内全部不可用的情况出现。

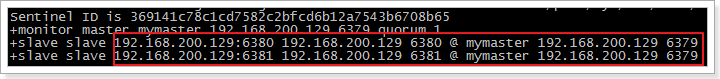

配置文件修改后,执行以下命令,启动sentinel:

1 | /root/redis-4.0.14/src/redis-sentinel sentinel01.conf |

效果如下:

可以看到,6379是主服务,6380和6381是从服务。

2.3.2.2 测试

我们在6379执行shutdown,关闭主服务,Sentinel提示如下:

1 | +sdown master mymaster 192.168.200.129 6379 #主节点宕机 |

根据提示信息,我们可以看到,6379故障转移到了6380,通过投票选择6380为新的主服务器。

在6380执行info

1 | # Replication |

在6381执行info

1 | # Replication |

故障转移如下图:

2.3.3.3 原理

Sentinel主要是监控服务器的状态,并决定是否进行故障转移。如何进行故障转移在前面的部分已经给大家演示过人工的操作,那么Sentinel是如何判断服务是否下线呢,主要分为主观下线和客观下线:

主观下线:

概念:

主观下线(Subjectively Down, 简称 SDOWN)指的是单个 Sentinel 实例对服务器做出的下线判断

特点:

如果一个服务器没有在 master-down-after-milliseconds 选项所指定的时间内, 对向它发送 PING 命令的 Sentinel 返回一个有效回复, 那么 Sentinel 就会将这个服务器标记为主观下线

客观下线

概念:

多个 Sentinel 实例在对同一个服务器做出 SDOWN 判断, 并且通过 SENTINEL is-master-down-by-addr 命令互相交流之后, 得出的服务器下线判断ODOWN。 (一个Sentinel 可以通过向另一个 Sentinel 发送命令来询问对方是否认为给定的服务器已下线)

特点:

从主观下线状态切换到客观下线状态并没有使用严格的法定人数算法(strong quorum algorithm),而是使用了流言传播(Gossip): 如果Sentinel在给定的时间范围内, 从其他Sentinel那里接收到了足够数量的主服务器下线报告, 那么 Sentinel 就会将主服务器的状态从主观下线改变为客观下线。

注意点:

客观下线条件只适用于主服务器,对于其他类型的 Redis 实例, Sentinel 在将它们判断为下线前不不需要进行协商, 所以从服务器或者其他 Sentinel 不会达到客观下线条件。 只要一个 Sentinel 发现某个主服务器进入了客观下线状态, 这个Sentinel就可能会被其他 Sentinel 推选出,并对失效的主服务器执行自动故障迁移操作。

2.3.3.4 小结

Sentinel三大工作任务

监控(Monitoring): Sentinel 会不断地检查你的主服务器和从服务器是否运作正常。

提醒(Notification): 当被监控的某个 Redis 服务器出现问题时, Sentinel 可以通过API向管理员或者其他应用程序发送通知。

自动故障迁移(Automatic failover): 当一个主服务器不能正常工作时,Sentinel会开始一次自动故障转移操作, 它会将失效主服务器的其中一个从服务器升级为新的主服务器, 并让失效主服务器的其他从服务器改为复制新的主服务器。

当客户端试图连接失效的主服务器时, 集群也会向客户端返回新主服务器的地址,使得集群可以使用新主服务器代替失效服务器。

互联网冷备和热备

冷备

概念:

冷备发生在数据库已经正常关闭的情况下,当正常关闭时会提供给我们一个完整的数据库

优点:

- 非常快速的备份方法(只需拷文件)

- 低度维护,高度安全

缺点:

- 单独使用时,只能提供“某一时间点上”的恢复

- 在实施备份的全过程中,数据库必须要作备份而不能作其他工作。也就是说,在冷备份过程中,数据库必须是关闭状态

热备

概念:

热备份是在数据库运行的情况下,采用归档模式(archivelog mode)方式备份数据库的方法

优点:

- 备份的时间短

- 备份时数据库仍可使用

- 可达到秒级恢复

缺点:

- 若热备份不成功,所得结果不可用于时间点的恢复

- 难于维护,要非常仔细小心

2.3.3 Sentinel整合SpringBoot

设置Redis密码

Redis 4.0.14默认开启保护模式protected-mode yes,我们要正常访问需要先设置redis的访问密码,然后才可以进行测试,在所有的redis配置文件redis.conf中,添加如下配置:

1 | # 设置密码 |

在Sentinel哨兵的配置文件sentinel01.conf中添加以下设置:

1 | sentinel auth-pass mymaster 123456 |

Redis命令行登录:

1 | ./redis-cli -h 192.168.200.129 -p 6381 -a 123456 |

其中-a 就是设置访问密码

整合SpringBoot

创建maven工程并在pom.xml添加以下依赖:

1 | <parent> |

编写application.yml配置文件:

1 | spring: |

编写启动类:

1 | @SpringBootApplication |

编写测试类:

1 | @RunWith(SpringRunner.class) |

3. Redis内置集群

3.1 搭建集群

3.1.1 准备redis节点

为了保证可以进行投票,需要至少3个主节点。

每个主节点都需要至少一个从节点,所以需要至少3个从节点。

一共需要6台redis服务器,我们这里使用6个redis实例,端口号为7001~7006

先准备一个干净的redis环境,复制原来的bin文件夹,清理后作为第一个redis节点,具体命令如下:

1 | # 进入redis安装目录 |

集群环境redis节点的配置文件如下:

1 | # 不能设置密码,否则集群启动时会连接不上 |

第一个redis节点node1准备好之后,再复制5份,

1 | cp -R node1/ node2 |

修改六个节点的端口号为7001~7006,修改redis.conf配置文件即可

编写启动节点的脚本:

1 | vi start-all.sh |

内容为:

1 | cd node1 |

设置脚本的权限,并启动:

1 | chmod 744 start-all.sh |

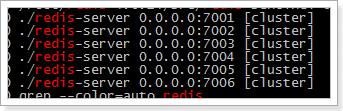

使用命令 ps -ef | grep redis 查看效果如下:

3.1.2 启动redis集群

redis集群的管理工具使用的是ruby脚本语言,安装集群需要ruby环境,先安装ruby环境:

1 | # 安装ruby |

下载符合环境要求的gem,下载地址如下:

https://rubygems.org/gems/redis/versions/4.1.0

课程资料中已经提供了redis-4.1.0.gem,直接上传安装即可,安装命令:

1 | gem install redis-4.1.0.gem |

进入redis安装目录,使用redis自带的集群管理脚本,执行命令:

1 | # 进入redis安装包 |

效果如下:

1 | >>> Creating cluster |

3.1.3 使用redis集群

命令行使用

使用redis的客户端连接redis集群,命令如下:

1 | ./redis-cli -h 192.168.200.129 -p 7001 -c |

其中-c 一定要加,这个是redis集群连接时,进行节点跳转的参数

3.2 集群原理

3.2.1 集群架构图

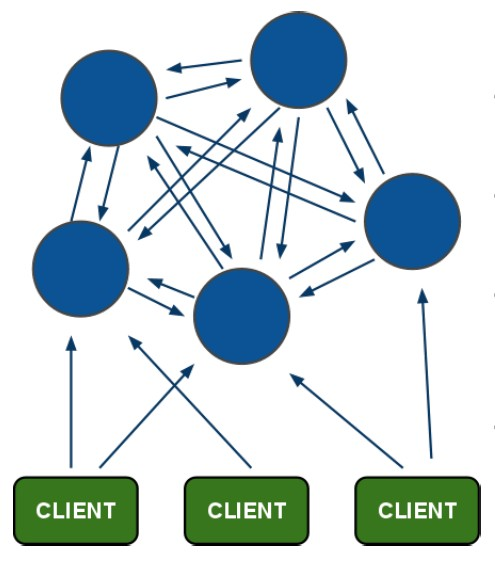

架构特点:

- 所有的redis节点彼此互联(PING-PONG机制),内部使用二进制协议优化传输速度和带宽。

- 节点的fail是通过集群中超过半数的master节点检测失效时才生效。

- 客户端与redis节点直连,不需要连接集群所有节点,只需要连接集群中任意可用节点即可。

- 集群把所有的物理节点映射到[0-16383]slot上,cluster 负责维护node<>slot<>key关系

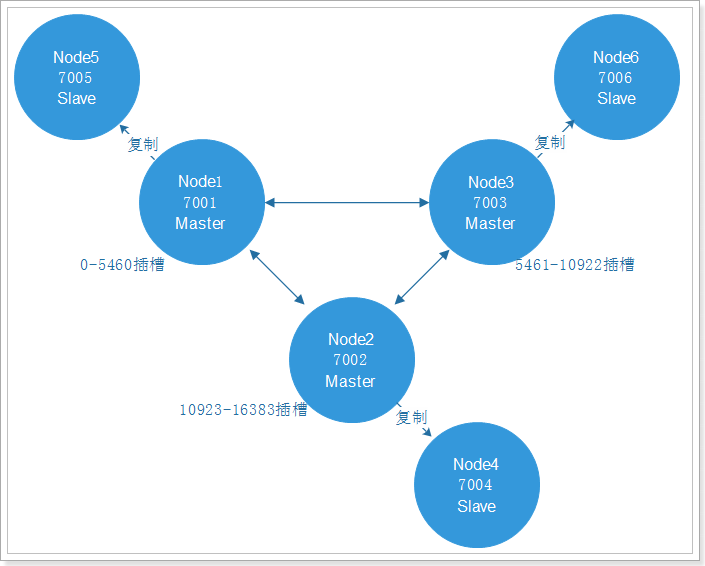

3.2.2 集群的数据分配

在前面的特点中,最后一个node<>slot<>key关系是什么意思呢?这里是说数据是如何放到集群的节点中。

Redis 集群有16384个哈希槽,每个key通过CRC16校验后对16384取模来决定放置哪个槽.集群的每个节点负责一部分哈希槽。可以使用命令查看集群信息:

1 | ./redis-cli -p 7001 cluster nodes | grep master |

结果:

1 | 192.168.200.129:7003@17003 master - 0 1560315648000 3 connected 10923-16383 |

哈希槽的使用:

- 集群搭建的时候分配哈希槽到节点上

- 使用集群的时候,先对数据key进行CRC16的计算

- 对计算的结果求16384的余数,得到的数字范围是0~16383

- 根据余数找到对应的节点(余数对应的哈希槽在哪个节点)

- 跳转到对应的节点,执行命令

这种结构很容易添加或者删除节点。比如果我想新添加节点node4, 我需要从节点 node1, node2, node3中得部分槽到node4上. 如果我想移除节点node1,需要将node1中的槽移到node2和node3节点上,然后将没有任何槽的node1节点从集群中移除即可。

由于从一个节点将哈希槽移动到另一个节点并不会停止服务,所以无论添加删除或者改变某个节点的哈希槽的数量都不不会造成集群不可用的状态。

Redis 集群的主从复制模型

为了使部分节点失败或者大部分节点无法通信的情况下集群仍然可用,所以集群使用了主从复制模型,每个节点都会有一个或多个复制品。

在我们例子中具有 node1, node2, node3三个节点的集群,在没有复制模型的情况下,如果节点node2失败了,那么整个集群就会以为缺少5461-10922这个范围的槽而不可用。Redis集群做主从备份解决了了这个问题。

Redis一致性保证

主节点对命令的复制工作发生在返回命令回复之后, 因为如果主节点每次处理命令请求都需要等待复制操作完成的话, 那么主节点处理命令请求的速度将极大地降低 。

当然现在这种情况也是有问题的,当主节点执行完命令,返回命令回复之后宕机了,并没有完成复制操作,这个时候就有主从的数据不一致的问题。

redis这样设计,就是在性能和一致性之间做出的权衡。

3.3 集群维护

很多时候,我们需要对集群进行维护,调整数据的存储,其实就是对slot哈希槽和节点的调整。Redis内置的集群支持动态调整,可以在集群不停机的情况下,改变slot、添加或删除节点。

3.3.1 分片重哈希

Redis集群节点分片重哈希,调整哈希槽和节点的关系,执行以下命令:

1 | # 分片重哈希,可以连接任意节点 |

查看结果:

1 | # 执行命令,查看hash槽结果 |

我们可以看到7001的哈希槽500-5460,而7004的哈希槽11423-16383,都少了500个哈希槽

而7002的哈希槽0-499 5461-11422,比原来增加了1000个哈希槽

3.3.2 移除节点

移除节点命令的第一个参数是任意节点的地址,第二个节点是想要移除的节点id:

1 | ./redis-trib.rb del-node 192.168.200.129:7001 cbd415973b3e85d6f3ad967441f6bcb5b7da506a |

移除主节点:

- 在移除主节点前,需要确保这个主节点是空的。如果不是空的,需要将这个节点的数据重新分片到其他主节点上

- 替代移除主节点的方法是手动执行故障恢复,被移除的主节点会作为一个从节点存在,不过这种情况下不会减少集群节点的数量,也需要重新分片数据

移除从节点,直接移除成功

3.3.3 添加节点

添加节点前需要保证新的节点是一个干净的,空的redis,主要就是要删除持久化文件和节点配置文件:

1 | rm -rf appendonly.aof |

添加新的主节点

1 | ./redis-trib.rb add-node 192.168.200.129:7005 192.168.200.129:7001 |

添加的新节点默认是没有哈希槽的,需要手动分配哈希槽

添加新的从节点

1 | ./redis-trib.rb add-node --slave 192.168.200.129:7005 192.168.200.129:7001 |

添加的新的从节点,集群默认自动分配对应的主节点。

3.4 整合SpringBoot

使用之前哨兵整合SpringBoot的例子,把配置文件修改为如下内容:

1 | spring: |

编写测试方法:

1 | @Test |

4. Redis集群扩展

4.1 Redis集群现状

我们已经学完了Redis内置集群,是不是这一种方式就足够我们使用了呢?在这里,我们要对redis集群现在使用的情况进行分析。

集群使用现状

Redis Cluster内置集群,在Redis3.0才推出的实现方案。在3.0之前是没有这个内置集群的。

但是在3.0之前,有很多公司都有自己的一套Redis高可用集群方案。虽然现在有内置集群,但是因为历史原因,很多公司都没有切换到内置集群方案,而其原理就是集群方案的核心,这也是很多大厂为什么要问原理的的原因。

网络通信问题

Redis Cluster是无中心节点的集群架构,依靠Gossip协议(谣言传播)协同自动化修复集群的状态。

但Gossip有消息延时和消息冗余的问题,在集群节点数量过多的时候,节点之间需要不断进行PING/PANG通讯,不必须要的流量占用了大量的网络资源。虽然Redis4.0对此进行了优化,但这个问题仍然存在。

数据迁移问题

Redis Cluster可以进行节点的动态扩容缩容,在扩缩容的时候,就需要进行数据迁移。

而Redis 为了保证迁移的一致性, 迁移所有操作都是同步操作,执行迁移时,两端的 Redis 均会进入时长不等的 阻塞状态。对于小 Key,该时间可以忽略不计,但如果一旦 Key 的内存使用过大,严重的时候会接触发集群内的故障转移,造成不必要的切换。

以上原因说明只是学习Redis Cluster并不够,我们还需要学习新的集群方案。

1 | Gossip 的缺陷 |

4.2 一致性哈希算法

4.2.1 分片介绍

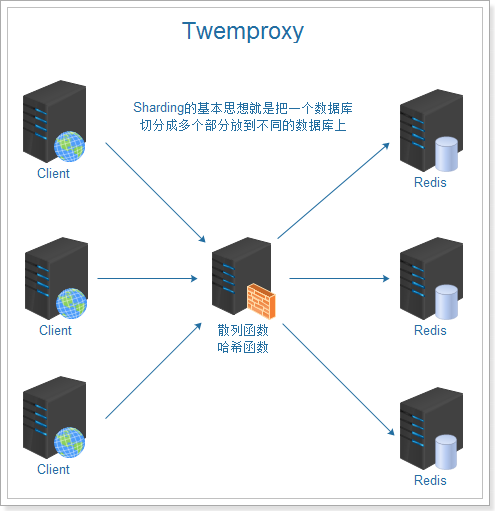

在前面我们讲了内置的集群因为一些原因,在节点数量过多的时候,并不能满足我们的要求,哪还有什么新的集群方案呢?我们在这里讲解使用twemproxy实现hash分片的Redis集群方案,这个方案也是知乎2000万QPS场景所使用的方案。

上图我们看到twemproxy主要的角色是代理服务器的作用,是对数据库进行分片操作。twemproxy的分片保证需要存储的数据散列存放在集群的节点上,尽量做到平均分布。如何实现呢,这里就涉及到一致性哈希算法,这个算法是分布式系统中常用的算法。

4.2.2 传统哈希方案

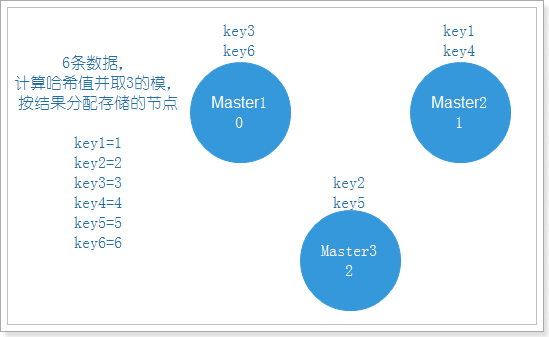

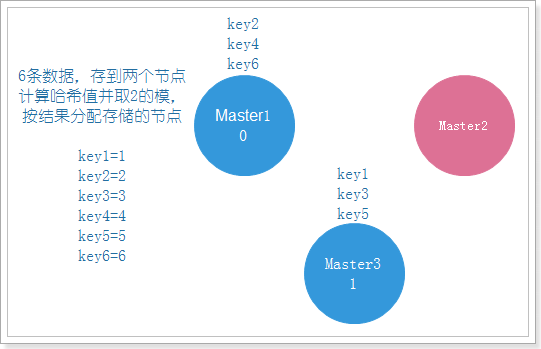

传统方案是使用对象的哈希值,对节点个数取模,再映射到相应编号的节点,这种方案在节点个数变动时,绝大多数对象的映射关系会失效而需要迁移。

1 | Hash,一般翻译做散列、杂凑,或音译为哈希,是把任意长度的输入,通过散列算法变换成固定长度的输出,该输出就是散列值。散列值的空间通常远小于输入的空间,不同的输入可能会散列成相同的输出,所以不可能从散列值来确定唯一的输入值。 |

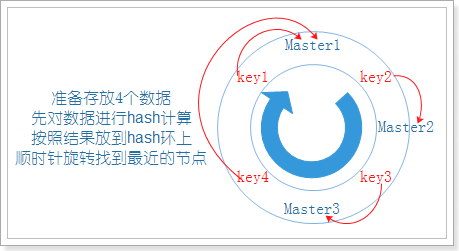

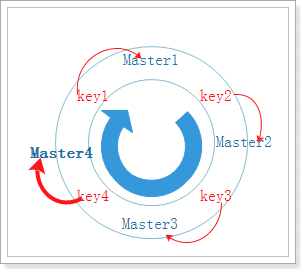

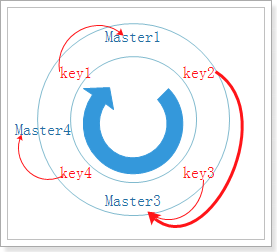

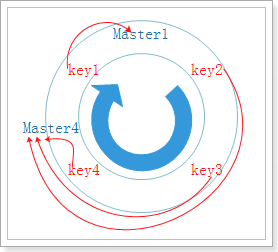

正常有3个节点,取3的模,分配数据,效果如下图:

如果节点挂了一个,那么久需要进行数据迁移,把数据分配到剩下的两个节点上,如下图:

可以看到原本存在Master1上的key3,需要迁移到Master3上,而Master1始终是正常的,这就造成了没有必要的数据迁移,浪费资源,所以我们需要采取另一种方式,一致性哈希算法。

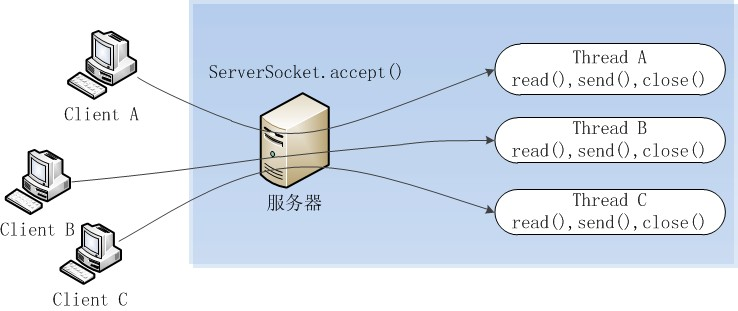

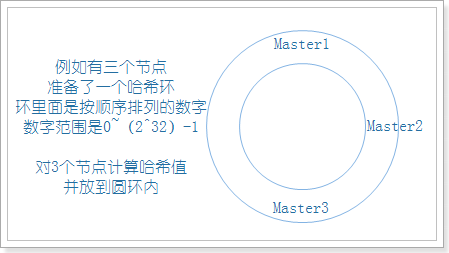

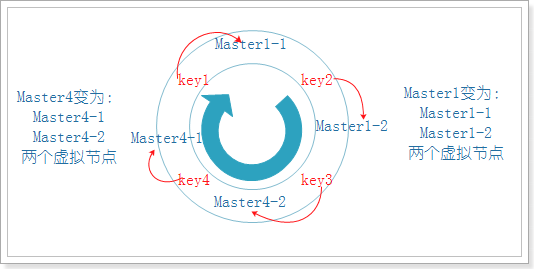

4.2.3 一致性哈希算法