Linux系统的安装,一般都是在虚拟机里面玩,所以了解了Linux基础概念后,我们给虚拟机安装上操作系统,比如centos。

虚拟机安装 实操-VMware安装 1 2 3 4 虚拟机:一台虚拟的电脑. 独立的 虚拟机软件: VmWare:收费的 VirtualBox:免费的. Oracle的产品 .

什么是虚拟软件:

常用的虚拟原件:

VMware workstation下载

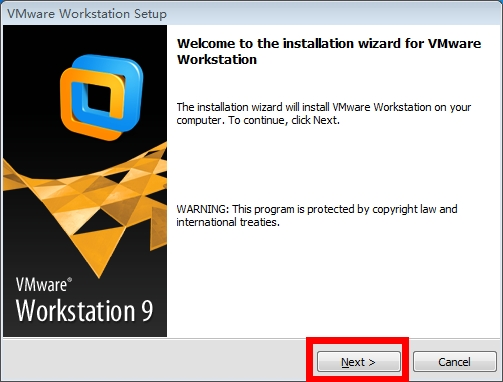

VMware workstation安装

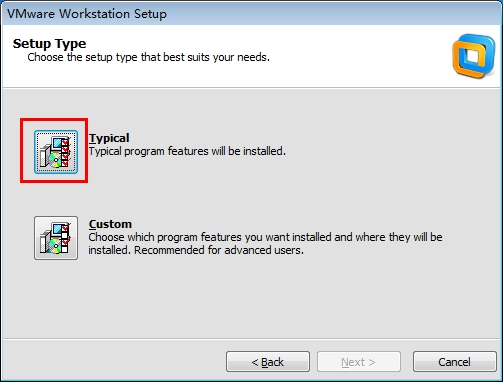

3.选择安装方式

Typical:典型安装

Custom:自定义安装

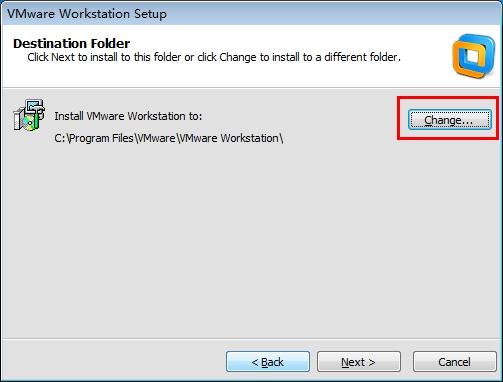

4.选择程序安装位置

点击change选择程序安装位置,然后点击next

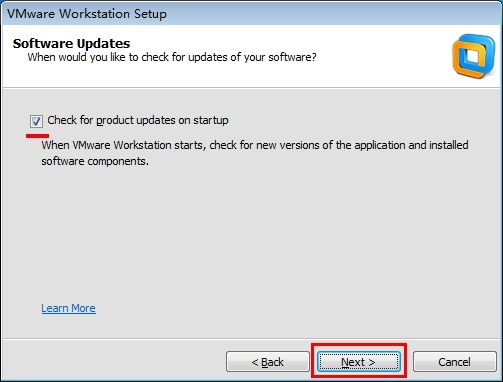

5.选择是否自动检测更新

如勾选,有新版时会提示你跟新版本,点next进行下一步

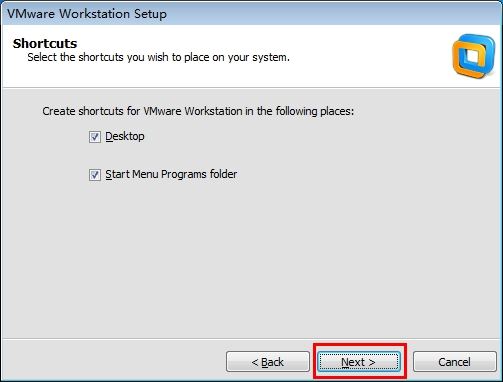

6.创建快捷方式

选择后点击next

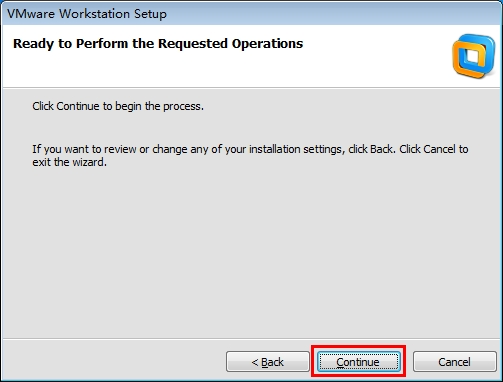

7.配置完成,开始安装程序

点击continue

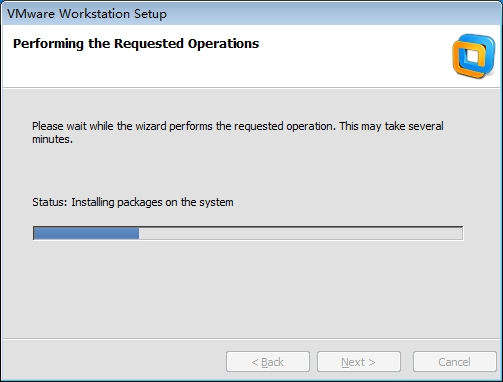

8.开始安装虚拟原件

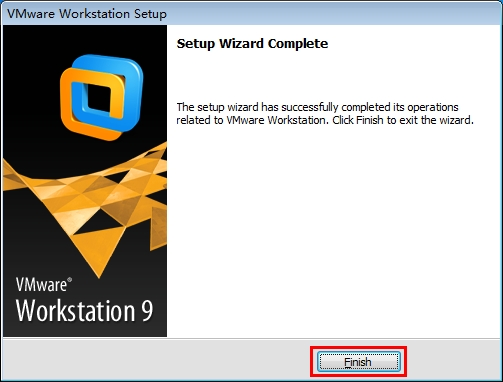

9.完成

点击finish完成安装

注意:

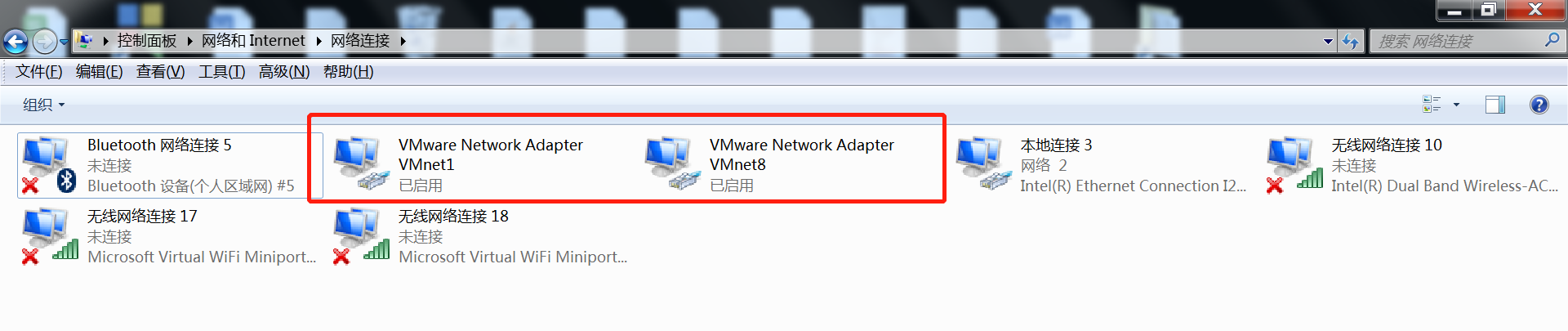

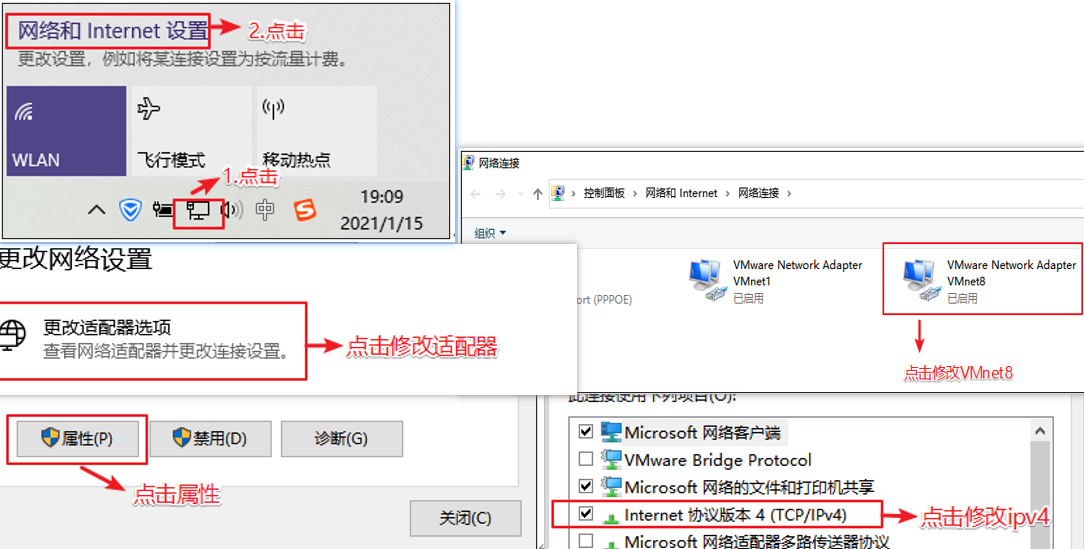

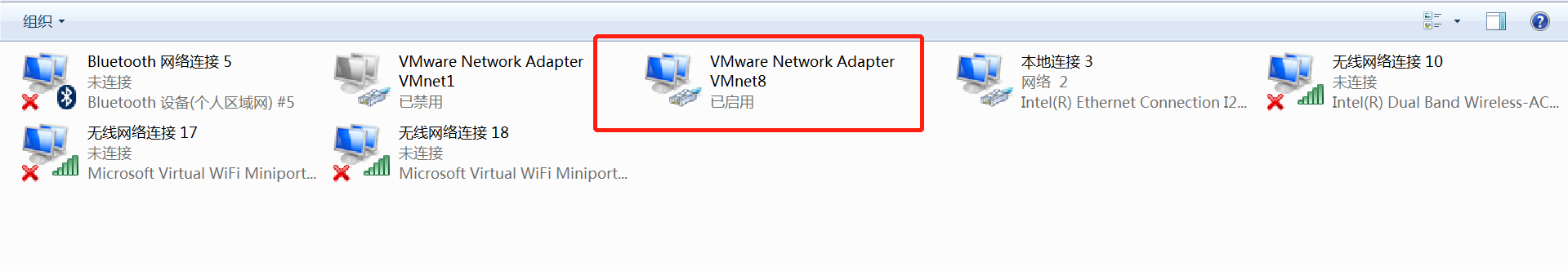

虚拟软件安装完成后会在 \控制面板\网络和Internet\网络连接 下多出来两个虚拟网卡VMware Network Adapter

VMnet1和VMware Network Adapter VMnet8

在我们的虚拟机中有三种模式,分别对应仅主机、桥接、nat模式

分别对应0、1、8如下

VMnet0:这是VMware用于虚拟桥接网络下的虚拟交换机

VMnet1:这是VMware用于虚拟Host-Only网络下的虚拟交换机

VMnet8:这是VMware用于虚拟NAT网络下的虚拟交换机

激活码随便百度找一个填写就行了

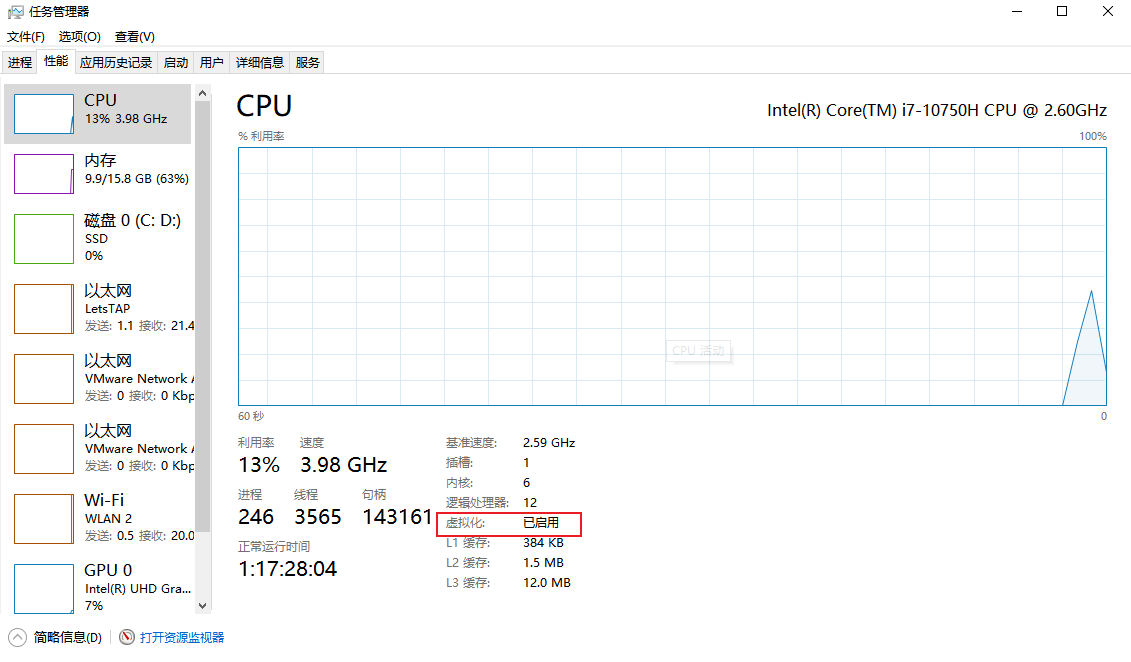

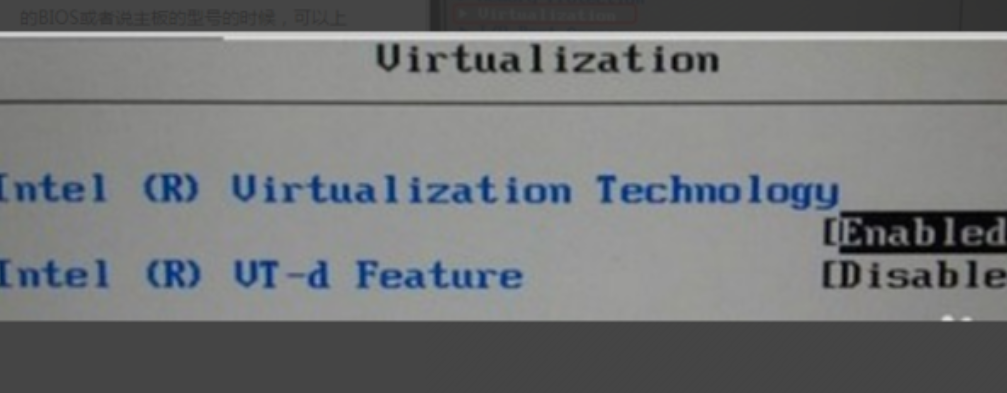

开启虚拟化 检查是否开启

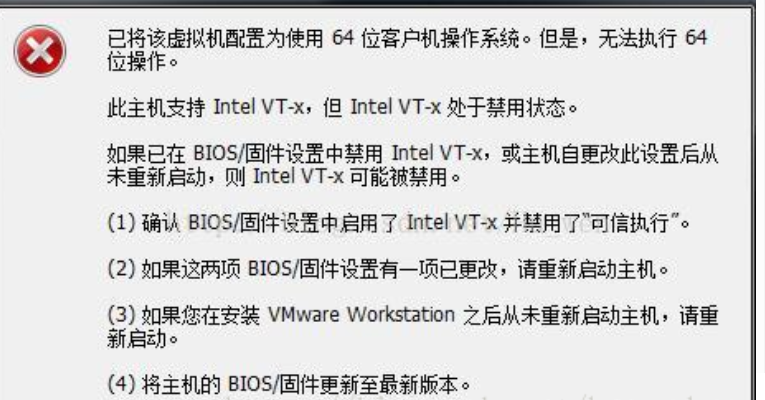

不开启虚拟化的报错信息如下:

我们在创建虚拟机的时候如果不开启虚拟化,会报下面的一个错误,此时,我们就要根据下面的步骤去开启硬件的虚拟化支持

注意:

目前大部分硬件版本都支持虚拟化的开启,只有很少的Blos硬件不支持

如果遇到不支持的VMware是无法使用的。

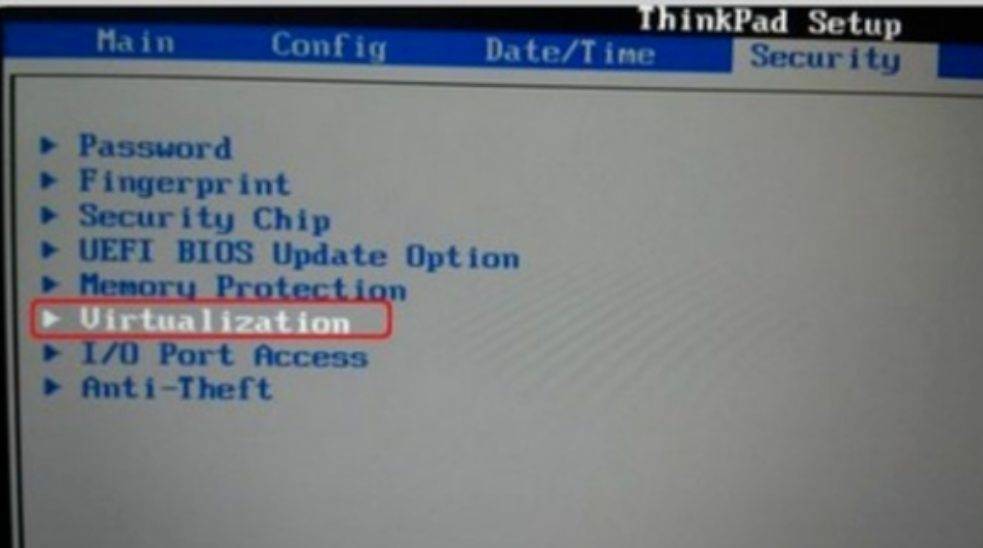

开启虚拟化的步骤:

1、开机(或重启)时进入Blos

注意:不同计算机使用的快捷键不同例如F2、F12、DEL、ESC等键就可以进入到BIOS

进入到BIOS后,找到Confifiguration选项或者Security选项,然后选择Virtualization,或者Intel Virtual Technology,就可以开始设置了

这里ThinkPad为例

2、然后选择Virtualization,或者Intel Virtual Technology然后回车,将其值设置为Enabled。

3、在保存BIOS设置之后,重启计算机。

实操-Centos7安装

镜像可以看成是类似ZIP的压缩文件,与rar ZIP压缩包类似,镜像文件是无法直接使用的,需要利用一些虚拟光驱工具进行解压后才能使用

我们这里就是CentOS系统的镜像文件

为什么选择CentOS

主流: 目前的Linux操作系统主要应用于生产环境,主流企业级Linux系统仍旧是RedHat或者CentOS

免费: RedHat 和CentOS差别不大,CentOS是一个基于Red Hat Linux 提供的可自由使用源代码 的企业级Linux 发行版本

更新方便:CentOS独有的yum命令支持在线升级,可以即时更新系统,不像RED HAT那样需要花钱购买支持服务!

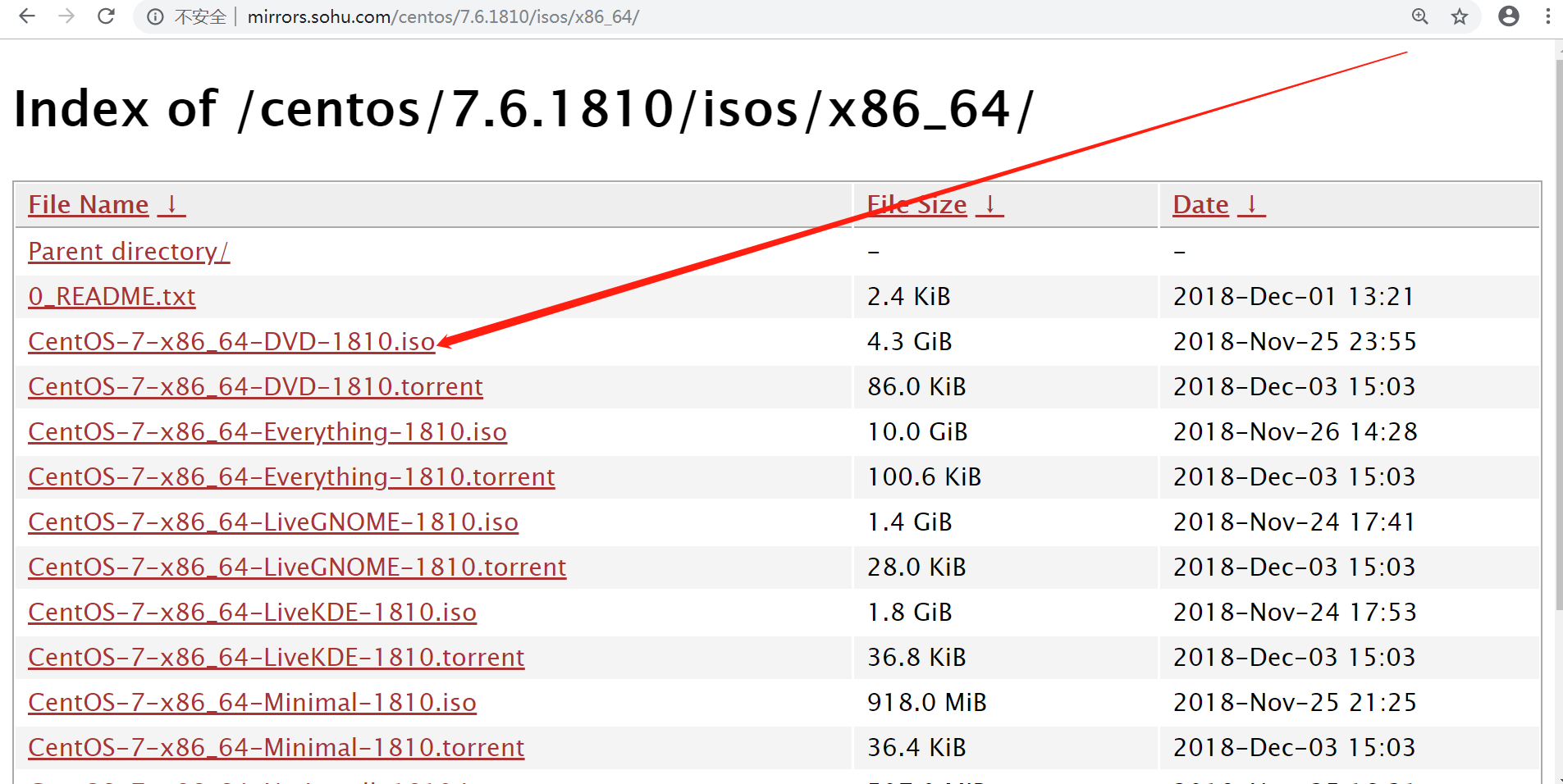

centos7下载

我们在下载的时候建议使用国内镜像源,速度快也稳定

比如:

点击【CentOS-7-x86_64-DVD-1810.iso】进行下载,由于文件比较大,下载时间会比较长,请耐心等待…

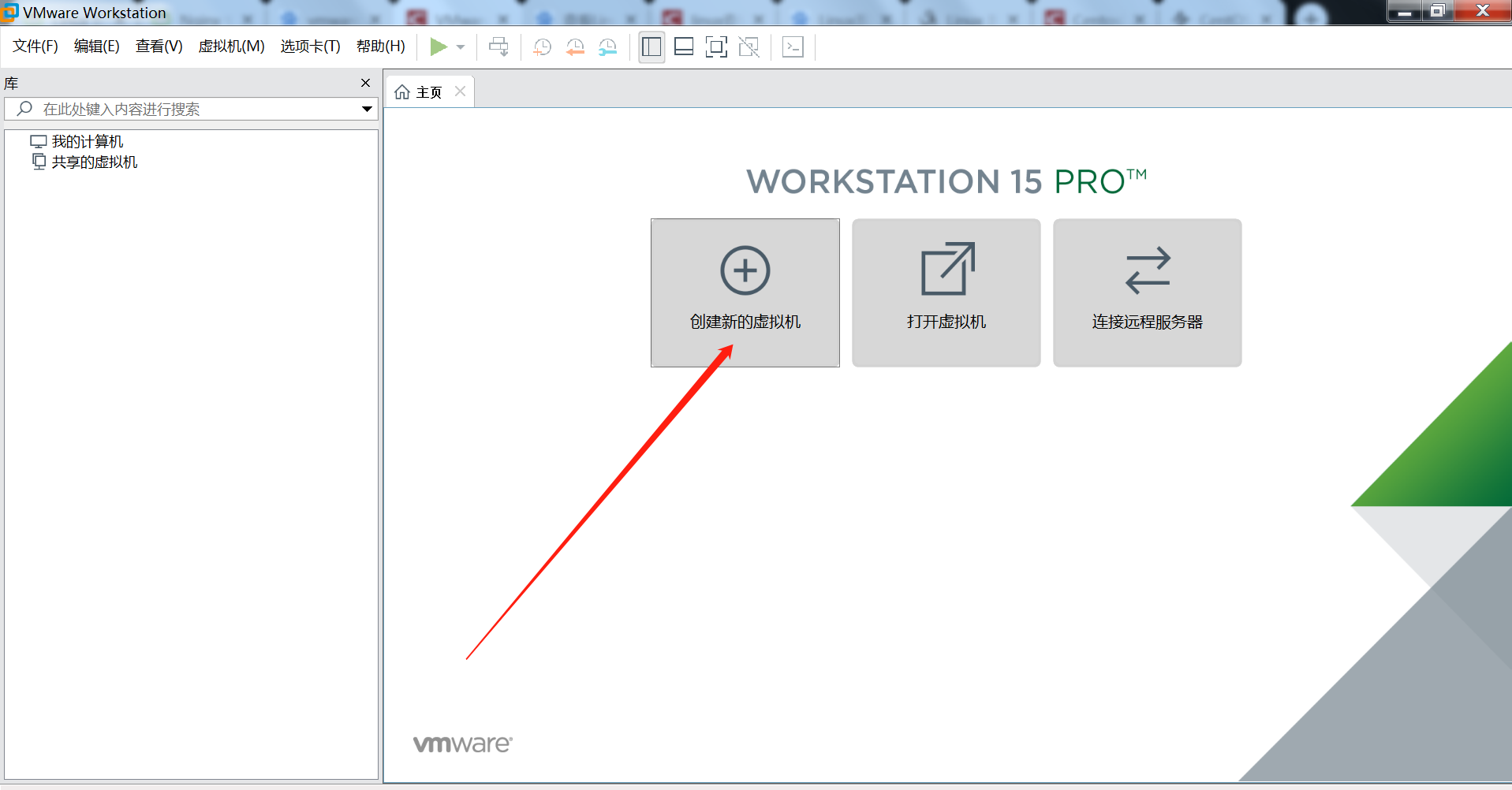

centos7安装 进入VMware 1)安装完VMware后,双击桌面图标,创建新的虚拟机,如下图:

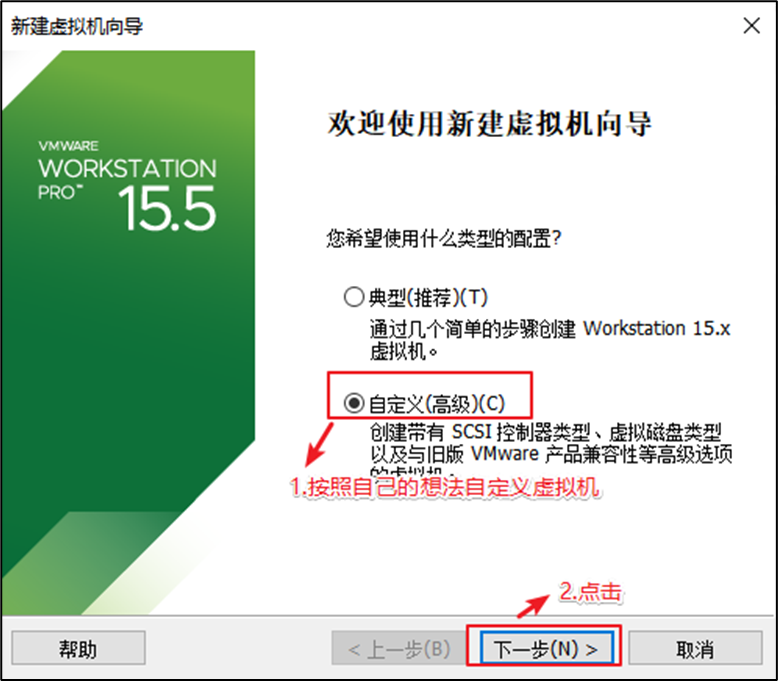

自定义新的虚拟机

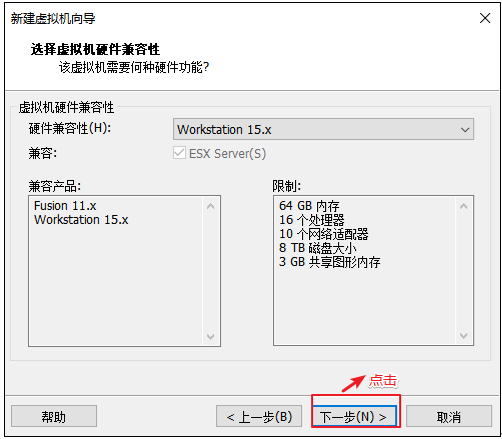

解决虚拟机的兼容性

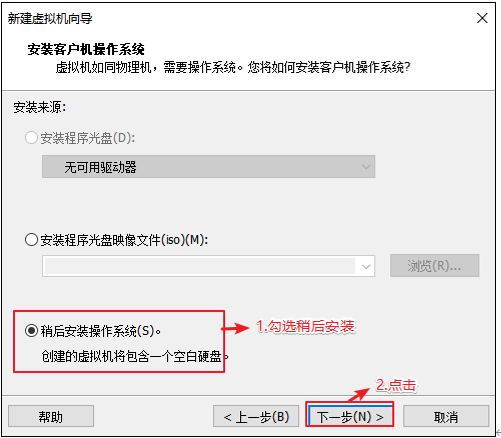

选择当前虚拟机的操作系统 我们先配置电脑,再安装系统

选择虚拟机将来需要安装的系统 因为不同的操作系统需要解决不同的兼容性问题,所以需要选择将来用什么系统,提前做适配

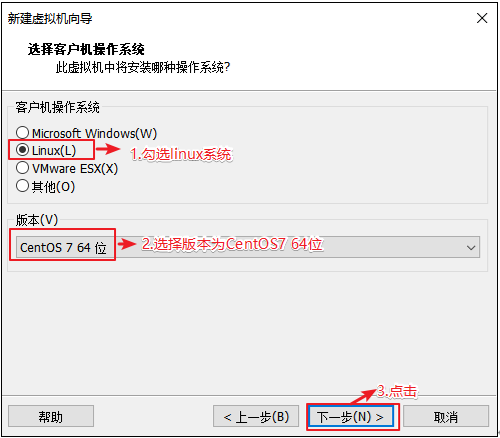

客户机操作系统:选择Linux

版本:选择CentOS7 64位

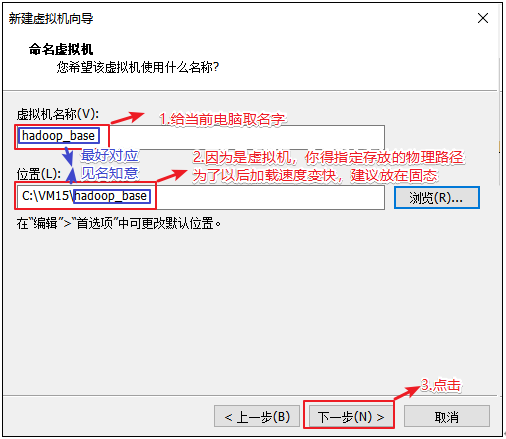

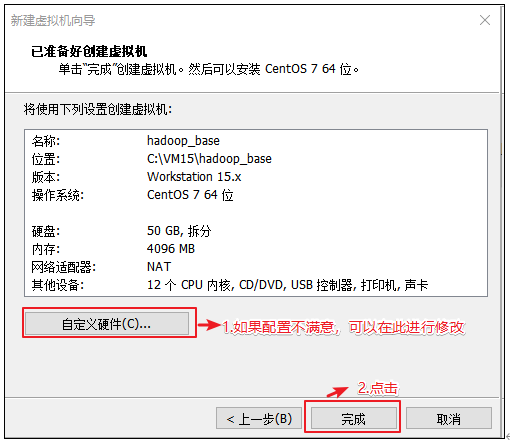

配置电脑 给自己配置电脑取个名字,并存放在物理机的位置在哪

虚拟机名称可以自定义(注意:不要出现特殊字符即可)

虚拟机运行文件路径选择本地磁盘路径(注意:磁盘空间尽量要大写,因为一个虚拟机的运行文件大约要在4G以上)

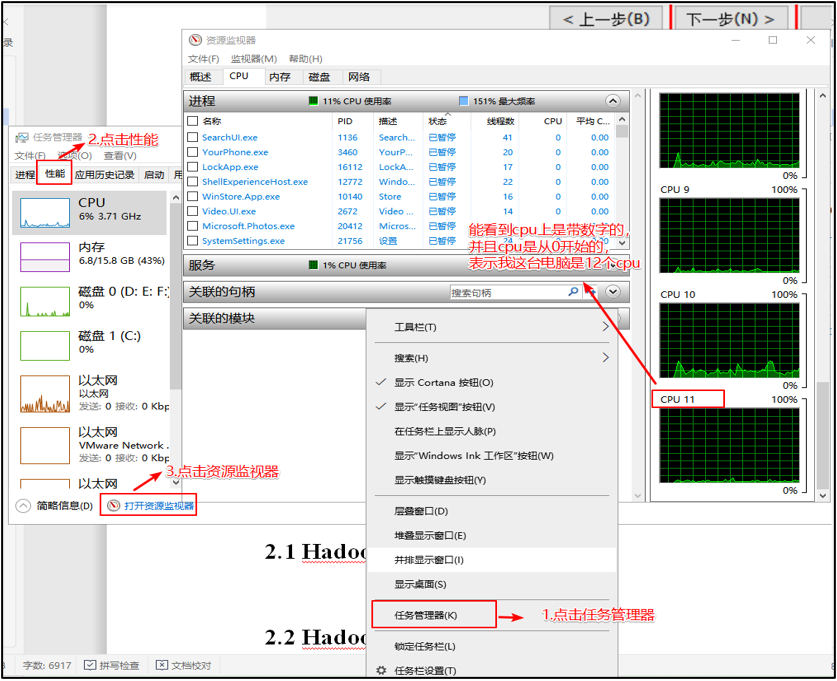

选择CPU的个数 有个原则就是选满(跟物理机的CPU个数相同,但是不能超过)

1 ) 查看物理机CPU 个数(Windows10为例)

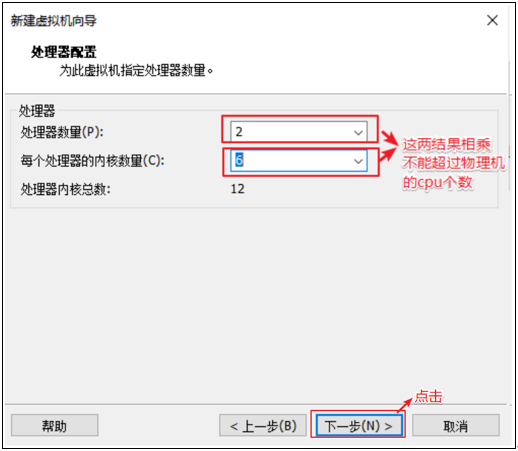

2 )设置虚拟机处理器的数量

安装注意事项

处理器设置:

处理器 1 每个处理器的核数 2 ==> 单核双进程(伪双核)

笔记本自身:4核。则虚拟机设置 1处理器 1核数

笔记本自身:8核。则虚拟机设置 1处理器 2核数 => 可以启动6个虚拟机,剩下2核用来运行母机

cpu数量看主板插槽、每个cpu有多个内核,超线程技术(HT)每个内核扩展出2个逻辑核心(也就是逻辑处理器)。

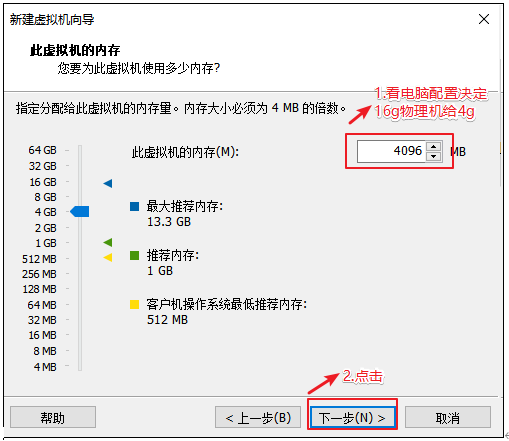

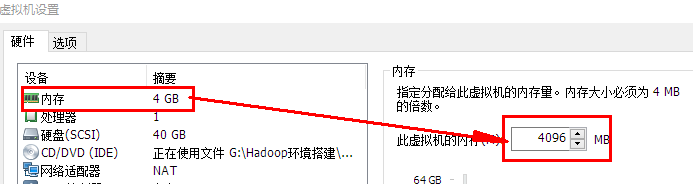

设置虚拟机的内存 内存大小有一定要求,建议4G,不能给太多,后期会有多台虚拟机同时启动

内存设置: 4G(512M) 8G(1,2G) 16G(1,2,4,8G) => 括号内为虚拟机推荐的设置

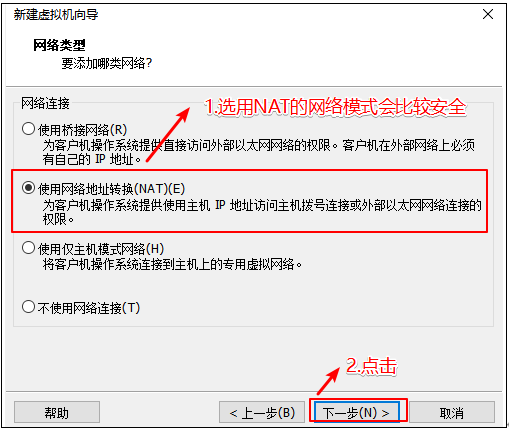

选择虚拟机上网方式 1) 选择NAT的方式

2) 没有VMware之前物理机的网络适配器信息(每个人不同,我只有3个)

3)安装VMware之后物理机的网络适配器信息(会多两个vmnet1和vmnet8)

注:vmnet8是虚拟机使用NAT模式上网的网卡

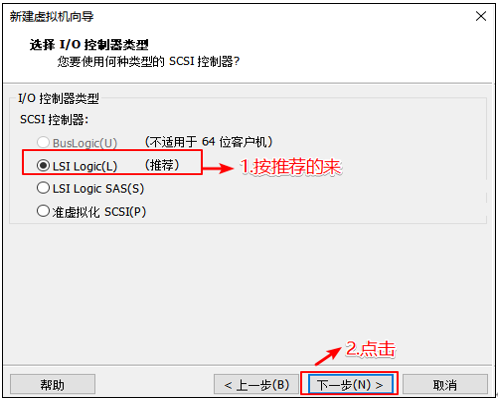

选择对应的文件系统的IO方式

选择磁盘的类型

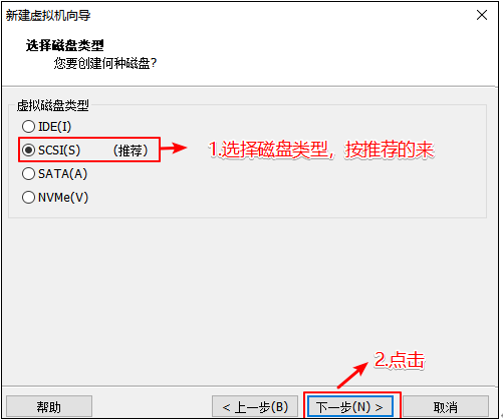

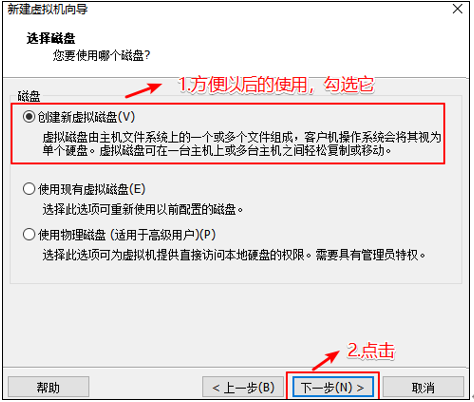

选择磁盘的种类

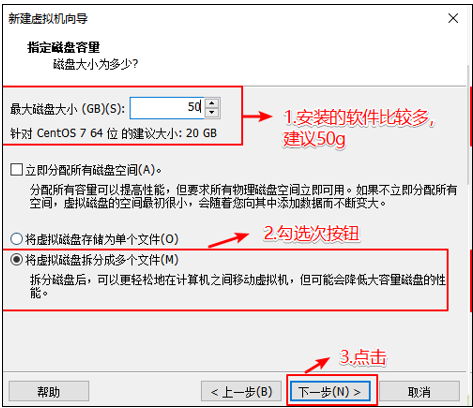

选择虚拟机的磁盘大小 设置磁盘容量,根据自己的需要设置

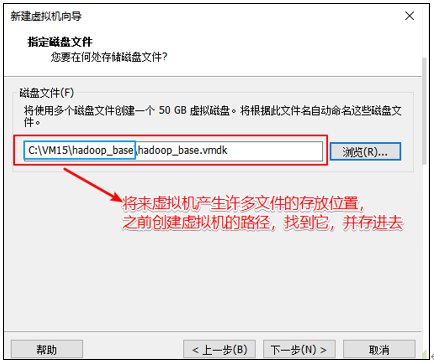

虚拟机文件的存放位置

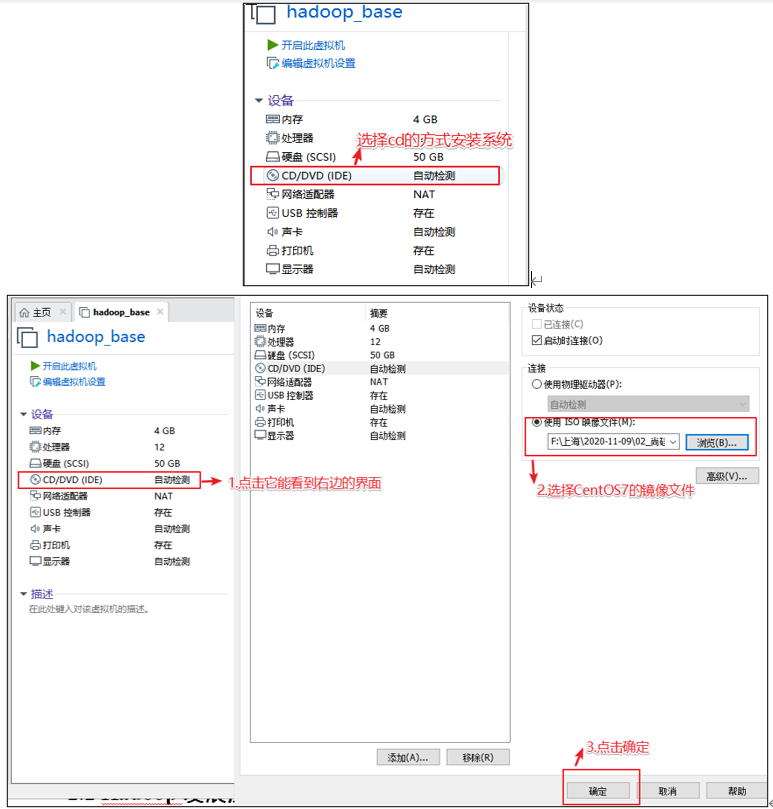

选择安装系统镜像

选择硬件【cd/dvd】,在【使用ISO镜像文件】中选择下载的镜像centos_xxx.iso文件

设置完成后点击【关闭】

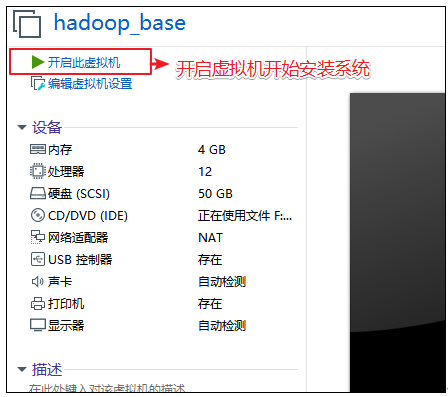

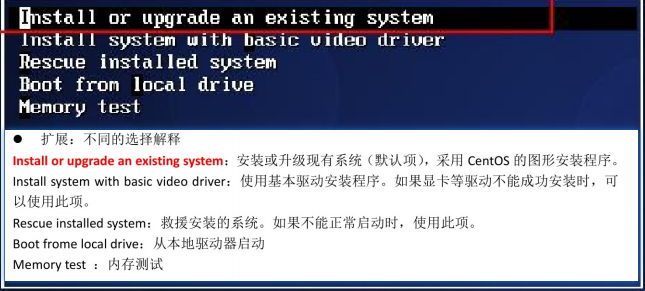

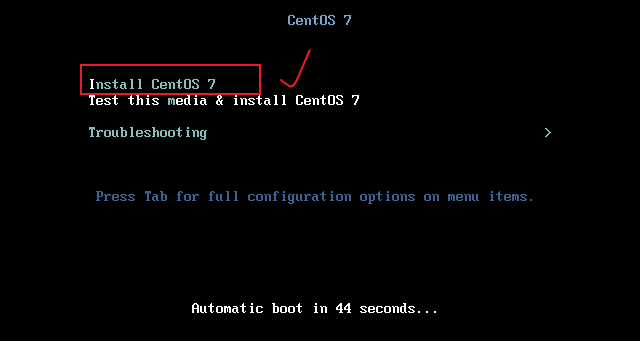

centos7启动

系统安装引导页面

centos6有检查磁盘是否完整,一般不用检查,比较耗时。tab+skip+回车enter跳过检查

或者遇到这种的

你得需要将鼠标点击进入界面中,但是鼠标会消失,你此刻得用键盘的上下键 来控制选项,图标变白了表示当前选中的是哪个选项,然后敲回车,表示执行所选选项。

注意:如果这个时候你需要鼠标可以使用ctrl+alt一起按呼出鼠标

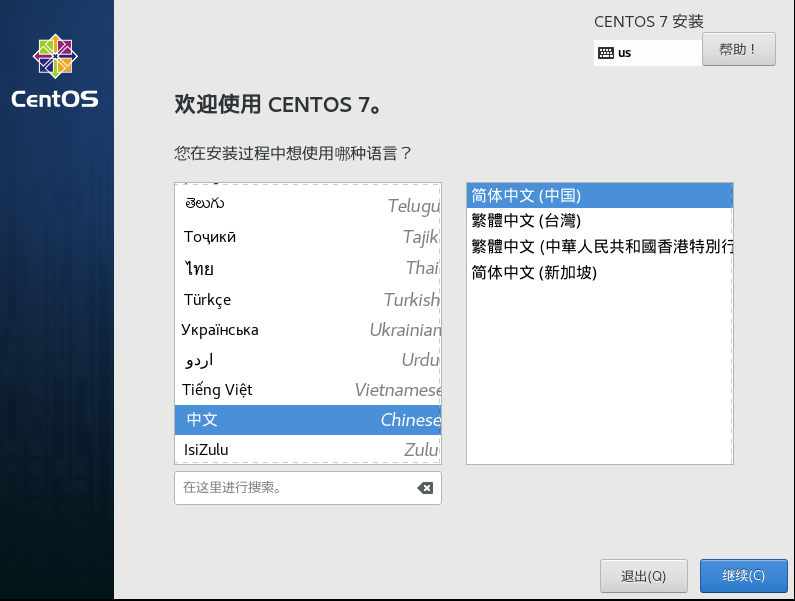

设置语言 在第一步设置完成后,我们一直等待,即可来到语言设置界面

此处我们设置【中文】

设置安装信息 将下面带有【感叹号图标】的内容进行设置,比如时间和键盘,可根据自己的需要进行初始化设置,继续往下看…

设置自动分区感叹号

采取默认设置,点击完成

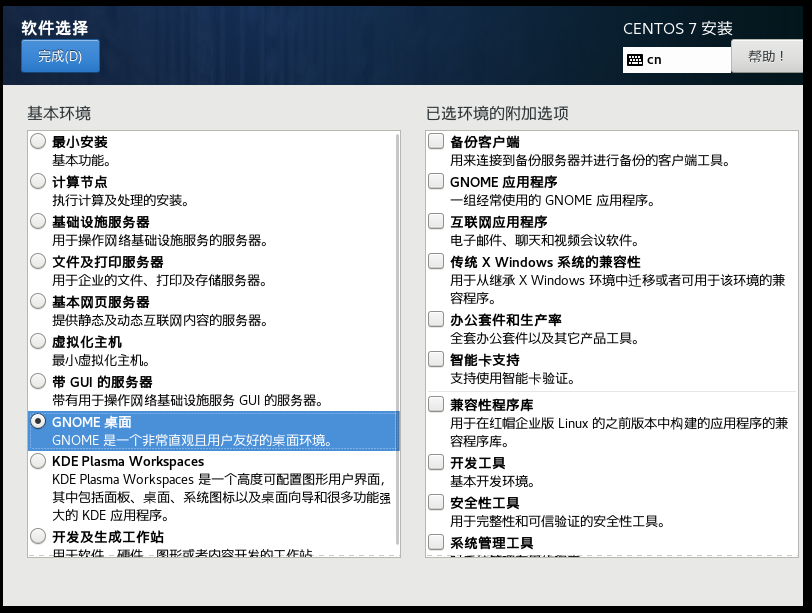

此处我们设置下CentOS的桌面,设置软件安装

在软件选择安装我们的桌面,此处选择GNOME桌面

如果选择centos7 最小安装忘记勾选开发 工具了,可以事后通过yum groupinstall 'Development Tools'安装

最小安装:功能比较少,可能存在问题,不推荐

推荐:基本网页服务器/GNOME桌面

4、点击开始安装

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 此处kdump,开发个人学习没有必要开启,可以关闭节省内存。 如果此处没有操作,可以用命令在安装后关闭 # 关闭kdump服务 systemctl stop kdump.service # 禁止开机启动 systemctl disable kdump.service # 修改grub文件 vim /etc/default/grub 可以看到类似如下的内容,将crashkernel改为0M GRUB_TIMEOUT=2 GRUB_DISTRIBUTOR="$(sed 's, release .*$,,g' /etc/system-release)" GRUB_DEFAULT=saved GRUB_DISABLE_SUBMENU=true GRUB_TERMINAL_OUTPUT="console" +GRUB_CMDLINE_LINUX="crashkernel=0M rhgb net.ifnames=0 biosdevname=0" GRUB_DISABLE_RECOVERY="true" # 重新生成grub配置文件后重启系统生效 grub2-mkconfig -o /boot/grub2/grub.cfg reboot

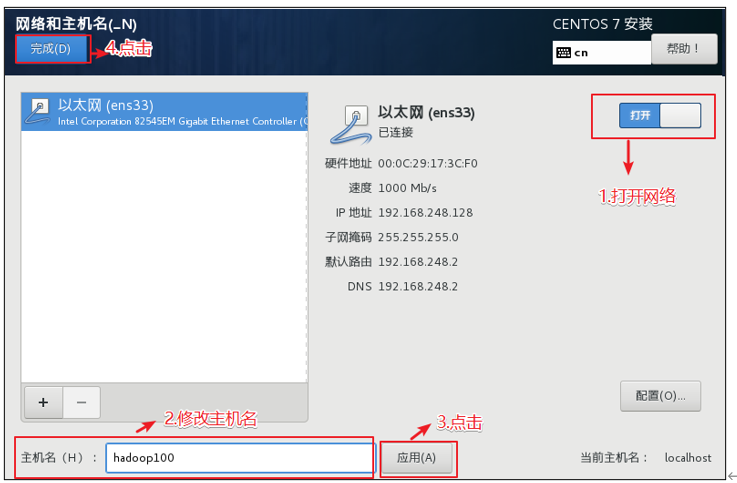

修改主机名

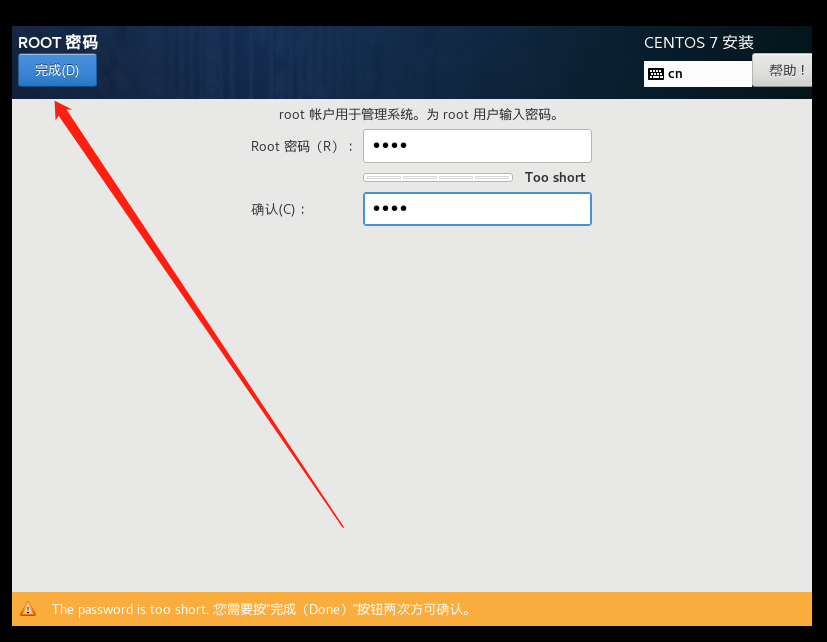

安装时间比较长,大概需要10几分钟(设置root用户密码,一定要设置)

配置用户信息 此处设置root账号密码,我们设置为root,暂时不创建新的用户(进入到欢迎页面的时候会提示我们创建用户)

设置密码root

设置完毕后不在有【感叹号图标】警告提示了

执行重启操作

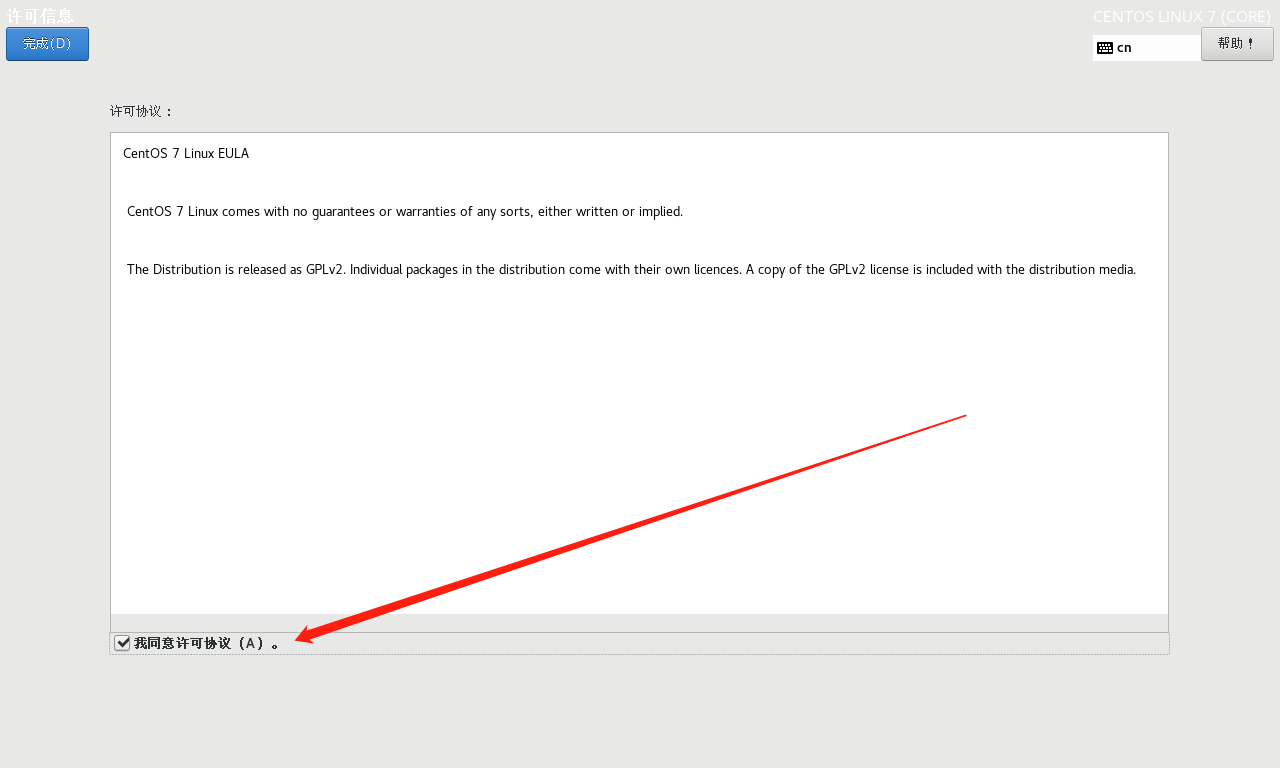

接受许可

在重启过程中,会有【未接受许可证】的警告提示,点击提示信息

设置(打勾)同意许可

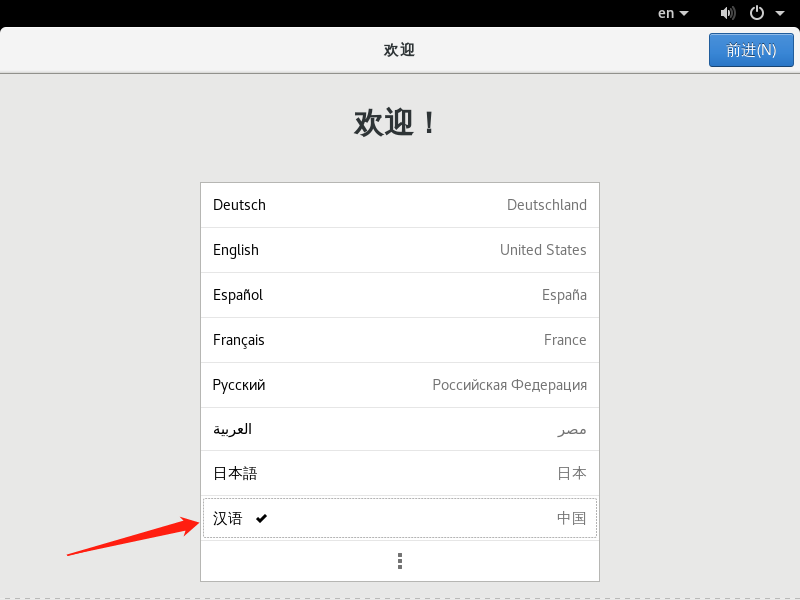

开机进入欢迎页面 此处设置为语言为【汉语】

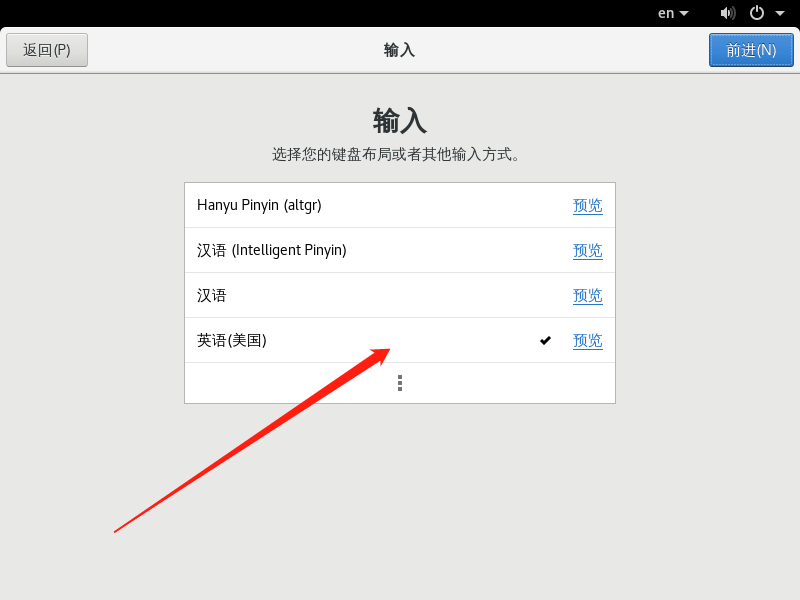

选择键盘输入 键盘输入类型此处我们选择美国

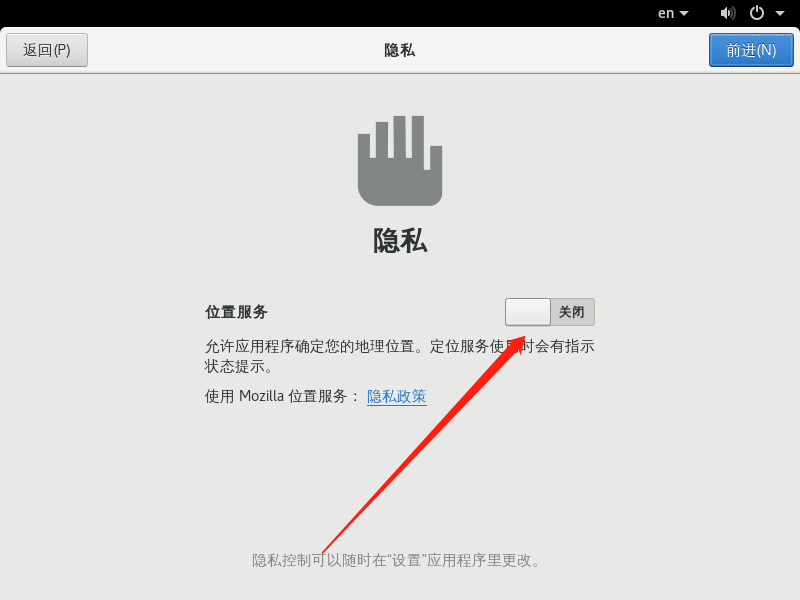

关闭隐私服务

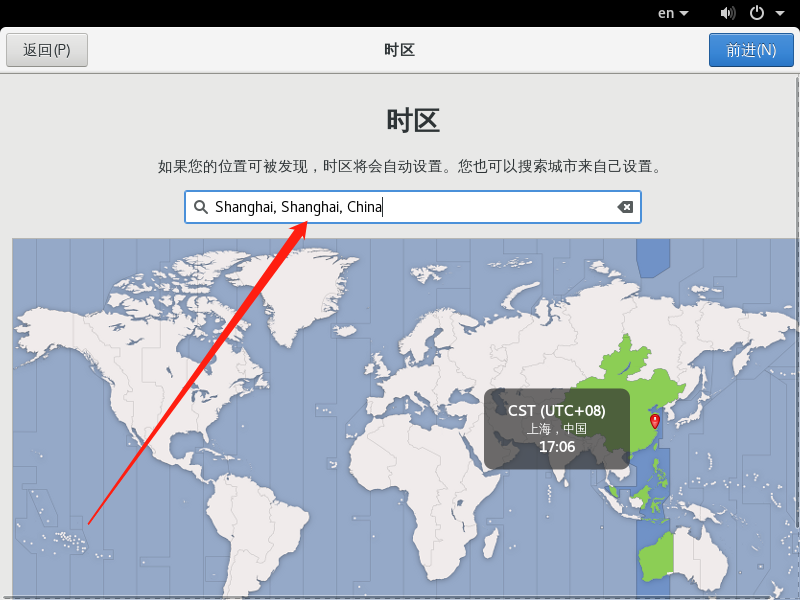

设置国家和地区 我们设置中国上海

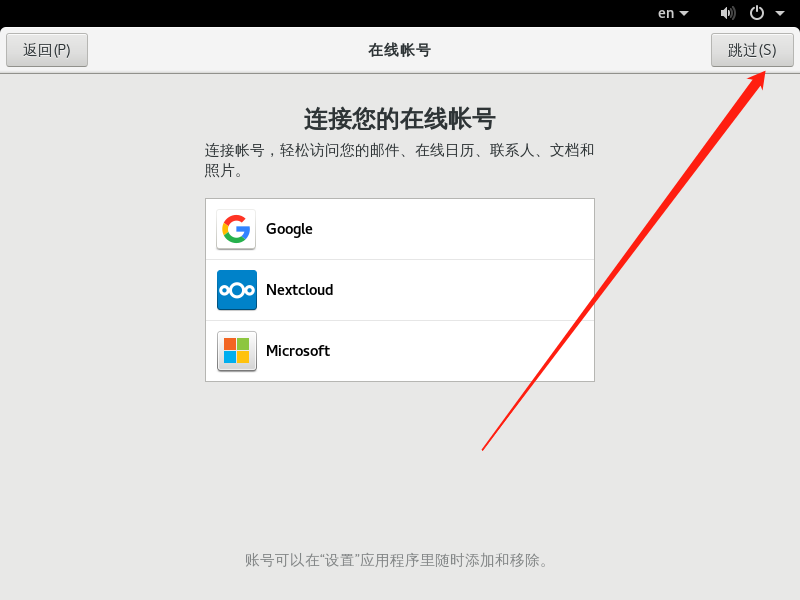

绑定账号 此处我们选择跳过【skip】

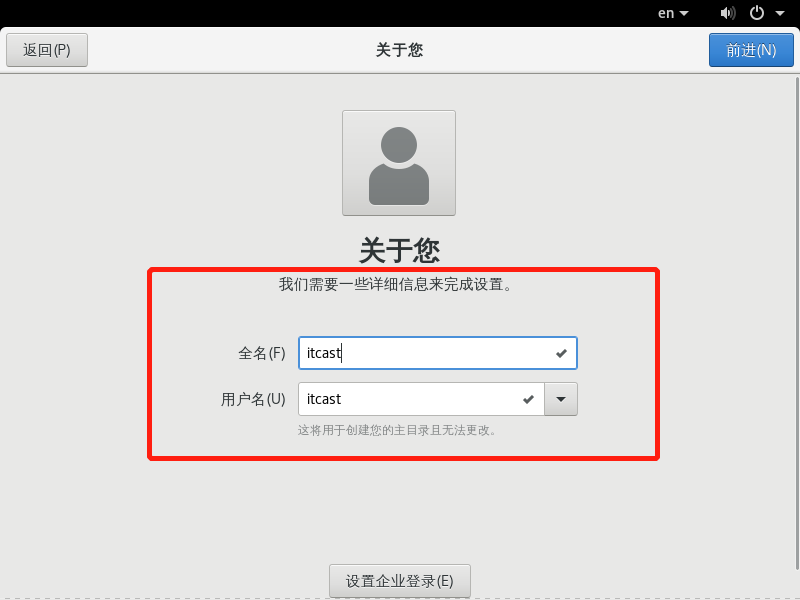

创建用户 我们新建用户zuoer

全名:zueor

用户名

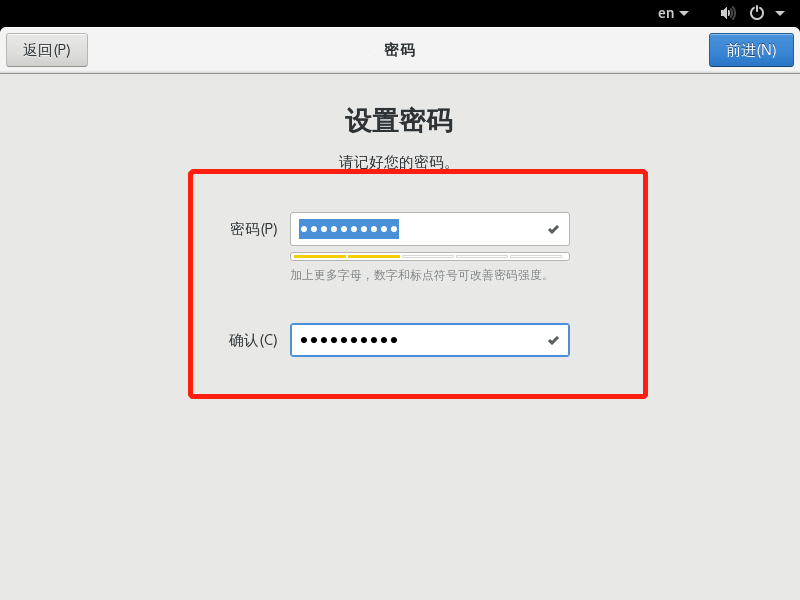

为用户zuoer设置密码zuoer

此处注意密码设置规范:大小写+数字

设置完毕,进入CentOS桌面

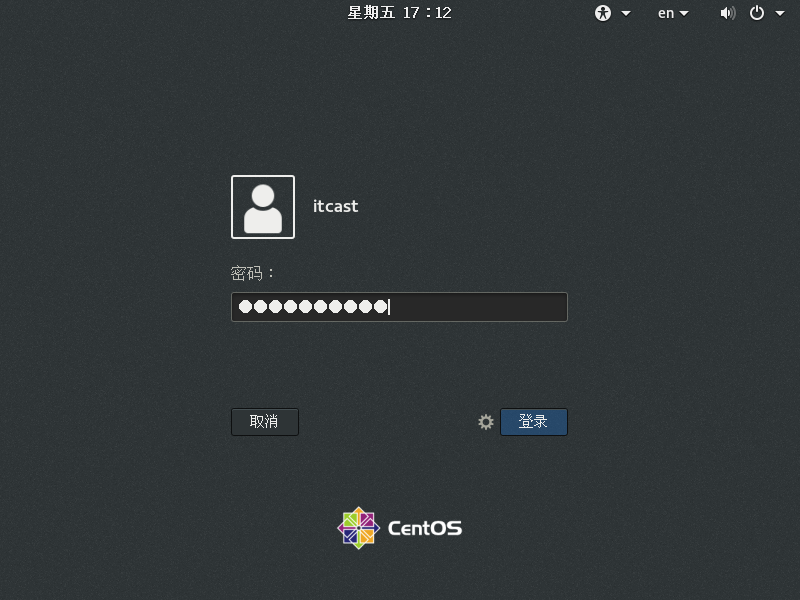

重启,输入用户名、密码就可以登录了(如果要root登陆,点击未列出)

命令行模式和图形化模式 如果想要默认命令行启动:

1 2 3 4 5 6 7 8 9 10 11 -- 查看当前模式 systemctl get-default -- 图形 systemctl set-default graphical.target -- 命令行 systemctl set-default multi-user.target 用ctrl+alt+f2也可以切到命令行界面 用ctrl+alt+f1也可以切到图形化界面

网络配置

静态IP设置 引子

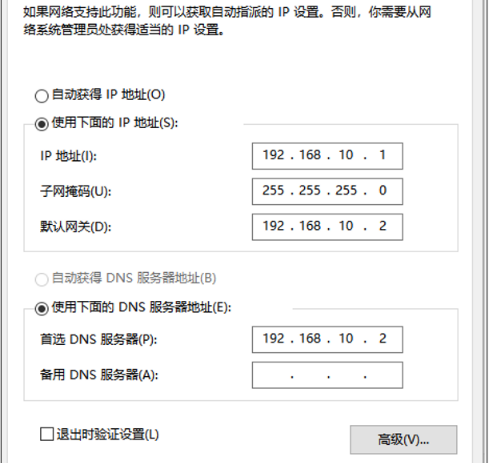

在上面,我们成功的将CentOS镜像安装到了我们的虚拟机上,可是这个时候,虚拟机还没有配置IP信息,为了后面开发方便,我们需要设置一个静态IP

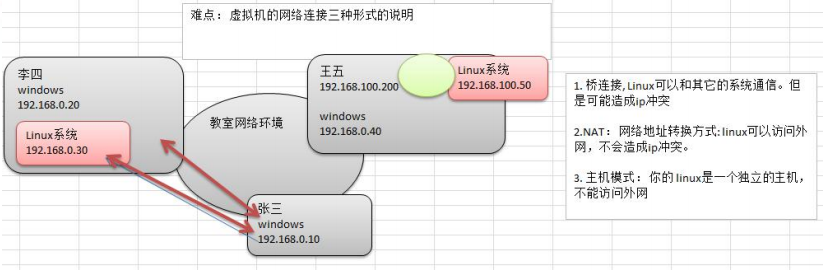

配置网络链接时,有三种形式,需要注意:

1 2 3 4 5 6 桥连: 假如在局域网内,桥连的话,虚拟机的IP和主机的IP在同一个网段,这样,别的系统也可以连通Linux系统.但是有可能造成IP冲突,毕竟,就那么些IP(0~255). 比如李四主机ip,20,虚拟机可能是30,这有可能和张三的ip冲突的。 NAT: 比如王五的IP,40,如果用nat,主机会有2个IP,100.200,这样,Linux使用100.50,不会和0.10和0.20张三李四的冲突。但是这时候,张三找不到100.50的Linux系统.因为不在同一个网段。但是100.50可以找到张三,因为可以通过王五主机0.40代理出去,也可以访问公网。 所以,一般安装NAT模式,即可以访问主机,还可以访问外网

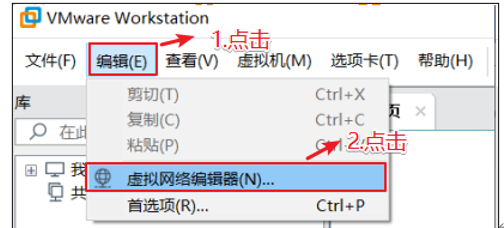

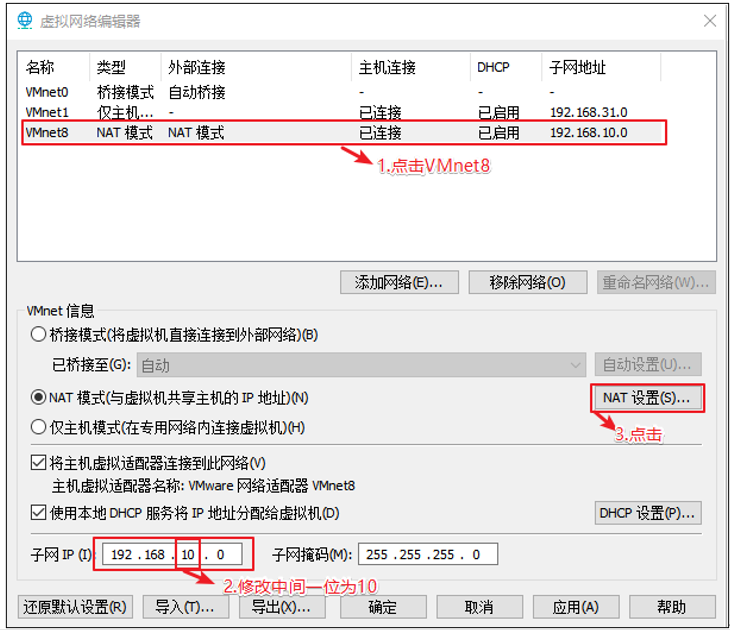

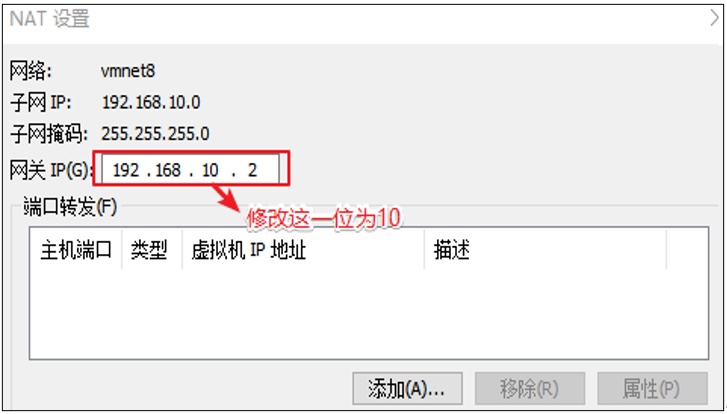

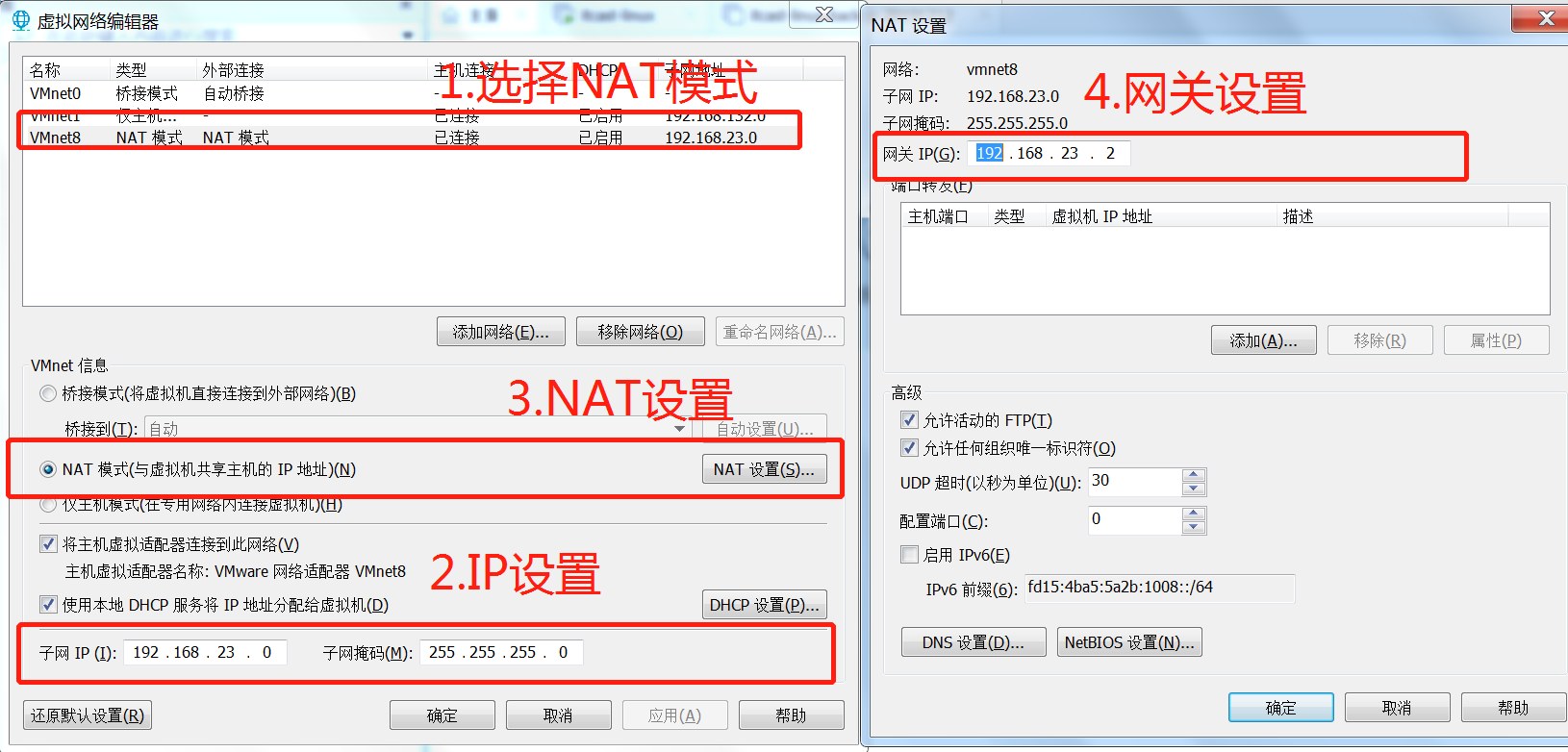

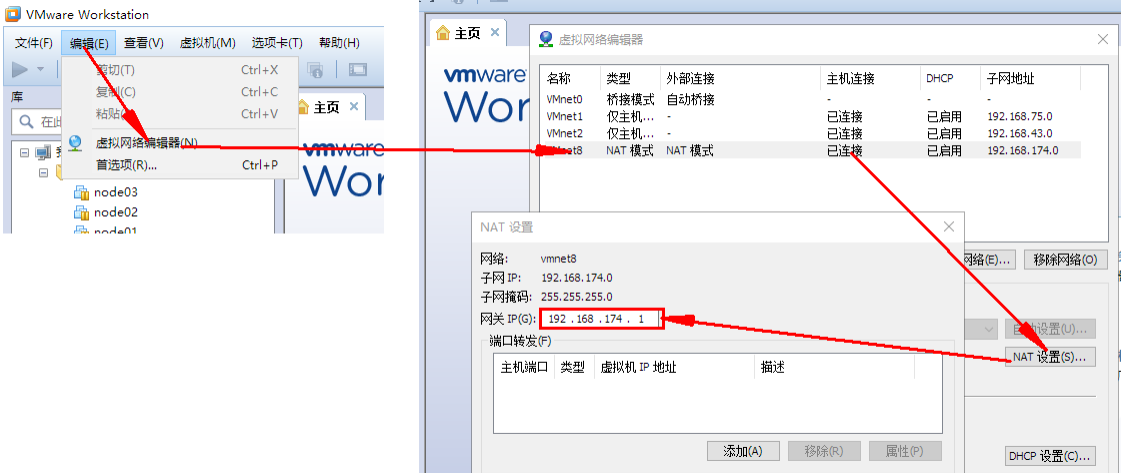

1.NAT模式设置

首先设置虚拟机中NAT模式的选项,打开VMware,点击“编辑”下的“虚拟网络编辑器”,设置NAT参数

注意:

VMware Network Adapter VMnet8保证是启用状态

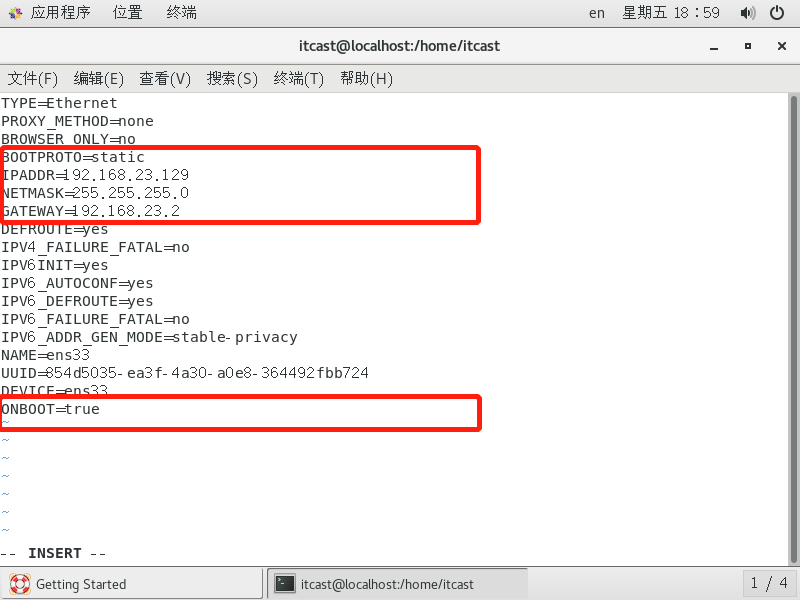

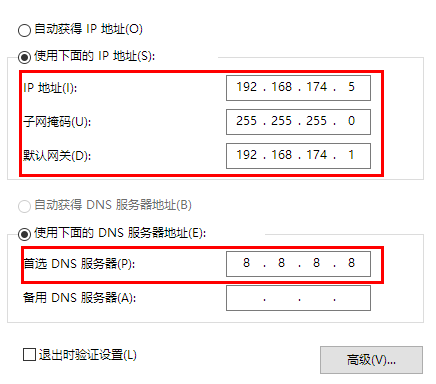

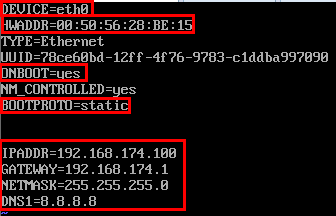

2、设置静态ip

注意:

下面的命令我们先使用,后续我们会慢慢讲解到

在普通用户下不能修改网卡的配置信息;所以我们要切换到root用户进行ip配置

1 2 3 4 5 6 用户名root 密码root # 修改网卡配置文件 su root vi /etc/sysconfig/network-scripts/ifcfg-ens33

静态IP设置内容:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 # 修改文件的内容 TYPE=Ethernet PROXY_METHOD=none BROWSER_ONLY=no BOOTPROTO=static IPADDR=192.168.23.129 NETMASK=255.255.255.0 GATEWAY=192.168.23.2 DEFROUTE=yes IPV4_FAILURE_FATAL=no IPV6INIT=yes IPV6_AUTOCONF=yes IPV6_DEFROUTE=yes IPV6_FAILURE_FATAL=no IPV6_ADDR_GEN_MODE=stable-privacy NAME=ens33 UUID=2c2371f1-ef29-4514-a568-c4904bd11c82 DEVICE=ens33 ONBOOT=true

内容说明:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 BOOTPROTO设置为静态static # 系统启动的地址协议,可选参数static(静态地址),dhcp(DHCP动态地址),none(不指定地址),bootp(BOOTP协议) IPADDR设置ip地址 # IP地址 NETMASK设置子网掩码 # 子网掩码 GATEWAY设置网关 ONBOOT设置为true在系统启动时是否激活网卡 默认是ON,如果ifconfig获取不到ip,改成yes,或True UUID="e83804c1-3257-4584-81bb-660665ac22f6" # 随机MAC id DEVICE="ens33" # 接口名(设备,网卡) HWADDR(mac地址)、UUID(唯一标识): 可以删除,因为如果是克隆的,这个n太虚拟机就一样了。删掉会自动分配。 还可以配置域名解析的地址 DNS1=192.168.23.2 (如果想在虚拟机做静态ip映射的话) DNS2=114.114.114.114 (不配置DNS,可能ping不通百度) # 执行保存 :wq!

重启网络:

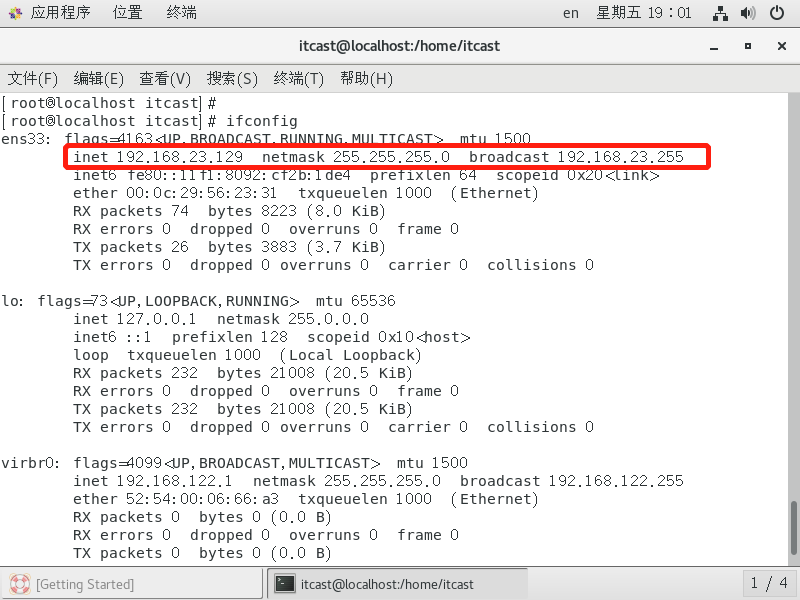

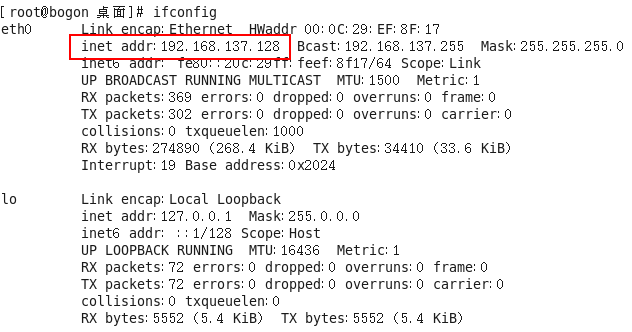

1 2 3 4 5 # 重启网络 systemctl restart network # 查看ip(mini版访问不了,要安装yum install net-tools) ifconfig

如上图所示,我们配置的静态IP起作用了,目前是192.168.23.129

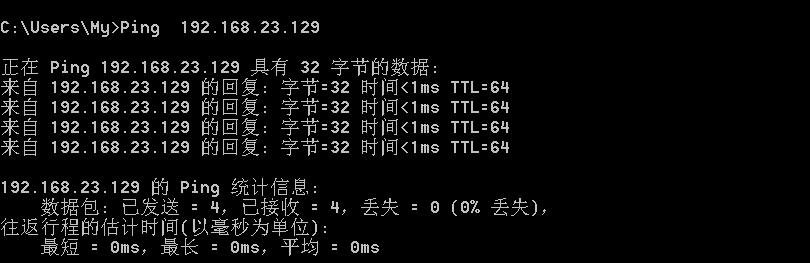

4、宿主机ping虚拟机

由此可见宿主机与虚拟机之间是互通的

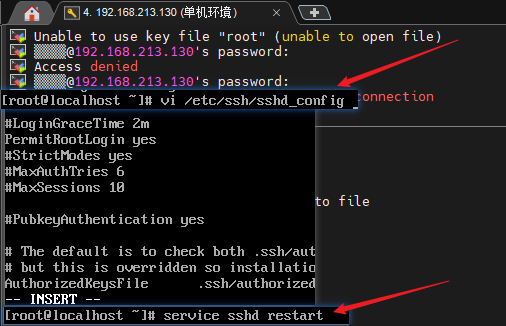

如果ping不同,且xshell连接不上,可以配置sshd

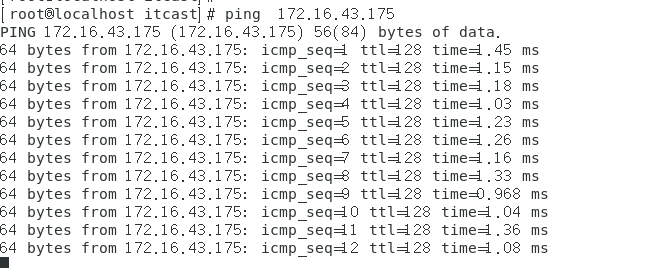

5、虚拟机ping宿主主机

由此可见,虚拟机与宿主机是互通的

如果ping不同百度,可以参考这篇文章 ,看是否是DNS未配置

注意:如果开着vpn时无法ping通,请关掉vpn后重试。

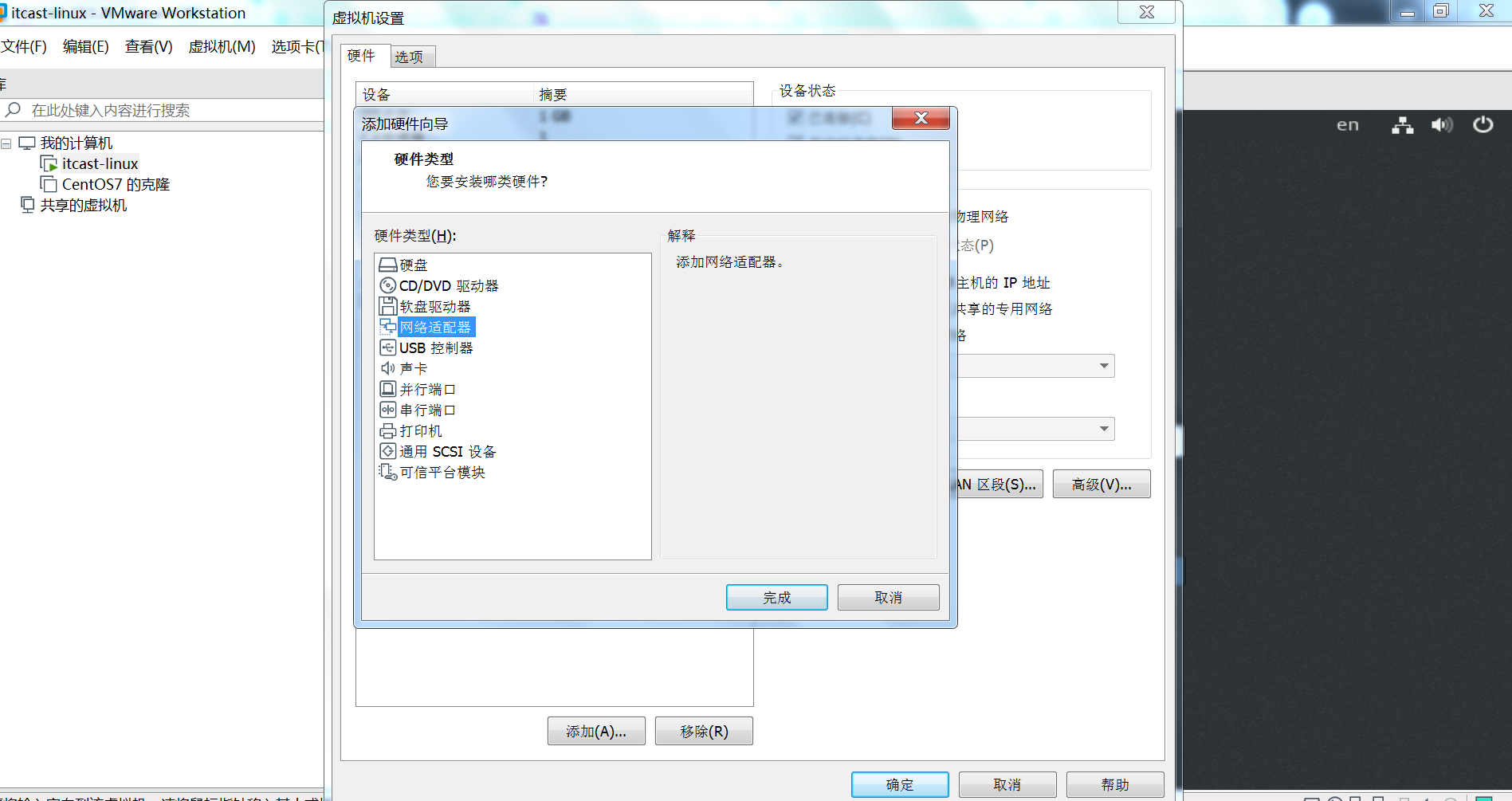

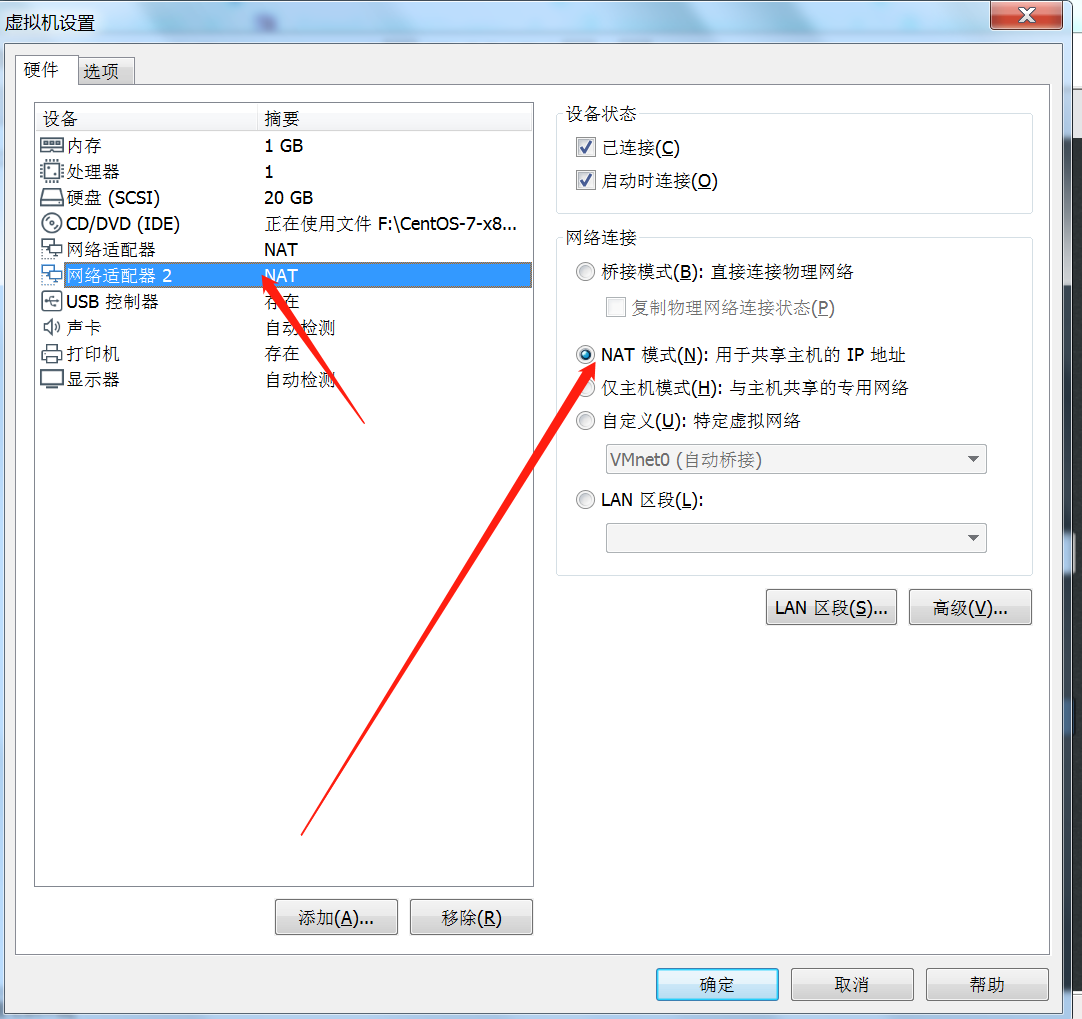

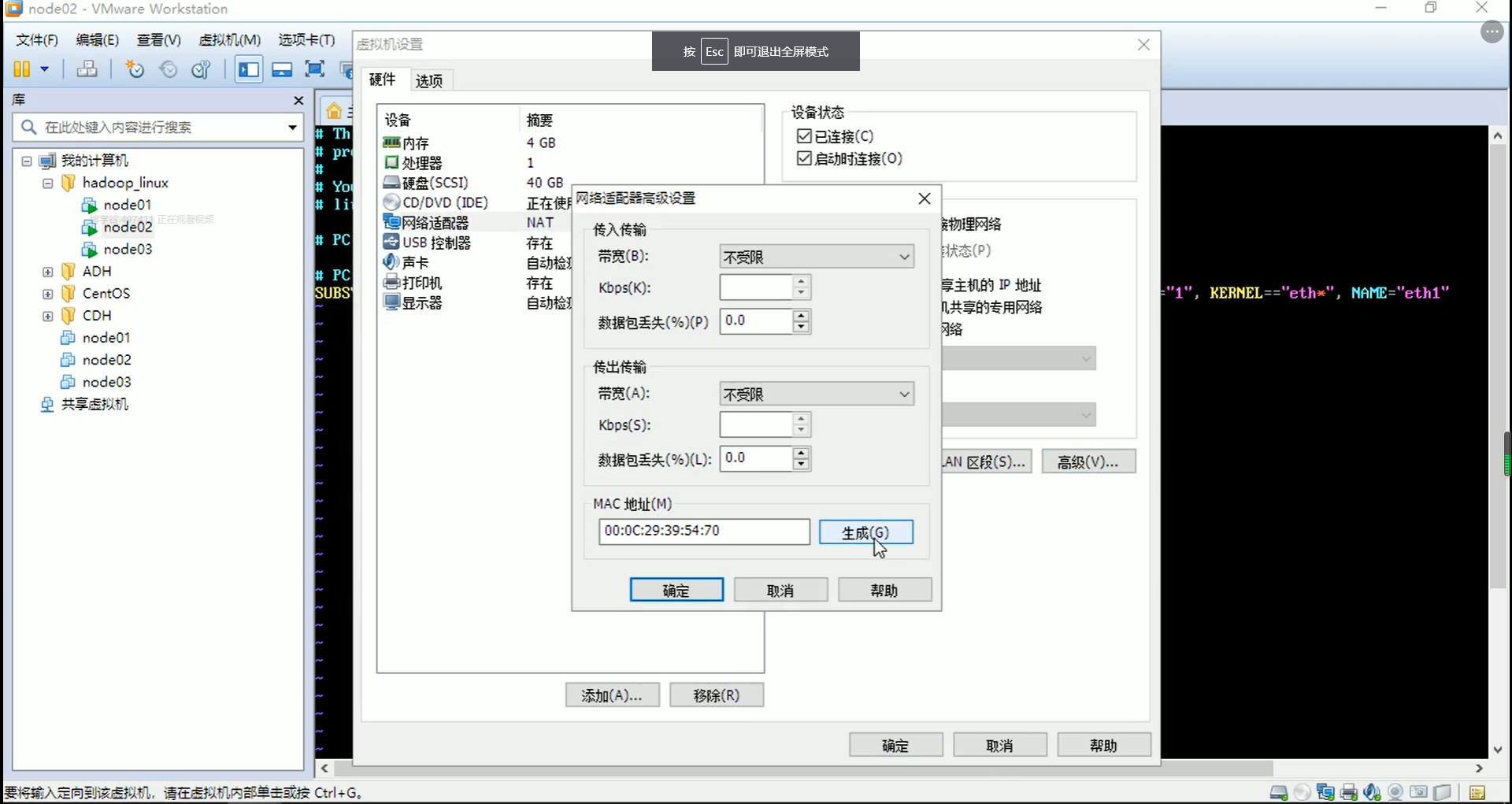

6、如果想在虚拟机中访问网络,增加一块NAT网卡(这步很重要!)

1)【虚拟机】–【设置】–【添加】

设置为NAT模式,如下图

此时,我们通过虚拟机的浏览器访问https://www.baidu.com/

由此可见,我们通过通过NAT模式可以访问外网。

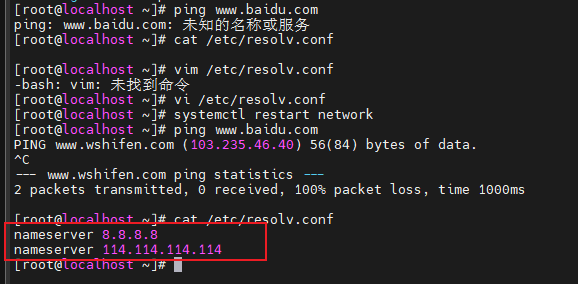

mini版无法访问网络,如果网络按照上面的都配置了,可能是需要在配置一下dns

1 2 3 4 5 6 vim /etc/resolv.conf nameserver 8.8.8.8 # 必要的安装 yum install net-tools yum install vim yum -y install yum-utils

如果DNS修改后会自动还原可以参考文章:https://blog.csdn.net/qq_43445867/article/details/142874167

修改主机名和hosts文件 1)修改主机名称

1 2 [root@hadoop100 ~]# vim /etc/hostname hadoop100

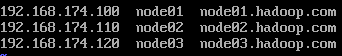

2)配置Linux克隆机主机名称映射hosts文件,打开/etc/hosts

1 2 3 4 5 6 7 8 9 10 11 [root@hadoop100 ~]# vim /etc/hosts 添加如下内容 192.168.199.130 hadoop01 192.168.199.131 hadoop02 192.168.199.132 hadoop03 192.168.199.133 hadoop04 192.168.199.134 hadoop05 192.168.199.135 hadoop06 192.168.199.136 hadoop07 192.168.199.137 hadoop08 192.168.199.138 hadoop09

3)重启克隆机hadoop102

1 [root@hadoop100 ~]# reboot

4)修改windows的主机映射文件(hosts文件)C:\Windows\System32\drivers\etc

1 2 3 4 5 6 7 8 9 192.168.10.100 hadoop100 192.168.10.101 hadoop101 192.168.10.102 hadoop102 192.168.10.103 hadoop103 192.168.10.104 hadoop104 192.168.10.105 hadoop105 192.168.10.106 hadoop106 192.168.10.107 hadoop107 192.168.10.108 hadoop108

配置yum的源

可以不用做,会根据你的IP选则最近的节点下载(如果yum update没有网络,可以替换国内源)

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 yum -y install wget # 备份CentOS-Base.repo mv /etc/yum.repos.d/CentOS-Base.repo /etc/yum.repos.d/CentOS-Base.repo.bak wget -O /etc/yum.repos.d/CentOS-Base.repo http://mirrors.aliyun.com/repo/Centos-7.repo wget -P /etc/yum.repos.d/ http://mirrors.aliyun.com/repo/epel-7.repo yum clean all yum makecache 如果有报错:yum Could not resolve host: mirrors.cloud.aliyuncs.com; Unknown error 解决: 进入 cd /etc/yum.repos.d/ 该目录下 修改文件 CentOS-Base.repo 和 epel.repo 中所有 http://mirrors.cloud.aliyuncs.com 为 http://mirrors.aliyun.com/centos 最后运行 yum -y update 即可

其他操作-为了基础客隆准备 windows

1 2 3 4 5 6 7 8 9 10 11 # /etc/hosts添加 192.168.199.130 hadoop00 192.168.199.131 hadoop01 192.168.199.132 hadoop02 192.168.199.133 hadoop03 192.168.199.134 hadoop04 192.168.199.135 hadoop05 192.168.199.136 hadoop06 192.168.199.137 hadoop07 192.168.199.138 hadoop08 192.168.199.139 hadoop09

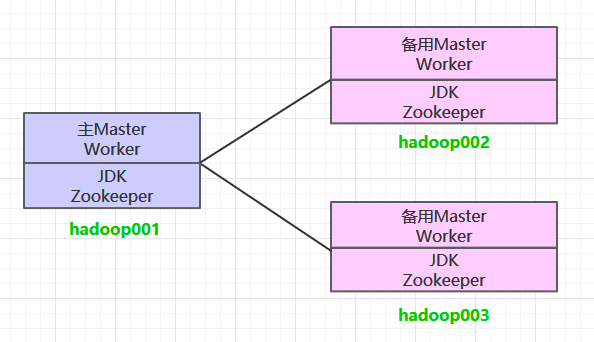

规划

hadoop00

192.168.199.130

基础模板机器,专门用来克隆的

hadoop01

192.168.199.131

单机伪分布

hadoop02

192.168.199.132

分布式

hadoop03

192.168.199.133

分布式

hadoop04

192.168.199.134

分布式

关闭防火墙,关闭防火墙开机自启

1 2 3 [root@hadoop100 ~]# systemctl stop firewalld [root@hadoop100 ~]# systemctl disable firewalld.service 注意:在企业开发时,通常单个服务器的防火墙时关闭的。公司整体对外会设置非常安全的防火墙

配置zuoer用户具有root权限,方便后期加sudo执行root权限的命令

信息

1 2 |- root用户:root/root |- 普通用户:zuoer/zuoer

1 2 3 4 5 6 7 8 9 10 11 12 13 [root@hadoop100 ~]# vim /etc/sudoers 修改/etc/sudoers文件,在%wheel这行下面添加一行,如下所示 root ALL=(ALL) ALL ## Allows members of the 'sys' group to run networking, software, ## service management apps and more. # %sys ALL = NETWORKING, SOFTWARE, SERVICES, STORAGE, DELEGATING, PROCESSES, LOCATE, DRIVERS ## Allows people in group wheel to run all commands %wheel ALL=(ALL) ALL +zuoer ALL=(ALL) NOPASSWD:ALL 注意:zuoer 这一行不要直接放到root行下面,因为所有用户都属于wheel组,你先配置了 zuoer 具有免密功能,但是程序执行到%wheel行时,该功能又被覆盖回需要密码。所以 zuoer 要放到%wheel这行下面。

目录规范建设

这里时用普通用户创建的,也可以直接用root用户操作

在/opt目录下创建文件夹,并修改所属主和所属组

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 在/opt目录下创建文件夹,并修改所属主和所属组 软件安装包目录:/opt/install 软件安装目录:/opt/apps 软件数据存放目录:/opt/data (1)在/opt目录下创建module、software文件夹 [root@hadoop100 ~]# mkdir /opt/apps [root@hadoop100 ~]# mkdir /opt/install [root@hadoop100 ~]# mkdir /opt/data (2)修改module、software文件夹的所有者和所属组均为 zuoer 用户 [root@hadoop100 ~]# chown zuoer:zuoer /opt/apps [root@hadoop100 ~]# chown zuoer:zuoer /opt/install [root@hadoop100 ~]# chown zuoer:zuoer /opt/data (3)查看module、software文件夹的所有者和所属组 [root@hadoop100 ~]# cd /opt/ [root@hadoop100 opt]# ll 总用量 12 drwxr-xr-x. 2 zuoer zuoer 4096 5月 28 17:18 apps

卸载虚拟机自带的JDK

注意:如果你的虚拟机是最小化安装不需要执行这一步。

1 [root@hadoop100 ~]# rpm -qa | grep -i java | xargs -n1 rpm -e --nodeps

重启虚拟

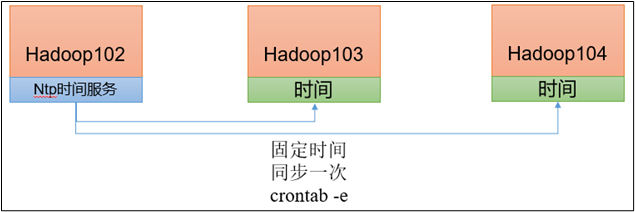

时间同步

如果服务器在公网环境(能连接外网),可以不采用集群时间同步,因为服务器会定期和公网时间进行校准;

如果服务器在内网环境,必须要配置集群时间同步,否则时间久了,会产生时间偏差,导致集群执行任务时间不同步。

1)需求

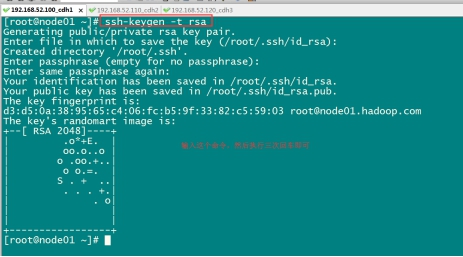

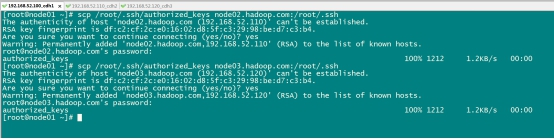

2)时间服务器配置(必须root用户)

1 2 3 4 5 6 7 (1)查看所有节点ntpd服务状态和开机自启动状态 [zuoer@hadoop02 ~]$ sudo systemctl status ntpd [zuoer@hadoop02 ~]$ sudo systemctl start ntpd [zuoer@hadoop02 ~]$ sudo systemctl is-enabled ntpd (2)修改hadoop102的ntp.conf配置文件 [zuoer@hadoop02 ~]$ sudo vim /etc/ntp.conf

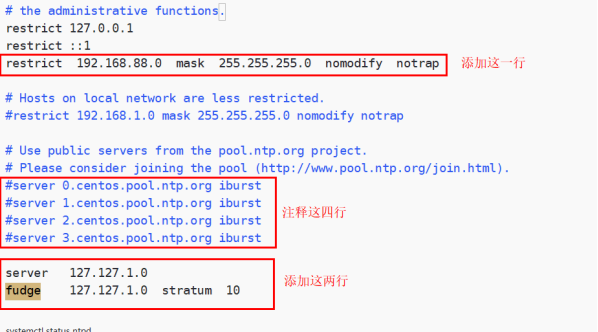

修改内容如下

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 (a)修改1(授权192.168.199.0-192.168.199.255网段上的所有机器可以从这台机器上查询和同步时间) # restrict 192.168.199.0 mask 255.255.255.0 nomodify notrap 为restrict 192.168.199.0 mask 255.255.255.0 nomodify notrap (b)修改2(集群在局域网中,不使用其他互联网上的时间) server 0.centos.pool.ntp.org iburst server 1.centos.pool.ntp.org iburst server 2.centos.pool.ntp.org iburst server 3.centos.pool.ntp.org iburst 为 # server 0.centos.pool.ntp.org iburst # server 1.centos.pool.ntp.org iburst # server 2.centos.pool.ntp.org iburst # server 3.centos.pool.ntp.org iburst (c)添加3(当该节点丢失网络连接,依然可以采用本地时间作为时间服务器为集群中的其他节点提供时间同步) server 127.127.1.0 fudge 127.127.1.0 stratum 10 (3)修改hadoop02的/etc/sysconfig/ntpd 文件 [zuoer@hadoop02 ~]$ sudo vim /etc/sysconfig/ntpd 增加内容如下(让硬件时间与系统时间一起同步) SYNC_HWCLOCK=yes (4)重新启动ntpd服务 [zuoer@hadoop02 ~]$ sudo systemctl start ntpd (5)设置ntpd服务开机启动 [zuoer@hadoop02 ~]$ sudo systemctl enable ntpd

3)其他机器配置(必须root用户)

1 2 3 4 5 6 7 8 9 10 11 12 13 (1)关闭所有节点上ntp服务和自启动 [zuoer@hadoop03 ~]$ sudo systemctl stop ntpd [zuoer@hadoop03 ~]$ sudo systemctl disable ntpd [zuoer@hadoop04 ~]$ sudo systemctl stop ntpd [zuoer@hadoop04 ~]$ sudo systemctl disable ntpd (2)在其他机器配置1分钟与时间服务器同步一次 [zuoer@hadoop03 ~]$ sudo crontab -e 编写定时任务如下: */1 * * * * /usr/sbin/ntpdate hadoop102 (3)修改任意机器时间 [zuoer@hadoop03 ~]$ sudo date -s "2021-9-11 11:11:11" (4)1分钟后查看机器是否与时间服务器同步 [zuoer@hadoop03 ~]$ sudo date

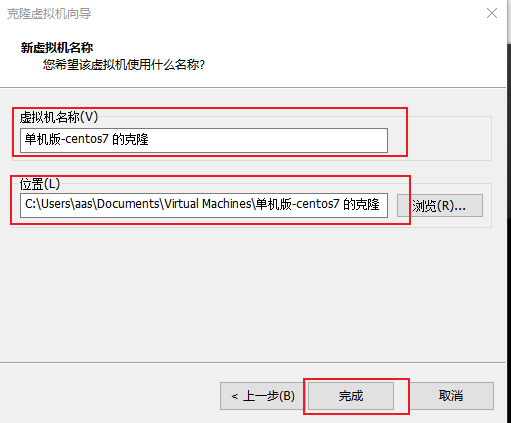

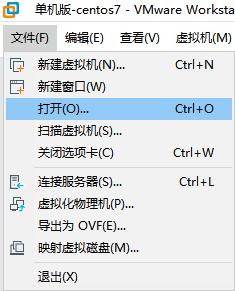

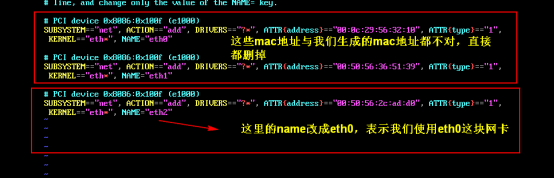

虚拟机克隆

虚拟机先处于关闭状态,如果是基于上面的基础搭建的机器克隆的,需要再修改ip,主机名

万一把源系统玩坏了。可以恢复

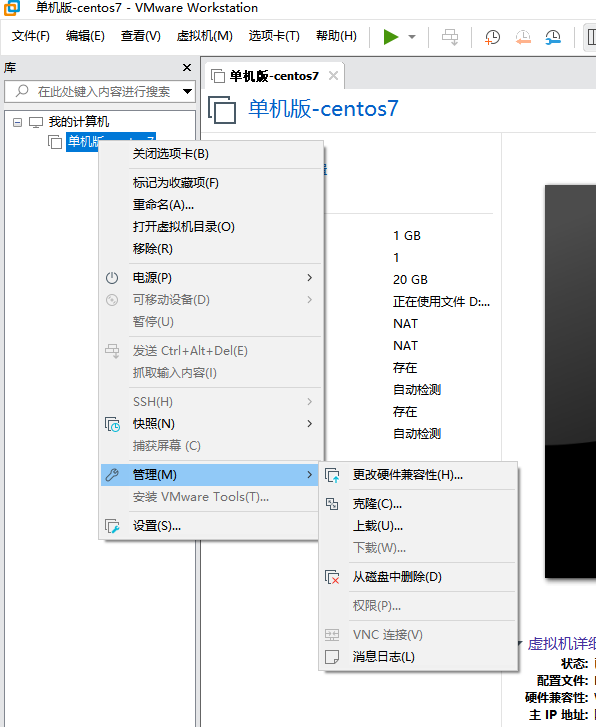

1 右键虚拟机->管理->点击克隆

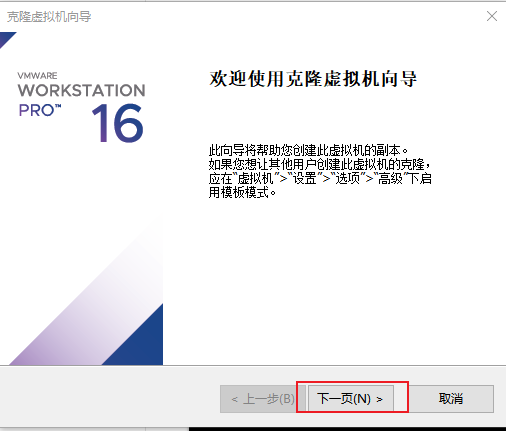

2 点击下一页

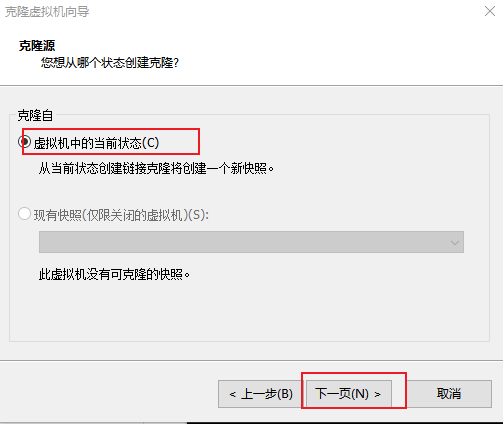

3 从当前虚拟机状态克隆,单击下一页

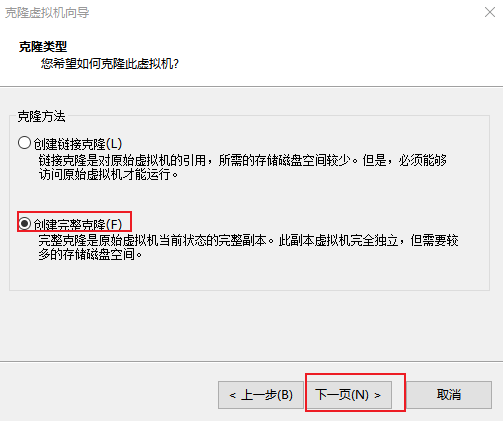

4 创建完整克隆,点击下一步

5 保存克隆

6 加载虚拟机克隆的vmx文件,打开即可

克隆后如果是静态ip记得修改

1 2 3 4 5 6 7 [root@hadoop100 ~]# vim /etc/sysconfig/network-scripts/ifcfg-ens33 改成 BOOTPROTO="static" IPADDR=192.168.199.130 NETMASK=255.255.255.0 GATEWAY=192.168.199.2 DNS1=192.168.199.2

克隆后主机名记得改

1 2 vim /etc/hostname vim /etc/hosts

保证Linux系统ifcfg-ens33文件中IP地址、虚拟网络编辑器地址和Windows系统VM8网络IP地址相同。

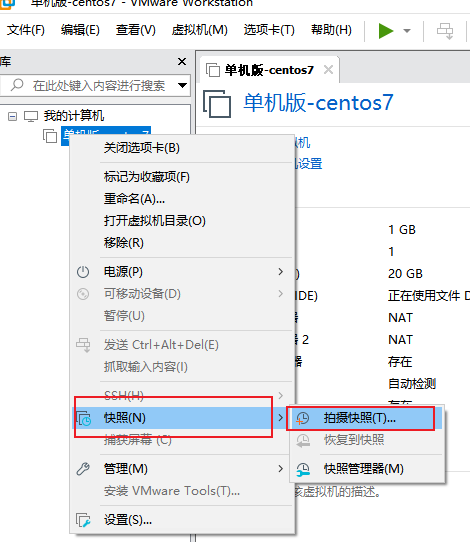

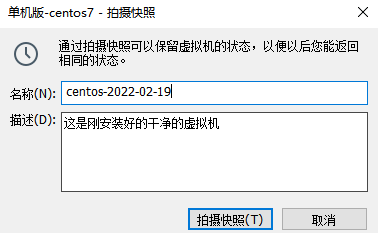

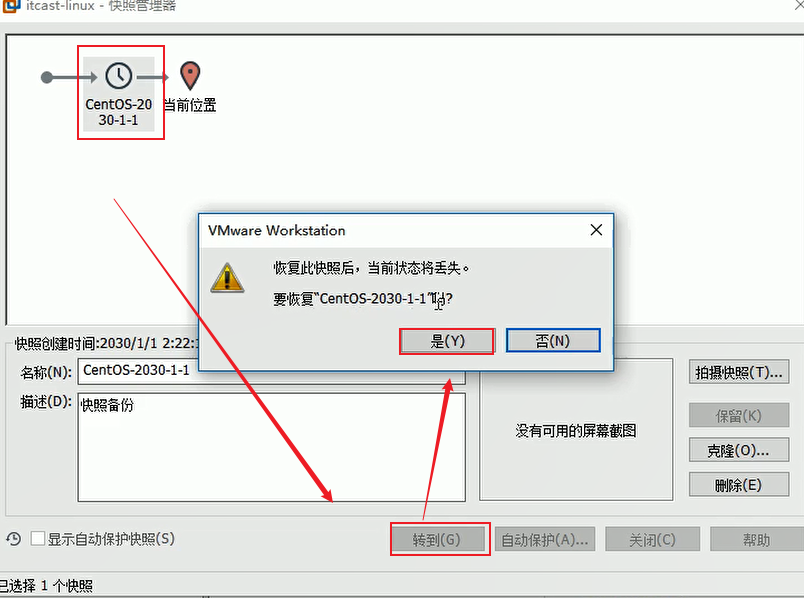

虚拟机快照和还原 把系统当前的状态保留了,不是拷贝完整的系统。占用空间比较小。

如果源系统删除了,快照也就没了。

如果要恢复快照,使用快照管理器

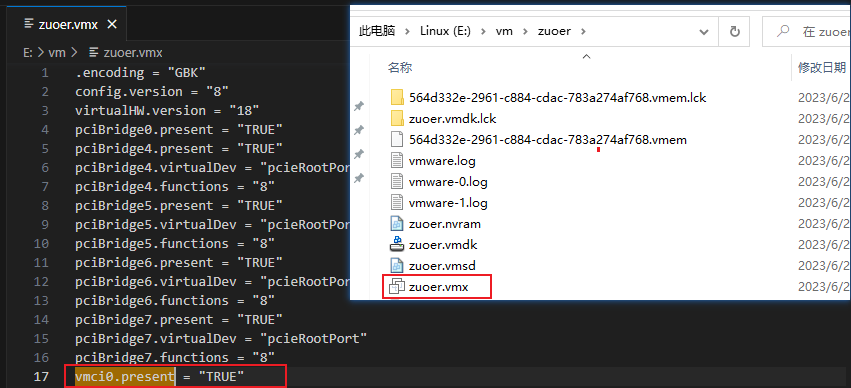

VM虚拟机强制关闭后无法开启 解决办法:

找到虚拟机系统文件目录

1.以记事本方式打开*.VMX文件把“vmci0.present = “TRUE””中的“TRUE”改为“FALSE”

2.以记事本方式打开*.VMX文件上加上一行代码disk.locking = “FALSE”

3.删除以.lck为后缀名的文件。

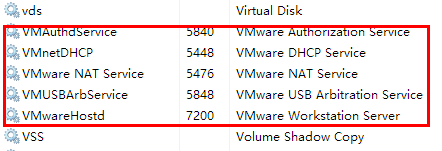

4.win+R 输入services.msc,手动查看并关闭五个VM服务,重启计算机。

计算机开启后,确保五个服务重新打开,点击虚拟机,可以成功开启。

实操-Centos-mini

最小化安装需要额外做一些步骤

初始化mini基础环境

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 yum update # 没有wget命令 yum -y install wget # 没有vim命令 yum -y install vim # 没有ifconfig命令 yum install net-tools # 创建应用安装目录 cd /usr/local mkdir apps cd apps # 关闭防火墙 查看防火墙状态 firewall-cmd --state 关闭防火墙 systemctl stop firewalld.service 开启防火墙 systemctl start firewalld.service 禁止开机启动启动防火墙 systemctl disable firewalld.service

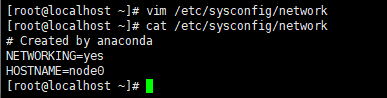

修改localhost主机名

你可能会发现centos7这样改无效,可以尝试通过

1 2 3 hostnamectl set-hostname node0 ,来修改hostname 查看: hostname

重连ssh可以看到生效了。

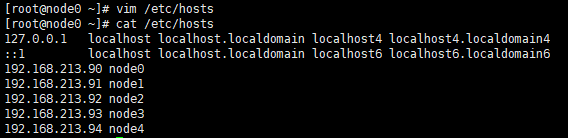

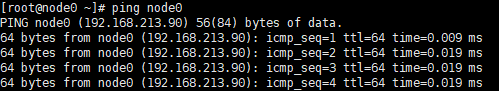

设置本地hosts解析,(为hadoop其他节点访问便利)

这样ping node0就可以访问到ip

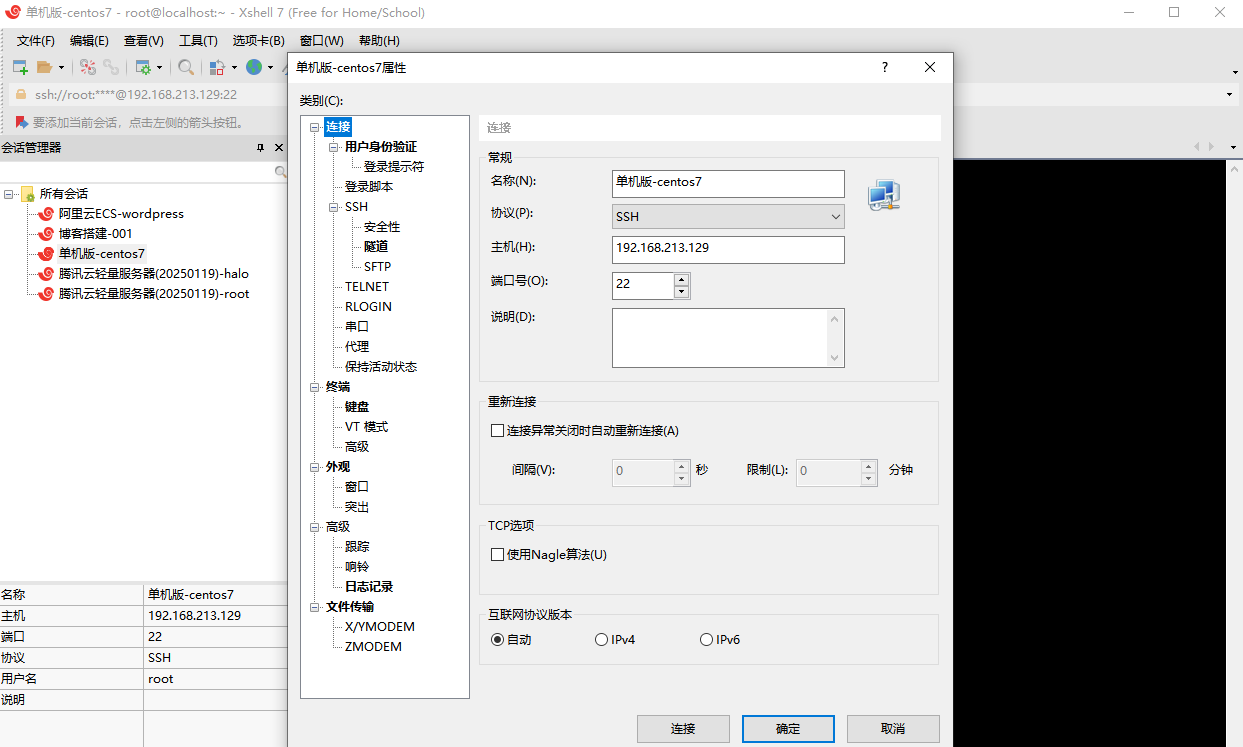

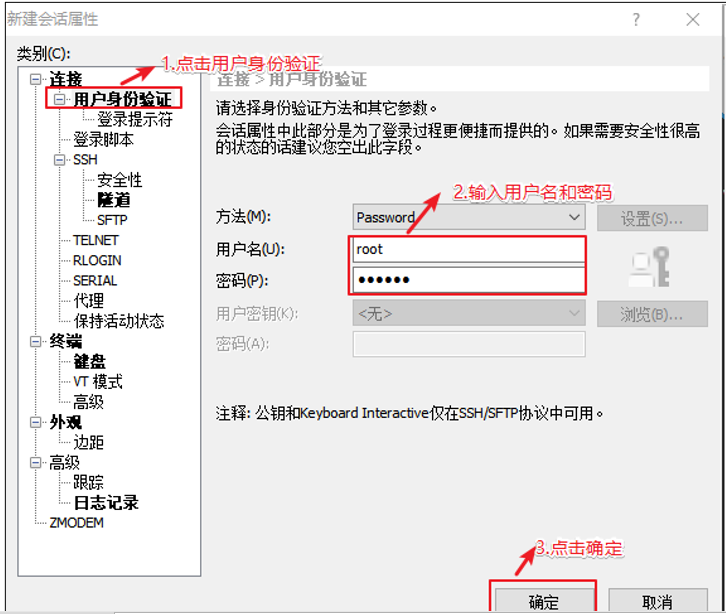

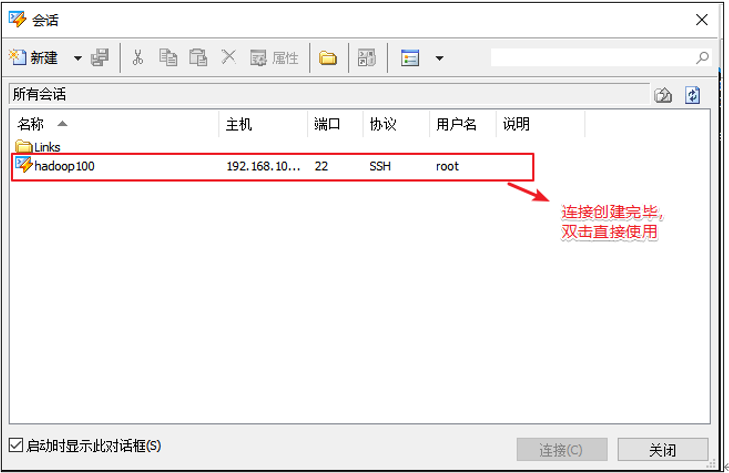

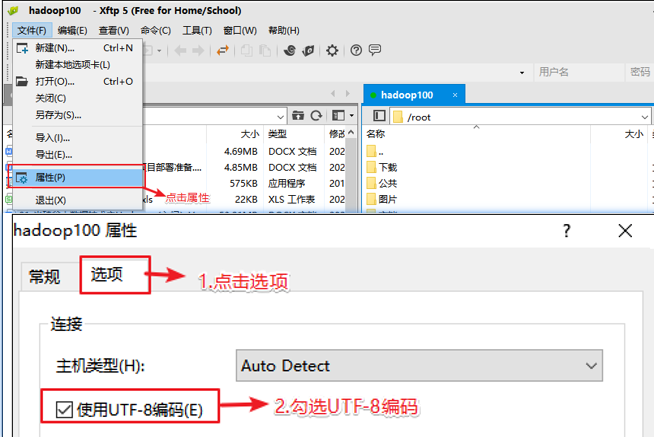

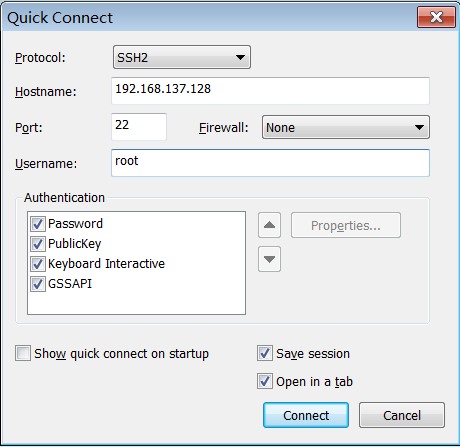

实操-Linux客户端工具Xshell 到官网下载个人版,可以免费使用

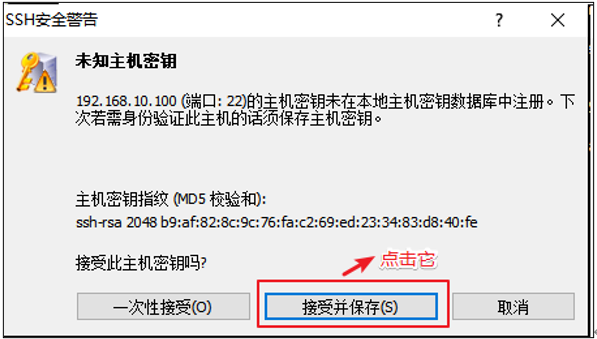

然后连接到创建的虚拟机

连接成功

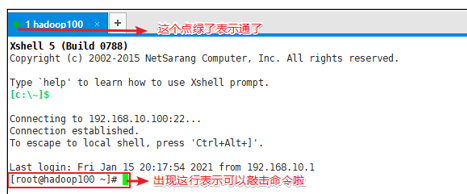

技巧:设置右键粘贴

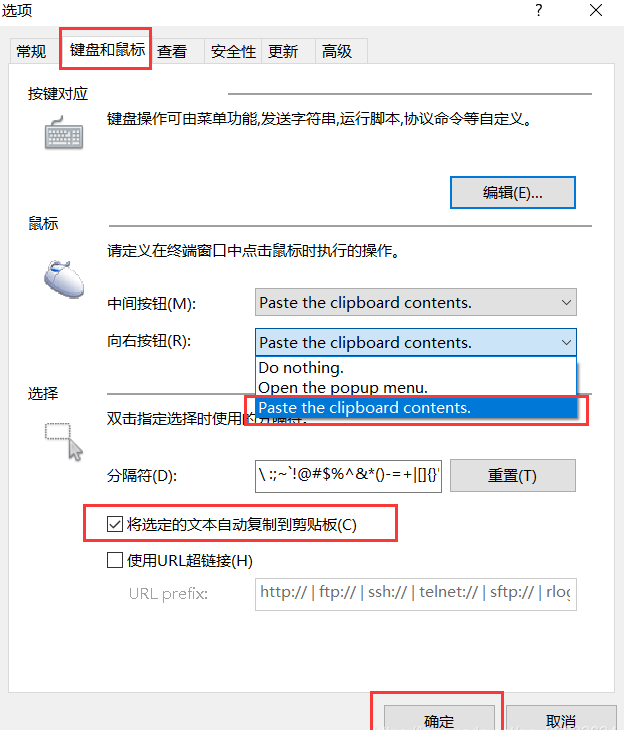

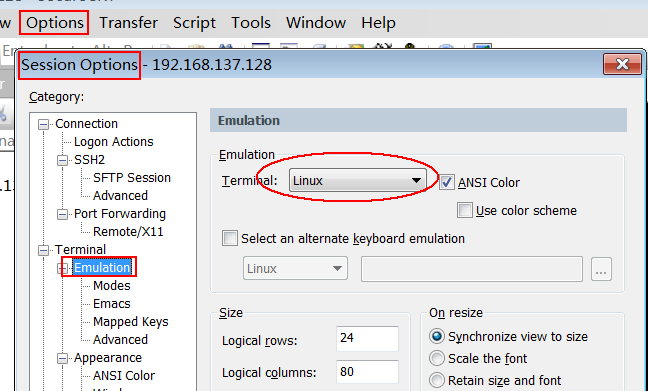

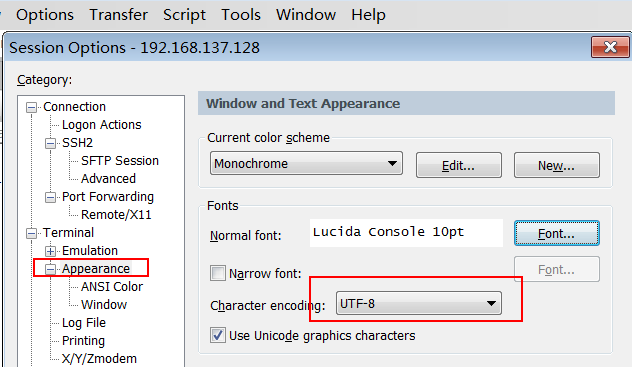

乱码处理

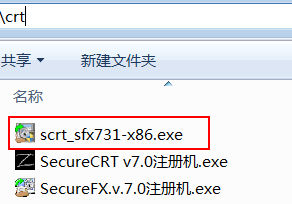

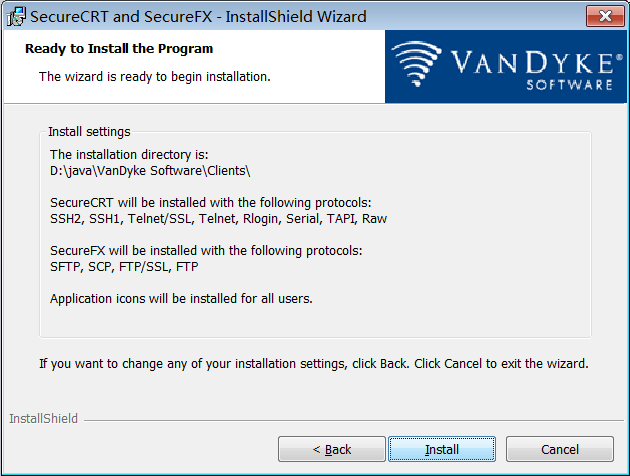

实操-Linux客户端工具SecureCRT CRT安装 步骤 1:安装scrt_sfx731-x86.exe

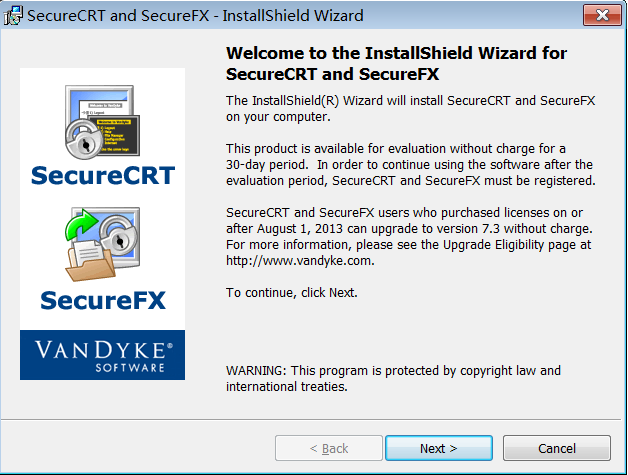

步骤 2:欢迎页面

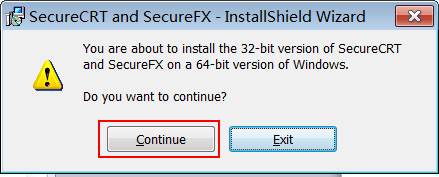

步骤 3:如果是 64 位操作系统,存在此提示

步骤 4:同意许可

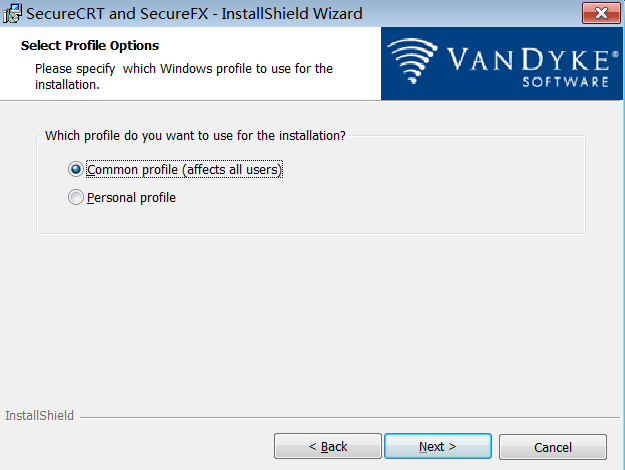

步骤 5:选择配置文件是否共享(默认)

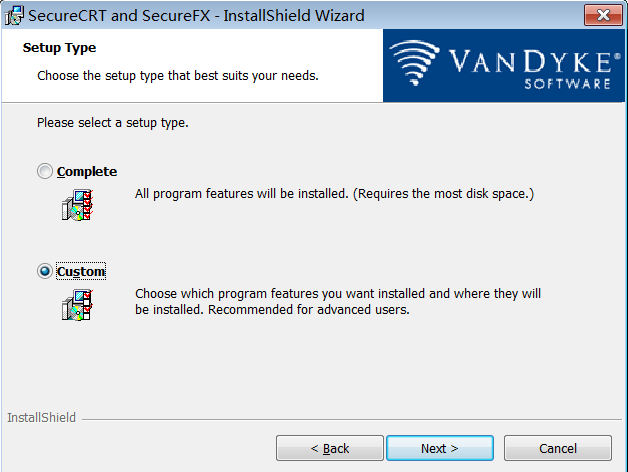

步骤 6:安装类型,自定义

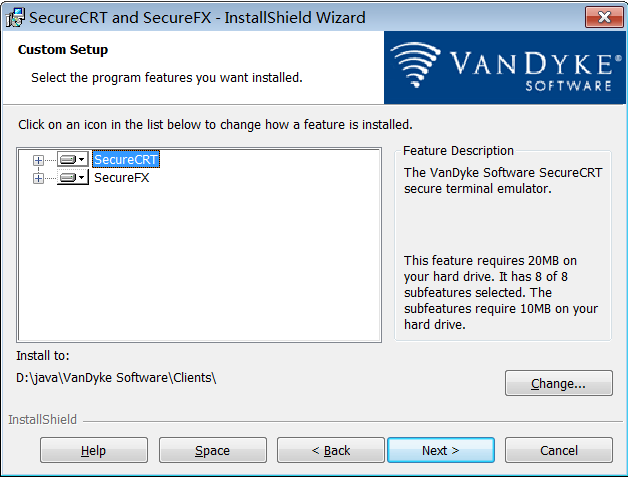

步骤 7:选择安装路径

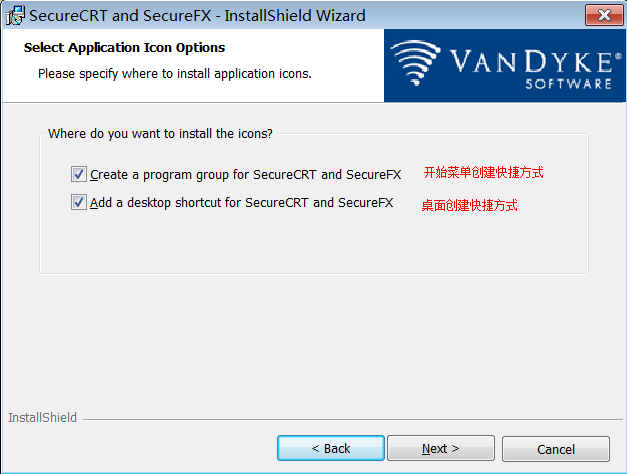

步骤 8:快捷方式(默认)

步骤 9:开始安装

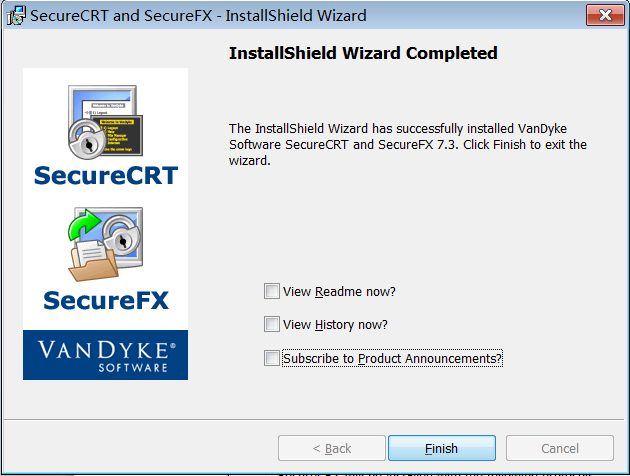

步骤 10:完成

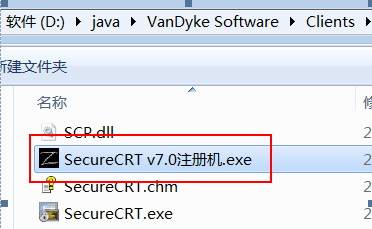

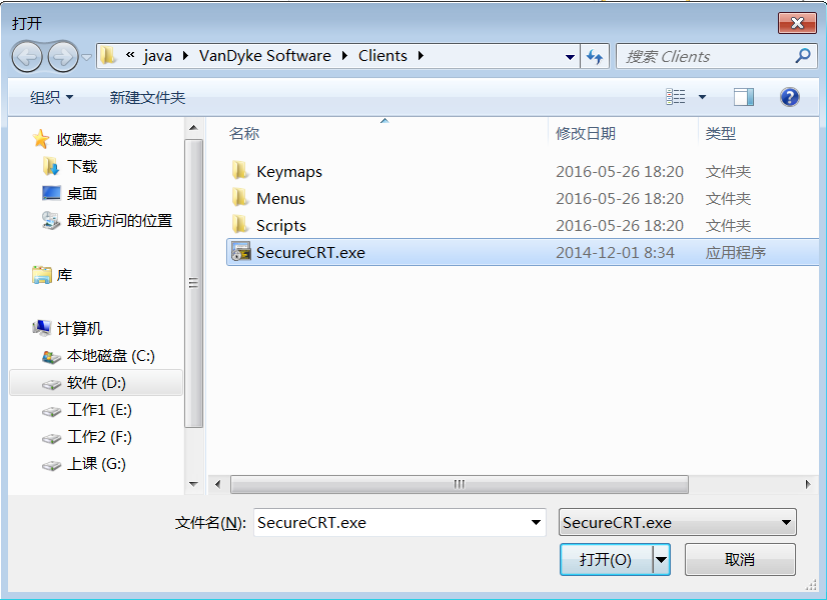

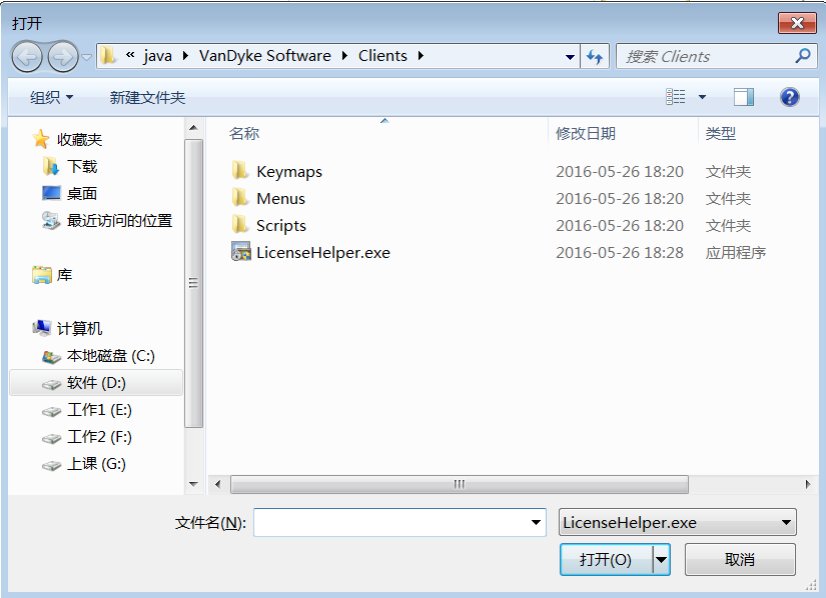

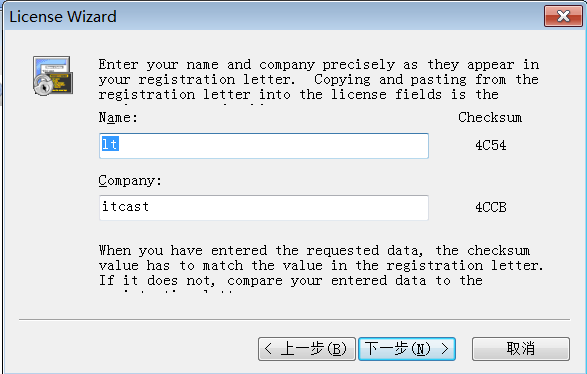

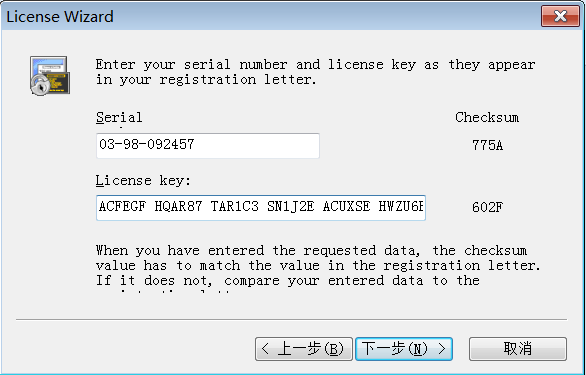

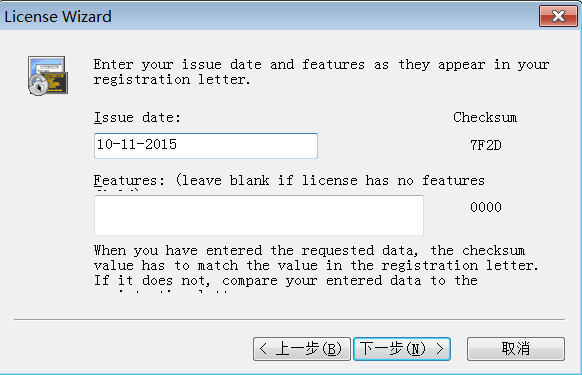

激活 步骤 1:将对应的激活程序拷贝到安装目录下

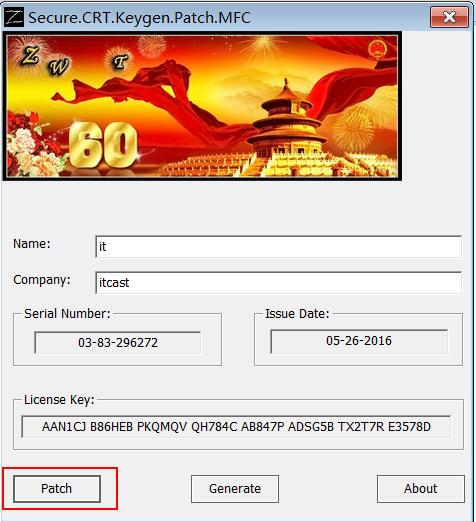

步骤 2:以“管理员”运行“SecureCRT v7.0 注册机.exe”激活程序,打补丁

步骤 3:生成序列号

步骤 4:运行程序,“SecureCRT 7.3”,并输入激活码

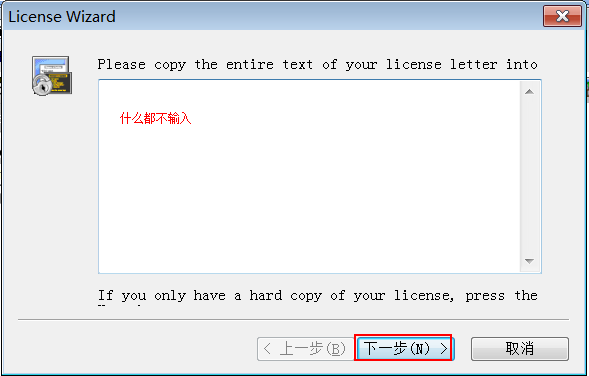

1)不输入任何内容,下一步

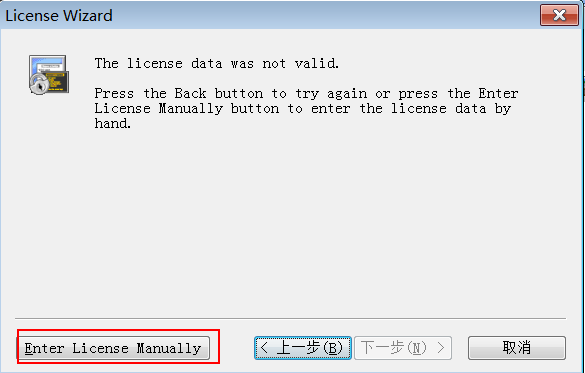

2)点击输入详情选项

3)输入详细内容

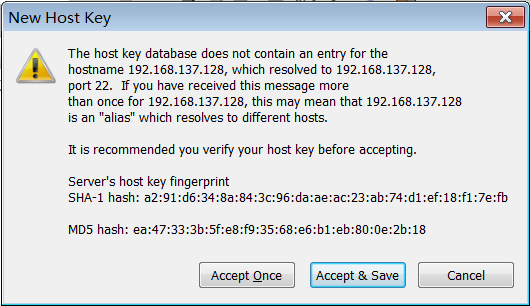

连接 步骤 1:登录 linux 成功之后,输入“ifconfig”查询 ip 地址

步骤 2:运行“SecureCRT.exe”进行连接

步骤 3:保存当次连接

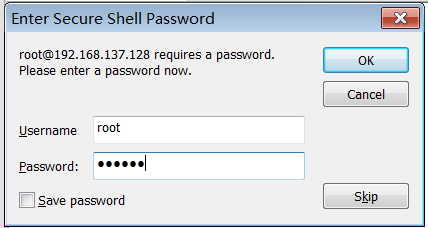

步骤 4:输入密码并连接

常见设置 设置操作窗口“背景黑色”。运行“SecureCRT 7.3”

修改后结果

设置操作窗口“字体”和“字符集”

实操篇,实践是检验真理的唯一标准,理论让你不至于摸着石头过河,而最终要学以致用才行。

软件安装(java)

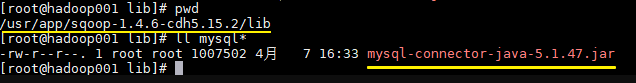

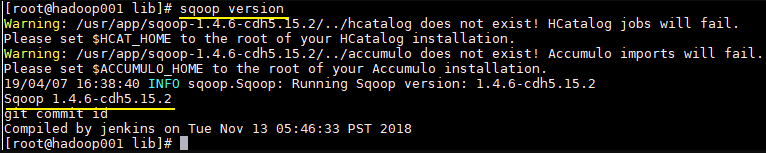

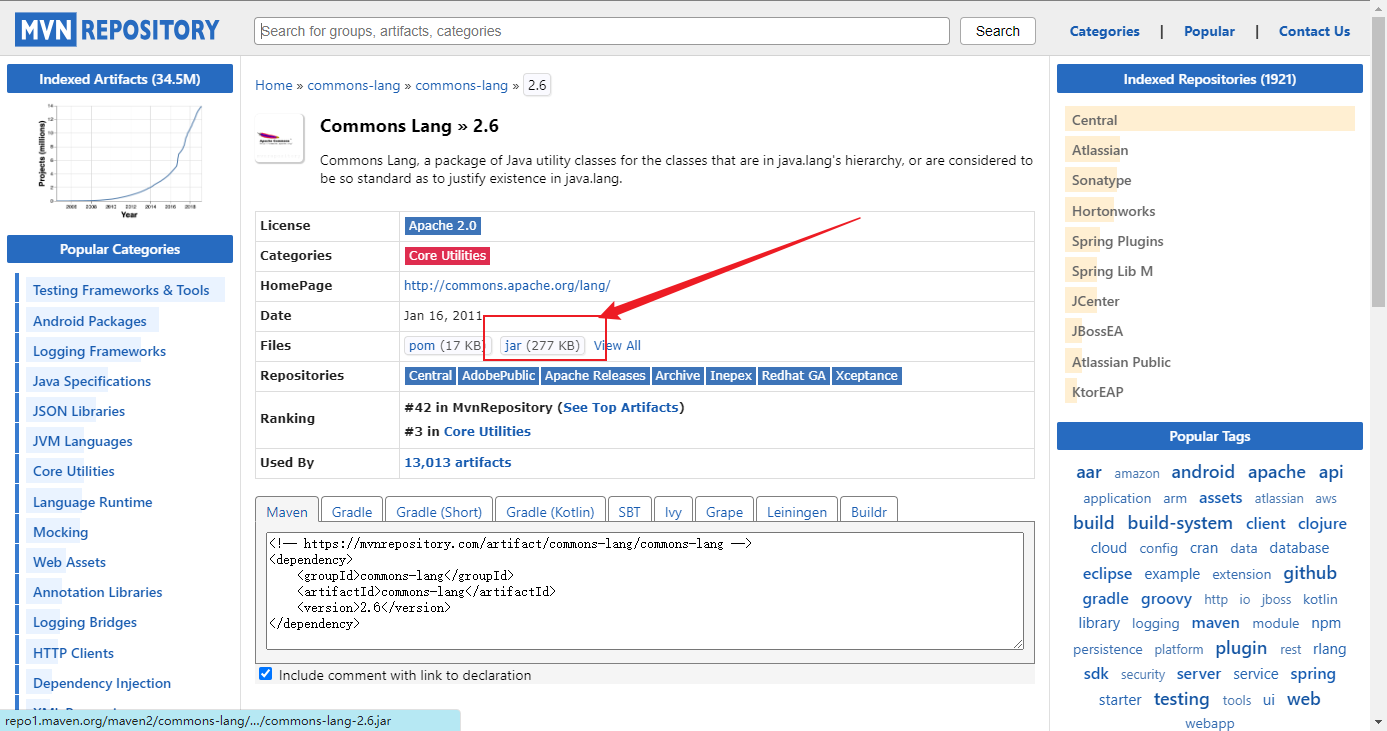

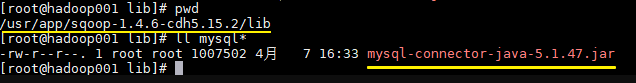

能放到/user/local/apps下的我都放到该目录下了

实操-安装文件上传工具 实操-安装Git 1.检查安装

2.卸载安装

1 rpm -e --nodeps git 或者 rpm -e git

3.安装Git(在线)

4.检验

实操-安装JDK 下载jdk并上传到linux http://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html

需要登录,用下面的账号,如果失效,再查找

1 2 1287019365@qq.com Oracle@1234

卸载默认JDK 检查系统上是否安装了jdk(若安装了就需要先卸载再使用我们自己的)

查看出安装的java的软件包

卸载linux自带的openjdk

历史原因,openjdk相当于简化版的jdk,不完整

1 2 3 4 5 6 7 rpm -qa | grep openjdk # 查询openjdk rpm -e --nodeps java-1.6.0-openjdk-1.6.0.0-1.66.1.13.0.el6.i686 rpm -e --nodeps java-1.7.0-openjdk-1.7.0.45-2.4.3.3.el6.i686 tzdata-java-2013g-1.el6.noarch # 删不掉加--nodeps # 或者用这个命令,卸载所有Java rpm -qa | grep -i java | xargs -n1 rpm -e --nodeps

解压安装包 进入 /opt/java 目录,解压jdk

1 2 cd /opt/apps/ tar -zxvf jdk-8u321-linux-x64.tar.gz -C /opt/apps

配置环境变量 1 2 3 4 5 vi /etc/profile # 在文件的最后面添加如下代码 export JAVA_HOME=/opt/apps/jdk1.8.0_321 export PATH=$JAVA_HOME/bin:$PATH

更好的做法: 配置到/etc/profile.d/下

1 2 3 4 5 6 7 # /etc/profile或加载/etc/profile.d/下的文件配置 cd /etc/profile.d/ sudo vim my_env.sh # JAVA配置 export JAVA_HOME=/opt/apps/jdk1.8.0_321 export PATH=$JAVA_HOME/bin:$PATH

检测是否安装成功 显示出对应的版本信息则代表安装成功。

1 2 3 java version "1.8.0_321" Java(TM) SE Runtime Environment (build 1.8.0_321-b07) Java HotSpot(TM) 64-Bit Server VM (build 25.321-b07, mixed mode)

实操-安装Tomcat(防火墙)

下载tomcat,上传到linux

https://archive.apache.org/dist/tomcat/tomcat-8/

https://archive.apache.org/dist/tomcat/tomcat-8/v8.5.75/bin/

在 /usr/local 新建一个文件夹tomcat

1 mkdir /usr/local/apps/tomcat

移动 tomcat…tar.gz 到 /usr/local/tomcat

1 mv apache-tomcat-8.5.32.tar.gz /usr/local/apps/tomcat/

进入/usr/local/tomcat目录,解压Tomcat

1 2 cd /usr/local/apps/tomcat tar -xvf apache-tomcat-8.5.32.tar.gz

进入 /usr/local/tomcat/apache-tomcat-8.5.32/bin

1 cd /usr/local/apps/tomcat/apache-tomcat-8.5.32/bin

启动tomcat

1 2 3 4 方式1: sh startup.sh 方式2: ./startup.sh

修改防火墙的规则

1 2 3 4 5 6 7 8 9 10 11 12 13 14 方式1:service iptables stop 关闭防火墙(不建议); 用到哪一个端口号就放行哪一个(80,8080,3306...) 方式2:放行8080 端口 修改配置文件 cd /etc/sysconfig vi iptables 复制(yy , p) -A INPUT -m state --state NEW -m tcp -p tcp --dport 22 -j ACCEPT 改成 -A INPUT -m state --state NEW -m tcp -p tcp --dport 8080 -j ACCEPT 重启加载防火墙或者重启防火墙 service iptables reload 或者 service iptables restart

centos7 防火墙添加端口

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 # 查看防火墙状态 firewall-cmd --state # 启动firewall:(centos7 默认防火墙是关闭的,要重启防护墙) systemctl start firewalld.service # 设置开机自启: systemctl enable firewalld.service # 查看防火墙设置开机自启是否成功: systemctl is-enabled firewalld.service;echo $? # 开启特定端口 在开启防火墙之后,我们有些服务就会访问不到,是因为服务的相关端口没有打开。 在此以打开80端口为例 开端口命令:firewall-cmd --zone=public --add-port=80/tcp --permanent 重启防火墙:systemctl restart firewalld.service 或:(此方式不需要重启) firewall-cmd --add-port=80/tcp --permanent && firewall-cmd --reload # tomcat防火墙 firewall-cmd --add-port=8080/tcp --permanent && firewall-cmd --reload # MySQL防火墙 firewall-cmd --add-port=3306/tcp --permanent && firewall-cmd --reload # redis防火墙 firewall-cmd --add-port=6379/tcp --permanent && firewall-cmd --reload # rabbitmq防火墙 firewall-cmd --add-port=5672/tcp --permanent && firewall-cmd --reload firewall-cmd --add-port=15672/tcp --permanent && firewall-cmd --reload # consul防火墙 firewall-cmd --add-port=8500/tcp --permanent && firewall-cmd --reload # apollo防火墙 firewall-cmd --add-port=8070/tcp --permanent && firewall-cmd --reload # MongoDB防火墙 firewall-cmd --add-port=27017/tcp --permanent && firewall-cmd --reload # elastic search防火墙 firewall-cmd --add-port=9200/tcp --permanent && firewall-cmd --reload firewall-cmd --add-port=9300/tcp --permanent && firewall-cmd --reload # kibana防火墙 firewall-cmd --add-port=5601/tcp --permanent && firewall-cmd --reload # zookeeper firewall-cmd --add-port=2181/tcp --permanent && firewall-cmd --reload firewall-cmd --add-port=20880/tcp --permanent && firewall-cmd --reload # nacos firewall-cmd --add-port=8848/tcp --permanent && firewall-cmd --reload # docker firewall-cmd --add-port=2375/tcp --permanent && firewall-cmd --reload 命令含义: --zone #作用域 --add-port=80/tcp #添加端口,格式为:端口/通讯协议 --permanent #永久生效,没有此参数重启后失效

端口占用

1 2 3 Caused by: java.net.BindException: 地址已在使用 netstat -alnp | grep 8080 kill - 9 1899

实操-安装maven (1)将Maven压缩包上传至服务器(虚拟机)

(2)解压

1 tar zxvf apache-maven-3.3.9-bin.tar.gz

(3)移动目录

1 mv apache-maven-3.3.9 /usr/local/apps/maven

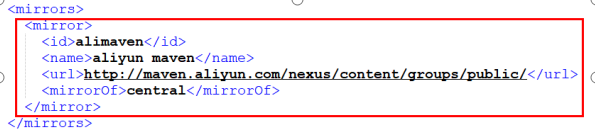

(4)编辑setting.xml配置文件 vi /usr/local/apps/maven/conf/settings.xml,配置本地仓库目录,内容如下

1 <localRepository>/usr/local/apps/maven/repository</localRepository>

(5)将开发环境的本地仓库上传至服务器(虚拟机)并移动到/usr/local/repository 。

1 mv reponsitory_boot /usr/local/repository

执行此步是为了以后在打包的时候不必重新下载,缩短打包的时间。

(6)编辑setting.xml配置文件 vi /usr/local/maven/conf/settings.xml

1 2 3 <pluginGroups> <pluginGroup>com.spotify</pluginGroup> </pluginGroups>

实操-安装MySql

下载mysql,上传到linux

http://ftp.ntu.edu.tw/MySQL/Downloads/MySQL-5.7/

检查系统上是否安装了mysql( 若安装了就需要先卸载再使用我们自己的)

1 2 rpm -qa |grep -i mysql #查看 rpm -e --nodeps mysql-libs-5.1.71-1.el6.i686 #卸载

在 /usr/local 新建一个文件夹mysql

把mysql压缩包移动 到/usr/local/mysql

1 mv MySQL-5.5.49-1.linux2.6.i386.rpm-bundle.tar /usr/local/mysql/

进入 /usr/local/mysql,解包mysql

1 2 cd /usr/local/mysql tar -xvf MySQL-5.5.49-1.linux2.6.i386.rpm-bundle.tar

安装 服务器端

1 rpm -ivh MySQL-server-5.5.49-1.linux2.6.i386.rpm

安装 客户端

1 rpm -ivh MySQL-client-5.5.49-1.linux2.6.i386.rpm

启动Mysql

1 service mysql start #启动mysql (注意:只启动一次)

先查看随机密码登录(cat /root/.mysql_secret)

登录mysql

修改密码

1 set password for root@localhost = password('123');

登录mysql

放行3306端口号

1 2 3 4 5 6 7 8 9 10 11 修改配置文件 cd /etc/sysconfig vi iptables 复制(yy p) -A INPUT -m state --state NEW -m tcp -p tcp --dport 22 -j ACCEPT 改成 -A INPUT -m state --state NEW -m tcp -p tcp --dport 3306 -j ACCEPT 重启加载防火墙或者重启防火墙 service iptables reload 或者 service iptables restart

允许远程连接 mysql

1 2 3 4 5 6 7 8 9 10 在linux上 先登录mysql cd /usr/local/mysql #进入mysql目录 mysql -uroot -p123 #登录 创建远程账号 create user 'root'@'%' identified by '123'; 授权 grant all on *.* to 'root'@'%' with grant option; 刷新权限 flush privileges;

实操-安装MySql5.7.38 下载

通过ftp上传到服务器

卸载 检查系统上是否安装了mysql( 若安装了就需要先卸载再使用我们自己的)

1 2 3 rpm -qa |grep -i mysql #查看 rpm -e --nodeps mysql-libs-5.1.71-1.el6.i686 #卸载

解压 1 tar -xvf mysql-5.7.38-1.el7.x86_64.rpm-bundle.tar -C /usr/local/apps/mysql

安装服务端 1 rpm -ivh mysql-community-server-5.7.38-1.el7.x86_64.rpm --force --nodeps

安装客户端 1 rpm -ivh mysql-community-client-5.7.38-1.el7.x86_64.rpm --force --nodeps

配置 配置文件添加以下配置

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 cd /etc/ vim /etc/my.cnf [mysqld] character-set-server=utf8 collation-server=utf8_general_ci [client] default-character-set=utf8

启动MySQL 登录mysql 1 2 3 4 5 mysql -uroot -p 初始化的密码:cat /var/log/mysqld.log # 在root@localhost: 后面的就是初始化密码

修改密码 1 2 3 4 5 6 7 8 9 # 忽略复杂密码验证 set global validate_password_policy=0; set global validate_password_length=1; SET PASSWORD = PASSWORD('root');

开启远程访问 1 2 3 4 5 grant all privileges on *.* to 'root'@'%' identified by'root'; # 第2个root是密码 FLUSH PRIVILEGES; exit # 退出窗口

环境变量配置 加入到环境变量配置文件中,实现通过 : mysql -u root -p 登录

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 vi /etc/profile 一直往下找到之前加入的环境变量,在下方加入 export MYSQL_HOME=/usr/local/apps/mysql export PATH=$MYSQL_HOME/bin:$PATH # 运行 source /etc/profile 让修改后的环境变量配置文件生效 # 运行 mysql -uroot -p 输入之前修改的密码

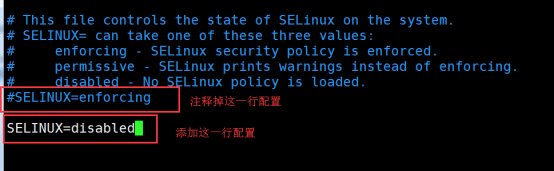

关闭防火墙 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 firewall-cmd --add-port=3306/tcp --permanent && firewall-cmd --reload 永久关闭防火墙(学习使用) systemctl stop firewalld.service #停止firewall systemctl disable firewalld.service #禁止firewall开机启动 编辑虚拟机的Selinux的配置文件 vim /etc/selinux/config SELINUX=disabled #该选项默认是: SELINUX=enforcing

解决断电后无法重启 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 # 查看配置文件位置 mysql --help | grep my.cnf # 在 /etc/my.cnf 中找到log-error的位置: log-error=/var/log/mysqld.log # 定位到ERROR问题 Invalid pid in unix socket lock file /var/lib/mysql/mysql.sock.lock # 删除lock文件 rm -rf mysql.sock.lock # 重启服务 service mysqld start # 成功

实操-安装MySql5.7.35(离线)

下载mysql,上传到linux

http://ftp.ntu.edu.tw/MySQL/Downloads/MySQL-5.7/

http://ftp.ntu.edu.tw/MySQL/Downloads/MySQL-5.7/mysql-5.7.38-1.el7.x86_64.rpm-bundle.tar

检查系统上是否安装了mysql( 若安装了就需要先卸载再使用我们自己的)

1 2 rpm -qa |grep -i mysql #查看 rpm -e --nodeps mysql-libs-5.1.71-1.el6.i686 #卸载

解压

1 tar -xzvf mysql-5.7.35-linux-glibc2.12-x86_64.tar.gz

移动解压后的文件至/usr/local/apps并重命名为mysql(必)

1 mv mysql-5.7.35-linux-glibc2.12-x86_64 /usr/local/apps/mysql

切换到目录下,创建data文件夹,用于存放数据

创建mysql用户和组

1 2 3 groupadd mysql useradd -r -g mysql mysql # useradd -r 表示mysql用户是系统用户, 不可用于登录系统 id mysql

将安装目录所有者及所属组改为mysql

1 2 3 chown -R mysql.mysql /usr/local/apps/mysql 或者 chown -R mysql:mysql /usr/local/apps/mysql

安装依赖包并初始化数据库,这一步在bin下运行

1 2 3 4 cd /usr/local/apps/mysql/bin yum install libaio ./mysqld --initialize --user=mysql --basedir=/usr/local/apps/mysql/ --datadir=/usr/local/apps/mysql/data # 记住初始密码 qLAx+FdC-3ZZ

编辑配置文件

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 cd /etc/ vim /etc/my.cnf [mysqld] datadir=/usr/local/apps/mysql/data basedir=/usr/local/apps/mysql socket=/tmp/mysql.sock user=mysql port=3306 character-set-server=utf8 # 取消密码验证 # skip-grant-tables symbolic-links=0 # skip-grant-tables [mysqld_safe] log-error=/var/log/mysqld.log pid-file=/var/run/mysqld/mysqld.pid !includedir /etc/my.cnf.d

可以设置取消密码验证,skip-grant-tables,取消注释。

将mysql加入到服务中

1 2 cd /usr/local/apps/mysql cp /usr/local/apps/mysql/support-files/mysql.server /etc/init.d/mysql

设置开启启动

启动mysql服务

登录mysql

1 2 3 4 5 cd /usr/local/apps/mysql/bin /usr/local/apps/mysql/bin/mysql -uroot -p 输入之前记录的密码,或者之前设置了跳过密码验证,直接回车进入mysql

如果报错 Can't connect to local MySQL server through socket

尝试重启服务systemctl restart mysql,/tmp/下有mysql.sock了

修改mysql登录密码

1 2 3 4 5 6 7 8 修改mysql登录密码 SET PASSWORD = PASSWORD('root'); # 设置秘密不过期 ALTER USER 'root'@'localhost' PASSWORD EXPIRE NEVER; FLUSH PRIVILEGES; exit

加入到环境变量配置文件中,实现通过 : mysql -u root -p 登录

1 2 3 4 5 6 7 8 9 10 11 12 vi /etc/profile 一直往下找到之前加入的环境变量,在下方加入 export MYSQL_HOME=/usr/local/apps/mysql export PATH=$MYSQL_HOME/bin:$PATH # 运行 source /etc/profile 让修改后的环境变量配置文件生效 # 运行 mysql -uroot -p 输入之前修改的密码

开启远程访问

1 2 grant all privileges on *.* to 'root'@'%' identified by'root'; # 第2个root是密码 FLUSH PRIVILEGES;

防火墙

1 firewall-cmd --add-port=3306/tcp --permanent && firewall-cmd --reload

永久关闭防火墙(学习使用)

1 2 3 4 5 6 7 systemctl stop firewalld.service #停止firewall systemctl disable firewalld.service #禁止firewall开机启动 编辑虚拟机的Selinux的配置文件 vim /etc/selinux/config #该选项默认是: SELINUX=enforcing,修改为以下值 SELINUX=disabled

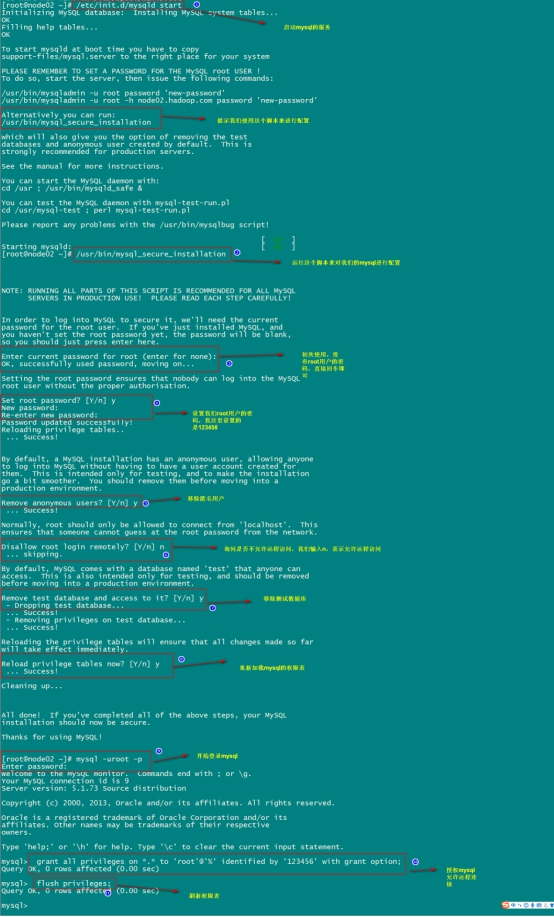

实操-安装MySql(在线) 第一步:在线安装mysql相关的软件包

1 yum install mysql mysql-server mysql-devel

第二步:启动mysql的服务

1 /etc/init.d/mysqld start

第三步:通过mysql安装自带脚本进行设置

1 /usr/bin/mysql_secure_installation

第四步:进入mysql的客户端然后进行授权

1 2 grant all privileges on *.* to 'root'@'%' identified by '123456' with grant option; flush privileges;

实操-安装Nexus 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 nexus 前提:jdk mkdir /usr/local/apps/nexus 解压:tar -zxvf nexus-2.11.2-03-bundle.tar.gz -C /usr/local/apps/nexus 修改nexus-2.11.2-03/bin/nexus: RUN_AS_USER=root #修改后的内容,代表Nexus私服使用root用户权限。 修改防火墙 vi /etc/sysconfig/iptables -A INPUT -m state --state NEW -m tcp -p tcp --dport 8081 -j ACCEPT service iptables restart 启动: /usr/local/apps/nexus/nexus-2.11.2-03/bin/nexus start /usr/local/apps/nexus/nexus-2.11.2-03/bin/nexus status 访问:http://ip:8081/nexus 登录admin /admin123 cofniguration down remote index--> true

实操-安装VSFTPD 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 安装:yum -y install vsftpd 添加用户(登录FTP服务器):useradd ftpuser (默认用不目录:/home/ftpuser.) 设置密码:passwd ftpuser 关闭防火墙: 1.vim /etc/sysconfig/iptables post:21 重启服务:service iptables restart 2.永久关闭:service iptables stop chkconfig iptables off 修改selinux: getsebool -a | grep ftp setsebool -P allow_ftpd_full_access on setsebool -P ftp_home_dir on 关闭匿名访问:(配置文件:/etc/vsftpd/vsftpd.conf) anonymous_enable=NO 服务: 开启: service vsftpd start 重启: service vsftpd restart 关闭: service vsftpd stop 开启启动:chkconfig vsftpd on

实操-安装redis

下载redis

https://redis.io/download

wget http://download.redis.io/releases/redis-5.0.14.tar.gz

在 /usr/local 新建一个文件夹redis

1 mkdir /usr/local/apps/redis # 实际redis命令存放目录

移动 redis…tar.gz 到 /usr/local/apps

1 mv redis-5.0.14.tar.gz /usr/local/apps/

进入/usr/local/apps目录,解压redis

1 2 cd /usr/local/apps tar -zxvf redis-5.0.14.tar.gz

编译需要的C环境

1 2 3 yum install gcc-c++ # 验证 gcc -v

进入 /usr/local/apps/redis-5.0.14/

1 2 3 4 5 6 7 cd /usr/local/apps/redis-5.0.14/ # redis解压的目录 # 编译(编译后的文件在src目录) make # 安装 make PREFIX=/usr/local/apps/redis/ install # 其实就是将bin目录拷贝到redis目录下,不指定默认安装到/usr/local/bin下 # 还要拷贝配置文件 cp redis.conf /usr/local/apps/redis/bin/

启动redis

1 2 3 4 5 6 7 8 cd /usr/local/apps/redis/bin # 服务端 ./redis-server # 客户端 ./redis-cli # 此处完整命令 /usr/local/apps/redis/bin/redis-server

后台启动redis

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 vi /usr/local/apps/redis/bin/redis.conf # 后台启动 将daemonize no 改成daemonize yes # 设置数据存放目录 mkdir /usr/local/apps/redis/data 配置文件 dir ./ 改为 dir /usr/local/apps/redis/data # 关闭保护 protected-mode no # 指定配置文件启动 ./redis-server ./redis.conf # bind 127.0.0.1 改为 0.0.0.0 # 查看redis进程 ps -ef |grep redis # 结束redis进程 kill -9 redis进程号

将redis加入到开机启动

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 vi /etc/rc.local //在里面添加内容: /usr/local/apps/redis/redis-5.0.14/src/redis-server /usr/local/apps/redis/redis-5.0.14/redis.conf (意思就是开机调用这段开启redis的命令) =================== 另一种方式: =================== 在系统服务目录里创建redis-server.service文件 vim /etc/systemd/system/redis-server.service [Unit] Description=The redis-server Process Manager After=syslog.target network.target [Service] Type=forking ExecStart=/usr/local/apps/redis/bin/redis-server /usr/local/apps/redis/bin/redis.conf [Install] WantedBy=multi-user.target # 重新加载系统服务 systemctl daemon-reload # 开机启动 systemctl enable redis-server.service

开启redis

1 /usr/local/apps/redis/bin/redis-server /usr/local/apps/redis/bin/redis.conf

将redis-cli,redis-server拷贝到bin下,让redis-cli指令可以在任意目录下直接使用

1 2 cp /usr/local/apps/redis/bin/redis-server /usr/local/bin/ cp /usr/local/apps/redis/bin/redis-cli /usr/local/bin/

防火墙

1 firewall-cmd --add-port=6379/tcp --permanent && firewall-cmd --reload

13.远程链接

1 2 3 4 5 6 7 8 报错:Redis Client On Error: Error: connect ECONNREFUSED 192.168.xxx.105:6379 Config right? vim redis.conf #注释 这一行重新启动redis即可 #bind 127.0.0.1 -::1 #bind 127.0.0.1 bind 0.0.0.0

实操-安装RabbitMQ 离线安装

卸载

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 # 删除安装包 [root@zabbix_server lib]# rpm -qa|grep rabbitmq rabbitmq-server-3.6.5-1.noarch [root@zabbix_server lib]# rpm -e --nodeps rabbitmq-server # 删除所有的rabbitmq目录 [root@de9f15cd4e56 ~]# whereis rabbitmq rabbitmq: /usr/lib/rabbitmq [root@de9f15cd4e56 ~]# rm -rf /usr/lib/rabbitmq/ rabbitmq:[root@de9f15cd4e56 ~]# find / -name rabbitmq /var/lib/rabbitmq /var/log/rabbitmq /root/.m2/repository/com/rabbitmq /usr/lib/ocf/resource.d/rabbitmq [root@de9f15cd4e56 ~]# [root@de9f15cd4e56 ~]# rm -rf /var/lib/rabbitmq [root@de9f15cd4e56 ~]# rm -rf /var/log/rabbitmq [root@de9f15cd4e56 ~]# rm -rf /usr/lib/ocf/resource.d/rabbitmq # 删除rabbitmq rabbitmqctl app_stop # 停止服务 yum list | grep rabbitmq yum -y remove rabbitmq-server.noarch # 删除erlang yum list | grep erlang yum -y remove erlang-* yum remove erlang.x86_64

1.安装依赖环境

1 2 # rpm包安装前需要安装下面的依赖包 yum install build‐essential openssl openssl‐devel unixODBC unixODBC‐devel make gcc gcc‐c++ kernel‐devel m4 ncurses‐devel tk tc xz

2. 离线安装

下载包:

1 2 3 4 5 6 wget https://packagecloud.io/rabbitmq/erlang/packages/el/7/erlang-23.2.7-2.el7.x86_64.rpm/download.rpm mv download.rpm erlang-23.2.7-2.el7.x86_64.rpm wget http://repo.iotti.biz/CentOS/7/x86_64/socat-1.7.3.2-5.el7.lux.x86_64.rpm wget https://github.com/rabbitmq/rabbitmq-server/releases/download/v3.8.17/rabbitmq-server-3.8.17-1.el7.noarch.rpm

安装包:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 # 上传rpm安装包 erlang-18.3-1.el7.centos.x86_64.rpm socat-1.7.3.2-5.el7.lux.x86_64.rpm rabbitmq-server-3.6.5-1.noarch.rpm # 解压安装 erlang rpm -ivh erlang-23.2.7-2.el7.x86_64.rpm --nodeps --force # 解压安装 socat rpm -ivh socat-1.7.3.2-5.el7.lux.x86_64.rpm --nodeps --force # 离线解压安装 rabbitmq rpm -ivh --prefix=/usr/local/apps/rabbitmq/ rabbitmq-server-3.8.14-1.el7.noarch.rpm --nodeps --force # 到这里就可以用service rabbitmq‐server start启动rabbitmq了

3.启动

1 2 3 service rabbitmq‐server start # 启动服务 service rabbitmq‐server stop # 停止服务 service rabbitmq‐server restart # 重启服务

4.开启管理界面及配置

1 2 3 4 5 6 7 8 9 # 开启管理界面(不然只能通过命令操作,不方便) rabbitmq-plugins enable rabbitmq_management # 修改默认配置信息 vim /usr/lib/rabbitmq/lib/rabbitmq_server‐3.6.5/ebin/rabbit.app # 比如修改密码、配置等等,例如:loopback_users 中的 <<"guest" >>,只保留guest # 重启服务 service rabbitmq‐server restart systemctl start rabbitmq‐server.service

5.开启防火墙

1 2 3 4 5 6 7 访问不到可能是防火墙拦截了。(或者单独开放15672端口) service iptables stop # 关闭防火墙 或者用单独的 firewall-cmd --add-port=15672/tcp --permanent && firewall-cmd --reload # tcp连接时需要开放端口(比如用java连接) firewall-cmd --add-port=5672/tcp --permanent && firewall-cmd --reload

6.拷贝一份配置文件

1 2 3 # 拷贝一份配置文件 cd /usr/share/doc/rabbitmq‐server‐3.6.5/ cp rabbitmq.config.example /etc/rabbitmq/rabbitmq.config

在线安装 1.添加rabbitmq yum源 yum源配置文件夹(/etc/yum.repos.d)下添加rabbitmq.repo,文件内容如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 # In /etc/yum.repos.d/rabbitmq.repo # # # [rabbitmq_erlang] name=rabbitmq_erlang baseurl=https://packagecloud.io/rabbitmq/erlang/el/7/$basearch repo_gpgcheck=1 gpgcheck=1 enabled=1 # PackageCloud's repository key and RabbitMQ package signing key gpgkey=https://packagecloud.io/rabbitmq/erlang/gpgkey https://github.com/rabbitmq/signing-keys/releases/download/2.0/rabbitmq-release-signing-key.asc sslverify=1 sslcacert=/etc/pki/tls/certs/ca-bundle.crt metadata_expire=300 [rabbitmq_erlang-source] name=rabbitmq_erlang-source baseurl=https://packagecloud.io/rabbitmq/erlang/el/7/SRPMS repo_gpgcheck=1 gpgcheck=0 enabled=1 gpgkey=https://packagecloud.io/rabbitmq/erlang/gpgkey sslverify=1 sslcacert=/etc/pki/tls/certs/ca-bundle.crt metadata_expire=300 # # # # RabbitMQ server # # [rabbitmq_server] name=rabbitmq_server baseurl=https://packagecloud.io/rabbitmq/rabbitmq-server/el/7/$basearch repo_gpgcheck=1 gpgcheck=1 enabled=1 # PackageCloud' s repository key and RabbitMQ package signing keygpgkey=https://packagecloud.io/rabbitmq/rabbitmq-server/gpgkey https://github.com/rabbitmq/signing-keys/releases/download/2.0/rabbitmq-release-signing-key.asc sslverify=1 sslcacert=/etc/pki/tls/certs/ca-bundle.crt metadata_expire=300 [rabbitmq_server-source] name=rabbitmq_server-source baseurl=https://packagecloud.io/rabbitmq/rabbitmq-server/el/7/SRPMS repo_gpgcheck=1 gpgcheck=0 enabled=1 gpgkey=https://packagecloud.io/rabbitmq/rabbitmq-server/gpgkey sslverify=1 sslcacert=/etc/pki/tls/certs/ca-bundle.crt metadata_expire=300

猜测:使用这个yum之后,可以解决Erlang版本和操作系统版本问题。

2.yum安装rabbitmq 1 2 3 4 5 6 7 8 9 #更新yum源 yum update -y #install these dependencies from standard OS repositories yum install socat logrotate -y #安装erlang和rabbitmq yum install erlang rabbitmq-server -y # 指定目录: --installroot=/usr/local/apps/rabbitmq/

3.查看安装版本 1 2 3 4 5 6 7 8 9 10 #查看Erlang erl -v Erlang/OTP 24 [erts-12.1.5] [source] [64-bit] [smp:2:2] [ds:2:2:10] [async-threads:1] Eshell V12.1.5 (abort with ^G) 1> #查看rabbitmq,可能要启动后才能使用rabbitmqctl rabbitmqctl version 3.9.10

4.启动rabbitmq 1 2 3 4 5 6 #启动 systemctl start rabbitmq-server #查看状态 systemctl status rabbitmq-server

5.防火墙开放端口访问 需要开发5672即15672端口,15672端口为管理界面使用

1 2 3 4 firewall-cmd --add-port=5672/tcp --permanent && firewall-cmd --reload firewall-cmd --add-port=15672/tcp --permanent && firewall-cmd --reload

6.启用管理页面插件 1 sudo /sbin/rabbitmq-plugins enable rabbitmq_management

7.添加访问用户远程访问 1 2 3 4 5 6 7 8 9 10 11 #查询安装默认的用户(一般有一个guest 用户和一个administrator管理员用户) rabbitmqctl list_users #其中admin 是用户名,123456是密码 rabbitmqctl add_user admin 123456 #通过命令给用户增加角色权限 rabbitmqctl set_user_tags admin administrator #给用户增加所有访问权限 rabbitmqctl set_permissions -p "/" admin '.*' '.*' '.*'

到此rabbitmq安装完成,页面URL:http://ip:15672/。

8.启动

1 2 3 4 5 6 7 8 9 10 [root@localhost home]# rabbitmq-server RabbitMQ 3.6.12. Copyright (C) 2007-2017 Pivotal Software, Inc. ## ## Licensed under the MPL. See http://www.rabbitmq.com/ ## ## ########## Logs: /var/log/rabbitmq/rabbit@localhost.log ###### ## /var/log/rabbitmq/rabbit@localhost-sasl.log ########## Starting broker... completed with 6 plugins. #这里显示6,说明web插件已经安装好啦

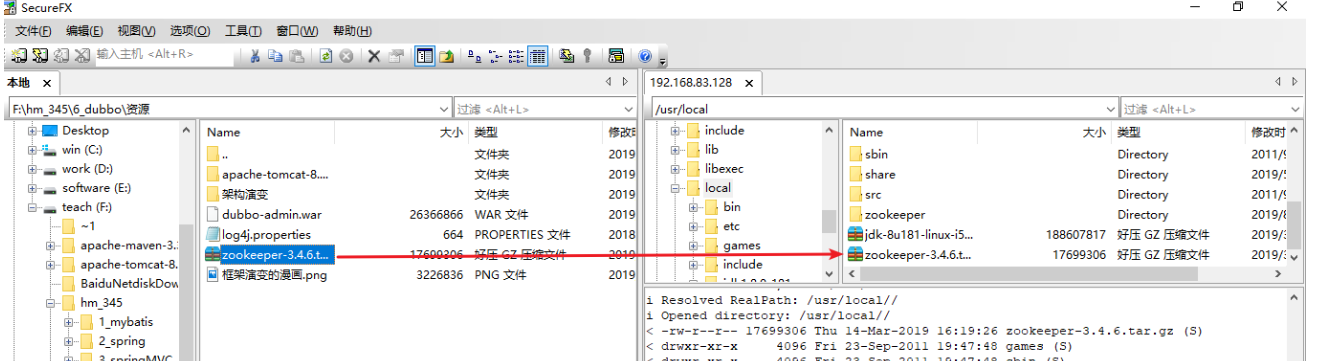

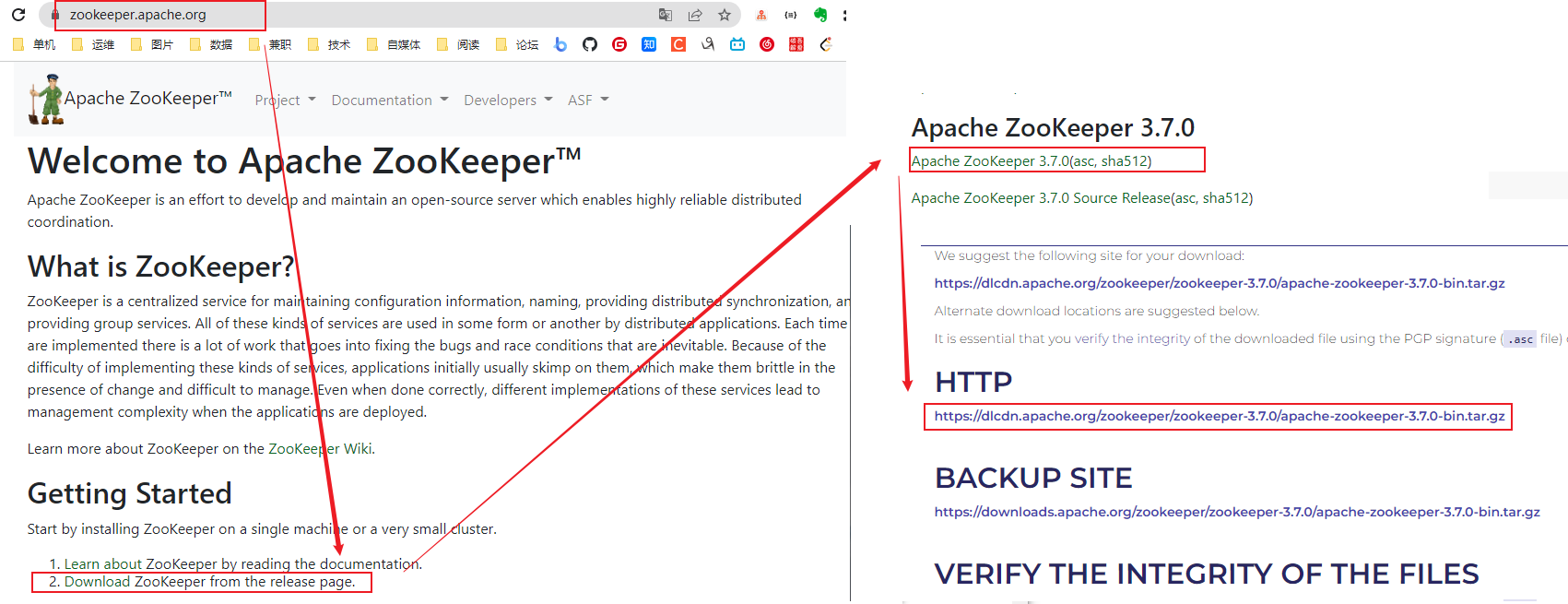

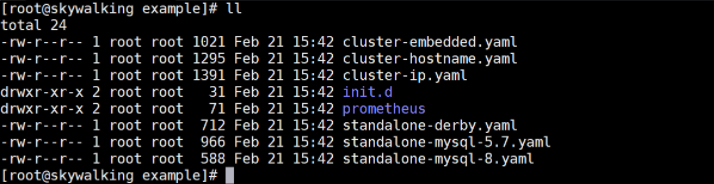

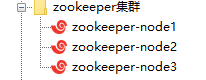

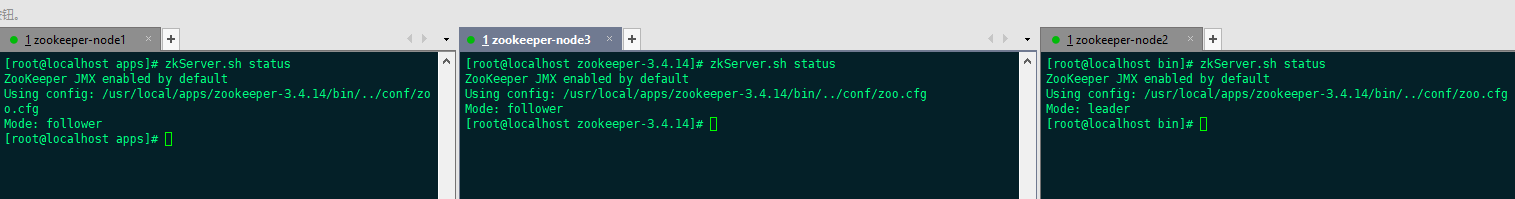

实操-安装Zookeeper 1.安装 jdk(略)

2.把 zookeeper 的压缩包(zookeeper-3.4.6.tar.gz)上传到 linux 系统

3.解压缩压缩包

1 2 3 tar -zxvf zookeeper-3.4.6.tar.gz # 可以改个名字 mv zookeeper-3.4.6 zookeeper

4.进入zookeeper-3.4.6目录,创建data目录 mkdir data

5.进入conf目录 ,把zoo_sample.cfg 改名为zoo.cfg

1 2 cd conf mv zoo_sample.cfg zoo.cfg 或 cp zoo_sample.cfg zoo.cfg

6.打开 zoo.cfg文件, 修改data属性:dataDir=/usr/local/apps/zookeeper/data

7.启动、停止Zookeeper

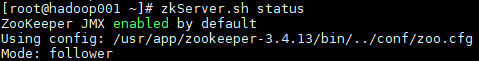

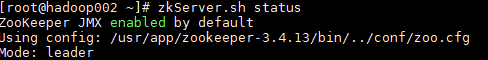

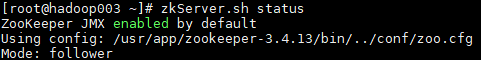

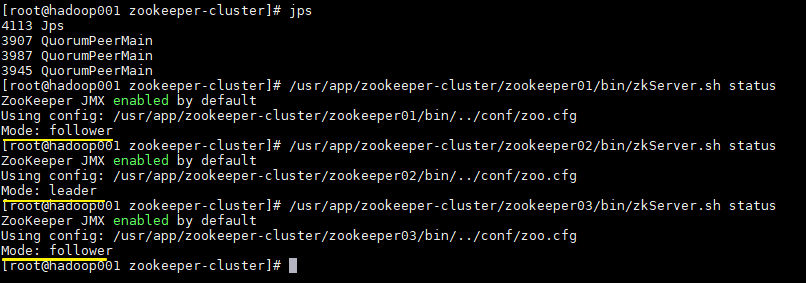

1 2 3 4 5 6 # 进入Zookeeper的bin目录,启动服务命令 ./zkServer.sh start # 停止服务命令 ./zkServer.sh stop # 查看服务状态: ./zkServer.sh status

8.开放防火墙

1 2 3 4 5 访问不到可能是防火墙拦截了。(或者单独开放2181、20880端口) service iptables stop # 关闭防火墙 或者用单独的 firewall-cmd --add-port=2181/tcp --permanent && firewall-cmd --reload firewall-cmd --add-port=20880/tcp --permanent && firewall-cmd --reload

注意:

zookeeper-3.7.0 下载的包是带bin的,3.7和3.42个版本命令差别挺大的

实操-安装ElasticSearch

为了模拟真实场景,我们将在linux下安装Elasticsearch。

1 2 3 # 环境要求: centos 64位 JDK8及以上

如果有的同学vmvare存在问题,可以在安装windows版本。

1 2 3 4 5 6 # 出于安全考虑,elasticsearch默认不允许以root账号运行。 useradd elastic # 设置密码: passwd elastic # 切换用户: su - elastic

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 我们将安装包上传到:/home/elastic目录 # 安装rz插件,一路 yes yum -y install lrzs # 切换到 cd /home/elastic rz -be # 解压缩: tar xvf elasticsearch-6.8.0.tar.gz # 目录重命名: mv elasticsearch-6.8.0/ elasticsearch # 修改权限(可选) chown elastic:elastic -R elasticsearch # 目录说明 bin 二进制脚本,包含启动命令等 config 配置文件目录 lib 依赖包目录 logs 日志文件目录 modules 模块库 plugins 插件目录,这里存放一些常用的插件比如IK分词器插件 data 数据储存目录(暂时没有,需要在配置文件中指定存放位置,启动es时会自动根据指定位置创建)

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 我们进入config目录: cd config ll # 修改jvm配置 # Elasticsearch基于Lucene的,而Lucene底层是java实现,因此我们需要配置jvm参数设置堆大小 vim jvm.options # 默认配置如下: -Xms1g -Xmx1g # 内存占用太多了,我们调小一些,大家虚拟机内存设置为2G: # 最小设置128m,如果虚机内存允许的话设置为512m -Xms128m -Xmx128m # 修改elasticsearch.yml vim elasticsearch.yml # 修改数据和日志目录: path.data: /home/elastic/elasticsearch/data # 数据目录位置 path.logs: /home/elastic/elasticsearch/logs # 日志目录位置 # 修改绑定的ip: network.host: 0.0.0.0 # 绑定到0.0.0.0,允许任何ip来访问 默认只允许本机访问,修改为0.0.0.0后则可以远程访问 目前我们是做的单机安装,如果要做集群,只需要在这个配置文件中添加其它节点信息即可。 elasticsearch.yml的其它可配置信息:

1 2 3 4 5 6 7 8 9 10 11 # 进入elasticsearch/bin目录,可以看到下面的执行文件: ./elasticsearch # 后台启动 ./elasticsearch -d 1.查找ES进程 ps -ef | grep elastic 2.杀掉ES进程 kill -9 2382(进程号) 3.重启ES sh elasticsearch -d

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 # [1]: max file descriptors [4096] for elasticsearch process likely too low, increase to at least [65536] # elasticsearch用户拥有的可创建文件描述的权限太低,至少需要65536; 我们用的是elastic用户,而不是root,所以文件权限不足。 首先用root用户登录。 然后修改配置文件: vim /etc/security/limits.conf 添加下面的内容: 注意下面的 “*” 号不要去除 # 可打开的文件描述符的最大数(软限制) * soft nofile 65536 #可打开的文件描述符的最大数(硬限制) * hard nofile 131072 #单个用户可用的最大进程数量(软限制) * soft nproc 4096 #单个用户可用的最大进程数量(硬限制) * hard nproc 4096 # 重新登录即生效 # [1]: max number of threads [1024] for user [leyou] is too low, increase to at least [4096] 这是线程数不够。 继续修改配置 vim /etc/security/limits.d/90-nproc.conf 修改下面的内容: * soft nproc 1024 改为: * soft nproc 4096 # [3]: max virtual memory areas vm.max_map_count [65530] likely too low, increase to at least [262144] # elasticsearch用户拥有的最大虚拟内存太小,至少需要262144; vim /etc/sysctl.conf 添加下面内容: vm.max_map_count=262144 然后执行命令: sysctl -p # 内核过低unable to install syscall filter 使用的centos6,其linux内核版本为2.6。而Elasticsearch的插件要求至少3.5以上版本。不过没关系,我们禁用这个插件即可。 修改elasticsearch.yml文件,在最下面添加以后配置 bootstrap.system_call_filter: false 重启终端窗口 所有错误修改完毕,如果启动还是失败则需要重启你的 Xshell终端,使配置生效

1 2 3 4 5 可以看到绑定了两个端口: 9300:集群节点间通讯接口,接收tcp协议 9200:客户端访问接口,接收Http协议 验证是否启动成功: 在浏览器中访问:http://192.168.88.128:9200/,如果不能访问,则需要关闭虚拟机防火墙,需要root权限

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 # 查看防火墙: service iptables status (centos 6) firewall-cmd --state (centos7) # 关闭防火墙: service iptables stop (centos 6) systemctl stop firewalld.service (centos7) # 禁止开机启动防火墙: chkconfig iptables off (centos 6) systemctl disable firewalld.service (centos7) firewall-cmd --add-port=9200/tcp --permanent && firewall-cmd --reload firewall-cmd --add-port=9300/tcp --permanent && firewall-cmd --reload

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 使用插件安装(方式一)=> 在线安装真香! 1)在elasticsearch的bin目录下执行以下命令,es插件管理器会自动帮我们安装,然后等待安装完成: ./elasticsearch-plugin install https://github.com/medcl/elasticsearch-analysis-ik/releases/download/v6.8.0/elasticsearch-analysis-ik-6.8.0.zip 2)下载完成后会提示 Continue with installation?输入 y 即可完成安装 3)重启es 和kibana 上传安装包安装(方式二) 1)在elasticsearch的plugins目录下新建 analysis-ik 目录 # 新建analysis-ik文件夹 mkdir analysis-ik # 切换至 analysis-ik文件夹下 cd analysis-ik # rz上传资料中的 elasticsearch-analysis-ik-6.8.0.zip rz # 解压 unzip elasticsearch-analysis-ik-6.8.0.zip # 解压完成后删除zip rm -rf elasticsearch-analysis-ik-6.8.0.zip 2)重启es 和kibana

注意:

1 2 3 如果用root启动,会导致一些文件变为root,下次用elatic启动没有权限写入, 要么一个一个删除,要么修改权限, elastic要有修改文件所属root组的权限的话,要修改soduers文件配置。

实操-安装Kibana 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 # 安装 # 将资料中的kibana-6.8.0-linux-x86_64.tar.gz上传至虚机,解压即可: tar xvf kibana-6.8.0-linux-x86_64.tar.gz # 配置运行 ## 进入安装目录下的config目录,修改kibana.yml文件: #修改server.host地址: server.host: "0.0.0.0" #界面中文显示,在最后一行修改 i18n.locale: "zh-CN" # 运行 # 进入安装目录下的bin目录运行: ./kibana # 发现kibana的监听端口是5601 # 我们访问: http://192.168.129.134:5601 # 开放端口(可选) firewall-cmd --add-port=5601/tcp --permanent && firewall-cmd --reload

1 2 3 # kibana dev tools快捷键 ctrl+enter 提交请求 ctrl+i 自动缩进

1 2 3 # Another Kibana instance appears to be migrating the index. Waiting for that migration to complete. If no other Kibana instance is attempting migrations, you can get past this message by deleting index .kibana_1 and restarting Kibana. 如果出现上述问题,可以使用elasticsearch-head删除kibana的相关索引,然后再启动kibana

实操-安装consul 1、下载consul安装源

1 官网地址:https://www.consul.io/downloads

2、解压安装包

1 unzip consul_1.9.0_linux_amd64.zip -d /usr/local/apps/consul/

解压出的文件是一个可以执行的文件 consul

3、查看consul版本 确定是否可用

4、将可执行程序设置成全局变量

(1)拷贝文件到/usr/local/bin下

1 cp consul /usr/local/bin/

(2)配置环境变量

1 2 3 4 5 6 7 8 9 10 #编辑~/.bashrc vi ~/.bashrc #新增下面代码 export CONSUL_HOME=/usr/local/bin/consul export PATH=$PATH:CONSUL_HOME #重新加载~/.bashrc source ~/.bashrc #测试是否能使用,输出版本及为正常 consul --version

5、启动服务

1 consul agent -dev -ui -client=0.0.0.0

6、设置启动脚本

(1)添加脚本,找一个自己脚本存放的位置

1 2 3 4 5 6 #新增启动脚本 consul_start.sh vi consul_start.sh #输入 nohup consul agent -dev -ui -client=0.0.0.0 >/tmp/consul.log & echo 'consul start success' #保存并退出

(2)设置脚本执行权限

1 chmod +x consul_start.sh

(3)运行脚本

7、浏览器访问

8、启动linux server

1 2 consul agent -server -bootstrap-expect 1 -data-dir /usr/local/apps/consul/data -node=n1 -ui -client=0.0.0.0 -bind=192.168.213.129 # 启动后直接访问 http://192.168.213.129:8500 就行了

9、防火墙

1 2 # consul防火墙 firewall-cmd --add-port=8500/tcp --permanent && firewall-cmd --reload

实操-安装nginx 卸载nginx

1 2 3 4 5 6 7 rm -rf /etc/nginx/ rm -rf /usr/sbin/nginx yum remove nginx # 查找相关目录删除 find / -name nginx

安装编译环境

一般系统中已经装了了make和g++,无须再装

安装make

1 yum -y install autoconf automake make

安装g++

1 yum -y install gcc gcc-c++ (nginx是c语言开发的)

安装nginx依赖的库

1 2 3 yum -y install pcre pcre-devel (http模块使用pcre解析正则) yum -y install zlib zlib-devel (是用zlib对http内容打包) yum -y install openssl openssl-devel (hhttps协议)

下载nginx

1 wget http://nginx.org/download/nginx-1.21.1.tar.gz

也可以先下载好这个tar包,离线安装

解压nginx

1 tar -zxvf nginx-1.21.1.tar.gz

编译安装

1 2 ./configure --prefix=/usr/local/nginx make && make install

--prefix默认就是该目录

配置环境变量

编辑/etc/profile

在最后一行加入

1 2 PATH=$PATH:/usr/local/nginx/sbin export PATH

生效环境变量

关闭防火墙

1 2 3 4 5 systemctl status firewalld systemctl stop firewalld systemctl disable firewalld firewall-cmd --add-port=80/tcp --permanent && firewall-cmd --reload

启动

1 2 3 nginx # 如果执行配置文件 nginx -c nginx.conf #如果不指定,默认为NGINX_HOME/conf/nginx.conf

停止

退出

关闭

1 2 3 4 5 # 查看nginx进程号 ps -aux | grep nginx # 杀掉进程(杀进程要先杀master,否则会再启动进程) kill -9 nginx

重新加载配置文件

检查配置文件是否正确

1 nginx -t -c /路径/nginx.conf

查看nginx的版本信息

实操-安装Apollo[失败] 前提:

Github安装包下载地址:https://github.com/nobodyiam/apollo-build-scripts

上传zip包到/usr/local/apps并解压

1 unzip apollo-build-scripts-master.zip

创建数据库

1 2 3 cd apollo-build-scripts-master/sql source apolloconfigdb.sql source apolloportaldb.sql

配置demo.sh的数据库

1 2 3 4 5 6 7 8 9 10 vim ./demo.sh apollo_config_db_url ="jdbc:mysql://192.168.200.129:3306/ApolloConfigDB? characterEncoding=utf8&serverTimezone=Asia/Shanghai" apollo_config_db_username =root apollo_config_db_password =root apollo_portal_db_url ="jdbc:mysql://192.168.200.129:3306/ApolloPortalDB? characterEncoding=utf8&serverTimezone=Asia/Shanghai" apollo_portal_db_username =root apollo_portal_db_password =root

检查端口是否被占用

1 2 3 4 5 6 7 8 Quick Start脚本会在本地启动3个服务,分别使用8070, 8080, 8090端口,请确保这3个端口当前没有被使用,如果端口没有被使用 lsof -i:8070 lsof -i:8080 lsof -i:8090 [root@localhost apollo-build-scripts-master]# netstat -anp | grep 8070 [root@localhost apollo-build-scripts-master]# netstat -anp | grep 8080 [root@localhost apollo-build-scripts-master]# netstat -anp | grep 8090

如果有端口占用

启动服务

1 2 cd /usr/local/apps/apollo-build-scripts-master/ ./demo.sh start

启动完成后访问 : http://192.168.200.129:8070/

防火墙:

1 firewall-cmd --add-port=8070/tcp --permanent && firewall-cmd --reload

实操-安装MongoDB 1.下载安装包

1 2 3 4 5 cd /usr/local/apps yum -y install wget wget https://fastdl.mongodb.org/linux/mongodb-linux-x86_64-rhel70-4.4.5.tgz tar -zxvf mongodb-linux-x86_64-rhel70-4.4.5.tgz mv mongodb-linux-x86_64-rhel70-4.4.5 mongodb4.4.5

2.配置环境变量

1 2 3 4 5 6 7 vi /etc/profile ... export MONGO_HOME=/usr/local/apps/mongodb4.4.5 ... export PATH=$MYSQL_HOME/bin:$JAVA_HOME/bin:$NGINX_HOME:$MONGO_HOME/bin:$PATH ... source /etc/profile

3.安装MongoDB

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 mkdir data logs #创建mongodb的日志文件 touch logs/mongodb.log vi mongodb.conf #端口号 默认为27017 port=27017 #数据库数据存放目录 dbpath=/usr/local/apps/mongodb4.4.5/data #数据库日志存放目录 logpath=/usr/local/apps/mongodb4.4.5/logs/mongodb.log # pid存储路径 pidfilepath = /var/run/mongo.pid #以追加的方式记录日志 logappend = true #以后台方式运行进程 fork=true #开启用户认证 #auth=true #最大同时连接数 maxConns=100 #这样就可外部访问了,例如从win10中去连虚拟机中的MongoDB bind_ip = 0.0.0.0 #每次写入会记录一条操作日志(通过journal可以重新构造出写入的数据)。 #启用日志文件,默认启用 journal=true #这个选项可以过滤掉一些无用的日志信息,若需要调试使用请设置为false quiet=true

4.作为服务启动

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 vi /etc/init.d/mongod #!/bin/sh # chkconfig: #MogoDB home directory MONGODB_HOME=/usr/local/apps/mongodb4.4.5/ #mongodb command MONGODB_BIN=$MONGODB_HOME/bin/mongod #mongodb config file MONGODB_CONF=$MONGODB_HOME/bin/mongodb.conf #mongodb PID MONGODB_PID=/var/run/mongo.pid #set open file limit SYSTEM_MAXFD=65535 MONGODB_NAME="mongodb" . /etc/rc.d/init.d/functions if [ ! -f $MONGODB_BIN ] then echo "$MONGODB_NAME startup: $MONGODB_BIN not exists! " exit fi start(){ ulimit -HSn $SYSTEM_MAXFD $MONGODB_BIN --config="$MONGODB_CONF" --fork ##added ret=$? if [ $ret -eq 0 ]; then action $"Starting $MONGODB_NAME: " /bin/true else action $"Starting $MONGODB_NAME: " /bin/false fi } stop(){ PID=$(ps aux |grep "$MONGODB_NAME" |grep "$MONGODB_CONF" |grep -v grep |wc -l) if [[ $PID -eq 0 ]];then action $"Stopping $MONGODB_NAME: " /bin/false exit fi kill -HUP `cat $MONGODB_PID` ret=$? if [ $ret -eq 0 ]; then action $"Stopping $MONGODB_NAME: " /bin/true rm -f $MONGODB_PID else action $"Stopping $MONGODB_NAME: " /bin/false fi } restart() { stop sleep 2 start } case "$1" in start) start ;; stop) stop ;; status) status $prog ;; restart) restart ;; *) echo $"Usage: $0 {start|stop|status|restart}" esac

设置文件权限

1 chmod 755 /etc/init.d/mongod

5.启动MongoDB

1 2 3 4 5 # 启动mongodb service mongod start # 检查服务是否存在 ps -ef|grep mongo

6.关闭防火墙

1 2 # MongoDB防火墙 firewall-cmd --add-port=27017/tcp --permanent && firewall-cmd --reload

7.优雅关机

1 2 3 4 >mongo show dbs; use admin db.shutdownServer()

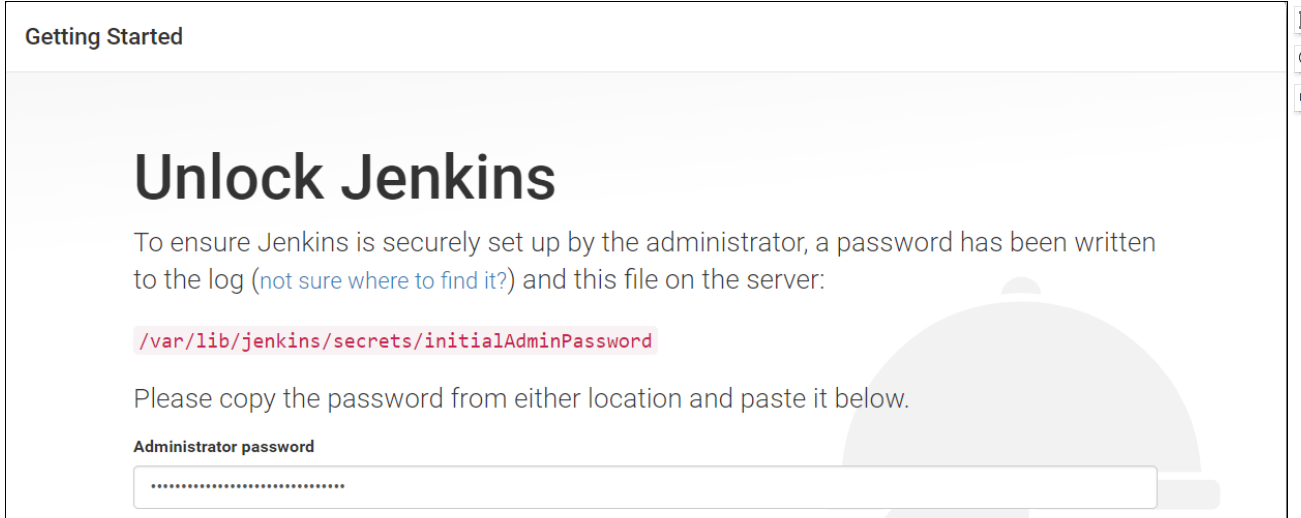

实操-安装Jenkins

前置:jdk、git、maven

1.下载jenkins

1 2 3 4 5 wget https://pkg.jenkins.io/redhat/jenkins-2.83-1.1.noarch.rpm 下面这个可以: yum -y install epel-release yum -y install daemonize wget https://mirrors.tuna.tsinghua.edu.cn/jenkins/redhat-stable/jenkins-2.319.1-1.1.noarch.rpm

2.安装jenkins

1 2 rpm -ivh jenkins-2.83-1.1.noarch.rpm rpm -ivh jenkins-2.319.1-1.1.noarch.rpm

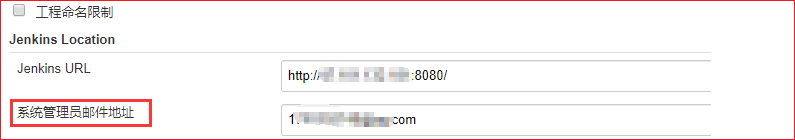

3.配置Jenkins用户和端口

1 2 3 4 vim /etc/sysconfig/jenkins JENKINS_USER="root" JENKINS_PORT="8888"

配置jdk路径(如果默认路径不是/usr/local/java的话)

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 vim /etc/rc.d/init.d/jenkins candidates=" /etc/alternatives/java /usr/lib/jvm/java-1.8.0/bin/java /usr/lib/jvm/jre-1.8.0/bin/java /usr/lib/jvm/java-1.7.0/bin/java /usr/lib/jvm/jre-1.7.0/bin/java /usr/lib/jvm/java-11.0/bin/java /usr/lib/jvm/jre-11.0/bin/java /usr/lib/jvm/java-11-openjdk-amd64 /usr/bin/java /usr/local/apps/java/jdk1.8.0_321/bin/java #把自己配置的目录加进去 systemctl daemon-reload

4.启动服务

5.访问Jenkins

访问链接 http://192.168.213.130:8888

如果访问不了开放防火墙

1 firewall-cmd --add-port=8888/tcp --permanent && firewall-cmd --reload

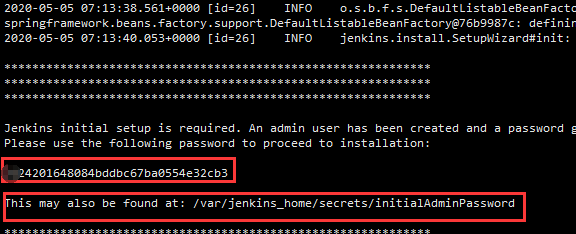

从cat /var/lib/jenkins/secrets/initialAdminPassword中获取初始密码串

如果报错:

1 An error occurred during installation: No such plugin: cloudbees-folder

重启一下Jenkins

1 2 3 http://localhost:8888/restart 或者 systemctl restart jenkins

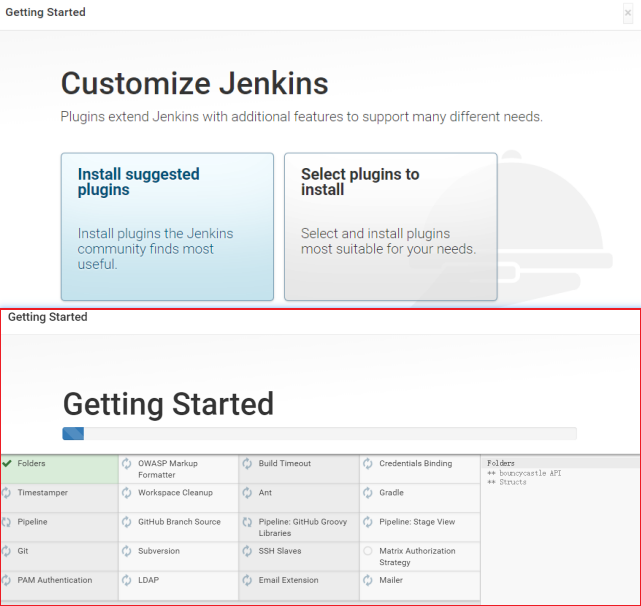

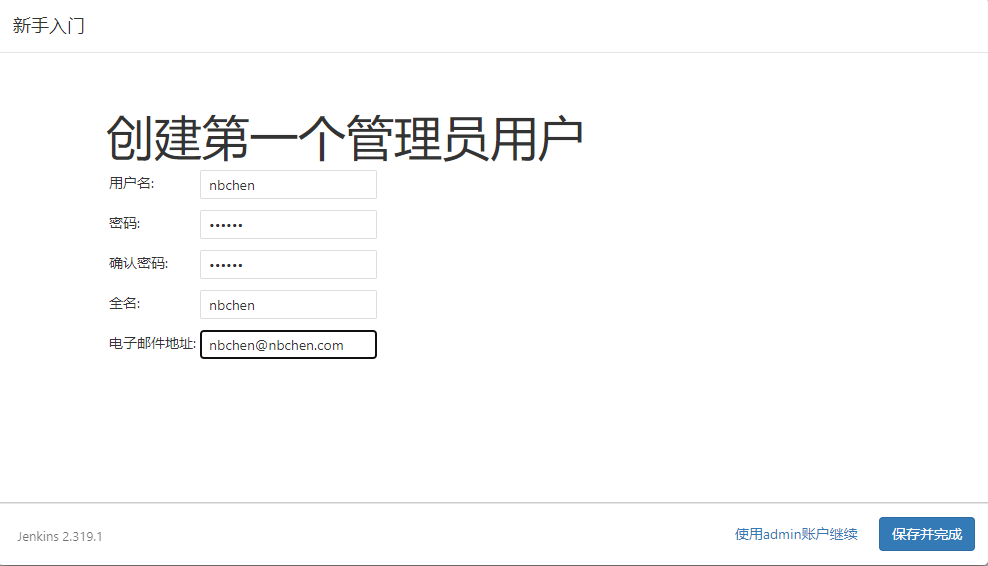

6.新建用户

7.完成安装进入主界面

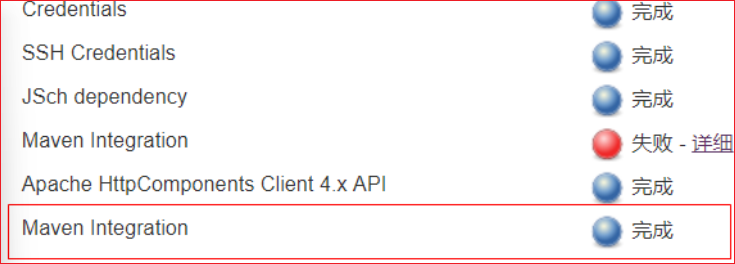

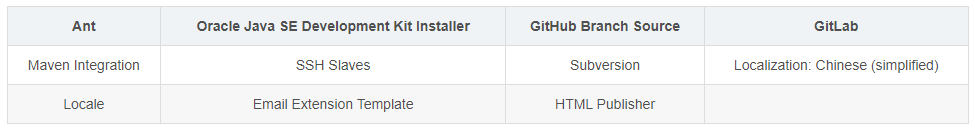

8.安装插件-maven插件

(1)点击左侧的“系统管理”菜单 ,然后点击 管理插件

(2)选择“可选插件”选项卡,搜索maven,在列表中选择Maven Integration ,点击“直 接安装”按钮

看到如下图时,表示已经完成

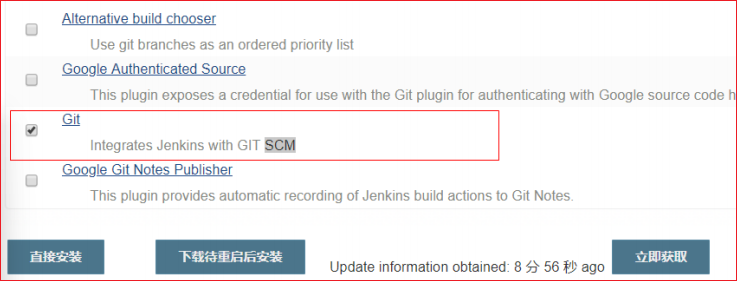

9.安装插件-git插件

步骤同8,搜索git

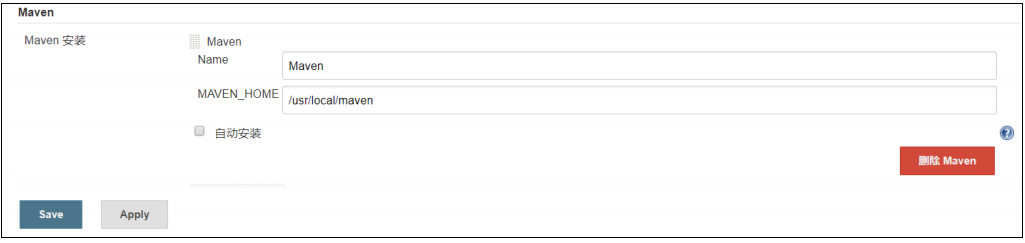

10.全局工具配置-安装maven和本地仓库

安装maven,将开发maven库上传到服务器的maven仓库(否则后续在线下载可能比较慢)

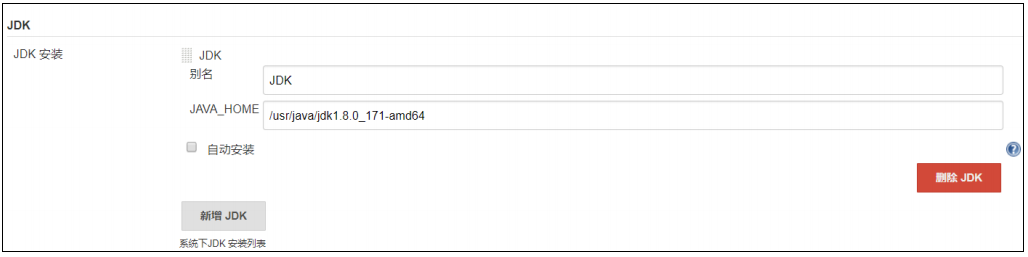

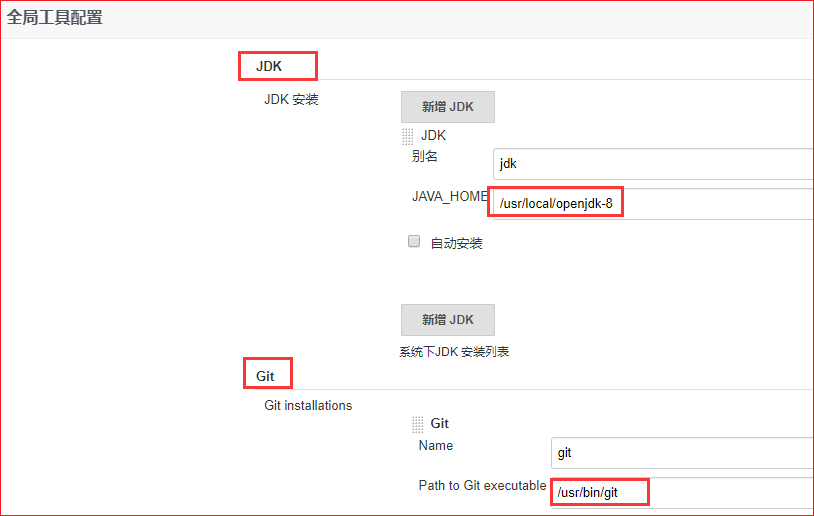

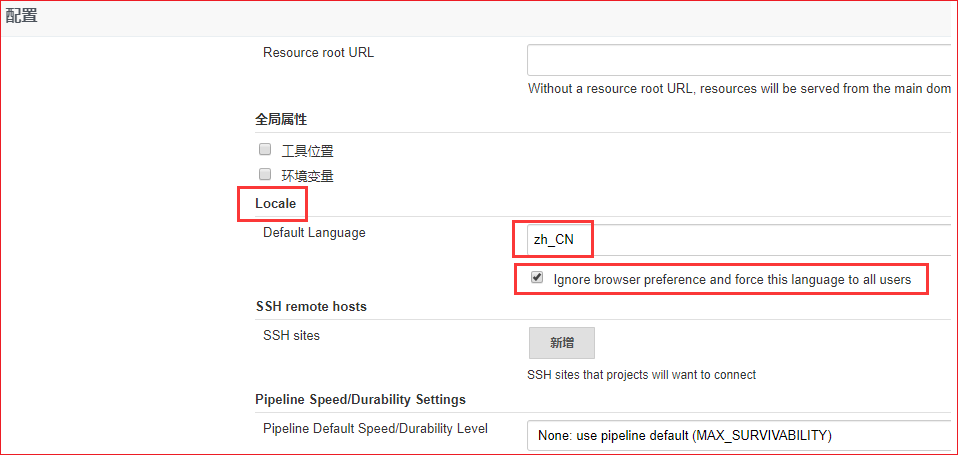

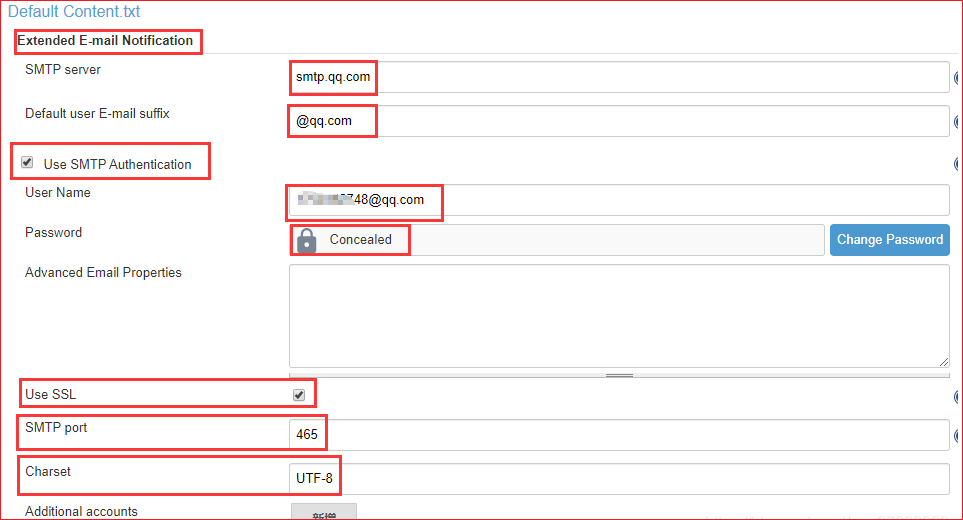

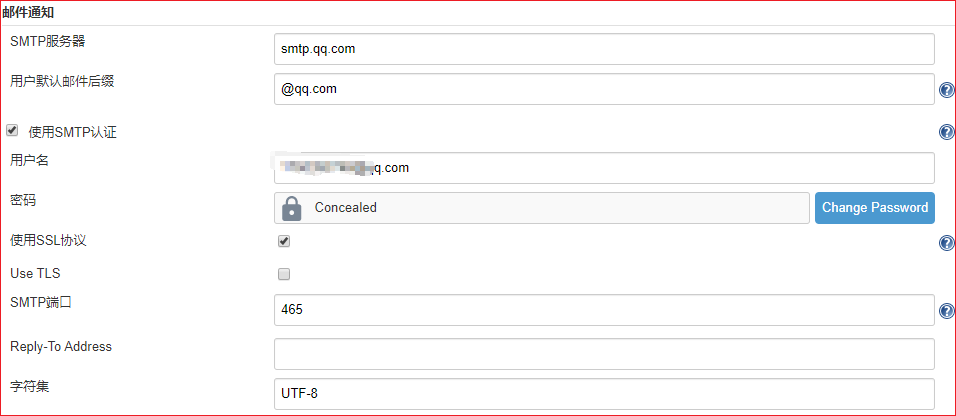

11.全局工具配置-jdk配置,设置javahome

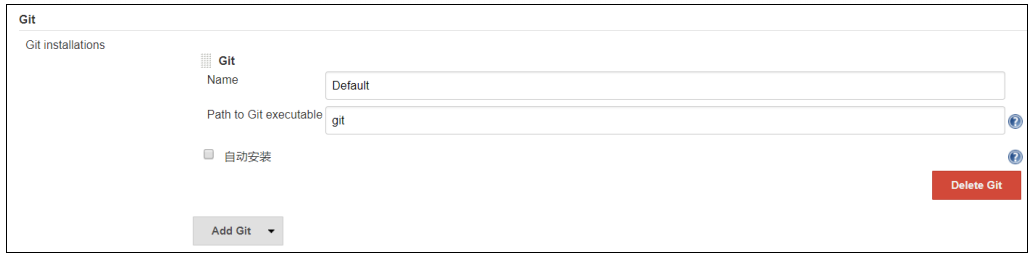

12.全局工具配置-git配置

13.全局工具配置-maven配置

14.持续集成

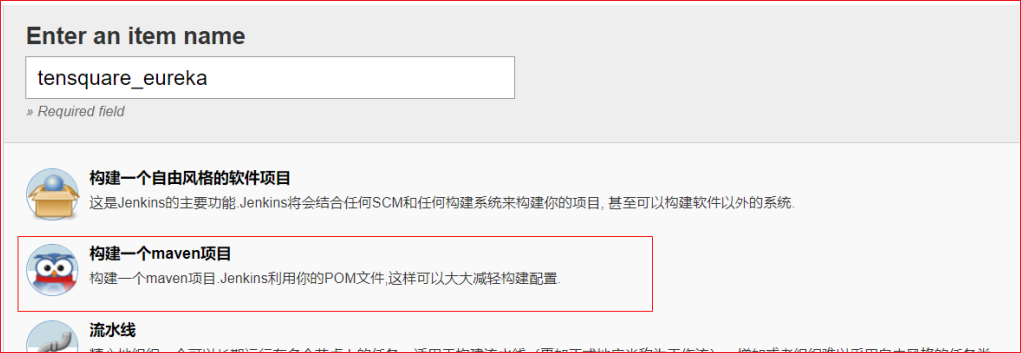

(1)回到首页,点击新建按钮 .如下图,输入名称,选择创建一个Maven项目,点击OK

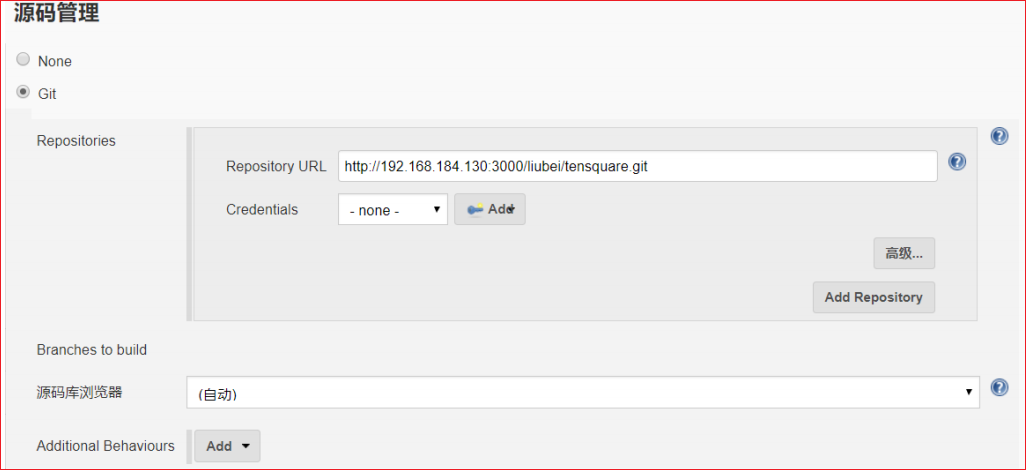

(2)源码管理,选择Git

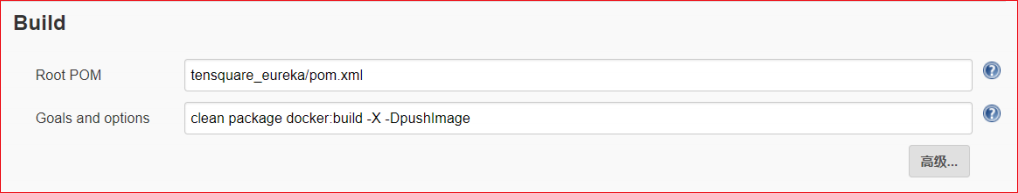

(3)Build

命令:

1 clean package docker:build -DpushImage

用于清除、打包,构建docker镜像

最后点击“保存”按钮

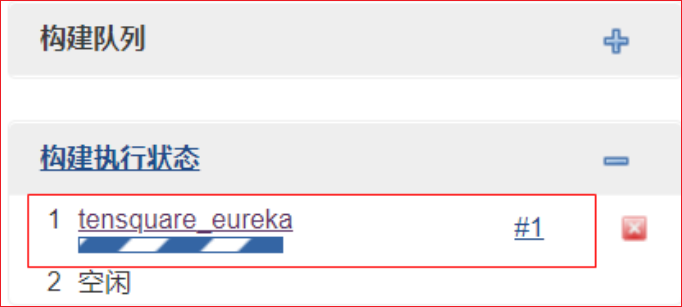

15.执行任务

返回首页,在列表中找到我们刚才创建的任务

点击右边的绿色箭头按钮,即可执行此任务.

点击下面正在执行的任务

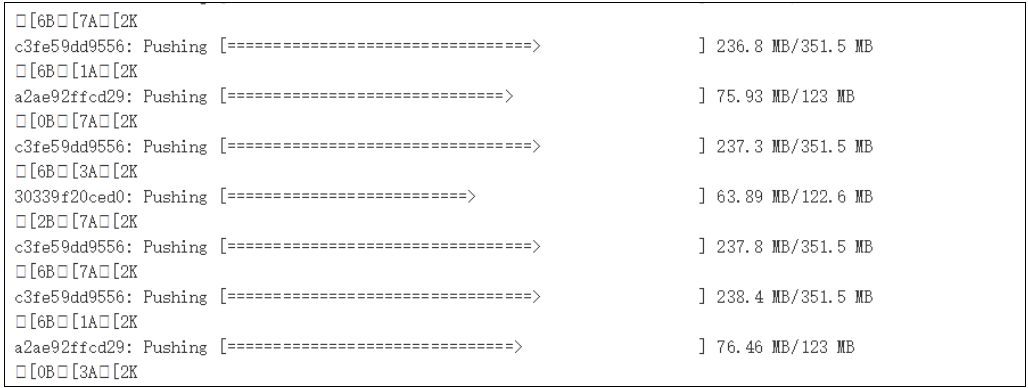

可以看到实时输出的日志

这就是镜像做好了在上传,如果你之前没有将你的本地仓库上传到服务器,会首先下载

依赖的jar包,接下来就是漫长的等待了。

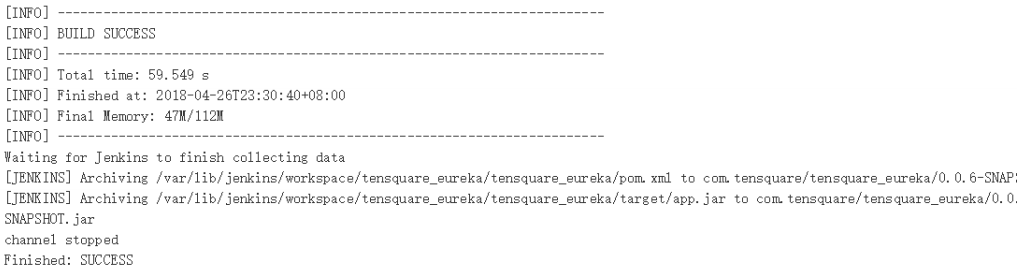

看到下面的结果就表示你已经成功了

首战告捷!哈哈,兴奋不?返回首页 看到列表

我们在浏览器看一下docker私有仓库

1 2 3 4 http://192.168.184.135:5000/v2/_catalog 会看到tensquare_eureka已经上传成功了 {"repositories":["jdk1.8","tensquare_eureka"]}

按此方法完成其它微服务的构建

16.卸载Jenkins

1 2 3 4 5 6 1、卸载rpm方式安装的jenkins: rpm -e jenkins 2、检查是否卸载成功: rpm -ql jenkins 3、彻底删除残留文件: find / -iname jenkins | xargs -n 1000 rm -rf

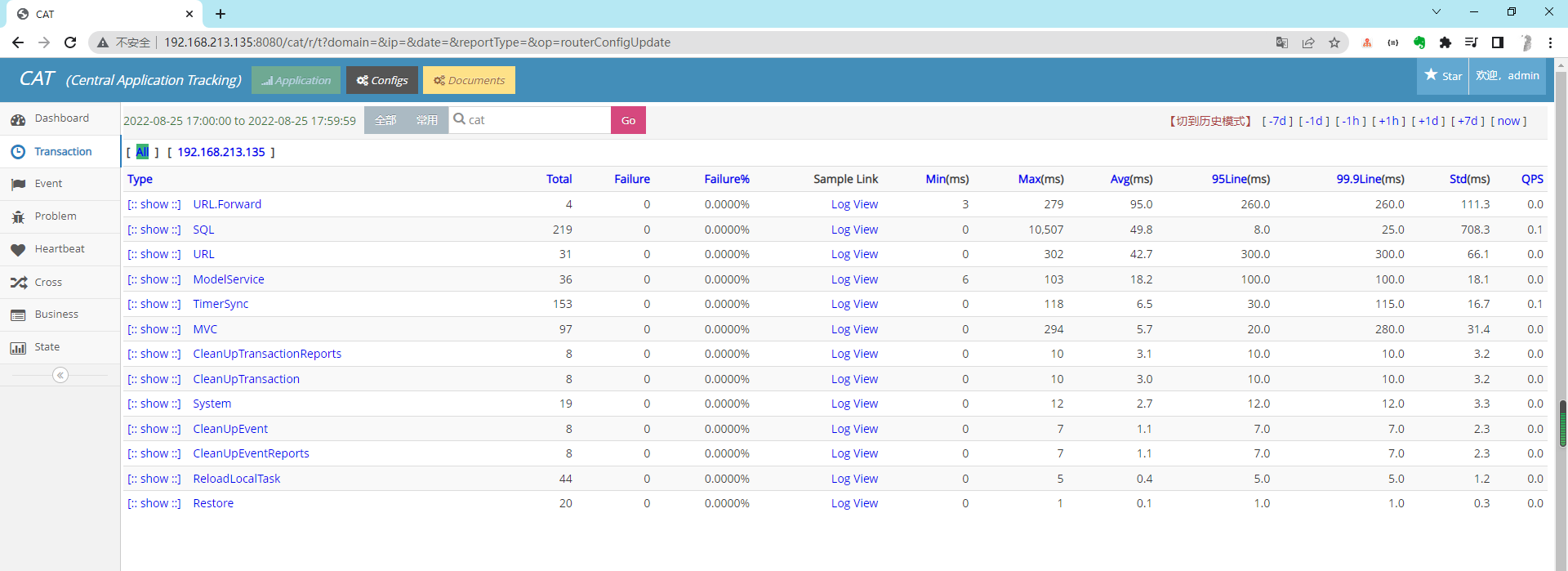

实操-安装CAT3 前提:

linux安装了jdk1.8(参考上面的实操-安装JDK)

linux安装了tomcat8(参考上面的实操-安装Tomcat)

linux-docker安装了MySQL7(我用的镜像是: centos/mysql-57-centos7)

1 docker run -di --name=cat_mysql -p 3306:3306 -e MYSQL_ROOT_PASSWORD=root centos/mysql-57-centos7

安装cat-3.0.0:

服务器创建目录

1 2 3 4 mkdir /datachmod -R 777 /data/mkdir -p /data/appdatas/cat/ mkdir -p /data/applogs/cat/

客户端配置文件

1 2 3 4 5 6 7 8 9 10 11 12 13 cd /data/appdatas/cat/ # 配置文件一 vim client.xml <?xml version="1.0" encoding="utf-8" ?> <config mode ="client" > <servers > <server ip ="192.168.213.135" port ="2280" http-port ="8080" /> </servers > </config > 注意: 2280是默认的CAT服务端接受数据的端口,不允许修改, http-port是Tomcat启动的端口,默认是8080,建议使用默认端口

服务端配置文件:配置自己独立的MySQL

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 cd /data/appdatas/cat/ # 配置文件二 vim datasources.xml <?xml version="1.0" encoding="utf-8" ?> <data-sources > <data-source id ="cat" > <maximum-pool-size > 3</maximum-pool-size > <connection-timeout > 1s</connection-timeout > <idle-timeout > 10m</idle-timeout > <statement-cache-size > 1000</statement-cache-size > <properties > <driver > com.mysql.jdbc.Driver</driver > <url > <![CDATA[jdbc:mysql://192.168.213.135:3306/cat]]></url > <user > root</user > <password > root</password > <connectionProperties > <![CDATA[useUnicode=true&characterEncoding=UTF-8&autoReconnect=true&socketTimeout=120000]]></connectionProperties > </properties > </data-source > </data-sources > 注意: 源码目录docker/下有配置文件,拷贝修改也可以

创建CAT数据库,并导入源码工程目录SCRIPT/下的SQL脚本

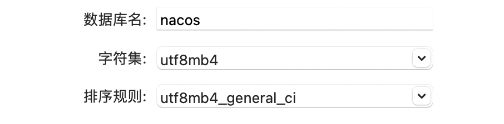

1 2 3 create database cat charset utf8mb4 collate utf8mb4_general_ci;注意1 :一套独立的CAT集群只需要一个数据库(之前碰到过个别同学在每台cat的服务端节点都安装了一个数据库) 注意2 :数据库编码使用utf8mb4,否则可能造成中文乱码等问题

源码打包(这一步可以在windows先打包好) 【直接用下载的war包的话这一步就省略了】

1 2 mvn clean install -DskipTests 注意: 打出来的jar包重命名为cat.war进行部署,此war是用jdk8,服务端请使用jdk8版本

war包部署

1 2 将war包扔到192.168.213.135的tomcat的webapps目录下,启动tomcat即可 tomcat目录/bin/startup.sh

访问

http://192.168.213.135:8080/cat/s/config?op=routerConfigUpdate

默认用户名:admin 默认密码:admin

如果访问不了,防火墙要关闭

1 firewall-cmd --add-port=8080/tcp --permanent && firewall-cmd --reload

进入配置(在网页里修改)

configs=>全局系统配置=>服务端配置中修改为: 将127.0.0.1改为实际的ip

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 <?xml version="1.0" encoding="utf-8" ?> <server-config > <server id ="default" > <properties > <property name ="local-mode" value ="false" /> <property name ="job-machine" value ="false" /> <property name ="send-machine" value ="false" /> <property name ="alarm-machine" value ="false" /> <property name ="hdfs-enabled" value ="false" /> <property name ="remote-servers" value ="192.168.213.135:8080" /> </properties > <storage local-base-dir ="/data/appdatas/cat/bucket/" max-hdfs-storage-time ="15" local-report-storage-time ="2" local-logivew-storage-time ="1" har-mode ="true" upload-thread ="5" > <hdfs id ="dump" max-size ="128M" server-uri ="hdfs://127.0.0.1/" base-dir ="/user/cat/dump" /> <harfs id ="dump" max-size ="128M" server-uri ="har://127.0.0.1/" base-dir ="/user/cat/dump" /> <properties > <property name ="hadoop.security.authentication" value ="false" /> <property name ="dfs.namenode.kerberos.principal" value ="hadoop/dev80.hadoop@testserver.com" /> <property name ="dfs.cat.kerberos.principal" value ="cat@testserver.com" /> <property name ="dfs.cat.keytab.file" value ="/data/appdatas/cat/cat.keytab" /> <property name ="java.security.krb5.realm" value ="value1" /> <property name ="java.security.krb5.kdc" value ="value2" /> </properties > </storage > <consumer > <long-config default-url-threshold ="1000" default-sql-threshold ="100" default-service-threshold ="50" > <domain name ="cat" url-threshold ="500" sql-threshold ="500" /> <domain name ="OpenPlatformWeb" url-threshold ="100" sql-threshold ="500" /> </long-config > </consumer > </server > <server id ="192.168.213.135" > <properties > <property name ="job-machine" value ="true" /> <property name ="send-machine" value ="true" /> <property name ="alarm-machine" value ="true" /> </properties > </server > </server-config >

改完点提交

configs=>全局系统配置=>客户端路由中修改为: 将127.0.0.1改为实际的ip

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 <?xml version="1.0" encoding="utf-8" ?> <router-config backup-server ="192.168.213.135" backup-server-port ="2280" > <default-server id ="192.168.213.135" weight ="1.0" port ="2280" enable ="true" /> <network-policy id ="default" title ="默认" block ="false" server-group ="default_group" > </network-policy > <server-group id ="default_group" title ="default-group" > <group-server id ="192.168.213.135" /> </server-group > <domain id ="cat" > <group id ="default" > <server id ="192.168.213.135" port ="2280" weight ="1.0" /> </group > </domain > </router-config >

改完点提交

这样就可以了

真TM的难搞有一说一,各种各样的问题,我装个链路跟踪装了N遍,裂开了。

实操-安装Nacos 1.1.4 1.获取包

1 wget https://github.com/alibaba/nacos/releases/download/1.1.4/nacos-server-1.1.4.tar.gz

2、解压安装包

1 tar -zxvf nacos-server-1.1.4.tar.gz

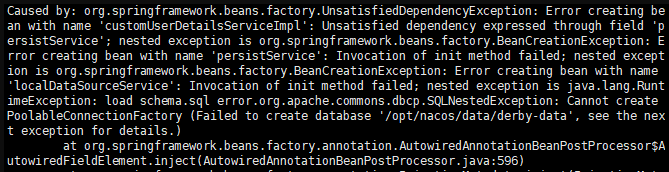

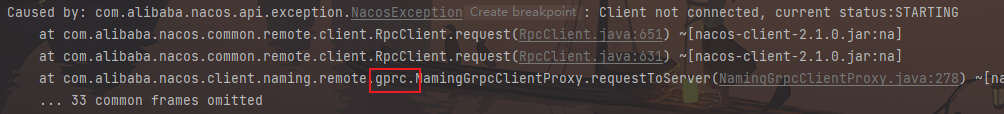

启动错误

启动日志可在nacos/logs/start.out 查看

解决办法:删除 nacos/data/derby-data 文件,重启

3、配置MySQL

1 2 3 4 5 6 7 8 9 10 11 修改配置文件,支持mysql,修改nacos/conf/application.properties文件,增加支持mysql数据源配置(目前只支持mysql),添加mysql数据源的url、用户名和密码,代码如下图: spring.datasource.platform=mysql ### Count of DB: db.num=1 ### Connect URL of DB: db.url.0=jdbc:mysql://127.0.0.1:3306/nacos_config?characterEncoding=utf8&connectTimeout=1000&socketTimeout=3000&autoReconnect=true db.user=root db.password=root

创建nacos-config数据库,并且将/config/nacos-mysql.sql执行。

4、无密码登录

开发方便些

修改Nacos配置文件application.properties

1 2 3 4 spring.security.enabled=false management.security=false security.basic.enabled=false nacos.security.ignore.urls=/**

5、单机启动

1 2 cd /usr/local/apps/nacos/bin sh startup.sh -m standalone

6、防火墙

1 2 # nacos firewall-cmd --add-port=8848/tcp --permanent && firewall-cmd --reload

访问地址为:http://127.0.0.1:8848/nacos

7、nacos开机启动配置

安装完成nacos后进行配置开机启动。

编写开机启动文件

vim /lib/systemd/system/nacos.service

文件内容如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 [Unit] Description=nacos After=network.target [Service] Type=forking ExecStart=/opt/nacos/bin/startup.sh -m standalone ExecReload=/opt/nacos/bin/shutdown.sh ExecStop=/opt/nacos/bin/shutdown.sh PrivateTmp=true [Install] WantedBy=multi-user.target

其中/opt/nacos为本机安装的nacos文件路径,-m standalone表示作为单机启动,不加的话表示集群启动,目前先作为单机启动。

设置开机启动

1 2 3 4 systemctl daemon-reload #先进行文件生效配置 systemctl enable nacos.service #设置为开机启动 systemctl start nacos.service #启动nacos服务 systemctl stop nacos.service

启动并查看是否成功

实操-安装Nacos 2.1.1 1.下载:https://github.com/alibaba/nacos/releases

2.修改config/application.yaml配置mysql

3.导入config/nacos-mysql.sql建表语句

1 mysql新建库:nacos,字符集:utf8 ,排序规则:utf8_general_ci

4.便捷启动

1 2 3 4 5 touch nacos-start.sh ./nacos/bin/startup.sh -m standalone touch nacos-stop.sh ./nacos/bin/shutdown.sh ps: 注意设置脚本执行权限

5.防火墙

1 2 3 firewall-cmd --add-port=8848/tcp --permanent && firewall-cmd --reload firewall-cmd --add-port=9848/tcp --permanent && firewall-cmd --reload firewall-cmd --add-port=9849/tcp --permanent && firewall-cmd --reload

2.0需要多开放2个端口,否则后台链接报错

实操-安装sentinel-dashboard 1.下载:https://github.com/alibaba/Sentinel/releases

2.上传并启动

1 java -Dserver.port=8090 -Dcsp.sentinel.dashboard.server=localhost:8090 -Dproject.name=sentinel-dashboard -jar sentinel-dashboard-1.8.5.jar

后台启动

1 nohup java -Dserver.port=8090 -Dcsp.sentinel.dashboard.server=localhost:8090 -Dproject.name=sentinel-dashboard -jar sentinel-dashboard-1.8.5.jar &

默认登陆账号与密码都是sentinel,也可以通过启动参数修改:

1 2 -Dsentinel.dashboard.auth.username=sentinel -Dsentinel.dashboard.auth.password=123456

3.防火墙

1 firewall-cmd --add-port=8090/tcp --permanent && firewall-cmd --reload

实操-安装Docker ⭐ 1、yum 包更新到最新

2、安装需要的软件包, yum‐util 提供yum‐config‐manager功能,另外两个是devicemapper驱动依赖的

1 yum install -y yum‐utils device-mapper-persistent-data lvm2

3、 设置yum源

1 2 3 4 5 6 yum-config-manager --add-repo https://download.docker.com/linux/centos/docker-ce.repo 或者用 # 阿里云地址(国内地址,相对更快) yum-config-manager \ --add-repo \ http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

4、 安装docker,出现输入的界面都按 y

1 2 3 4 5 yum install docker-ce docker-ce-cli containerd.io 或者用 yum install -y docker-ce # #docker-ce-cli、containerd.io 会作为依赖包被安装 或者用: sudo yum install -y docker-ce docker-ce-cli containerd.io

5、 查看docker版本,验证是否验证成功

6.配置阿里云镜像加速

1 2 3 4 5 6 7 8 mkdir -p /etc/docker vim /etc/docker/daemon.json { "registry-mirrors": ["https://xbmcwm0u.mirror.aliyuncs.com"] } systemctl daemon-reload systemctl restart docker

7.启动停止docker服务

1 2 3 4 5 6 7 8 9 10 # 启动docker服务: (安装玩要启动一下) systemctl start docker # 停止docker服务: systemctl stop docker # 重启docker服务: systemctl restart docker # 查看docker服务状态: systemctl status docker # 设置开机启动docker服务: systemctl enable docker

查找下有哪些版本可以安装

1 yum list docker-ce --showduplicates | sort -r

9.卸载docker

1 2 3 4 5 6 7 8 yum remove docker \ docker-client \ docker-client-latest \ docker-common \ docker-latest \ docker-latest-logrotate \ docker-logrotate \ docker-engine

或者很详细的:

1 2 3 4 5 6 7 8 9 10 11 12 13 # 所有下列命令包含了诸多情况,实际上可能没有,若报错文件不存在忽略即可 yum remove docker-ce \ docker-ce-cli \ containerd systemctl stop docker rm -rf /etc/systemd/system/docker.service.d rm -rf /etc/systemd/system/docker.service rm -rf /var/lib/docker rm -rf /var/run/docker rm -rf /usr/local/docker rm -rf /etc/docker rm -rf /usr/bin/docker* /usr/bin/containerd* /usr/bin/runc /usr/bin/ctr

10.开启Docker自动补全

使用docker时无法自动补全镜像名和其他参数,这样使用效率大大降低,下面是解决方法

bash-complete

1 yum install -y bash-completion

刷新文件

1 2 source /usr/share/bash-completion/completions/docker source /usr/share/bash-completion/bash_completion

测试

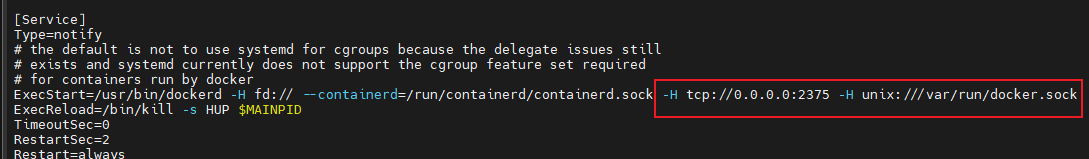

11.Docker-Maven-Plugin 通过Maven插件自动部署

1 2 vi /lib/systemd/system/docker.service 在ExecStart=后添加配置 ‐H tcp://0.0.0.0:2375 ‐H unix:///var/run/docker.sock

1 2 3 4 5 ystemctl daemon-reload //加载docker守护线程 systemctl restart docker //重启docker 关闭防火墙: firewall-cmd --add-port=2375/tcp --permanent && firewall-cmd --reload

12.拉取镜像失败

1 2 3 4 5 6 7 8 Error response from daemon: Get https://registry-1.docker.io/v2/: net/http: request canceled 报错 # 修改配置 vim /etc/resolv.conf 将 nameserver 改为 8.8.8.8 # 重启docker systemctl restart docker

实操-Docker-安装Redis 1.搜索redis镜像

2.拉取redis镜像

3.创建容器,设置端口映射

1 2 3 4 docker run -id \ -p 6379:6379 \ --name=c_redis \ redis:5.0

4.使用外部机器连接redis

1 ./redis-cli.exe -h 192.168.149.135 -p 6379

上面只是简单使用,实际上要挂载

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 mkdir -p /opt/data/docker/redis/conf/ mkdir -p /opt/data/docker/redis/data/ # 拷贝配置文件 cd /opt/data/docker/redis/conf wget http://download.redis.io/redis-stable/redis.conf # 修改配置文件 bind 127.0.0.1 #注释掉这部分,使redis可以外部访问 requirepass 你的密码#给redis设置密码 appendonly yes#redis持久化 默认是no tcp-keepalive 300 #防止出现远程主机强迫关闭了一个现有的连接的错误 默认是300 protected-mode no参数是为了禁止外网访问redis,如果启用了,则只能够通过localhost ip (127.0.0.1)访问Redis daemonize yes 默认no 为不守护进程模式,修改为yes # 当 docker 重启时,容器自动启动 docker update redis --restart=always # 创建容器 cd /opt/data/docker/redis/ docker run -d \ --privileged=true \ --restart always \ -p 6379:6379 \ --name redis \ -v $PWD/conf:/etc/redis/redis.conf \ -v $PWD/data:/data \ redis:5.0 redis-server /etc/redis/redis.conf ps:--appendonly yes #开启AOF模式

1 docker exec -it redis /bin/bash

实操-Docker-安装Mysql5.6 1.搜索mysql镜像

2.拉取mysql镜像

3.创建容器,设置端口映射、目录映射

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 # 在/root目录下创建mysql目录用于存储mysql数据信息 mkdir ~/mysql cd ~/mysql docker run -id \ -p 3306:3306 \ --name=c_mysql \ -v $PWD/conf:/etc/mysql/conf.d \ -v $PWD/logs:/logs \ -v $PWD/data:/var/lib/mysql \ -e MYSQL_ROOT_PASSWORD=root \ mysql:5.6 参数说明: -p 3307:3306:将容器的 3306 端口映射到宿主机的 3307 端口。 -v $PWD/conf:/etc/mysql/conf.d:将主机当前目录下的 conf/my.cnf 挂载到容器的 /etc/mysql/my.cnf。配置目录 -v $PWD/logs:/logs:将主机当前目录下的 logs 目录挂载到容器的 /logs。日志目录 -v $PWD/data:/var/lib/mysql :将主机当前目录下的data目录挂载到容器的 /var/lib/mysql 。数据目 录 -e MYSQL_ROOT_PASSWORD=123456:初始化 root 用户的密码。

4.进入容器,操作mysql

1 docker exec -it c_mysql /bin/bash

5.使用外部机器连接容器中的mysql

实操-Docker-安装Mysql8.0.26 1.搜索mysql镜像

2.拉取mysql镜像

1 docker pull mysql:8.0.26

3.创建容器,设置端口映射、目录映射

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 # 在/root目录下创建mysql目录用于存储mysql数据信息 mkdir /opt/data/docker/mysql cd /opt/data/docker/mysql docker run -id \ -p 3306:3306 \ --name=mysql \ -v $PWD/conf:/etc/mysql/conf.d \ -v $PWD/logs:/logs \ -v $PWD/data:/var/lib/mysql \ -e MYSQL_ROOT_PASSWORD=root \ mysql:8.0.26 参数说明: -p 3307:3306:将容器的 3306 端口映射到宿主机的 3307 端口。 -v $PWD/conf:/etc/mysql/conf.d:将主机当前目录下的 conf/my.cnf 挂载到容器的 /etc/mysql/my.cnf。配置目录 -v $PWD/logs:/logs:将主机当前目录下的 logs 目录挂载到容器的 /logs。日志目录 -v $PWD/data:/var/lib/mysql :将主机当前目录下的data目录挂载到容器的 /var/lib/mysql 。数据目 录 -e MYSQL_ROOT_PASSWORD=123456:初始化 root 用户的密码。

4.进入容器,操作mysql

1 docker exec -it c_mysql /bin/bash

5.使用外部机器连接容器中的mysql

实操-Docker-安装Tomcat 1.搜索tomcat镜像

2.拉取tomcat镜像

3.创建容器,设置端口映射、目录映射

1 2 3 4 5 6 7 8 9 10 11 12 13 # 在/root目录下创建tomcat目录用于存储tomcat数据信息 mkdir /opt/data/docker/tomcat cd /opt/data/docker/tomcat docker run -id \ -p 8080:8080 \ --name=tomcat \ -v $PWD:/usr/local/tomcat/webapps \ tomcat 参数说明: -p 8080:8080:将容器的8080端口映射到主机的8080端口 -v $PWD:/usr/local/tomcat/webapps:将主机中当前目录挂载到容器的webapps

4.webapps复制文件

1 2 3 4 5 # 进入tomcat容器 docker exec -it tomcat /bin/bash # 复制文件 cp -r webapps.dist/. webapps exit

4.使用外部机器访问tomcat

实操-Docker-安装Nginx 1.搜索nginx镜像

2.拉取nginx镜像

3.创建容器,设置端口映射、目录映射

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 # 在/root目录下创建nginx目录用于存储nginx数据信息 mkdir /opt/data/docker/nginx cd /opt/data/docker/nginx mkdir conf cd conf # 在~/nginx/conf/下创建nginx.conf文件,粘贴下面内容 vim nginx.conf ------------------ nginx.conf ------------------- user nginx; worker_processes 1; error_log /var/log/nginx/error.log warn; pid /var/run/nginx.pid; events { worker_connections 1024; } http { include /etc/nginx/mime.types; default_type application/octet‐stream; log_format main '$remote_addr ‐ $remote_user [$time_local] "$request" ' '$status $body_bytes_sent "$http_referer" ' '"$http_user_agent" "$http_x_forwarded_for"'; access_log /var/log/nginx/access.log main; sendfile on; #tcp_nopush on; keepalive_timeout 65; #gzip on; include /etc/nginx/conf.d/*.conf; }

创建首页index.html,放到nginx/html目录下

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 <!DOCTYPE html > <html > <head > <title > Welcome to nginx!</title > <style > html { color-scheme : light dark; }body { width : 35em ; margin : 0 auto;font-family : Tahoma, Verdana, Arial, sans-serif; }</style > </head > <body > <h1 > Welcome to nginx!</h1 > <p > If you see this page, the nginx web server is successfully installed andworking. Further configuration is required.</p > <p > For online documentation and support please refer to<a href ="http://nginx.org/" > nginx.org</a > .<br /> Commercial support is available at <a href ="http://nginx.com/" > nginx.com</a > .</p > <p > <em > Thank you for using nginx.</em > </p > </body > </html >

4.启动容器

1 2 3 4 5 6 7 8 9 10 11 12 13 14 # 到nginx,不然$PWD 受影响 cd /opt/data/docker/nginx docker run -id \ -p 80:80 \ --name=nginx \ -v $PWD/conf/nginx.conf:/etc/nginx/nginx.conf \ -v $PWD/logs:/var/log/nginx \ -v $PWD/html:/usr/share/nginx/html \ nginx 参数说明: -p80:80:将容器的80端口映射到宿主机的80端口。 -v$ PWD/conf/nginx.conf:/etc/nginx/nginx.conf:将主机当前目录下的/conf/nginx.conf挂载到容器的:/etc/nginx/nginx.conf。配置目录 -v$ PWD/logs:/var/log/nginx:将主机当前目录下的logs目录挂载到容器的/var/log/nginx。日志目录

5.使用外部机器访问nginx

1 2 # 如果访问不了,看是否是防火墙的原因 firewall-cmd --add-port=80/tcp --permanent && firewall-cmd --reload

实操-Docker-安装MongoDB 1.搜索mongo镜像

2.拉取mongo镜像

3.启动容器

1 docker run -di --name=c_mongo -p 27017:27017 mongo

远程登录

实操-Docker-安装ElasticSearch 1.搜索mongo镜像

1 docker search elasticsearch:5.6.8

2.拉取mongo镜像

1 docker pull elasticsearch:5.6.8

3.启动容器

1 docker run -di --name=elasticsearch -p 9200:9200 -p 9300:9300 elasticsearch:5.6.8

http://192.168.25.129:9200/

4.拷贝配置文件到宿主机

1 docker cp elasticsearch:/usr/share/elasticsearch/config/elasticsearch.yml /usr/share/elasticsearch.yml

5.停止和删除原来创建的容器

6.重新创建容器

1 docker run -di --name=tensquare_elasticsearch -p 9200:9200 -p 9300:9300 -v /usr/share/elasticsearch.yml:/usr/share/elasticsearch/config/elasticsearch.yml elasticsearch:5.6.8

修改/usr/share/elasticsearch.yml 将 transport.host: 0.0.0.0 前的#去掉后保

1 2 3 4 5 6 7 8 9 修改/etc/security/limits.conf ,追加内容 * soft nofile 65536 * hard nofile 65536 修改/etc/sysctl.conf,追加内容 vm.max_map_count=655360 sysctl -p

7.重启

8.IK分词器安装

拷贝宿主机的ik目录到容器里

1 docker cp ik elasticsearch:/usr/share/elasticsearch/plugins/

重新启动,即可加载IK分词器

9.HEAD插件安装

1)修改/usr/share/elasticsearch.yml ,添加允许跨域配置

1 2 http.cors.enabled: true http.cors.allow-origin: "*"

重新启动elasticseach容器

10.下载head镜像

1 docker pull mobz/elasticsearch-head:5

创建head容器

1 docker run -di --name=elasticsearch_head -p 9100:9100 mobz/elasticsearch-head:5

实操-Docker-安装Nacos1.4.1 1、拉取镜像

1 docker pull nacos/nacos-server:1.4.1

2、创建数据库

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 178 179 180 181 182 183 184 185 186 187 188 189 190 191 192 193 194 195 196 197 198 CREATE TABLE `config_info` ( `id` bigint (20 ) NOT NULL AUTO_INCREMENT COMMENT 'id' , `data_id` varchar (255 ) NOT NULL COMMENT 'data_id' , `group_id` varchar (255 ) DEFAULT NULL , `content` longtext NOT NULL COMMENT 'content' , `md5` varchar (32 ) DEFAULT NULL COMMENT 'md5' , `gmt_create` datetime NOT NULL DEFAULT CURRENT_TIMESTAMP COMMENT '创建时间' , `gmt_modified` datetime NOT NULL DEFAULT CURRENT_TIMESTAMP COMMENT '修改时间' , `src_user` text COMMENT 'source user' , `src_ip` varchar (50 ) DEFAULT NULL COMMENT 'source ip' , `app_name` varchar (128 ) DEFAULT NULL , `tenant_id` varchar (128 ) DEFAULT '' COMMENT '租户字段' , `c_desc` varchar (256 ) DEFAULT NULL , `c_use` varchar (64 ) DEFAULT NULL , `effect` varchar (64 ) DEFAULT NULL , `type` varchar (64 ) DEFAULT NULL , `c_schema` text, PRIMARY KEY (`id`), UNIQUE KEY `uk_configinfo_datagrouptenant` (`data_id`,`group_id`,`tenant_id`) ) ENGINE= InnoDB DEFAULT CHARSET= utf8 COLLATE = utf8_bin COMMENT= 'config_info' ; CREATE TABLE `config_info_aggr` ( `id` bigint (20 ) NOT NULL AUTO_INCREMENT COMMENT 'id' , `data_id` varchar (255 ) NOT NULL COMMENT 'data_id' , `group_id` varchar (255 ) NOT NULL COMMENT 'group_id' , `datum_id` varchar (255 ) NOT NULL COMMENT 'datum_id' , `content` longtext NOT NULL COMMENT '内容' , `gmt_modified` datetime NOT NULL COMMENT '修改时间' , `app_name` varchar (128 ) DEFAULT NULL , `tenant_id` varchar (128 ) DEFAULT '' COMMENT '租户字段' , PRIMARY KEY (`id`), UNIQUE KEY `uk_configinfoaggr_datagrouptenantdatum` (`data_id`,`group_id`,`tenant_id`,`datum_id`) ) ENGINE= InnoDB DEFAULT CHARSET= utf8 COLLATE = utf8_bin COMMENT= '增加租户字段' ; CREATE TABLE `config_info_beta` ( `id` bigint (20 ) NOT NULL AUTO_INCREMENT COMMENT 'id' , `data_id` varchar (255 ) NOT NULL COMMENT 'data_id' , `group_id` varchar (128 ) NOT NULL COMMENT 'group_id' , `app_name` varchar (128 ) DEFAULT NULL COMMENT 'app_name' , `content` longtext NOT NULL COMMENT 'content' , `beta_ips` varchar (1024 ) DEFAULT NULL COMMENT 'betaIps' , `md5` varchar (32 ) DEFAULT NULL COMMENT 'md5' , `gmt_create` datetime NOT NULL DEFAULT CURRENT_TIMESTAMP COMMENT '创建时间' , `gmt_modified` datetime NOT NULL DEFAULT CURRENT_TIMESTAMP COMMENT '修改时间' , `src_user` text COMMENT 'source user' , `src_ip` varchar (50 ) DEFAULT NULL COMMENT 'source ip' , `tenant_id` varchar (128 ) DEFAULT '' COMMENT '租户字段' , PRIMARY KEY (`id`), UNIQUE KEY `uk_configinfobeta_datagrouptenant` (`data_id`,`group_id`,`tenant_id`) ) ENGINE= InnoDB DEFAULT CHARSET= utf8 COLLATE = utf8_bin COMMENT= 'config_info_beta' ; CREATE TABLE `config_info_tag` ( `id` bigint (20 ) NOT NULL AUTO_INCREMENT COMMENT 'id' , `data_id` varchar (255 ) NOT NULL COMMENT 'data_id' , `group_id` varchar (128 ) NOT NULL COMMENT 'group_id' , `tenant_id` varchar (128 ) DEFAULT '' COMMENT 'tenant_id' , `tag_id` varchar (128 ) NOT NULL COMMENT 'tag_id' , `app_name` varchar (128 ) DEFAULT NULL COMMENT 'app_name' , `content` longtext NOT NULL COMMENT 'content' , `md5` varchar (32 ) DEFAULT NULL COMMENT 'md5' , `gmt_create` datetime NOT NULL DEFAULT CURRENT_TIMESTAMP COMMENT '创建时间' , `gmt_modified` datetime NOT NULL DEFAULT CURRENT_TIMESTAMP COMMENT '修改时间' , `src_user` text COMMENT 'source user' , `src_ip` varchar (50 ) DEFAULT NULL COMMENT 'source ip' , PRIMARY KEY (`id`), UNIQUE KEY `uk_configinfotag_datagrouptenanttag` (`data_id`,`group_id`,`tenant_id`,`tag_id`) ) ENGINE= InnoDB DEFAULT CHARSET= utf8 COLLATE = utf8_bin COMMENT= 'config_info_tag' ; CREATE TABLE `config_tags_relation` ( `id` bigint (20 ) NOT NULL COMMENT 'id' , `tag_name` varchar (128 ) NOT NULL COMMENT 'tag_name' , `tag_type` varchar (64 ) DEFAULT NULL COMMENT 'tag_type' , `data_id` varchar (255 ) NOT NULL COMMENT 'data_id' , `group_id` varchar (128 ) NOT NULL COMMENT 'group_id' , `tenant_id` varchar (128 ) DEFAULT '' COMMENT 'tenant_id' , `nid` bigint (20 ) NOT NULL AUTO_INCREMENT, PRIMARY KEY (`nid`), UNIQUE KEY `uk_configtagrelation_configidtag` (`id`,`tag_name`,`tag_type`), KEY `idx_tenant_id` (`tenant_id`) ) ENGINE= InnoDB DEFAULT CHARSET= utf8 COLLATE = utf8_bin COMMENT= 'config_tag_relation' ; CREATE TABLE `group_capacity` ( `id` bigint (20 ) unsigned NOT NULL AUTO_INCREMENT COMMENT '主键ID' , `group_id` varchar (128 ) NOT NULL DEFAULT '' COMMENT 'Group ID,空字符表示整个集群' , `quota` int (10 ) unsigned NOT NULL DEFAULT '0' COMMENT '配额,0表示使用默认值' , `usage` int (10 ) unsigned NOT NULL DEFAULT '0' COMMENT '使用量' , `max_size` int (10 ) unsigned NOT NULL DEFAULT '0' COMMENT '单个配置大小上限,单位为字节,0表示使用默认值' , `max_aggr_count` int (10 ) unsigned NOT NULL DEFAULT '0' COMMENT '聚合子配置最大个数,,0表示使用默认值' , `max_aggr_size` int (10 ) unsigned NOT NULL DEFAULT '0' COMMENT '单个聚合数据的子配置大小上限,单位为字节,0表示使用默认值' , `max_history_count` int (10 ) unsigned NOT NULL DEFAULT '0' COMMENT '最大变更历史数量' , `gmt_create` datetime NOT NULL DEFAULT CURRENT_TIMESTAMP COMMENT '创建时间' , `gmt_modified` datetime NOT NULL DEFAULT CURRENT_TIMESTAMP COMMENT '修改时间' , PRIMARY KEY (`id`), UNIQUE KEY `uk_group_id` (`group_id`) ) ENGINE= InnoDB DEFAULT CHARSET= utf8 COLLATE = utf8_bin COMMENT= '集群、各Group容量信息表' ; CREATE TABLE `his_config_info` ( `id` bigint (64 ) unsigned NOT NULL , `nid` bigint (20 ) unsigned NOT NULL AUTO_INCREMENT, `data_id` varchar (255 ) NOT NULL , `group_id` varchar (128 ) NOT NULL , `app_name` varchar (128 ) DEFAULT NULL COMMENT 'app_name' , `content` longtext NOT NULL , `md5` varchar (32 ) DEFAULT NULL , `gmt_create` datetime NOT NULL DEFAULT CURRENT_TIMESTAMP , `gmt_modified` datetime NOT NULL DEFAULT CURRENT_TIMESTAMP , `src_user` text, `src_ip` varchar (50 ) DEFAULT NULL , `op_type` char (10 ) DEFAULT NULL , `tenant_id` varchar (128 ) DEFAULT '' COMMENT '租户字段' , PRIMARY KEY (`nid`), KEY `idx_gmt_create` (`gmt_create`), KEY `idx_gmt_modified` (`gmt_modified`), KEY `idx_did` (`data_id`) ) ENGINE= InnoDB DEFAULT CHARSET= utf8 COLLATE = utf8_bin COMMENT= '多租户改造' ; CREATE TABLE `tenant_capacity` ( `id` bigint (20 ) unsigned NOT NULL AUTO_INCREMENT COMMENT '主键ID' , `tenant_id` varchar (128 ) NOT NULL DEFAULT '' COMMENT 'Tenant ID' , `quota` int (10 ) unsigned NOT NULL DEFAULT '0' COMMENT '配额,0表示使用默认值' , `usage` int (10 ) unsigned NOT NULL DEFAULT '0' COMMENT '使用量' , `max_size` int (10 ) unsigned NOT NULL DEFAULT '0' COMMENT '单个配置大小上限,单位为字节,0表示使用默认值' , `max_aggr_count` int (10 ) unsigned NOT NULL DEFAULT '0' COMMENT '聚合子配置最大个数' , `max_aggr_size` int (10 ) unsigned NOT NULL DEFAULT '0' COMMENT '单个聚合数据的子配置大小上限,单位为字节,0表示使用默认值' , `max_history_count` int (10 ) unsigned NOT NULL DEFAULT '0' COMMENT '最大变更历史数量' , `gmt_create` datetime NOT NULL DEFAULT CURRENT_TIMESTAMP COMMENT '创建时间' , `gmt_modified` datetime NOT NULL DEFAULT CURRENT_TIMESTAMP COMMENT '修改时间' , PRIMARY KEY (`id`), UNIQUE KEY `uk_tenant_id` (`tenant_id`) ) ENGINE= InnoDB DEFAULT CHARSET= utf8 COLLATE = utf8_bin COMMENT= '租户容量信息表' ; CREATE TABLE `tenant_info` ( `id` bigint (20 ) NOT NULL AUTO_INCREMENT COMMENT 'id' , `kp` varchar (128 ) NOT NULL COMMENT 'kp' , `tenant_id` varchar (128 ) default '' COMMENT 'tenant_id' , `tenant_name` varchar (128 ) default '' COMMENT 'tenant_name' , `tenant_desc` varchar (256 ) DEFAULT NULL COMMENT 'tenant_desc' , `create_source` varchar (32 ) DEFAULT NULL COMMENT 'create_source' , `gmt_create` bigint (20 ) NOT NULL COMMENT '创建时间' , `gmt_modified` bigint (20 ) NOT NULL COMMENT '修改时间' , PRIMARY KEY (`id`), UNIQUE KEY `uk_tenant_info_kptenantid` (`kp`,`tenant_id`), KEY `idx_tenant_id` (`tenant_id`) ) ENGINE= InnoDB DEFAULT CHARSET= utf8 COLLATE = utf8_bin COMMENT= 'tenant_info' ; CREATE TABLE `users` ( `username` varchar (50 ) NOT NULL PRIMARY KEY, `password` varchar (500 ) NOT NULL , `enabled` boolean NOT NULL ); CREATE TABLE `roles` ( `username` varchar (50 ) NOT NULL , `role` varchar (50 ) NOT NULL , UNIQUE INDEX `idx_user_role` (`username` ASC , `role` ASC ) USING BTREE ); CREATE TABLE `permissions` ( `role` varchar (50 ) NOT NULL , `resource` varchar (255 ) NOT NULL , `action` varchar (8 ) NOT NULL , UNIQUE INDEX `uk_role_permission` (`role`,`resource`,`action`) USING BTREE ); INSERT INTO users (username, password, enabled) VALUES ('nacos' , '$2a$10$EuWPZHzz32dJN7jexM34MOeYirDdFAZm2kuWj7VEOJhhZkDrxfvUu' , TRUE ); INSERT INTO roles (username, role) VALUES ('nacos' , 'ROLE_ADMIN' );

3、创建容器

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 docker run \ -d --name c_nacos \ -p 8848:8848 \ -p 9848:9848 \ -p 9849:9849 \ --restart=always \ -e JVM_XMS=256m \ -e JVM_XMX=256m \ -e MODE=standalone \ -e SPRING_DATASOURCE_PLATFORM=mysql \ -e MYSQL_SERVICE_HOST=192.168.88.88 \ -e MYSQL_SERVICE_PORT=3306 \ -e MYSQL_SERVICE_DB_NAME=nacos \ -e MYSQL_SERVICE_USER=root \ -e MYSQL_SERVICE_PASSWORD=root \ -e MYSQL_SERVICE_DB_PARAM="characterEncoding=utf8&connectTimeout=1000&socketTimeout=3000&autoReconnect=true&serverTimezone=Asia/Shanghai" \ nacos/nacos-server:1.4.1 这样服务注册的ip才对 # 访问地址 默认账号密码是nacos/nacos http://ip:8848/nacos

实操-Docker-安装gogs (1)下载镜像

(2)创建容器

1 2 docker run -di --name=c_gogs -p 10022:22 -p 3000:3000 -v /root/docker_volumn/gogs:/data gogs/gogs # gogs的/data目录挂载到宿主机的/root/docker_volumn/gogs目录

注册一下用户,创建仓库

实操-Docker-安装Jenkins 搜索镜像

拉取Jenkins镜像

1 docker pull jenkins/jenkins:lts

生成Jenkins的docker容器

1 2 3 4 5 6 7 8 9 10 11 mkdir /opt/data/docker/jenkins cd /opt/data/docker/jenkins docker run -d \ -uroot \ -p 9095:8080 \ -p 50000:50000 \ --name jenkins \ -v $PWD:/var/jenkins \ -v /etc/localtime:/etc/localtime \ jenkins/jenkins:lts

参数说明

命令

描述

-d

后台运行容器,并返回容器ID

-uroot

使用 root 身份进入容器,推荐加上,避免容器内执行某些命令时报权限错误

-p 9095:8080

将容器内8080端口映射至宿主机9095端口,这个是访问jenkins的端口

-p 50000:50000

将容器内50000端口映射至宿主机50000端口

–name jenkins

设置容器名称为jenkins

-v /home/jenkins_home:/var/jenkins_home

:/var/jenkins_home目录为容器jenkins工作目录,我们将硬盘上的一个目录挂载到这个位置,方便后续更新镜像后继续使用原来的工作目录

-v /etc/localtime:/etc/localtime

让容器使用和服务器同样的时间设置

jenkins/jenkins

镜像的名称,这里也可以写镜像ID

这个命令执行完后结尾处会有一个提示,提示了初始密码和初始密码文件路径。可以先复制初始密码,为后面使用

1 2 3 # 查看日志 docker logs jenkins # 拿到初始化密码: 16bbb3a596ee4f2cb41ccf3a288f1dfe

启动容器

通过ip地址:Jenkins容器端口来访问Jenkins。例如http://192.168.30.142:8080/。

如果上面没有记住密码,可以手动查看密码