【数据存储系列】手牵手学习MySQL

互联网环境,数据是第一生产力,数据的存储至关重要,而MySQL是大多数普通业务的第一选择。

🔖MySql基础

数据库概述

数据库的介绍

目前来说如果我们要进行数据存储,有几种方式:

- 我们可以使用集合等方式将数据保存在内存中,但是数据不能持久化保存,断电/程序退出,数据就清除了

- 我们还可以将数据保存在普通文件中,可以持久化保存,但是查找,增加,修改,删除数据比较麻烦,效率低

所以我们需要一个既可以持久化保存数据又可以方便操作的地方来存储数据,这就是我们接下来要给大家介绍的数据库

什么是数据库

数据库(DataBase,DB):指长期保存在计算机的存储设备(硬盘)上,按照一定规则组织起来,可以被各种用户或应用共享的数据集合. 还是以文件的方式存在服务器的电脑上的。

说白了就是数据的仓库, 用来持久化保存数据的.

数据的存储方式

数据保存在内存

1

2

3

4int[] arr = new int[]{1, 2, 3, 4};

ArrayList<Integer>list = new ArrayList<Integer>();

list.add(1);

list.add(2);new出来的对象存储在堆中.堆是内存中的一小块空间

优点:内存速度快 缺点:断电/程序退出,数据就清除了.内存价格贵

数据保存在普通文件 优点:永久保存 缺点:查找,增加,修改,删除数据比较麻烦,效率低

数据保存在数据库 优点:永久保存,通过SQL语句比较方便的操作数据库

数据库的优点

数据库是按照特定的格式将数据存储在文件中,通过SQL语句可以方便的对大量数据进行增、删、改、查操作,数据库是对大量的信息进行管理的高效的解决方案。

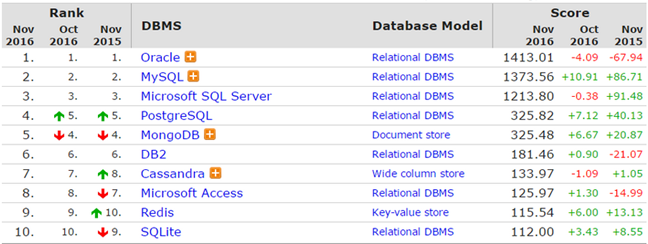

常见的关系型数据库

- MySql(最流行中型数据库):开源免费的数据库,中小型的数据库,已经被Oracle收购了。MySql6.x版本也开始收费。后来Sun公司收购了MySql,而Sun公司又被Oracle收购

- Oracle(老大,最挣钱的数据库):收费的大型数据库.Oracle公司的产品.Oracle收购SUN公司,收购MySql.

- DB2:IBM公司的数据库产品,收费的.银行系统中.

- SQLServer(Windows上最好的数据库):MS公司.收费的中型的数据库.

- SyBase:已经淡出历史舞台.提供了一个非常专业数据建模的工具PowerDesigner.

- SQLite(最流行的嵌入式数据库): 嵌入式的小型数据库,应用在手机端.

- PostgreSQL: (功能最强大的开源数据库)

常用数据库:MYSQL,Oracle 在web应用中,使用的最多的就是MySQL数据库,原因如下:

- 开源、免费

- 功能足够强大,足以应付web应用开发(最高支持千万级别的并发访问

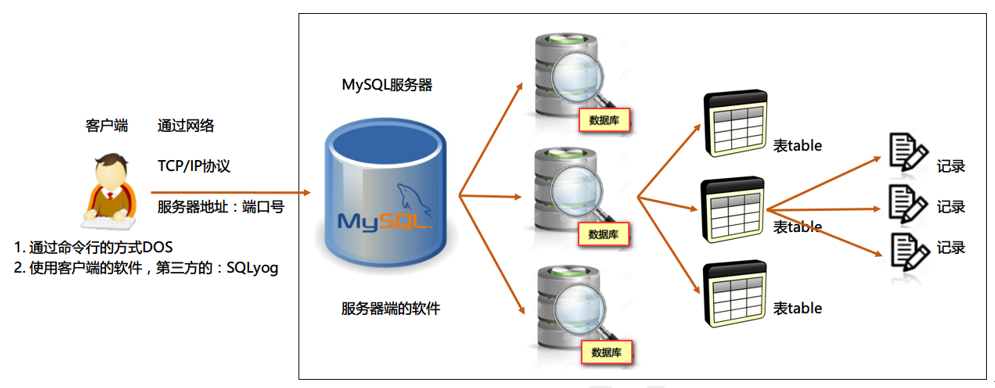

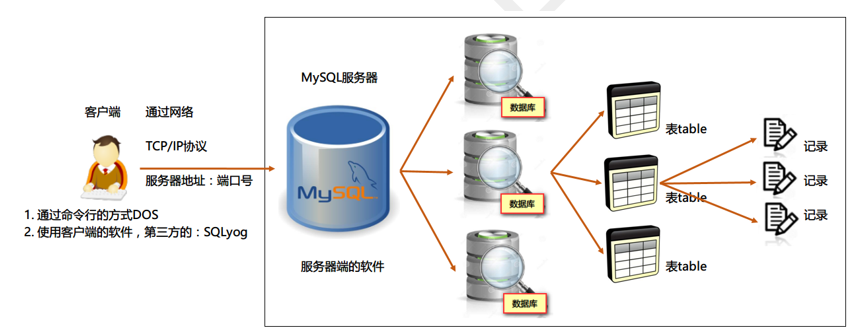

数据库结构

数据库是用来存储数据的,那么到底通过什么样的方式来存的. 结构是怎么样的呢?

数据库管理程序(DBMS)可以管理多个数据库,一般开发人员会针对每一个应用创建一个数据库。为保存应用中实体的数据,一般会在数据库创建多个表,以保存程序中实体的数据。

数据库管理系统、数据库和表的关系如图所示:

- 1.一般情况下,一个系统(软件,项目) 就设计一个数据库;

- 2.一个数据库里面有多(>=1)张表. 一个实体(java类)对应一张表

- 3.一张表里面有多条(>=1)记录, 一个对象对应一条记录

mysql简介

特点

- ①MySQL数据库是用C和C++语言编写的,以保证源码的可移植性

- ②支持多个操作系统例如:Windows、Linux、Mac OS等等

- ③支持多线程,可以充分的利用CPU资源

- ④为多种编程语言提供API,包括C语言,Java,PHP。Python语言等

- ⑤MySQL优化了SQL算法,有效的提高了查询速度

- ⑥MySQL开放源代码且无版权制约,自主性强、使用成本低。

- ⑧MySQL历史悠久、社区及用户非常活跃,遇到问题,可以很快获取到帮助。

版本

针对不同的用户,MySQL分为两种不同的版本:

- MySQL Community Server :社区版本,免费,但是Mysql不提供官方技术支持。

- MySQL Enterprise Edition :商业版,该版本是收费版本,可以试用30天,官方提供技术支持

- MySQL Cluster :集群版,开源免费,可将几个MySQL Server封装成一个Server。

- MySQL Cluster CGE :高级集群版,需付费。

- MySQL Workbench(GUI TOOL):一款专为MySQL设计的ER/数据库建模工具。MySQL Workbench又分为两个版本,分别是社区版(MySQL Workbench OSS)、商用版(MySQL Workbench SE)。

MySQL的命名机制使用由3个数字和一个后缀组成的版本号。例如,像mysql-8.0.26的版本号这样解释:、

- 第1个数字(8)是主版本号,描述了文件格式。所有版本5的发行都有相同的文件格式。

- 第2个数字(0)是发行级别。主版本号和发行级别组合到一起便构成了发行序列号。

- 第3个数字(26)是在此发行系列的版本号,随每个新分发版递增。

目前,My SQL的最新版本为MySQL 8.0。

数据库的安装,卸载,启动,登录

实操-MySql的安装

我们要使用MySql数据库,就需要先安装. 如果第一次安装失败了,就需要卸载,再安装.

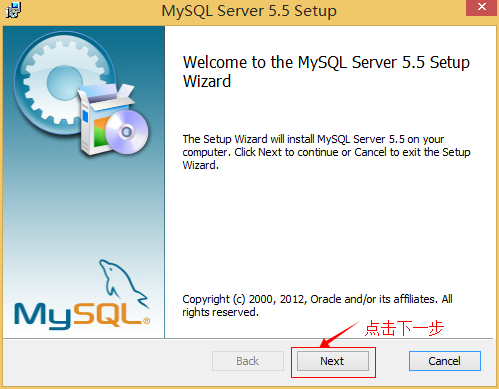

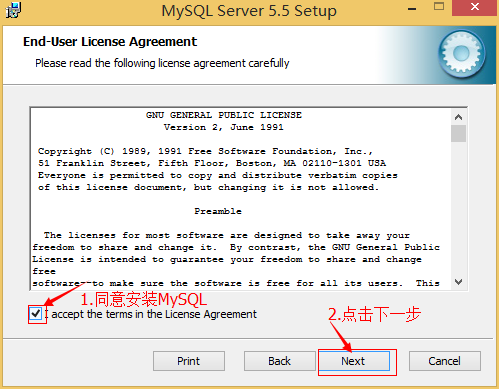

一、MYSQL的安装

1、打开下载的mysql安装文件mysql-5.5.27-win32.zip,双击解压缩,运行“setup.exe”。

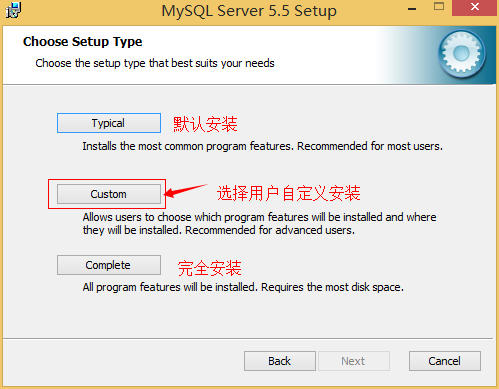

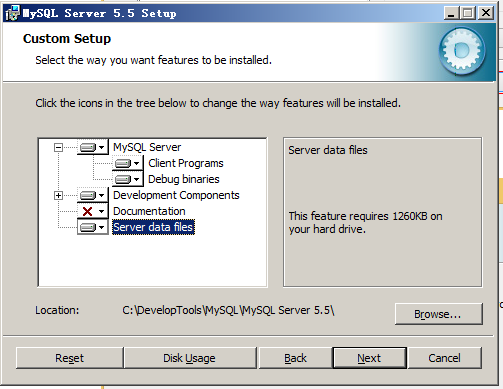

2、选择安装类型,有“Typical(默认)”、“Complete(完全)”、“Custom(用户自定义)”三个选项,选择“Custom”,按“next”键继续。

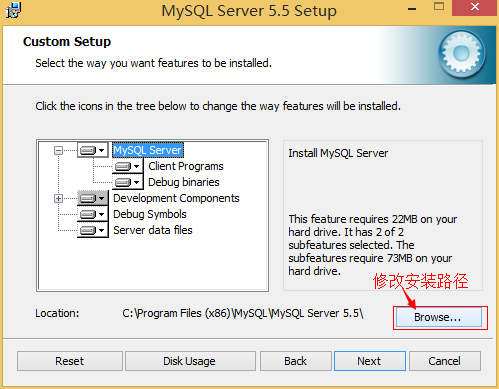

3、点选“Browse”,手动指定安装目录。

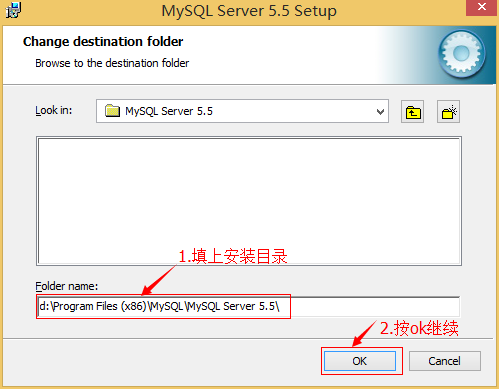

4、填上安装目录,我的是“F:\Server\MySQL\MySQL Server 5.0”,也建议不要放在与操作系统同一分区,这样可以防止系统备份还原的时候,数据被清空。按“OK”继续。

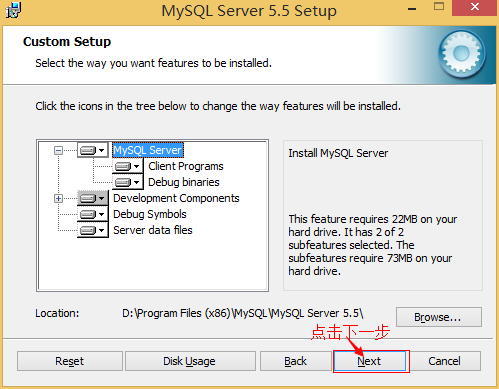

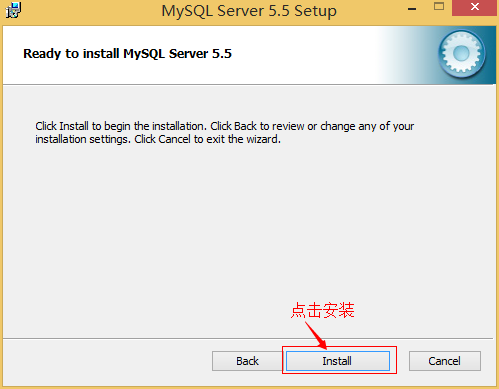

确认一下先前的设置,如果有误,按“Back”返回重做。按“Install”开始安装。

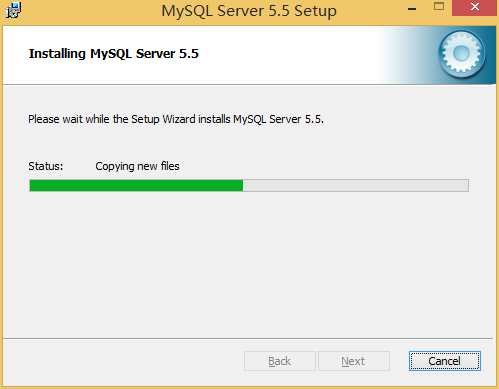

5、正在安装中,请稍候,直到出现下面的界面, 则完成MYSQL的安装

二、MYSQL的配置

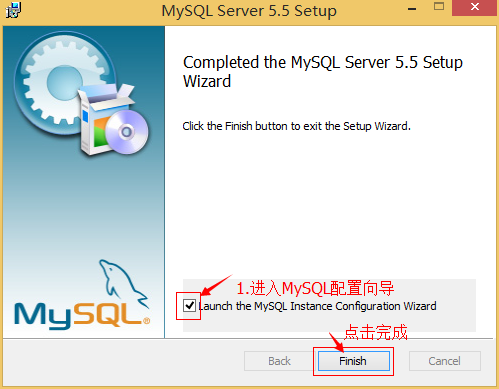

1、安装完成了,出现如下界面将进入mysql配置向导

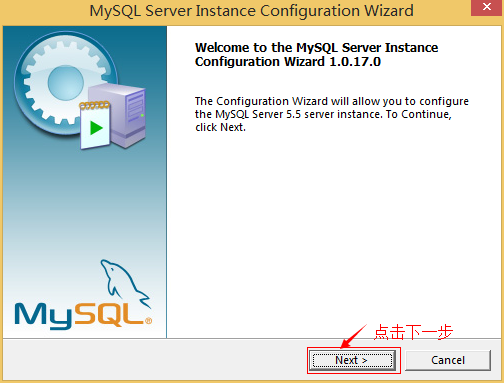

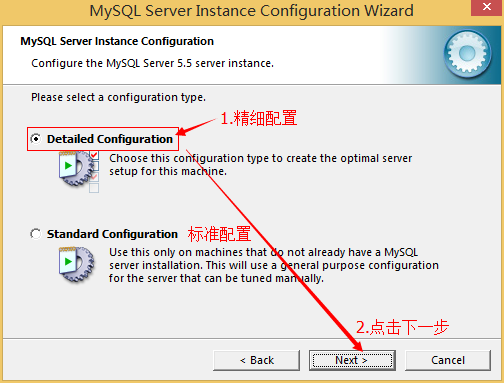

2、选择配置方式,“Detailed Configuration(手动精确配置)”、“Standard Configuration(标准配置)”,我们选择“Detailed Configuration”,方便熟悉配置过程。

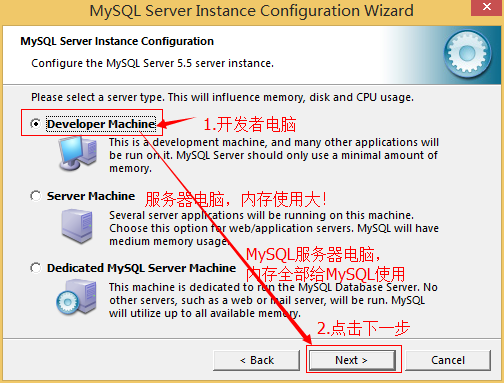

3、选择服务器类型,“Developer Machine(开发测试类,mysql占用很少资源)”、“Server Machine(服务器类型,mysql占用较多资源)”、“Dedicated MySQL Server Machine(专门的数据库服务器,mysql占用所有可用资源)”

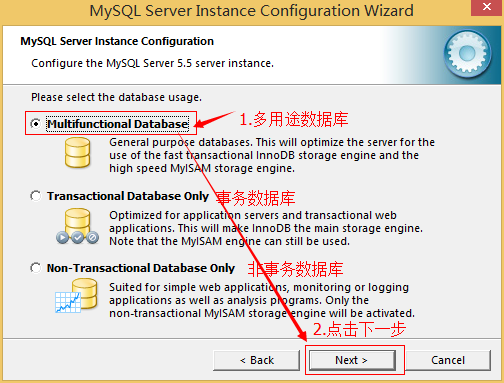

4、选择mysql数据库的大致用途,“Multifunctional Database(通用多功能型,好)”、“Transactional Database Only(服务器类型,专注于事务处理,一般)”、“Non-Transactional Database Only(非事务处理型,较简单,主要做一些监控、记数用,对MyISAM数据类型的支持仅限于non-transactional),按“Next”继续。

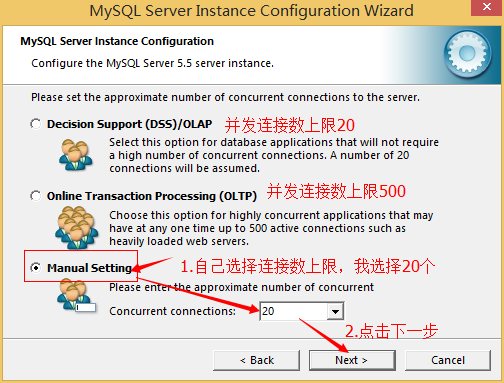

5、选择网站并发连接数,同时连接的数目,“Decision Support(DSS)/OLAP(20个左右)”、“Online Transaction Processing(OLTP)(500个左右)”、“Manual Setting(手动设置,自己输一个数)”。

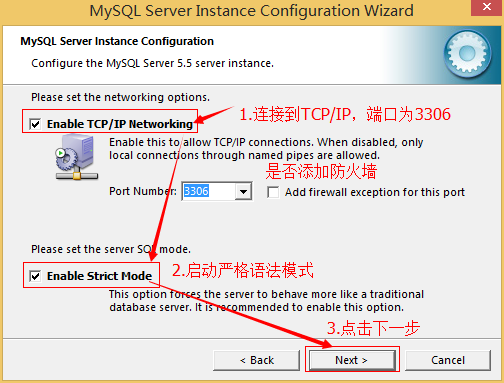

6、是否启用TCP/IP连接,设定端口,如果不启用,就只能在自己的机器上访问mysql数据库了,在这个页面上,您还可以选择“启用标准模式”(Enable Strict Mode),这样MySQL就不会允许细小的语法错误。如果是新手,建议您取消标准模式以减少麻烦。但熟悉MySQL以后,尽量使用标准模式,因为它可以降低有害数据进入数据库的可能性。按“Next”继续

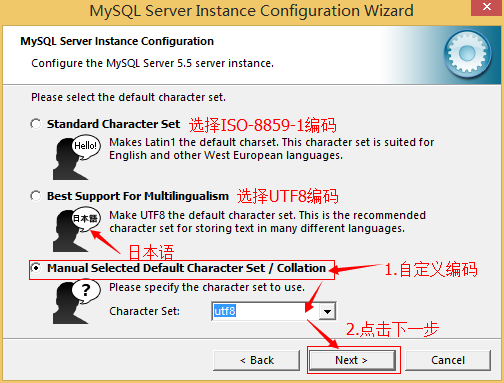

7、就是对mysql默认数据库语言编码进行设置(重要),一般选UTF-8,按 “Next”继续。

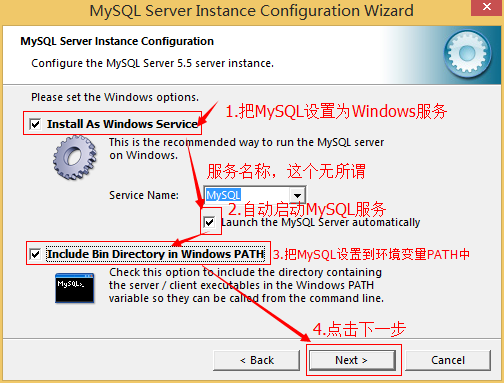

8、选择是否将mysql安装为windows服务,还可以指定Service Name(服务标识名称),是否将mysql的bin目录加入到Windows PATH(加入后,就可以直接使用bin下的文件,而不用指出目录名,比如连接,“mysql.exe -uusername -ppassword;”就可以了,不用指出mysql.exe的完整地址,很方便),我这里全部打上了勾,Service Name不变。按“Next”继续。

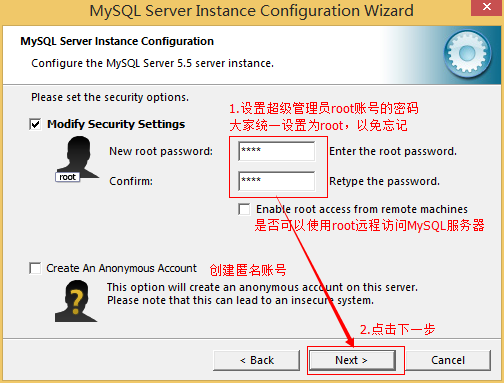

9、询问是否要修改默认root用户(超级管理)的密码。“Enable root access from remote machines(是否允许root用户在其它的机器上登陆,如果要安全,就不要勾上,如果要方便,就勾上它)”。最后“Create An Anonymous Account(新建一个匿名用户,匿名用户可以连接数据库,不能操作数据,包括查询)”,一般就不用勾了,设置完毕,按“Next”继续。

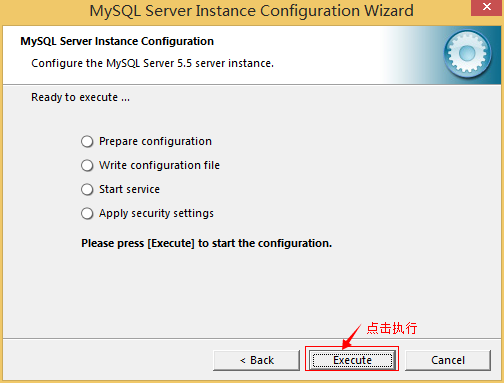

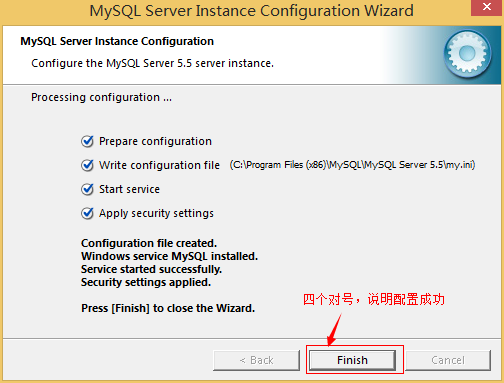

10、确认设置无误,按“Execute”使设置生效,即完成MYSQL的安装和配置。

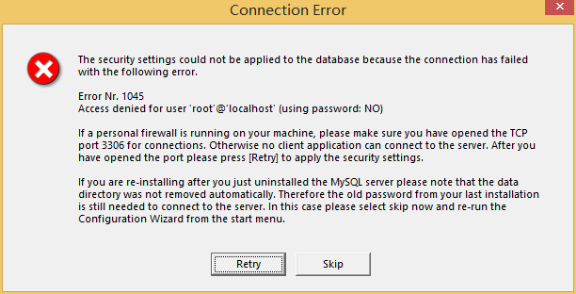

注意:设置完毕,按“Finish”后有一个比较常见的错误,就是不能“Start service”,一般出现在以前有安装mysql的服务器上,解决的办法,先保证以前安装的mysql服务器彻底卸载掉了;不行的话,检查是否按上面一步所说,之前的密码是否有修改,照上面的操作;如果依然不行,将mysql安装目录下的data文件夹备份,然后删除,在安装完成后,将安装生成的 data文件夹删除,备份的data文件夹移回来,再重启mysql服务就可以了,这种情况下,可能需要将数据库检查一下,然后修复一次,防止数据出错。

解决方法:

1,卸载MySQL

2,windows Xp系统删除目录 C:\Documents and Settings\All Users\Application Data

windows 7\8\10操作系统删除目录C:\ProgramData\MySQL

3,重新安装就可以了

小结

安装需要注意的地方: 安装路径不要有空格和中文,对着文档装

卸载需要注意的地方

- 去360/软件管家或者控制面板卸载(删除之前先找到两个文件夹)

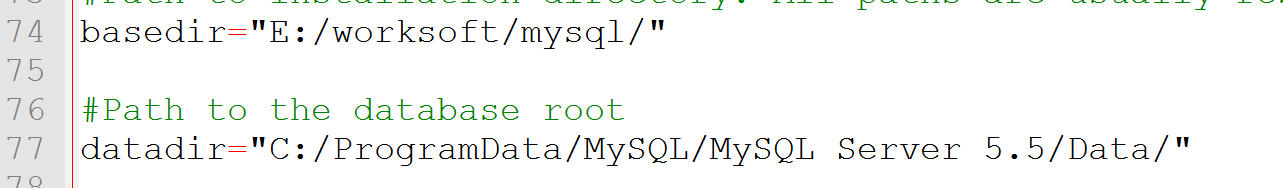

- 一定要删除两个文件夹(数据库安装路径和数据存放路径,这两个文件夹在配置文件里面my.ini)

实操-MySql的卸载

如何彻底的删除MySQL数据库:

以下操作以Window7操作系统为例:

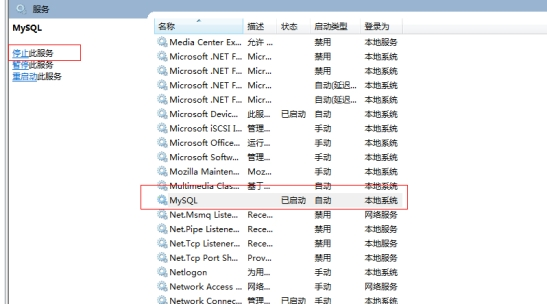

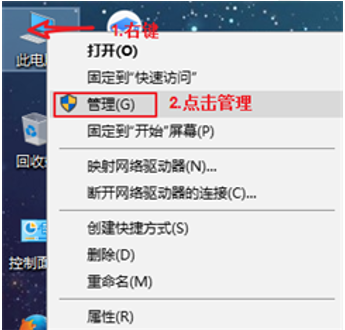

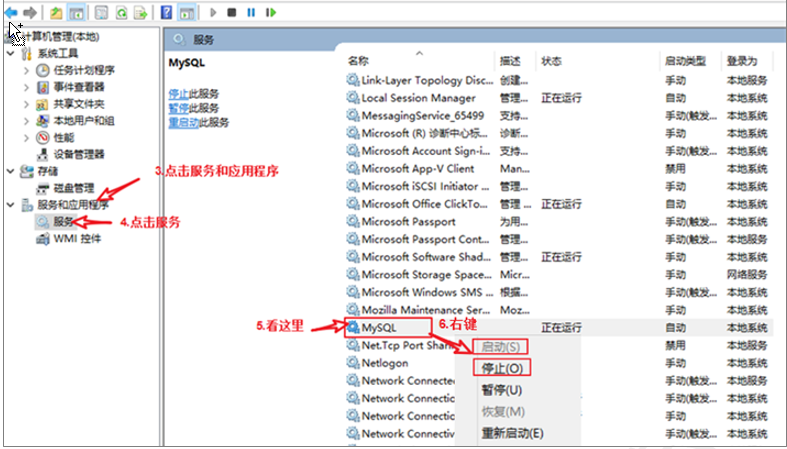

1)停止window的MySQL服务。

找到“控制面板”-> “管理工具”-> “服务”,停止MySQL后台服务。

或者可以用

DOS:net stop MySQL命令停止服务(需要知道服务名,不一定是MySQL)

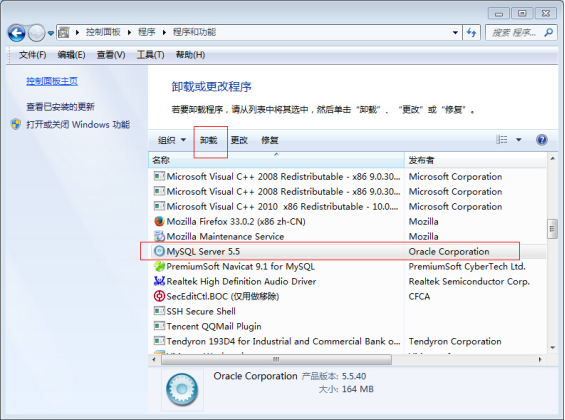

2)卸载MySQL安装程序。找到“控制面板”-> “程序和功能”,卸载MySQL程序。

3)删除MySQL安装目录下的所有文件。(删除安装的文件夹)

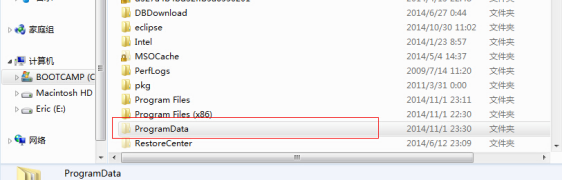

4)删除c:/ProgramDate/MySQL隐藏目录。(删除文件存放的文件夹)

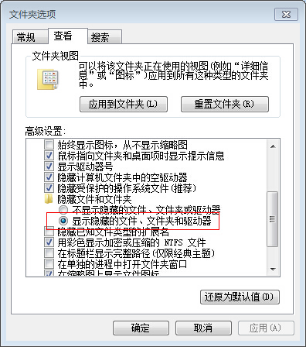

- 打开window系统的“显示隐藏文件”功能,以便查看到系统的所有隐藏文件

- 找到ProgramData目录

- 删除MySQL目录

- 查看注册表: 可选

1 | HKEY_LOCAL_MACHINE\SYSTEM\CurrentControlSet\Services/Eventlog/Applications/MySQL |

- 【可选】如果配置了环境变量MYSQL_HOME和在path中使用,也需要删除

- 删除MySQL服务,

管理员启动cmd-> sc delete MySQL服务名字

实操-数据库服务的启动和登录,退出

我们刚刚把数据库安装成功了,下面就需要进行数据库的启动,登录和退出

数据库服务的启动(界面)

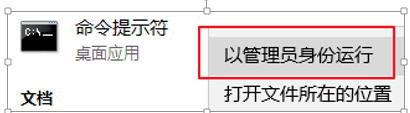

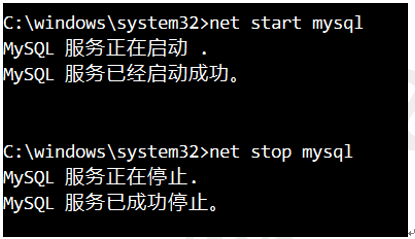

数据库服务的启动(DOS命令)

MySql是一个需要账户名密码登录的数据库,登陆后使用,它提供了一个默认的root账号,使用安装时设置的密码即可登录.

登录

命令行

1 | mysql -u 用户名 -p #然后再输入密码. |

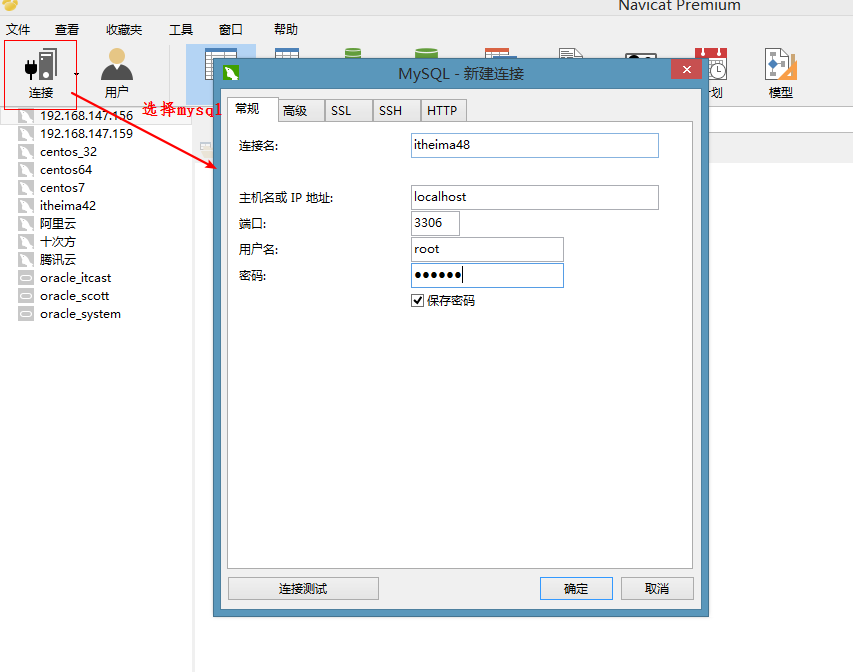

图形化工具

- 安装

连接

退出

命令行

1 | 输入: quit或exit |

图形化工具

- 右键关闭

小结

- MySql服务启动: 建议大家开机就启动

- dos连接

1 | mysql -u root -p |

- navicat图形化工具, 会连接就OK

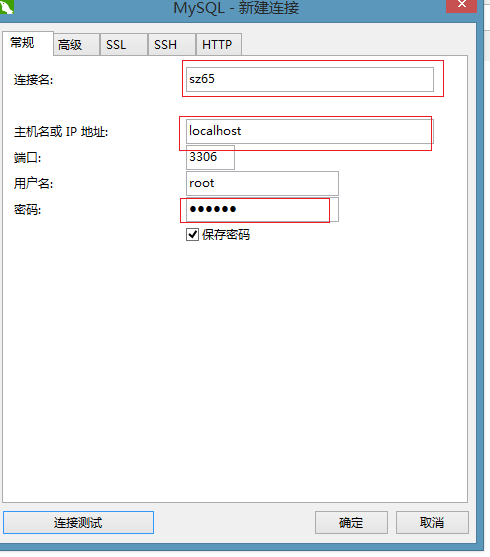

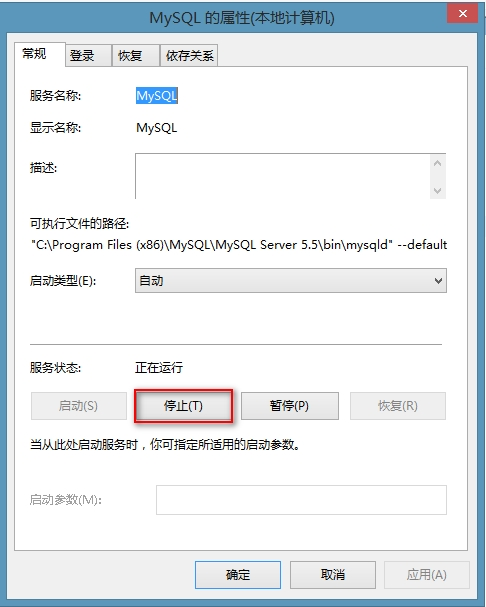

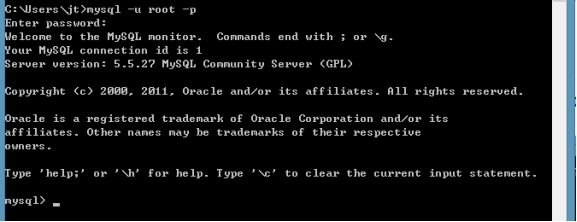

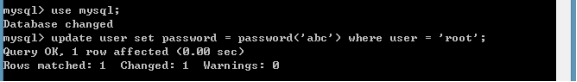

实操-重置MySQL密码

- 停止MySQL服务

- 在cmd下启动MySQL服务

- 重新开启cmd命名行,登录MySQL,不需要输入密码

- 修改root密码

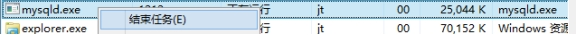

- 结束mysqld的进程

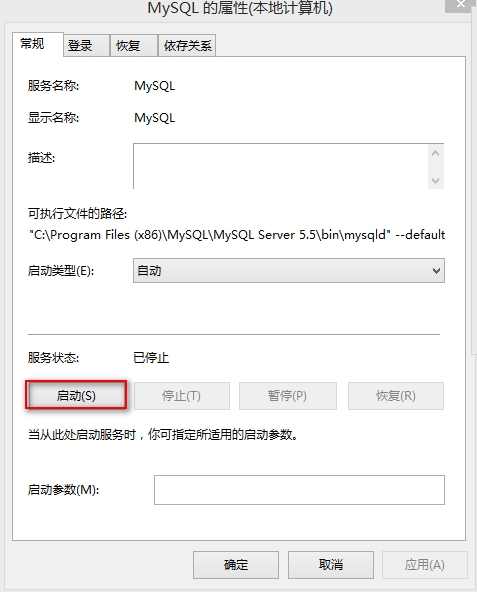

- 重启MySQL服务

mysql windows安装

下载:

https://dev.mysql.com/downloads/mysql/,下载zip包

初始化

管理员身份cmd进入bin,执行初始化命令:mysqld --initialize --console,记住随记生成的密码,t6olp-eQjt3j

安装服务

1 | mysqld -install |

启动服务

1 | net start mysql |

修改密码

mysqladmin -u root -p password root,输入上面的随机密码

登陆MySQL

mysql -u root -p,输入新的密码

可视化工具使用

可视化工具有很多

- Navicat

- SQLyog

- MySQL Workbench

- DataGrip

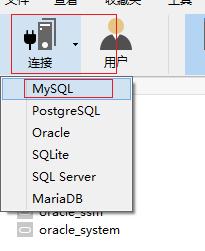

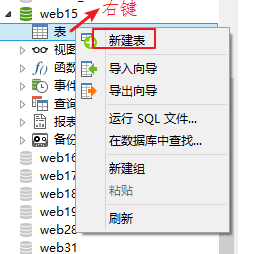

实操-可视化Navicat的使用

- 连接数据库

对数据库的操作

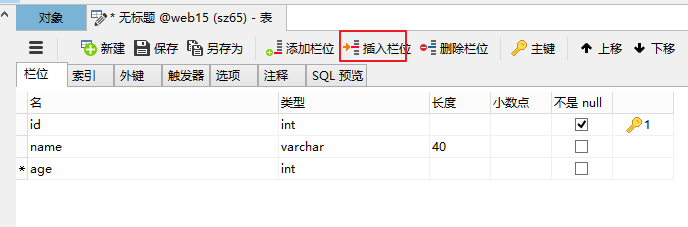

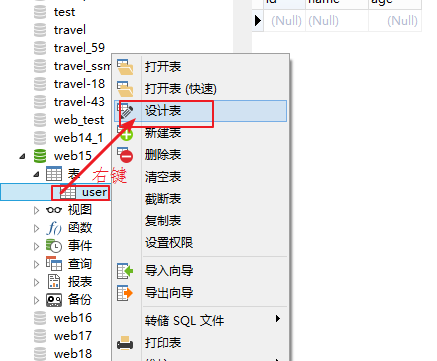

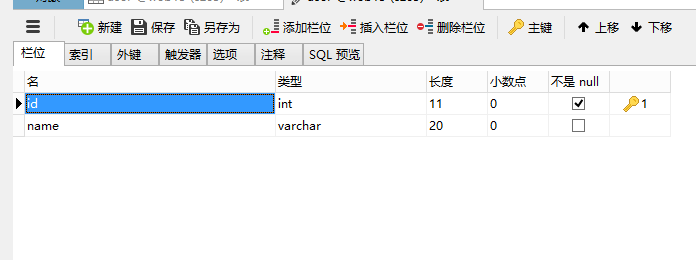

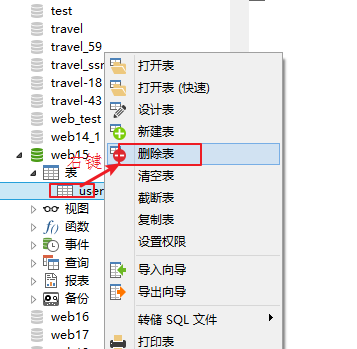

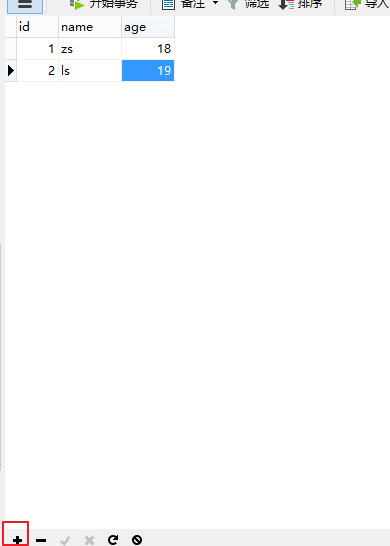

对表的操作

创建表

修改表

删除表

对数据的操作

插入数据

删除数据

修改数据

注意点:表, 记录如果创建好了, 没有展示, 需要刷新一下就可以了

SQL概述

什么是sql

- SQL:Structure Query Language。(结构化查询语言),通过sql操作数据库(操作数据库,操作表,操作数据)

- SQL被美国国家标准局(ANSI)确定为关系型数据库语言的美国标准,后来被国际化标准组织(ISO)采纳为关系数据库语言的国际标准

- 美国国家标准局(ANSI)开始着手制定SQL标准,并在1986年10月公布了最早的SQL标准,扩展的标准版本是1989年发表的SQL-89,之后还有1992年制定的版本SQL-92和1999年ISO发布的版本SQL-99。

- SQL标准几经修改和完善,其功能更加强大,但目前很多数据库系统只支持SQL-99的部分特征,而大部分数据库系统都能支持1992年制定的SQL-92。

- 各数据库厂商(MySql,oracle,sql server)都支持ISO的SQL标准。

- 各数据库厂商在标准的基础上做了自己的扩展。 各个数据库自己特定的语法

sql的语法

- 每条语句以分号结尾(命令行里面需要),如果在navicat,java代码中不是必须加的。

- SQL在window中不区分大小写,关键字中认为大写和小写是一样的

sql的分类

- Data Definition Language (DDL数据定义语言) 如:操作数据库,操作表

- Data Manipulation Language(DML数据操纵语言),如:对表中的记录操作增删改 (常用)

- Data Query Language(DQL 数据查询语言),如:对表中的记录查询操作 (常用)

- Data Control Language(DCL 数据控制语言),如:对用户权限的设置

DDL操作数据库

我们把Sql介绍完成了, 那下面就通过DDL操作数据库

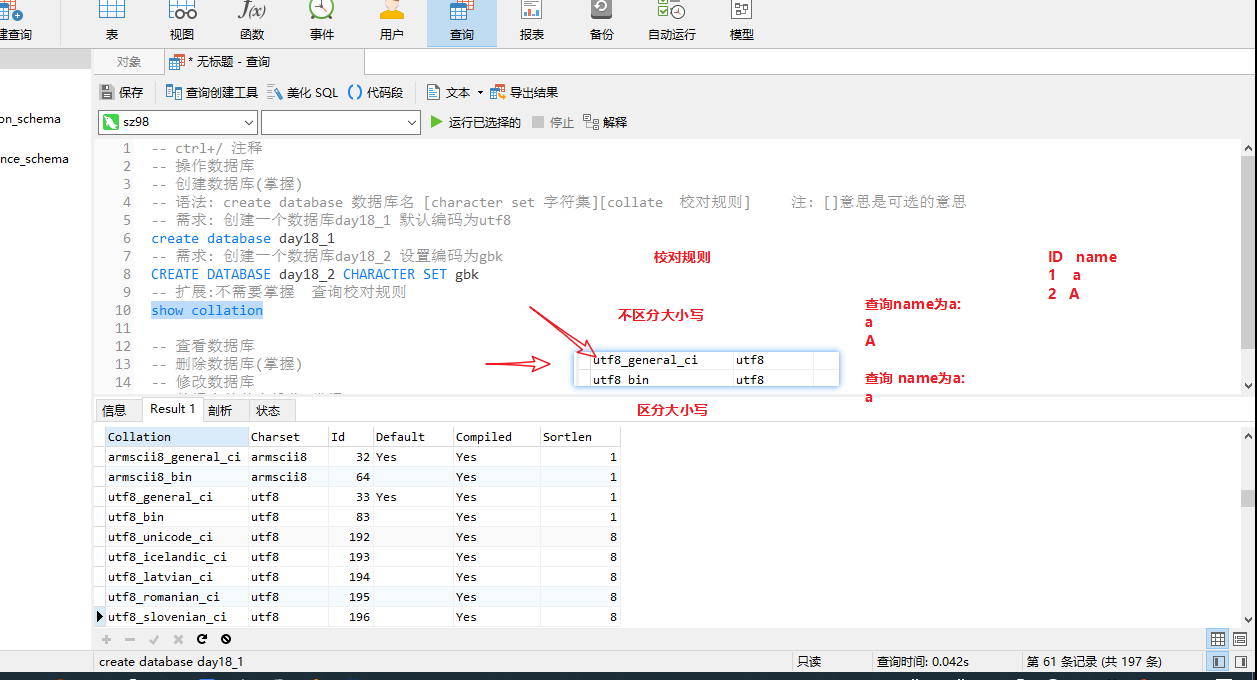

创建数据库

- 语法

1 | create database 数据库名 [character set 字符集][collate 校对规则] 注: []意思是可选的意思 |

字符集(charset):是一套符号和编码。

- 练习

1 | -- 直接创建数据库db1 |

查看所有的数据库

- 语法

1 | show databases; |

- 查看数据库的定义结构

1 | show create database 数据库名; |

- 查看web14_1这个数据库的定义

1 | show create database web14_1; |

删除数据库

- 语法

1 | drop database 数据库名; |

- 删除web14_2数据库

1 | drop database web14_2; |

修改数据库编码

- 语法

1 | alter database 数据库名 character set 字符集; |

- 修改web14_1这个数据库的字符集(gbk)

1 | alter database web14_1 character set gbk; |

注意:

- 是utf8,不是utf-8

- 不是修改数据库名

切换数据库

选定哪一个数据库

1 | use 数据库名; //注意: 在创建表之前一定要指定数据库. use 数据库名 |

查看正在使用的数据库

1 | select database(); |

DDL操作表

创建表

我们第四章已经把数据库的CRUD讲解完了,下面我们就学习创建表

创建表语法

1 | create table [if not exists] 表名( |

类型

原则是:够用就行,尽量使用取值范围小的,而不用大的,这样可以更多的节省存储空间。(实际开发可能没这么精细,这么简单这么用,现在存储也没那么拮据了)

数值类型:

| 类型 | 大小 | 范围(有符号) | 范围(无符号) | 用途 | 用途 |

|---|---|---|---|---|---|

TINYINT [UNSIGNED] [ZEROFILL] |

1 byte | (-128,127) | (0,255) | 微整数值 | 带符号的覆盖是-128~127.无符号0~255.默认是有符号,无符号要加UNSIGNED |

| BOOL,BOOLEAN | 使用0或1表示真或假 | ||||

| SMALLINT [UNSIGNED] [ZEROFILL] | 2 bytes | (-32 768,32 767) | (0,65 535) | 小整数值 | 2的16次方 |

| MEDIUMINT | 3 bytes | (-8 388 608,8 388 607) | (0,16 777 215) | 中整数值 | 2的24次方 |

INT或INTEGER [UNSIGNED] [ZEROFILL] |

4 bytes | (-2 147 483 648,2 147 483 647) | (0,4 294 967 295) | 大整数值 | 2的32次方 |

| BIGINT [UNSIGNED] [ZEROFILL] | 8 bytes | (-9,223,372,036,854,775,808,9 223 372 036 854 775 807) | (0,18 446 744 073 709 551 615) | 极大整数值 | 2的64次方 |

| FLOAT(M,D) [UNSIGNED] [ZEROFILL] | 4 bytes | (-3.402 823 466 E+38,3.402 823 466 351 E+38) | 0,(1.175 494 351 E-38,3.402 823 466 E+38) | 单精度浮点数值 | M指定显示长度,d指定小数位数。float(4,2) 表达的范围: -99.99~99.99 |

DOUBLE(M,D) [UNSIGNED] [ZEROFILL] |

8 bytes | (-1.797 693 134 862 315 7 E+308,1.797 693 134 862 315 7 E+308) | 0,(2.225 073 858 507 201 4 E-308,1.797 693 134 862 315 7 E+308) | 双精度浮点数值 | 表示比float精度更大的小数 |

| DECIMAL(M,D) | 依赖于M和D的值 | 依赖于M和D的值 | 小数值 | M指定显示长度,d指定小数位数,可以表示整数decimal(10)或小数decimal(10,2) |

字符串类型:

| 类型 | 大小 | 用途 |

|---|---|---|

| CHAR(size) | 0-255 bytes | 定长字符串,char(20), 最大能存放20个字符. ‘aaa’, 还是占20个字符的空间,一般使用varchar(n) 节省空间; 如果长度(eg:身份证)是固定的话 可以使用char(n) 性能高一点 |

VARCHAR(size) |

0-65535 bytes | 变长字符串,varchar(20), 最大能存放20个字符. ‘aaa’, 占3个字符的空间 |

| TINYBLOB | 0-255 bytes | 不超过 255 个字符的二进制字符串 |

| TINYTEXT | 0-255 bytes | 短文本字符串 |

| BLOB | 0-65 535 bytes | 二进制形式的长文本数据 |

| TEXT(clob) | 0-65 535 bytes | 长文本数据 |

| MEDIUMBLOB | 0-16 777 215 bytes | 二进制形式的中等长度文本数据 |

| MEDIUMTEXT | 0-16 777 215 bytes | 中等长度文本数据 |

| LONGBLOB | 0-4 294 967 295 bytes | 二进制形式的极大文本数据 |

| LONGTEXT(longclob) | 0-4 294 967 295 bytes | 极大文本数据 |

- 一般在数据库里面很少存文件的内容, 一般存文件的路径

- 一般不使用二进制存, 使用varchar(n)存文件的路径

日期类型:

| 类型 | 大小( bytes) | 范围 | 格式 | 用途 |

|---|---|---|---|---|

DATE |

3 | 1000-01-01/9999-12-31 | YYYY-MM-DD | 日期值 |

| TIME | 3 | ‘-838:59:59’/‘838:59:59’ | HH:MM:SS | 时间值或持续时间 |

| YEAR | 1 | 1901/2155 | YYYY | 年份值 |

DATETIME |

8 | 1000-01-01 00:00:00/9999-12-31 23:59:59 | YYYY-MM-DD HH:MM:SS | 混合日期和时间值 |

TIMESTAMP |

4 | 1970-01-01 00:00:00/2038结束时间是第 2147483647 秒,北京时间 2038-1-19 11:14:07,格林尼治时间 2038年1月19日 凌晨 03:14:07 | YYYYMMDD HHMMSS | 混合日期和时间值,时间戳,可用于自动记录insert,update操作的时间 |

约束

表在设计的时候加入约束的目的就是为了保证表中的记录完整性和有效性,比如用户表有些列的值(手机号)不能为空,有些列的值(身份证号)不能重复。

- 即规则,规矩 限制;

- 作用:保证用户插入的数据保存到数据库中是符合规范的

约束种类:

- 主键约束(

primary key) PK: (非空+唯一): 一般用在表的id列上面. 一张表基本上都有id列的, id列作为唯一标识的,默认会创建唯一索引。只有当设置了auto_increment 才可以插入null,由数据库维护。否则不给值插入null会报错 - 自增长约束(

auto_increment): 必须是设置了primary key之后,才可以使用auto_increment,id int primary key auto_increment;,id不需要我们自己维护了, 插入数据的时候直接插入null, 自动的增长进行填充进去, 避免重复了. - 非空约束(

not null):username varchar(40) not null, username这个字段不能为空,必须要有数据 - 唯一性约束(

unique):cardNo char(18) unique;,cardNo字段不能出现重复的数据 - 默认约束(default)

- 零填充约束(zerofill)

- 外键约束(foreign key) FK

表中的id列一般设置以下2种情况:

- 给id设置为int类型, 添加主键约束, 自增长约束

- 或者给id设置为字符串类型,添加主键约束, 不能设置自动增长

1 | -- 创建一张学生表(含有id字段,姓名字段,性别字段. id为主键自动增长) |

主键约束

- 定义字段的同时指定主键

1 | create table 表名( |

- 定义完字段之后指定主键

1 | create table 表名( |

- 设置多列主键(联合主键)

一张表只能有一个主键,联合主键也是一个主键

1 | create table 表名( |

- 通过修改表结构添加主键

主键约束不仅可以在创建表的同时创建,也可以在修改表时添加。

1 | create table 表名( |

- 删除主键约束

1 | alter table <数据表名> drop primary key; |

自增长约束

主键一般是唯一标识,设置了我们一般不想管它,就想让数据库系统自动赋值。每增加一条记录,主键会自动以相同的步长进行增长。 ———— 自增长约束(auto_increment)

语法:字段名 数据类型 primary key auto_increment

- 默认情况下,auto_increment的初始值是 1,每新增一条记录,字段值自动加 1。

- 一个表中只能有一个字段使用 auto_increment约束,且该字段必须有唯一索引,以避免序号重复(即为主键或主键的一部分)。

- auto_increment约束的字段必须具备

NOT NULL属性。 - auto_increment约束的字段只能是整数类型(TINYINT、SMALLINT、INT、BIGINT 等)。

- auto_increment约束字段的最大值受该字段的数据类型约束,如果达到上限,auto_increment就会失效。

比如字段id设置auto_increment,那么会自增长,全字段插入指定为NULL就行了。

insert into 表1 values(NULL,’张三’);

或者部分字段插入,就不用给null了

insert into 表1 (name) values(‘张三’);

- 指定自增字段初始值,比如自增长从100开始。

1 | # 添加自增长约束 |

delete和truncate在删除后自增列的变化

- delete数据之后自动增长从断点开始

- truncate数据之后自动增长从默认起始值开始

非空约束

对于使用了非空约束的字段,如果用户在添加数据时没有指定值,数据库系统就会报错。

1 | # 添加非空约束 |

唯一约束

唯一约束(Unique Key)是指所有记录中字段的值不能重复出现。

例如,为 id 字段加上唯一性约束后,每条记录的 id 值都是唯一的,不能出现重复的情况。

在MySQL中 NULL和任何值都不相同,包括自己,所以唯一约束的列可以为NULL

1 | # 添加唯一约束 |

默认约束

MySQL 默认值约束用来指定某列的默认值

设置了默认值的列,插入的时候也可以不用插入,但是如果插入的时候给了字段值(包括给NULL值),那相当于手动指定了,默认值就不会生效。

1 | # 添加默认约束 |

零填充约束

1、插入数据时,当该字段的值的长度小于定义的长度时,会在该值的前面补上相应的0

2、zerofill默认为int(10)

3、当使用zerofill 时,默认会自动加unsigned(无符号)属性,使用unsigned属性后,数值范围是原值的2倍,例如,有符号为-128~+127,无符号为0~256。

1 | # 添加零填充约束 |

查看表

我们把表创建好了, 下面就来介绍查看表

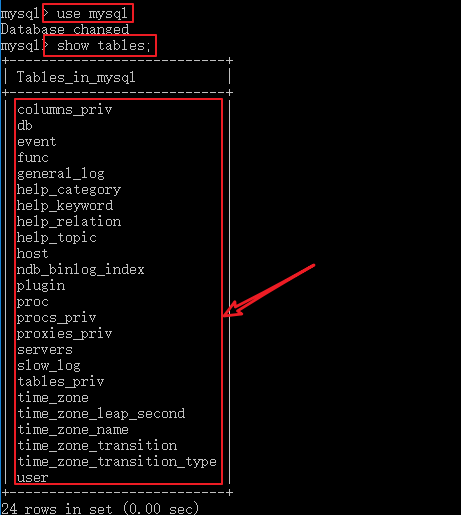

查看所有的表

1 | show tables; |

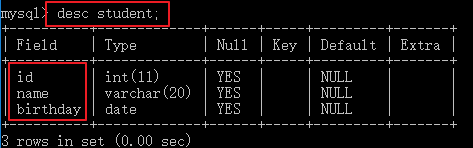

查看表的定义结构

语法

desc 表名;

练习: 查看student表的定义结构

1 | desc student; |

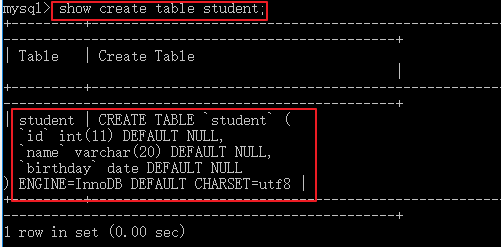

查看创建表的SQL

1 | SHOW CREATE TABLE 表名; |

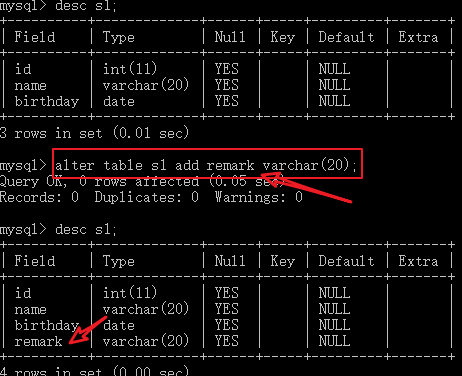

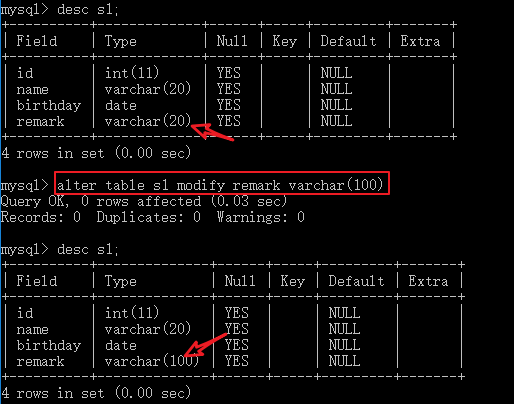

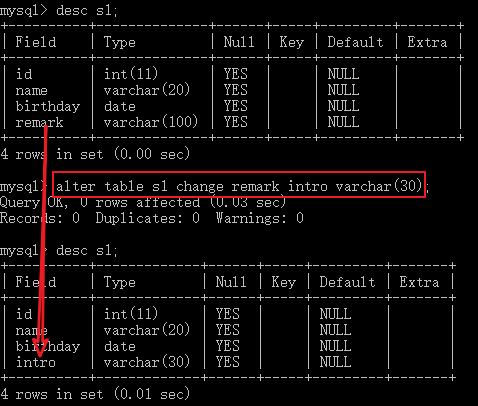

修改表

我们表创建好了, 如果要增加一列,要删除一列呢? 那下面就来讲解修改表

语法

- 增加一个字段;

alter table 表 add 字段 类型 约束; - 修改一个字段的类型约束;

alter table 表 modify 字段 类型 约束 ; - 修改一个字段的名称,类型,约束;

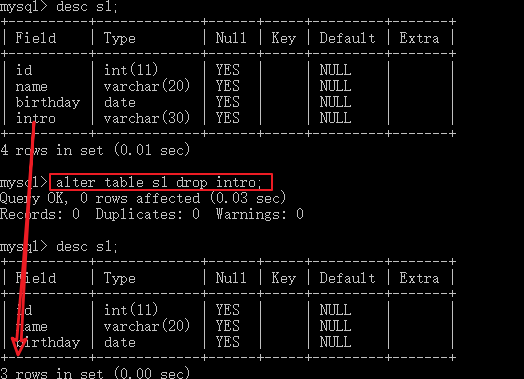

alter table 表 change 旧列 新列 类型 约束; - 删除一个字段;

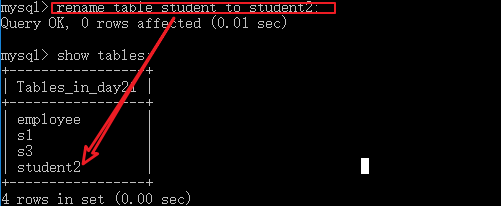

alter table 表名 drop 列名; - 修改表名 ;

rename table 旧表名 to 新表名;

练习

- 给学生表增加一个grade字段

1 | alter table student add grade varchar(20) not null; |

- 给学生表的sex字段改成字符串类型

1 | alter table student modify sex varchar(10); |

- 给学生表的grade字段修改成class字段

1 | alter table student change grade class varchar(20); |

将student表中的remark字段名改成intro,类型varchar(30)

- 把class字段删除

1 | alter table student drop class; |

删除student表中的字段intro

- 把学生表修改成老师表(了解)

1 | rename table student to teacher |

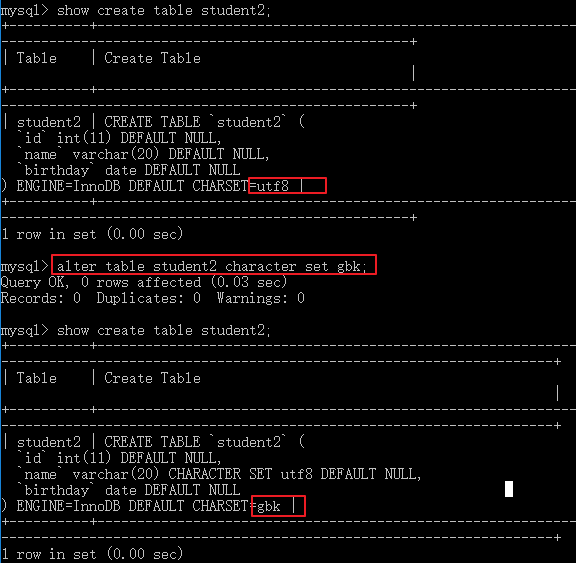

- 修改字符集

1 | ALTER TABLE 表名 character set 字符集; |

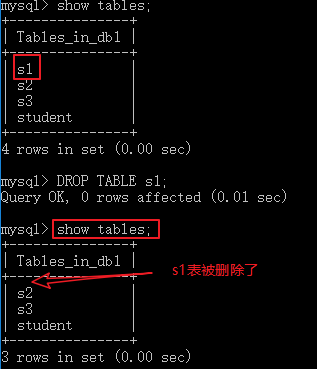

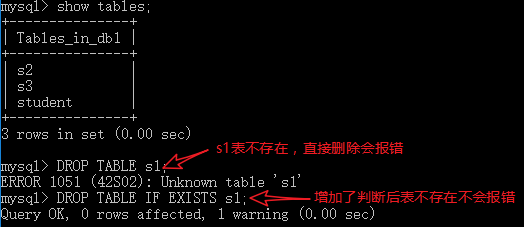

删除表

表创建好了, 我们还可以删除。 掌握表的删除

- 1 直接删除表

1 | DROP TABLE 表名; |

- 2 判断表是否存在并删除表

1 | DROP TABLE IF EXISTS 表名; |

DML操作表记录-增删改

- 准备工作: 创建一张商品表(商品id,商品名称,商品价格,商品数量.)

1 | create table product( |

插入记录

注意

- 插入特定的列:没有赋值的列,系统自动赋为null(前提是当前列没有设置not null 约束)

- 列名与列值的类型、个数、顺序要一一对应。

- 值不要超出列定义的长度。

- 插入的日期和字符串,使用引号括起来。

方式一: 插入指定列, 如果没有把这个列进行列出来, 以null进行自动赋值了.

1 | insert into 表(列1,列2..) values(值1,值2..); |

注意: 如果没有插入的列设置了非空约束, 会报错的

方式二: 插入所有的列

1 | insert into 表 values(值,值....); |

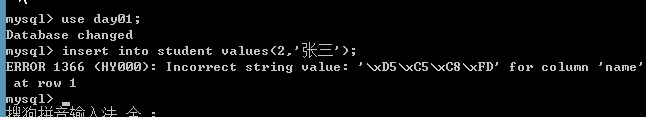

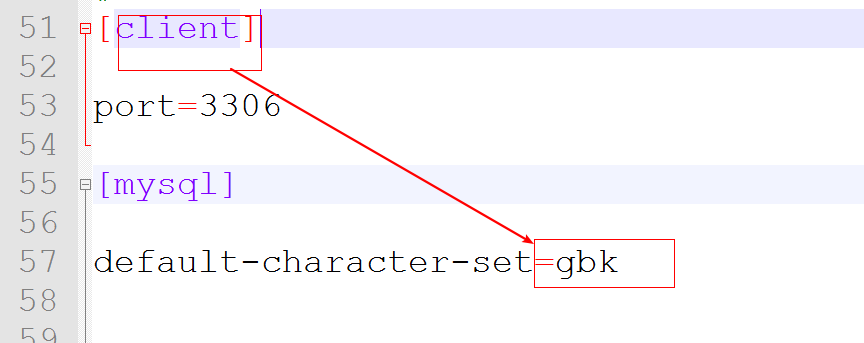

命令行插入中文数据报错:

- 关闭服务,

net stop MySql - 在数据库软件的安装目录下面, 修改配置文件 my.ini中客户端的编码为gbk

- 重新打开命令行,开启服务,

net start MySql

更新记录

我们数据插入成功了, 还可以对已有的数据进行更新。

语法

1 | update 表 set 列1=值, 列2=值 [where 条件] |

- 如果没有加where 更新整个的

- 工作里面一般是加where,可能也会设置门禁不让全表操作

练习

- 将所有商品的价格修改为5000元

- 将商品名是Mac的价格修改为18000元

- 将商品名是Mac的价格修改为17000,数量修改为5

- 将商品名是方便面的商品的价格在原有基础上增加2元

1 | update product set price = 5000; |

删除记录

delete

语法

1 | delete from 表 [where 条件] 注意: 删除数据用delete,不用truncate |

练习

- 删除表中名称为’Mac’的记录

- 删除价格小于5001的商品记录

- 删除表中的所有记录

1 | delete from product where pname = 'Mac'; |

truncate

1 | truncate table 表; |

delete和truncate区别【面试题】

- DELETE 删除表中的数据,表结构还在; 删除的记录可以找回

- TRUNCATE 删除是把表直接DROP掉,然后再创建一个同样的新表(空)。删除的记录不可以找回

工作里面的删除

- 物理删除: 真正的删除了, 数据不在, 使用delete就属于物理删除

- 逻辑删除: 没有真正的删除, 数据还在. 搞一个标记, 其实逻辑删除是更新 eg: state字段 1 启用 0禁用

工作里面一般看业务,重要的数据使用逻辑删除用的多

蠕虫复制

1 | # 蠕虫复制 |

DQL操作表记录-查询

单表查询

我们上面讲解了对数据的增删改, 下面就来重点讲解数据的简单查询.

基本查询语法

1 | select |

简单查询

查询所有的列的记录

- 语法

1 | select * form 表 |

- 查询商品表里面的所有的列

1 | select * from product; |

查询某张表特定列的记录

- 语法

1 | select 列名,列名,列名... from 表 |

- 查询商品名字和价格

1 | select pname, price from product; |

去重查询

- 语法

1 | SELECT DISTINCT 字段名 FROM 表名; //要数据一模一样才能去重 |

- 去重查询商品的价格

1 | select distinct price from product; |

注意点: 去重针对某列, distinct前面不能先出现列名

别名查询

- 语法

1 | select 列名 as 别名 ,列名 from 表 //列别名 as可以不写 |

- 查询商品名称和商品价格,商品价格通过别名‘价格’来显示

1 | select pname , price as 价格 from product; |

算术运算查询

| 算术运算符 | 说明 |

|---|---|

| + | 加法运算 |

| - | 减法运算 |

| ***** | 乘法运算 |

| / 或 DIV | 除法运算,返回商 |

| % 或 MOD | 求余运算,返回余数 |

- 把商品名,和商品价格+10查询出来

1 | select pname ,price+10 from product; |

注意:

- 运算查询字段,字段之间是可以的

- 字符串等类型可以做运算查询,但结果没有意义

条件查询

语法

1 | select ... from 表 where 条件 |

运算符

| 比较运算符 | 说明 |

|---|---|

| = | 等于 |

| < 和 <= | 小于和小于等于 |

| > 和 >= | 大于和大于等于 |

| <=> | 安全的等于,两个操作码均为NULL时,其所得值为1;而当一个操作码为NULL时,其所得值为0 |

| <>或!= | 不等于 |

| IS NULL 或 ISNULL | 判断一个值是否为 NULL |

| IS NOT NULL | 判断一个值是否不为 NULL |

| LEAST | 当有两个或多个参数时,返回最小值,如果有个值为NULL,则结果为NULL |

| GREATEST | 当有两个或多个参数时,返回最大值,如果有个值为NULL,则结果为NULL |

| BETWEEN AND | 判断一个值是否落在两个值之间 |

| IN | 判断一个值是IN列表中的任意一个值,例:in(100,200) |

| NOT IN | 判断一个值不是IN列表中的任意一个值 |

| LIKE | 通配符匹配, 模糊查询,like ‘张pattern’ |

| REGEXP | 正则表达式匹配 |

| 逻辑运算符 | 说明 |

|---|---|

| NOT 或者 ! | 逻辑非,不成立,例:where not(salary > 100); |

| AND 或者 && | 逻辑与,多个条件同时成立 |

| OR 或者 || | 逻辑或,多个条件任一成立 |

| XOR | 逻辑异或,不同为真,相同为假 |

| 位运算符 | 说明 |

|---|---|

| | | 按位或 |

| & | 按位与 |

| ^ | 按位异或 |

| << | 按位左移 |

| >> | 按位右移 |

| ~ | 按位取反,反转所有比特 |

位运算符是在二进制数上进行计算的运算符。位运算会先将操作数变成二进制数,进行位运算。然后再将计算结果从二进制数变回十进制数。

常用的操作

- between…and… 区间查询

1 | eg: where price between 1000 and 3000 相当于 1000<=price<=3000 |

- in(值,值..)

1 | -- 查询id为1,3,5,7的 |

- like 模糊查询,一般和

_或者%一起使用_占1位%占0或者n位

1 | name like '张%' --查询姓张的用户, 名字的字数没有限制 |

- and 多条件同时满足

1 | where 条件1 and 条件2 and 条件3 |

- or 任意条件满足

1 | where 条件1 or 条件2 or 条件3 |

6.使用least求n个数最小值和greatest求n个数最大值

1 | select least(10,5,20) as small_num; -- 5 |

练习

- 查询商品价格>3000的商品

- 查询id=1的商品

- 查询id<>1的商品

- 查询价格在3000到6000之间的商品

- 查询id在1,5,7,15范围内的商品

- 查询商品名以iPho开头的商品(iPhone系列)

- 查询商品价格大于3000并且数量大于20的商品 (条件 and 条件 and…)

- 查询id=1或者价格小于3000的商品

1 | select * from product where price > 3000; |

- 位运算(了解)

1 | select 3&5; -- 位与 -- 1 |

排序查询

有时候我们需要对查询出来的结果排序显示,那么就可以通过ORDER BY子句将查询出的结果进行排序。排序可以根据一个字段排,也可以根据多个字段排序,排序只是对查询的结果集排序,并不会影响表中数据的顺序。

应用场景

- 商城里面 根据价格, 销量, 上架时间, 评论数…

- 社交里面 根据距离排序

环境的准备

1 | # 创建学生表(有sid,学生姓名,学生性别,学生年龄,分数列,其中sid为主键自动增长) |

单列排序

- 语法: 只按某一个字段进行排序,单列排序

1 | SELECT 字段名 FROM 表名 [WHERE 条件] ORDER BY 字段名 [ASC|DESC]; //ASC: 升序,默认值; DESC: 降序 |

- 练习: 以分数降序查询所有的学生

1 | SELECT * FROM student ORDER BY score DESC |

组合排序

- 语法: 同时对多个字段进行排序,如果第1个字段相等,则按第2个字段排序,依次类推

1 | SELECT 字段名 FROM 表名 WHERE 字段=值 ORDER BY 字段名1 [ASC|DESC], 字段名2 [ASC|DESC]; |

- 练习: 以分数降序查询所有的学生, 如果分数一致,再以age降序

1 | SELECT * FROM student ORDER BY score DESC, age DESC |

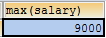

聚合函数

之前我们做的查询都是横向查询,它们都是根据条件一行一行的进行判断,而使用聚合函数查询是纵向查询,它是对一列的值进行计算,然后返回一个结果值。聚合函数会忽略空值NULL

| 聚合函数 | 作用 |

|---|---|

| max(列名) | 求这一列的最大值 |

| min(列名) | 求这一列的最小值 |

| avg(列名) | 求这一列的平均值 |

| count(列名) | 统计这一列有多少条记录 |

| sum(列名) | 对这一列求总和 |

- 语法

1 | SELECT 聚合函数(列名) FROM 表名 [where 条件]; |

- 练习

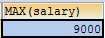

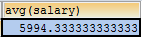

1 | -- 求出学生表里面的最高分数 |

注意: 聚合函数会忽略空值NULL

我们发现对于NULL的记录不会统计,建议如果统计个数则不要使用有可能为null的列,但如果需要把NULL也统计进去呢?我们可以通过 IFNULL(列名,默认值) 函数来解决这个问题. 如果列不为空,返回这列的值。如果为NULL,则返回默认值。

分组查询

分组查询是指使用 GROUP BY语句对查询信息进行分组

GROUP BY怎么分组的? 将分组字段结果中相同内容作为一组,如按性别将学生分成两组

GROUP BY将分组字段结果中相同内容作为一组,并且返回每组的第一条数据,所以单独分组没什么用处。分组的目的就是为了统计,一般分组会跟聚合函数一起使用

分组查询如果不查询出分组字段的值,就无法得知结果属于那组

在分组里面, 如果select后面的列没有出现在group by后面 ,展示这个组的这个列的第一个数据

分组

- 语法

1 | SELECT 字段1,字段2... FROM 表名 [where 条件] GROUP BY 列 [HAVING 条件]; |

- 练习:根据性别分组, 统计每一组学生的总人数

1 | -- 根据性别分组, 统计每一组学生的总人数 |

分组后筛选 having

- 练习根据性别分组, 统计每一组学生的总人数> 5的(分组后筛选)

1 | SELECT sex, count(*) FROM student GROUP BY sex HAVING count(*) > 5 |

where和having的区别【面试】

| 子名 | 作用 |

|---|---|

| where 子句 | 1) 对查询结果进行分组前,将不符合where条件的行去掉,即在分组之前过滤数据,即先过滤再分组。2) where后面不可以使用聚合函数 |

| having字句 | 1) having 子句的作用是筛选满足条件的组,即在分组之后过滤数据,即先分组再过滤。2) having后面可以使用聚合函数 |

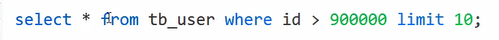

分页查询

LIMIT是限制的意思,所以LIMIT的作用就是限制查询记录的条数. 经常用来做分页查询

应用场景

如果数据库里面的数据量特别大, 我们不建议一次查询出来. 为了提升性能和用户体验, 使用分页

- 语法

1 | select ... from .... limit 起始行数,查询的记录条数. |

- 练习

1 | eg: 分页查询学生, 每一页查询4条 |

正则表达式🆕

MySQL通过REGEXP关键字支持正则表达式进行字符串匹配。

| 模式 | 描述 |

|---|---|

| ^ | 匹配输入字符串的开始位置。 |

| $ | 匹配输入字符串的结束位置。 |

| . | 匹配除 “\n” 之外的任何单个字符。 |

| […] | 字符集合。匹配所包含的任意一个字符。例如, ‘[abc]’ 可以匹配 “plain” 中的 ‘a’。 |

| [^…] | 负值字符集合。匹配未包含的任意字符。例如, ‘[^abc]’ 可以匹配 “plain” 中的’p’。 |

| p1|p2|p3 | 匹配 p1 或 p2 或 p3。例如,’z|food’ 能匹配 “z” 或 “food”。’(z|f)ood’ 则匹配 “zood” 或 “food”。 |

| ***** | 匹配前面的子表达式零次或多次。例如,zo* 能匹配 “z” 以及 “zoo”。* 等价于{0,}。 |

| + | 匹配前面的子表达式一次或多次。例如,’zo+’ 能匹配 “zo” 以及 “zoo”,但不能匹配 “z”。+ 等价于 {1,}。 |

| {n} | n 是一个非负整数。匹配确定的 n 次。例如,’o{2}’ 不能匹配 “Bob” 中的 ‘o’,但是能匹配 “food” 中的两个 o。 |

| {n,m} | m 和 n 均为非负整数,其中n <= m。最少匹配 n 次且最多匹配 m 次。 |

例子:

1 | -- ^ 在字符串开始处进行匹配 |

🔖MySQL进阶

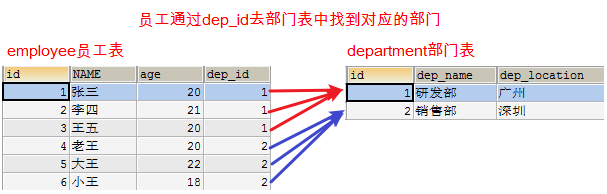

多表间的关系

为什么要有多表

单表的缺点

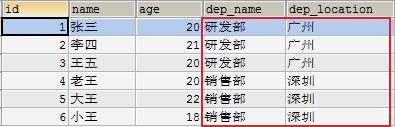

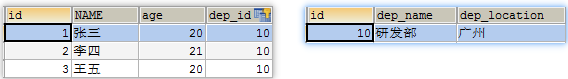

创建一个员工表包含如下列(id, name, age, dep_name, dep_location),id主键并自动增长,添加5条数据

1 | CREATE TABLE emp ( |

缺点:表中出现了很多重复的数据(数据冗余),如果要修改研发部的地址需要修改3个地方。

解决方案:将一张表分成2张表(员工表和部门表)

1 | -- 创建部门表 |

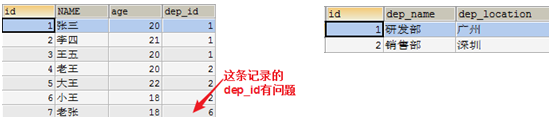

问题: 当我们在employee的dep_id里面输入不存在的部门,数据依然可以添加.但是并没有对应的部门,不能出现这种情况。employee的dep_id中的内容只能是department表中存在的id

目标:需要约束dep_id字段的值, 只能是department表中已经存在id 解决方式:使用外键约束

有些情况下,使用一张表表示数据 数据不好维护, 存在数据冗余,比较乱的现象

使用多张表,需要对数据进行约束,不约束,添加的数据会不合法

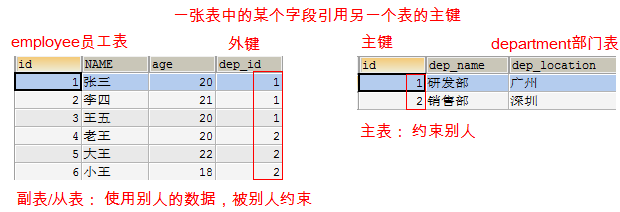

外键约束

表和表之间存在一种关系,但是这个关系需要谁来维护和约束?

外键约束作用

- 用来维护多表之间关系

外键: 一张从表中的某个字段引用主表中的主键 主表: 约束别人 副表/从表: 使用别人的数据,被别人约束

外键的语法

添加外键

1 | 1. 新建表时增加外键: |

删除外键

1 | alter table 表 drop foreign key 外键名称; |

为已存在的表添加外键,注意:外键字段上不能有非法数据

1 | alter table 表名 add constraint 外键名称 foreign key(外键字段名) reference 主表(主键名) |

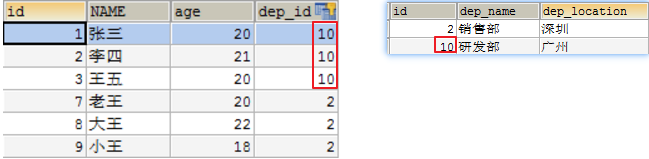

外键的级联

要把部门表中的id值2,改成5,能不能直接修改呢?

1

UPDATE department SET id=5 WHERE id=2;

不能直接修改:Cannot delete or update a parent row: a foreign key constraint fails 如果副表(员工表)中有引用的数据,不能直接修改主表(部门表)主键

要删除部门id等于1的部门, 能不能直接删除呢?

1

DELETE FROM department WHERE id = 1;

不能直接删除:Cannot delete or update a parent row: a foreign key constraint fails 如果副表(员工表)中有引用的数据,不能直接删除主表(部门表)数据

什么是级联操作: 在修改和删除主表的主键时,同时更新或删除副表的外键值,称为级联操作 ON UPDATE CASCADE – 级联更新,主键发生更新时,外键也会更新 ON DELETE CASCADE – 级联删除,主键发生删除时,外键也会删除

具体操作:

- 删除employee表

- 重新创建employee表,添加级联更新和级联删除

1 | CREATE TABLE employee ( |

- 再次添加数据到员工表和部门表

1 | INSERT INTO employee (NAME, age, dep_id) VALUES ('张三', 20, 1); |

- 把部门表中id等于1的部门改成id等于10

1 | UPDATE department SET id=10 WHERE id=1; |

- 删除部门号是2的部门

1 | DELETE FROM department WHERE id=2; |

小结

- 外键约束的作用: 维护多表的关系, 保证引用数据的完整性

- 外键的语法

1 | constraint 外键名称 foreign key(外键字段名) references 主表(列[主键]) [ON UPDATE CASCADE][ON DELETE CASCADE] |

- 外键注意事项

- 外键的这个列的类型必须和参照主表主键列的类型一致

- 参照列必须是主键

多表间关系

能够说出多表之间的关系及其建表原则

eg: 下订单(t_order)—>谁下(t_user), 买了什么(t_product)

现实生活中,实体与实体之间肯定是有关系的,比如:老公和老婆,部门和员工,老师和学生等。那么我们在设计表的时候,就应该体现出表与表之间的这种关系!分成三种:

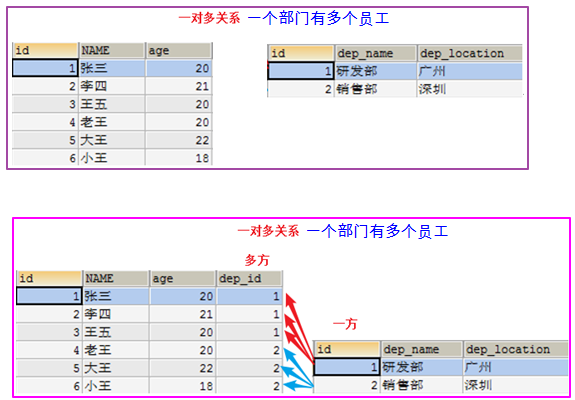

- 一对多

- 多对多

- 一对一

一对多(1:n)

例如:班级和学生,部门和员工,客户和订单

一的一方: 班级 部门 客户

多的一方:学生 员工 订单

一对多建表原则: 在从表(多方的一方)创建1一个字段,字段作为外键指向主表(一方)的主键

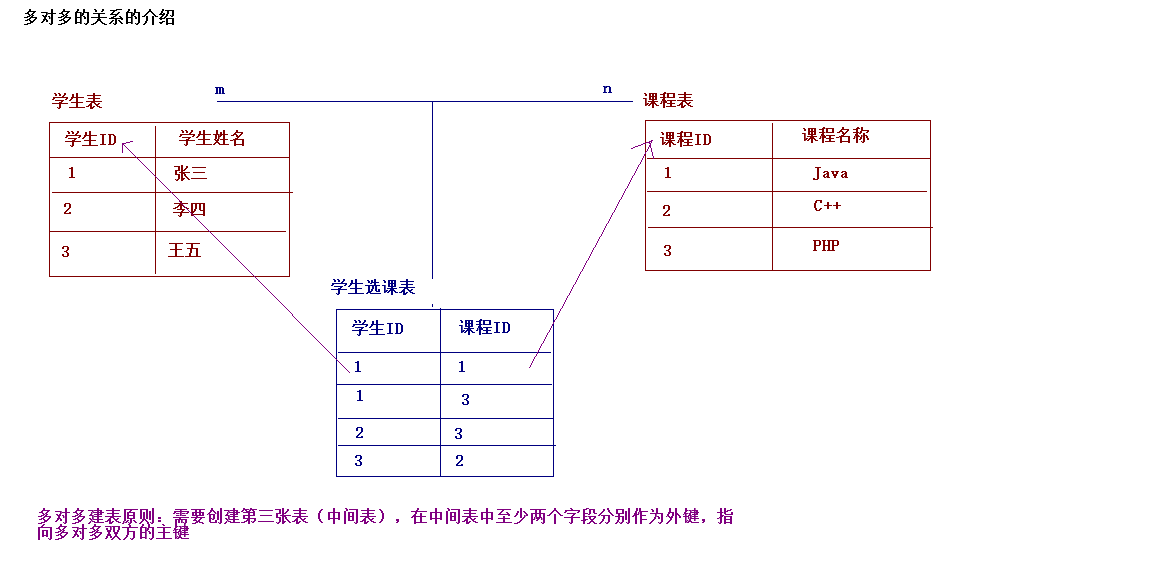

多对多

多对多(m:n) 例如:老师和学生,学生和课程,用户和角色

一个老师可以有多个学生,一个学生也可以有多个老师 多对多的关系

一个学生可以选多门课程,一门课程也可以由多个学生选择 多对多的关系

一个用户可以有多个角色,一个角色也可以有多个用户 多对多的关系

多对多关系建表原则: 需要创建第三张表,中间表中至少两个字段,这两个字段分别作为外键指向各自一方的主键。

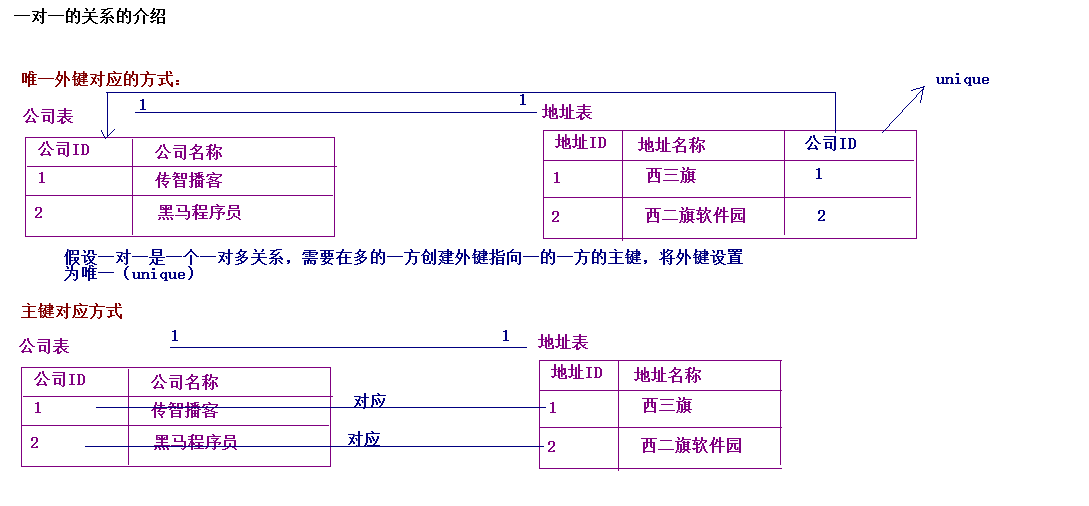

一对一(通常单表)

一对一(1:1)

例如: 一个公司可以有一个注册地址,一个注册地址只能对一个公司。

例如:一个老公可以有一个老婆,一个老婆只能有一个老公

在实际的开发中应用不多.因为一对一可以创建成一张表。 两种建表原则:

- 外键唯一:主表的主键和从表的外键(唯一),形成主外键关系,外键唯一

UNIQUE - 外键是主键:主表的主键和从表的主键,形成主外键关系

多表设计之多表分析及创建

需求:完成一个学校的选课系统,在选课系统中包含班级,学生和课程这些实体。

分析:

班级和学生: 一对多

学生和课程: 多对多

班级和学生之间是有关系存在:

一个班级下包含多个学生,一个学生只能属于某一个班级(一对多的关系)。

学生和课程之间是有关系存在:

一个学生可以选择多门课程,一门课程也可以被多个学生所选择(多对多的关系)。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29-- 多表建表原则练习

-- 班级和学生: 一对多

-- 学生和课程: 多对多

-- 创建班级表

create table class(

cid int primary key auto_increment,

cname varchar(40)

);

-- 创建学生表

create table student(

sid int primary key auto_increment,

sname varchar(40),

c_id int,

constraint stu_cls_fk1 foreign key(c_id) references class(cid)

);

-- 创建课程表

create table course(

co_id int primary key auto_increment,

co_name varchar(40)

);

-- 创建中间表

create table stu_co(

sno int,

cno int,

constraint stu_co_fk1 foreign key(sno) references student(sid),

constraint stu_co_fk2 foreign key(cno) references course(co_id)

);

小结

- 1对多: 在多方创建一个字段作为外键 指向一方的主键

- 多对多: 创建一张中间表,这个表里面至少包含两个字段,都作为外键,分别指向各自一方的主键

- 1对1: 先当做1对多, 再在外键列添加唯一约束;一般开发中是创建一张表

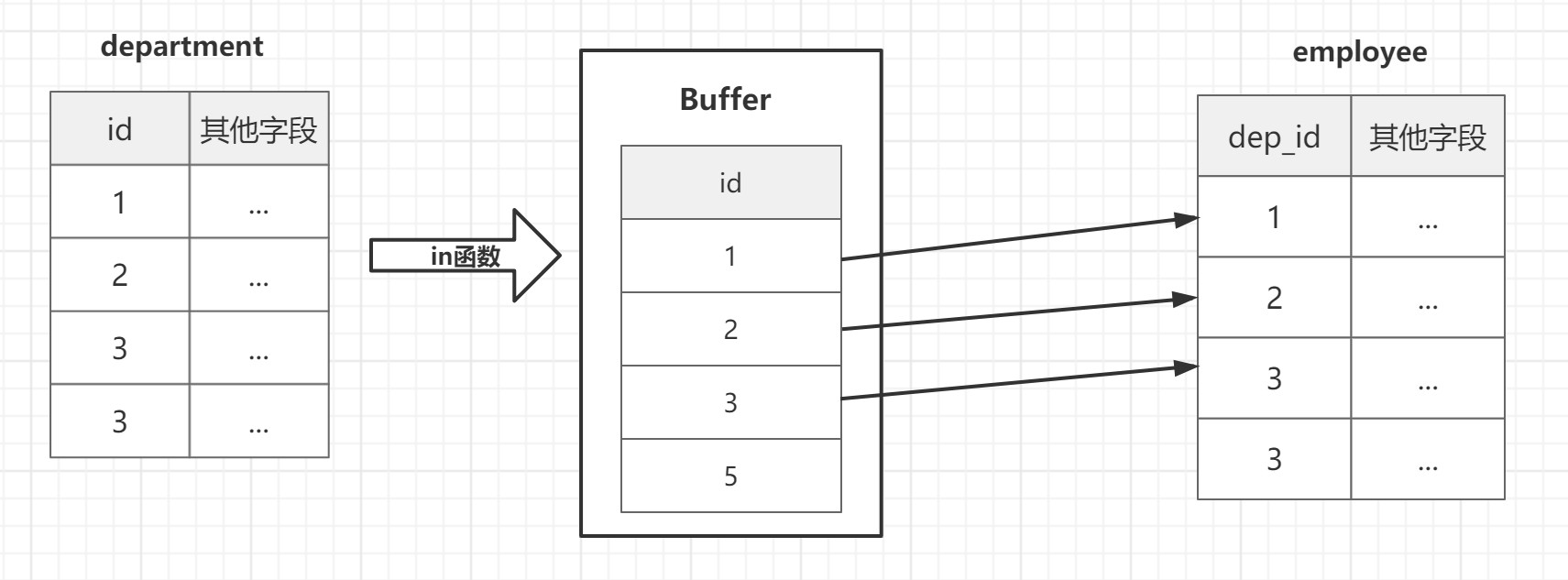

连接查询

环境准备

1 | -- 创建部门表 |

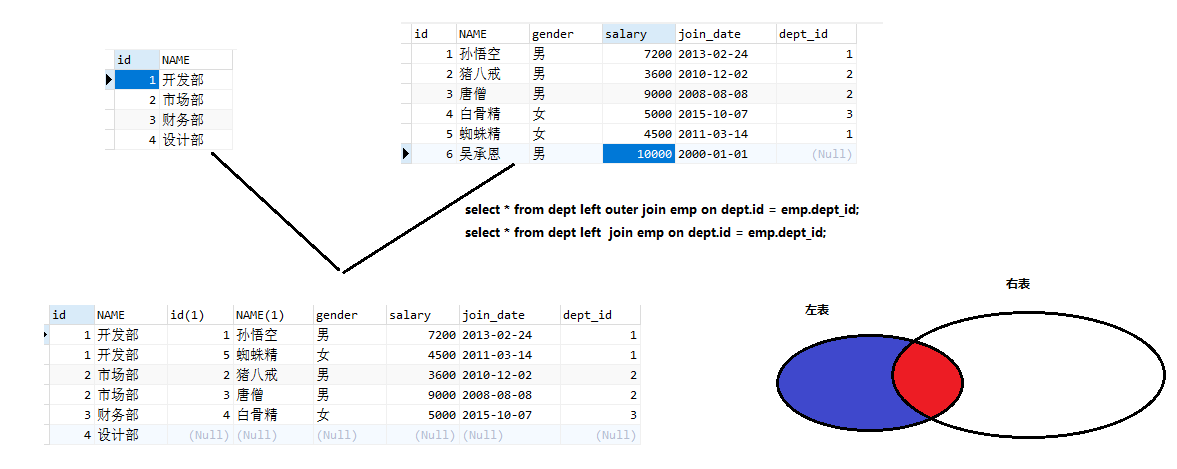

交叉查询【了解】

我思故我在 ———— 笛卡尔

交叉查询其实是一种错误.数据大部分是无用数据,叫笛卡尔积.

假设集合A={a,b},集合B={0,1,2},则两个集合的笛卡尔积为{(a,0),(a,1),(a,2),(b,0),(b,1),(b,2)}。可以扩展到多个集合的情况。

交叉查询把若干张表(>=2)没有条件的连接在一起,进行展示

- 语法

1 | select ... from 表1,表2 ; |

- 练习: 使用交叉查询部门和员工

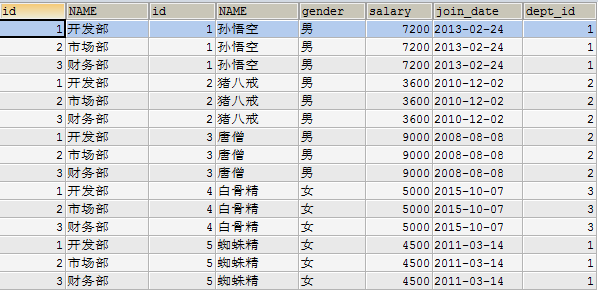

1 | SELECT * FROM dept, emp; |

以上数据其实是左表的每条数据和右表的每条数据组合。左表有3条,右表有5条,最终组合后3*5=15条数据。

左表的每条数据和右表的每条数据组合,这种效果称为笛卡尔乘积

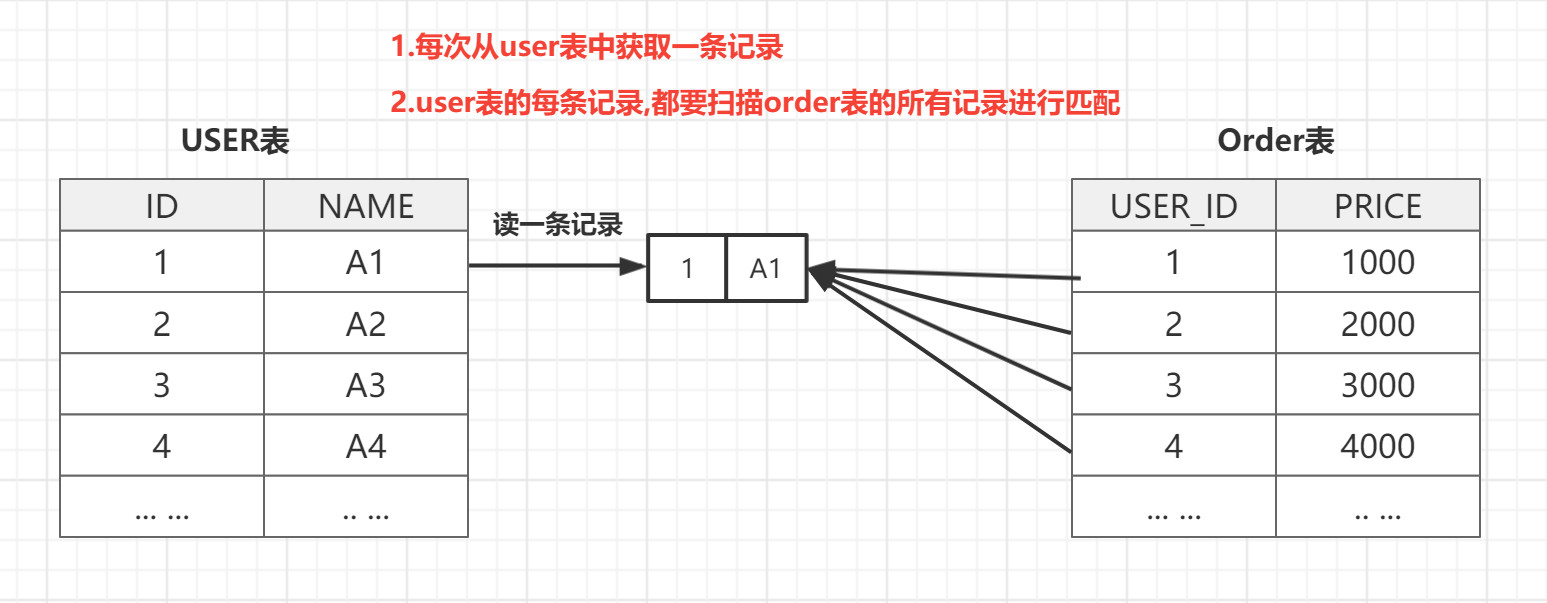

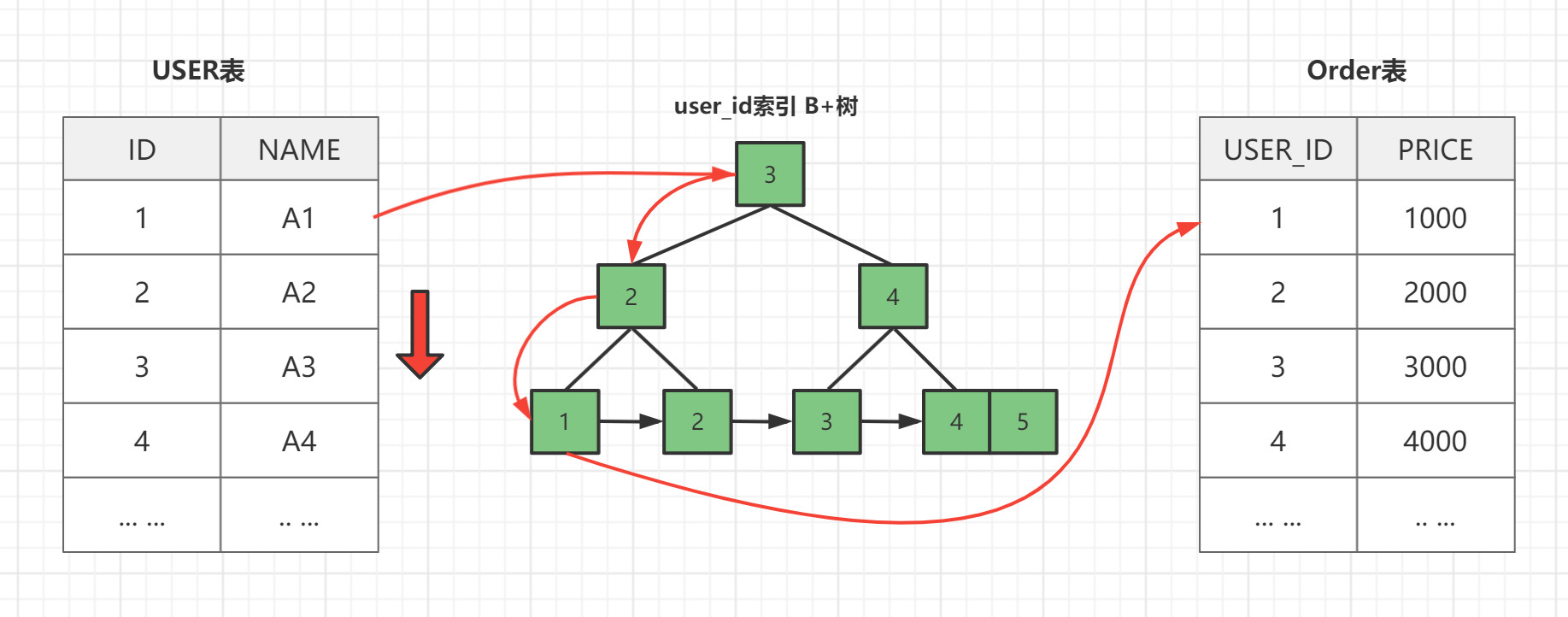

内连接查询【重点】

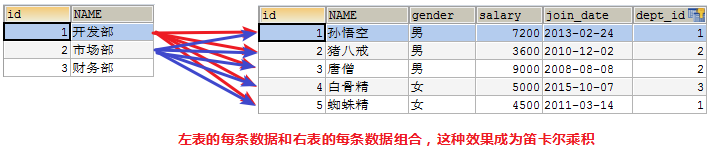

交叉查询产生这样的结果并不是我们想要的,那么怎么去除错误的,不想要的记录呢,当然是通过条件过滤。通常要查询的多个表之间都存在关联关系,那么就通过**关联关系(主外键关系)**去除笛卡尔积。

隐式内连接(SQL92标准)

隐式里面是没有inner关键字的

1 | select [字段,字段,字段][*] from 表1,表2 where 连接条件 --(外键的值等于主键的值) |

练习:查询员工的id,姓名,性别,薪资,加入日期,所属部门

1 | select emp.id,emp.name,emp.gender,emp.salary,emp.join_date,dept.name from emp,dept where emp.dept_id = dept.id; |

显式内连接(SQL99标准)

吼吼,99年的事情瞒不住啦~

显示里面是有inner关键字的

1 | select [字段,字段,字段][*] from a [inner] join b on 连接条件 [ where 其它条件] |

练习

查询所有部门下的员工信息,如果该部门下没有员工则不展示.

1 | insert into dept values(null,'设计部'); |

小结

内连接的特点(查的是什么东西)

内连接查询的是公共部分,满足连接条件(主外键关系)的部分

使用内连接的关键点

- 使用主外键关系做为条件来去除无用信息. 抓住主外键的关系,用主外键作为连接条件 b表里面的外键 = a表里面的主键

- 显示内连接里面的,on只能用主外键关联作为条件,如果还有其它条件,后面加where

语法

1 | -- 隐式(不出现inner) |

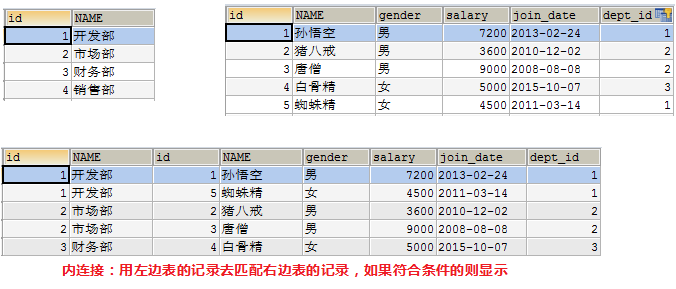

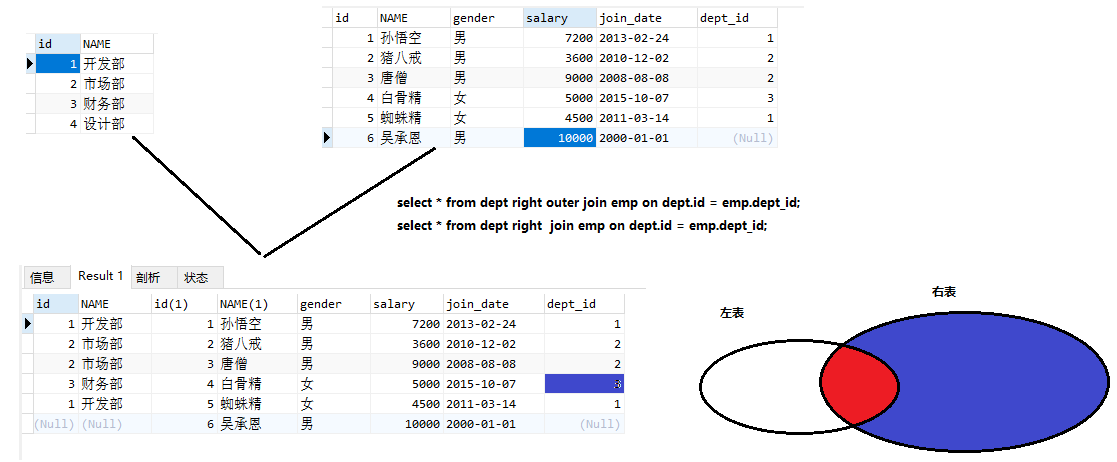

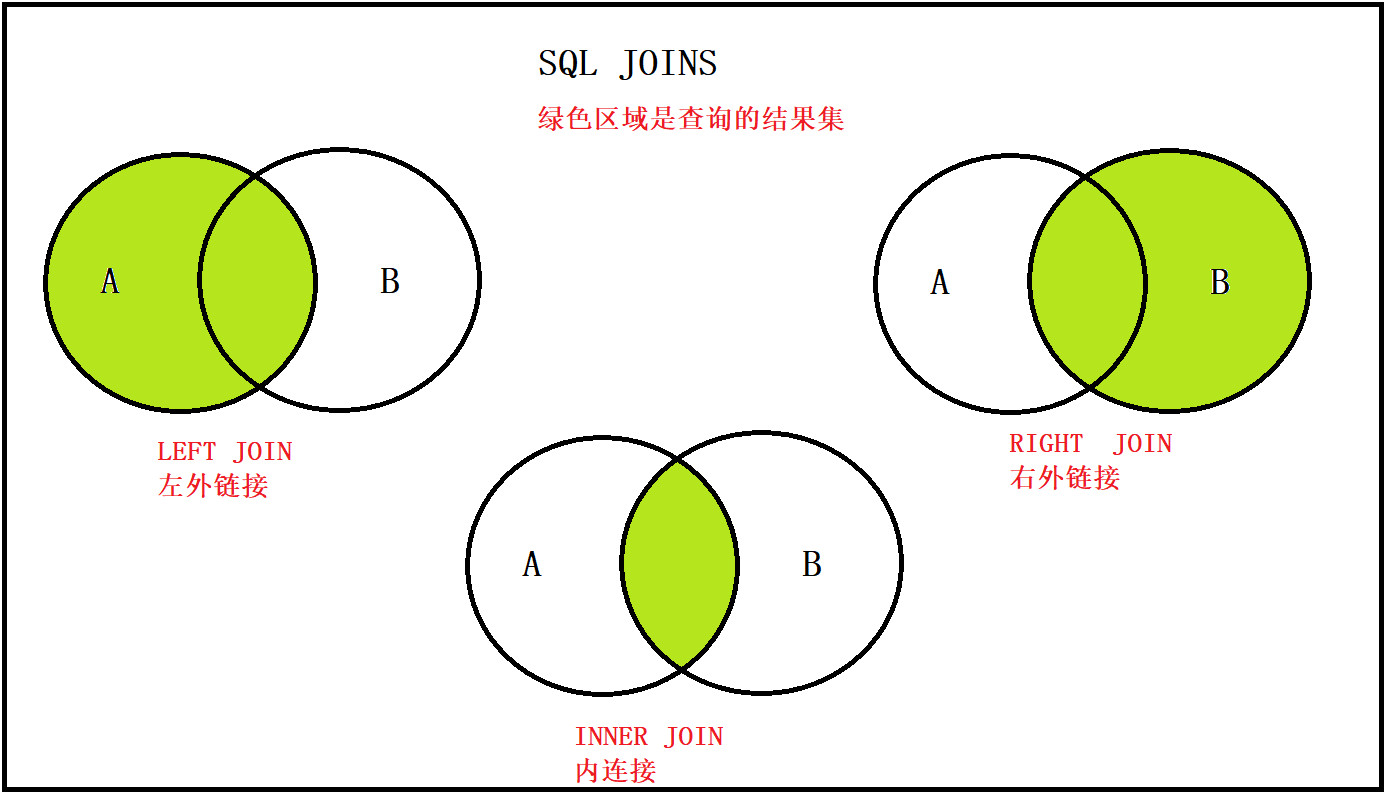

外连接查询【重点】

我们发现内连接查询出来的是公共部分. 如果要保证某张表的全部数据情况下进行连接查询. 那么就要使用外连接查询了. 外连接分为左外连接和右外连接

左外连接

以join左边的表为主表,展示主表的所有数据,根据条件查询连接右边表的数据,若满足条件则展示,若不满足则以null显示.

可以理解为:在内连接的基础上保证左边表的数据全部显示

- 语法

1 | select [字段][*] from a left [outer] join b on 条件 |

- 练习:查询所有部门下的员工

1 | SSELECT * FROM dept LEFT OUTER JOIN emp ON emp.`dept_id`=dept.`id`; |

右外连接

以join右边的表为主表,展示右边表的所有数据,根据条件查询join左边表的数据,若满足则展示,若不满足则以null显示

可以理解为:在内连接的基础上保证右边表的数据全部显示

- 语法

1 | select 字段 from a right [outer] join b on 条件 |

- 练习:查询所有员工所对应的部门

1 | SELECT * FROM dept RIGHT OUTER JOIN emp ON emp.dept_id=dept.id; |

小结

- 语法

1 | select * from a left [outer] join b on 连接条件 --左外连接 |

- 内连接和外连接的区别

- 内连接: 查询的是公共部分,满足连接条件的部分

- 左外连接: 以左边表为主表, 查询出左边表的所有的数据. 再通过连接条件匹配出右边表的数据, 如果满足连接条件, 展示右边表的数据; 如果不满足, 右边的数据通过null代替

- 右外连接: 以右边表为主表, 查询出右边表的所有的数据. 再通过连接条件匹配出左边表的数据, 如果满足连接条件, 展示左边表的数据; 如果不满足, 左边的数据通过null代替

- 应用

1 | 1.用户1和订单m |

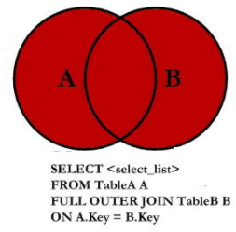

满外连接

注意:oracle里面有full join,可是在mysql对full join支持的不好。我们可以使用union来达到目的。

1 | select * from A full outer join B on 条件; |

自关联查询

MySQL有时在信息查询时需要进行对表自身进行关联查询,即一张表自己和自己关联,一张表当成多张表来用。注意自关联时表必须给表起别名。

1 | select 字段列表 from 表1 a , 表1 b where 条件; |

操作例子:

1 | -- 创建表,并建立自关联约束 |

子查询

我们刚刚讲解了内连接和外连接查询, 但是如果遇到很复杂的场景, 内连接和外连接查询可能查询不出来.我们就可以使用子查询了.

什么是子查询

直观一点: 一个查询语句里面至少包含2个select

- 一个查询语句的结果作为另一个查询语句的条件

- 有查询的嵌套,内部的查询称为子查询

- 子查询要使用括号

尽管子查询的语法很灵活,没有固定的写法.但是它也有一些规律.

子查询结果的三种情况:

- 子查询的结果是一个值的时候

- 子查询结果是单列多行的时候

- 子查询的结果是多行多列

子查询逻辑关键字

ALL关键字

- ALL: 与子查询返回的所有值比较为true 则返回true

- ALL可以与

=、>、>=、<、<=、<>结合是来使用,分别表示等于、大于、大于等于、小于、小于等于、不等于其中的其中的所有数据。 - ALL表示指定列中的值必须要大于子查询集的每一个值,即必须要大于子查询集的最大值;如果是小于号即小于子查询集的最小值。同理可以推出其它的比较运算符的情况。

1 | select …from …where c > all(查询语句) |

ANY 和 SOME关键字

- ANY:与子查询返回的任何值比较为true 则返回true

- ANY可以与

=、>、>=、<、<=、<>结合是来使用,分别表示等于、大于、大于等于、小于、小于等于、不等于其中的其中的任何一个数据。 - 表示制定列中的值要大于子查询中的任意一个值,即必须要大于子查询集中的最小值。同理可以推出其它的比较运算符的情况。

- SOME和ANY的作用一样,SOME可以理解为ANY的别名

1 | select …from …where c > any(查询语句) |

IN关键字

- IN关键字,用于判断某个记录的值,是否在指定的集合中

- 在IN关键字前边加上not可以将条件反过来

1 | select …from …where c in(查询语句) |

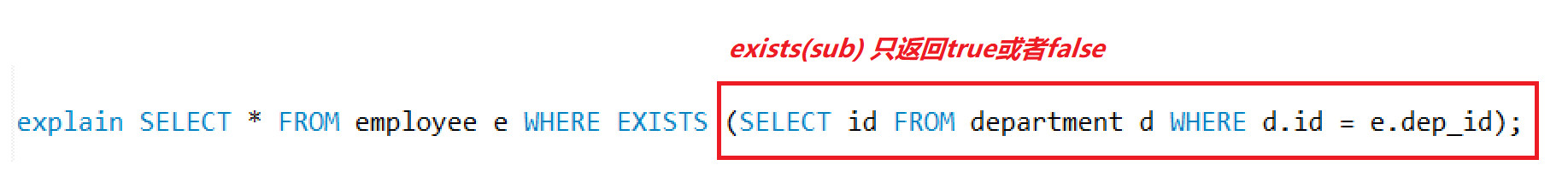

EXISTS关键字

- 该子查询如果“有数据结果”(至少返回一行数据), 则该EXISTS() 的结果为“true”,外层查询执行

- 该子查询如果“没有数据结果”(没有任何数据返回),则该EXISTS()的结果为“false”,外层查询不执行

- EXISTS后面的子查询不返回任何实际数据,只返回真或假,当返回真时 where条件成立

- 注意,EXISTS关键字,比IN关键字的运算效率高,因此,在实际开发中,特别是大数据量时,推荐使用EXISTS关键字

1 | select …from …where exists(查询语句) |

子查询的结果是一个值的时候

子查询结果只要是单个值,肯定在WHERE后面作为条件 SELECT 查询字段 FROM 表 WHERE 字段[= > < <>](子查询);

查询工资最高的员工是谁?

- 查询最高工资是多少

1 | SELECT MAX(salary) FROM emp; |

- 根据最高工资到员工表查询到对应的员工信息

1 | SELECT * FROM emp WHERE salary=(SELECT MAX(salary) FROM emp); |

查询工资小于平均工资的员工有哪些?

- 查询平均工资是多少

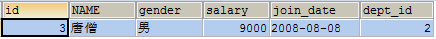

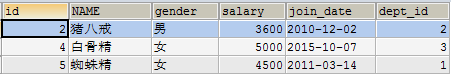

1 | SELECT AVG(salary) FROM emp; |

- 到员工表查询小于平均的员工信息

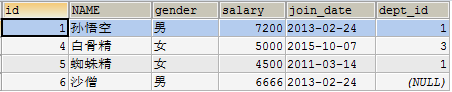

1 | SELECT * FROM emp WHERE salary < (SELECT AVG(salary) FROM emp); |

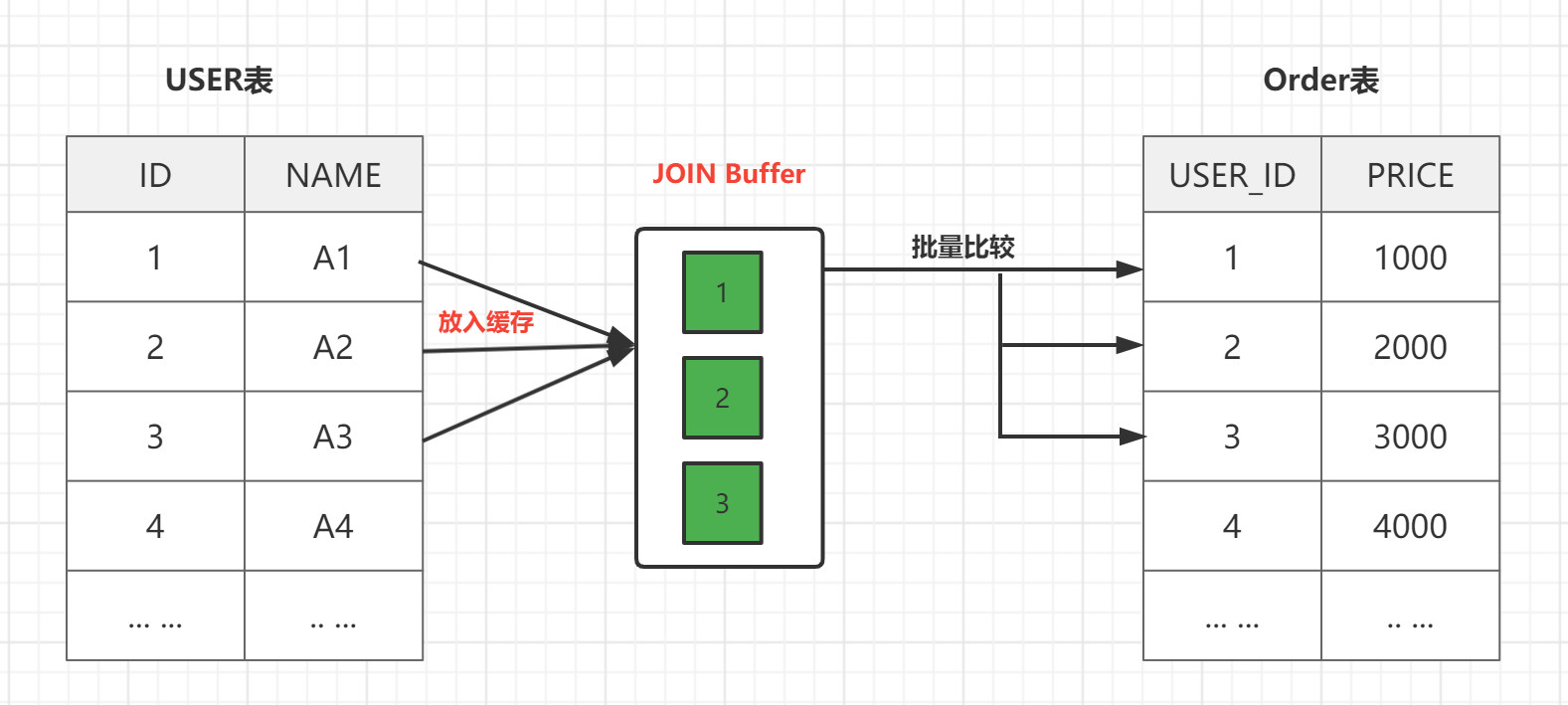

子查询结果是单列多行的时候

子查询结果只要是单列,肯定在WHERE后面作为条件 子查询结果是单列多行,结果集类似于一个数组,父查询使用IN运算符 SELECT 查询字段 FROM 表 WHERE 字段 IN (子查询);

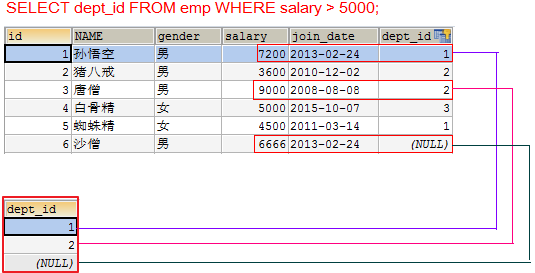

查询工资大于5000的员工,来自于哪些部门的名字

- 先查询大于5000的员工所在的部门id

1 | SELECT dept_id FROM emp WHERE salary > 5000; |

- 再查询在这些部门id中部门的名字

1 | SELECT dept.name FROM dept WHERE dept.id IN (SELECT dept_id FROM emp WHERE salary > 5000); |

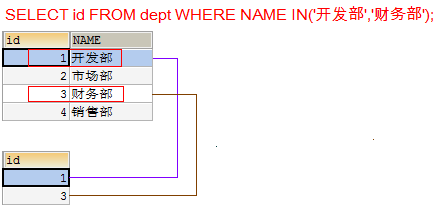

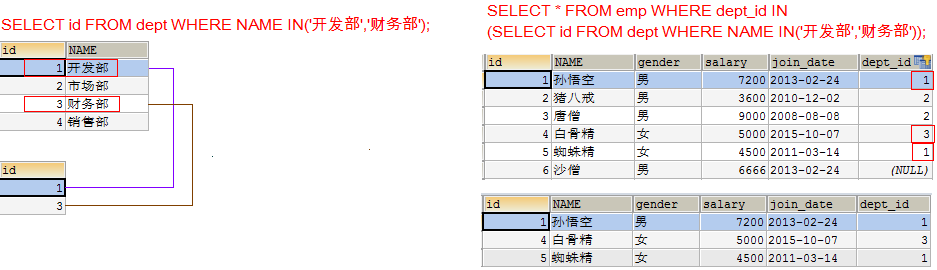

查询开发部与财务部所有的员工信息

- 先查询开发部与财务部的id

1 | SELECT id FROM dept WHERE NAME IN('开发部','财务部'); |

- 再查询在这些部门id中有哪些员工

1 | SELECT * FROM emp WHERE dept_id IN (SELECT id FROM dept WHERE NAME IN('开发部','财务部')); |

子查询的结果是多行多列

子查询结果只要是多行多列,肯定在FROM后面作为表 SELECT 查询字段 FROM (子查询) 表别名 WHERE 条件; 子查询作为表需要取别名,否则这张表没用名称无法访问表中的字段

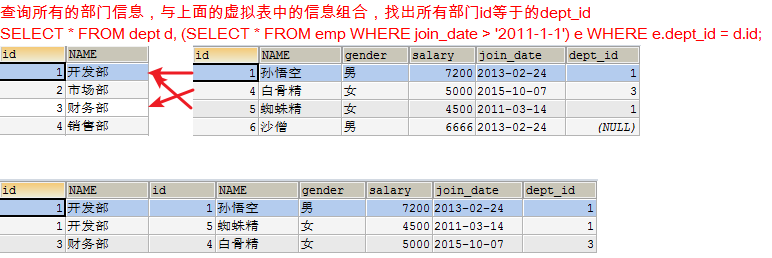

查询出2011年以后入职的员工信息,包括部门名称

- 在员工表中查询2011-1-1以后入职的员工

1 | SELECT * FROM emp WHERE join_date > '2011-1-1'; |

- 查询所有的部门信息,与上面的虚拟表中的信息组合,找出所有部门id等于的dept_id

1 | SELECT * FROM dept d, (SELECT * FROM emp WHERE join_date > '2011-1-1') e WHERE e.dept_id = d.id; |

小结

- 子查询的结果是单行单列(一个值情况), 一般放在where后面作为条件**, 通过=,>,<,<>**

1 | select ... from ... where 列 [=><<>...] (子查询) |

- 子查询的结果是单列多行, 一般放在where后面作为条件**, 通过in**

1 | select ... from ... where 列 in (子查询) |

- 子查询的结果是多行多列, 一般放在from后面作为虚拟表, 需要给虚拟表取别名

1 | select ... from (子查询) as 别名 where 条件 |

事务

环境的准备

1 | -- 账户表 |

事务的概述

我们有这样的需求:保证一组操作全部成功或者失败,就要通过事务来实现,保证数据库数据的完整性。

事务指逻辑上的一组操作,组成这组操作的单元要么全部成功,要么全部失败。

事务用来管理 DDL、DML、DCL 操作,比如 insert,update,delete 语句,默认是自动提交的。

在MySQL中的事务(Transaction)是由存储引擎实现的,在MySQL中,只有InnoDB存储引擎才支持事务。

转账案例:

- 操作: zs向李四转账100元

- 组成单元: zs钱-100, ls钱+100

- 操作成功: zs钱900,ls钱1100

- 操作失败: zs钱1000,ls钱1000

- 不可能/不应该发生: zs钱900,ls钱1000; zs钱1000,ls钱1100

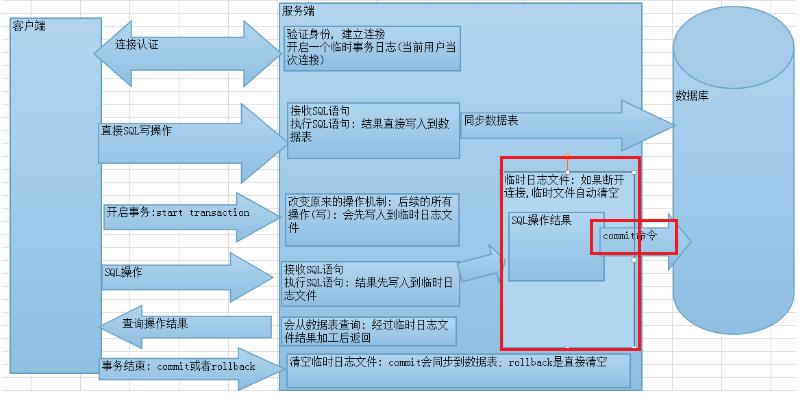

MYSQL进行事务管理

自动事务(mysql默认)

一条sql语句就是一个事务

1 | -- 场景: zs向ls转账100元 |

手动开启一个事务

方式一: 手动开启事务的方式 【掌握】

- start transaction;开启事务

- commit;提交

- rollback;回滚

1 | -- 没有异常 |

方式二: 设置MYSQL中的自动提交的参数【了解】

查看MYSQL中事务是否自动提交

1 | show variables like '%commit%'; |

设置自动提交的参数为OFF

1 | select @@autocommit; -- 查看当前自动提交的状态 |

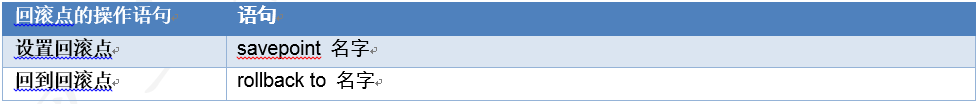

回滚点【了解】

什么是回滚点

在某些成功的操作完成之后,后续的操作有可能成功有可能失败,但是不管成功还是失败,前面操作都已经成功,可以在当前成功的位置设置一个回滚点。可以供后续失败操作返回到该位置,而不是返回所有操作,这个点称之为回滚点。

回滚点的操作语句

具体操作

- 将数据还原到1000

- 开启事务

- 让张三账号减3次钱

- 设置回滚点:savepoint three_times;

- 让张三账号减4次钱

- 回到回滚点:rollback to three_times;

- 总结:设置回滚点可以让我们在失败的时候回到回滚点,而不是回到事务开启的时候。

1 | start transaction; |

应用场景

1 | 插入大量的数据的时候. 1亿条数据 需要插入很久. |

小结

手动开启事务 语法

1

2

3start transaction; -- 开启事务

commit; -- 提交

rollback; -- 回滚注意

- 建议手动开启事务, 用一次 就开启一次

- 开启事务之后, 要么commit, 要么rollback

- 一旦commit或者rollback, 当前的事务就结束了

- 回滚到指定的回滚点, 但是这个时候事务没有结束的

事务特性和隔离级别

事务特性【面试题】

- 原子性(Atomicity)原子性是指事务是一个不可分割的工作单位,事务中的操作要么都发生,要么都不发生。

1 | eg: zs 1000; ls 1000; |

- 一致性(Consistency)事务前后数据的完整性必须保持一致.

1 | eg: zs 1000; ls 1000; 一共2000 |

- 持久性(Durability)持久性是指一个事务一旦被提交,它对数据库中数据的改变就是永久性的,接下来即使数据库发生故障也不应该对其有任何影响。

1 | eg: zs 1000 给小红 转520, 张三 提交了 |

- 隔离性(Isolation)事务的隔离性是指多个用户并发操作数据库时,一个用户的事务不能被其它用户的事务所干扰,多个并发事务之间数据要相互隔离。 简单来说: 事务之间互不干扰

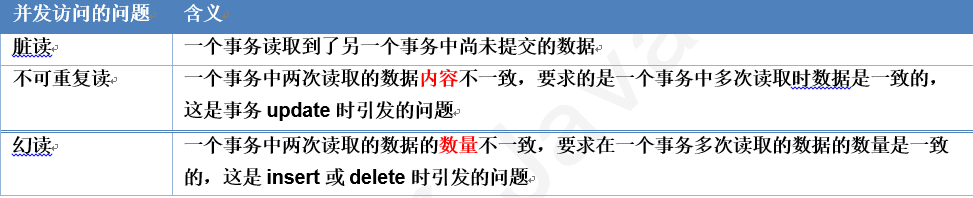

如果不考虑隔离性,会引发下面的问题

事务在操作时的理想状态: 所有的事务之间保持隔离,互不影响。因为并发操作,多个用户同时访问同一个数据。可能引发并发访问的问题

- 读未提交(Read uncommitted) 一个事务可以读取另一个未提交事务的数据,最低级别,任何情况都无法保证,会造成

脏读。 - 读已提交(Read committed) 一个事务要等另一个事务提交后才能读取数据,可避免脏读的发生,会造成

不可重复读。 - 可重复读(Repeatable read) 就是在开始读取数据(事务开启)时,不再允许修改操作,可避免脏读、不可重复读的发生,但是会造成

幻读。 - 串行(Serializable) 是最高的事务隔离级别,在该级别下,事务串行化顺序执行,可以避免脏读、不可重复读与幻读。但是这种事务隔离级别效率低下,比较耗数据库性能,一般不使用。

事务隔离级别

可以通过设置事物隔离级别解决读的问题

事务四个隔离级别

| 级别 | 名字 | 隔离级别 | 脏读 | 不可重复读 | 幻读 | 数据库默认隔离级别 |

|---|---|---|---|---|---|---|

| 1 | 读未提交 | read uncommitted | 是 | 是 | 是 | 不合理,不用 |

| 2 | 读已提交 | read committed | 否 | 是 | 是 | Oracle |

| 3 | 可重复读 | repeatable read | 否 | 否 | 是 | MySQL |

| 4 | 串行化 | serializable | 否 | 否 | 否 | 效率低,不用 |

隔离级别越高,安全性越高,性能(效率)越差。

设置隔离级别

- 设置事务隔离级别

1 | set session transaction isolation level 隔离级别; |

- 查询当前事务隔离级别

1 | select @@tx_isolation; |

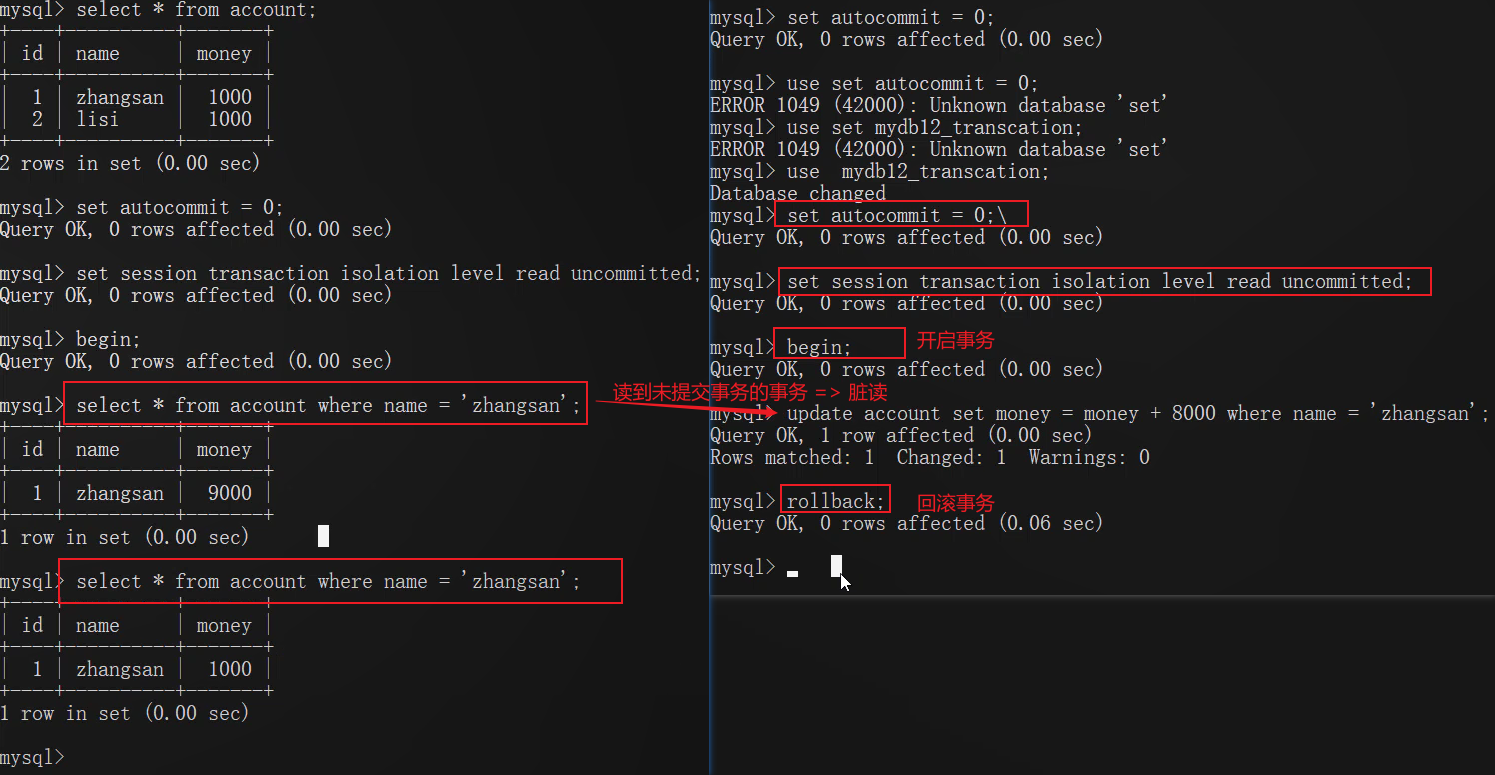

实操-演示数据库安全性问题的发生

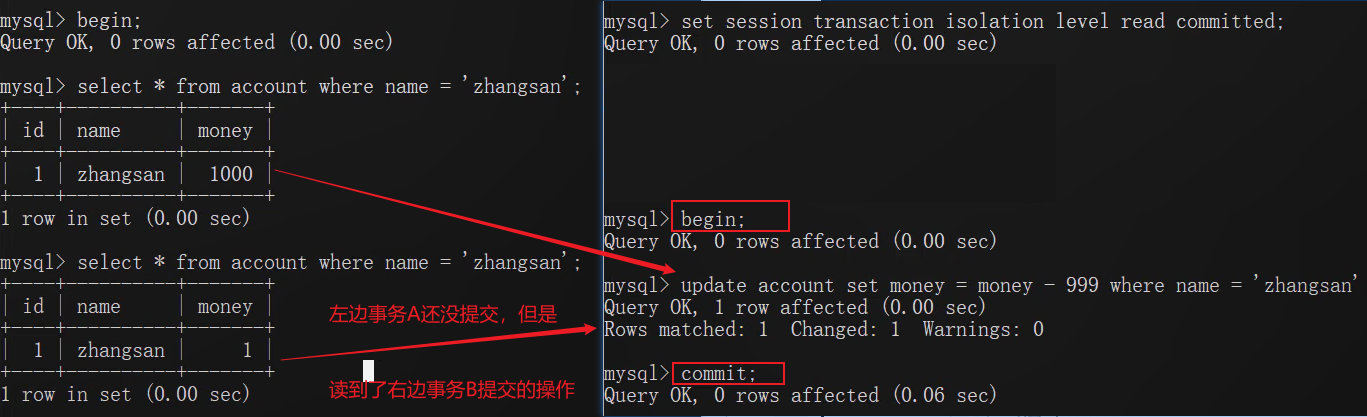

演示脏读

一个事物里面读到了另外一个事物没有提交的数据: read uncommitted

1.开启A,B窗口

2.分别查询A,B的隔离级别

1 | select @@tx_isolation; |

3.设置A窗口的隔离级别为read uncommitted(读未提交)

1 | set session transaction isolation level read uncommitted; |

4.A,B都开启事物

5.在B中zs向ls转账100,事务不提交

6.在A中查询账户

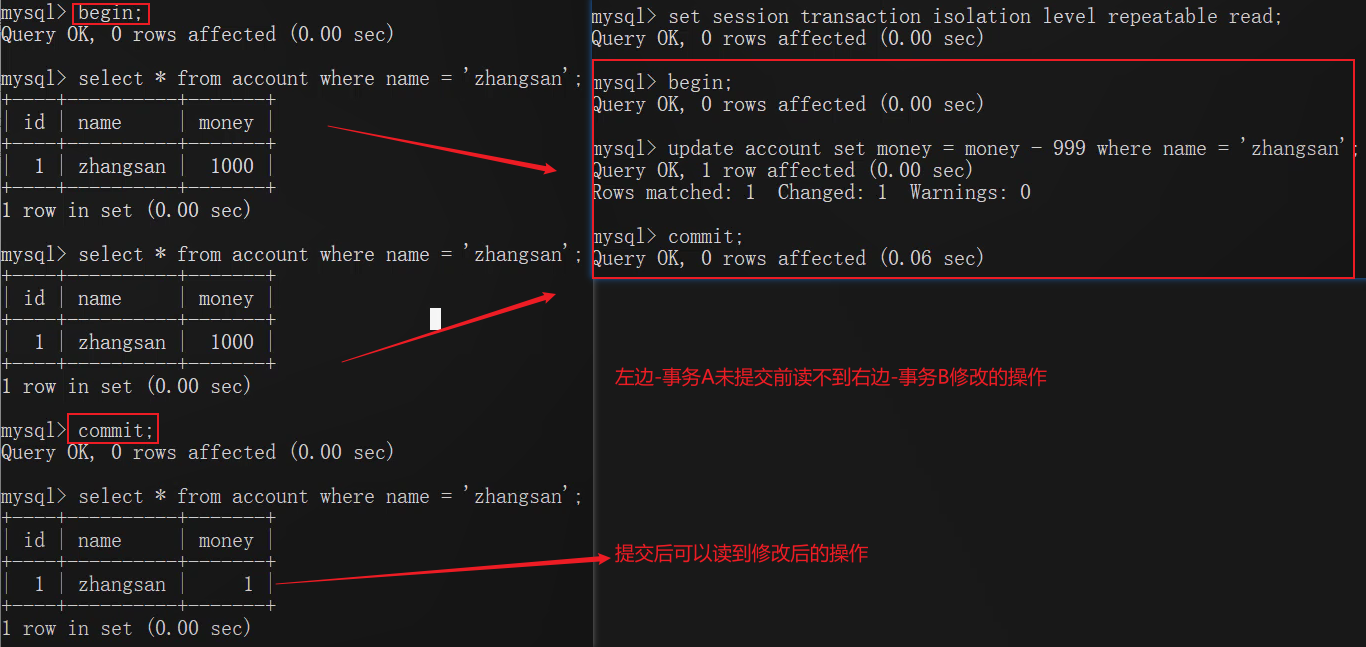

解决脏读—演示不可重复读

不可重复读: 在一个事务里面,同一条语句,两次查询的结果不一致.

1.开启A,B窗口

2.分别查询A,B的隔离级别

1 | select @@tx_isolation; |

3.设置A窗口的隔离级别为Read committed(读已提交)

1 | set session transaction isolation level Read committed; |

4.A,B都开启事物

5.在B中张三向李四转账100,事物不提交

6.在A中查询账户(避免脏读发生)

7.B中提交事物

8.在A中查询账户(两次查询的结果不一致,不可重复读发生)

解决不可重复读

1.开启A,B窗口

2.分别查询A,B的隔离级别

1 | select @@tx_isolation |

3.设置A窗口的隔离级别为Repeatable read

1 | set session transaction isolation level Repeatable read; |

4.A,B都开启事物

5.在B中张三向李四转账100,事物不提交

6.A中查询账户

7.B中提交

8.A中查询账户

9.A中结束事物,再重新查询

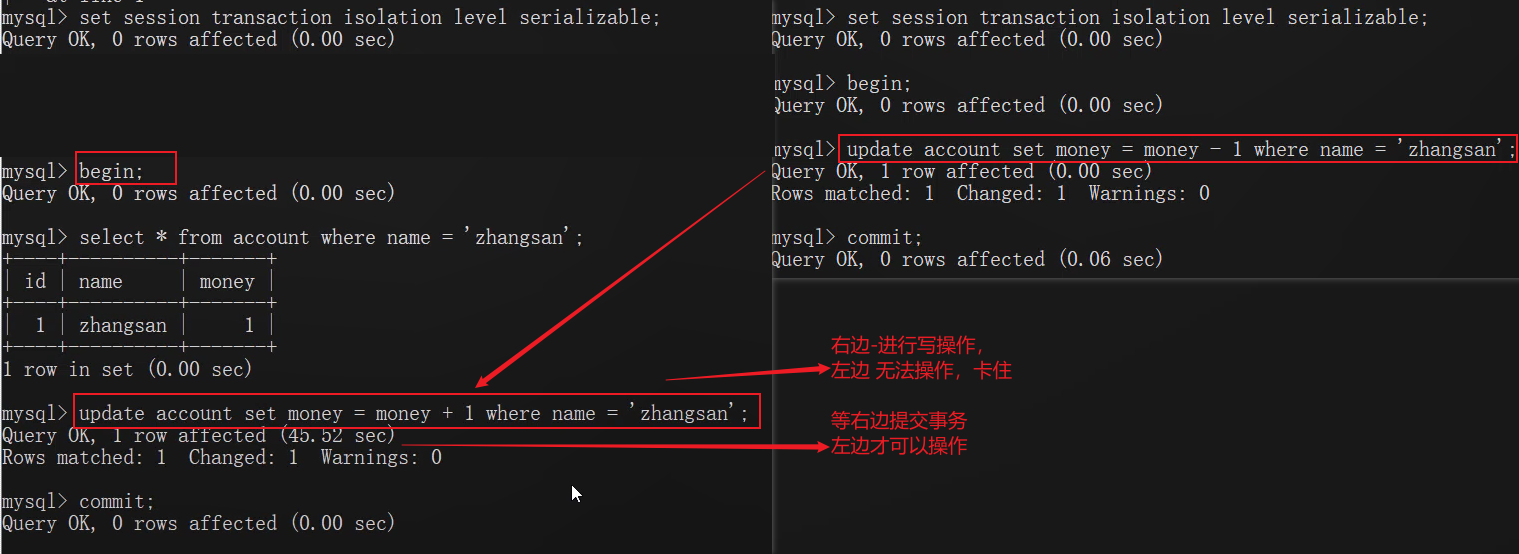

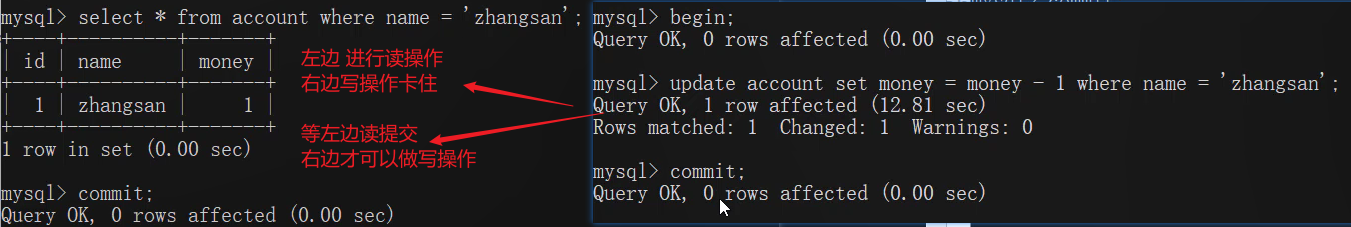

演示隔离级别Serializable

1.开启A,B窗口

2.分别查询A,B的隔离级别

1 | select @@tx_isolation |

3.设置A窗口的隔离级别为Serializable

1 | set session transaction isolation level Serializable; |

4.A,B都开始事物

5.B中向account账户插入一条数据,不提交

6.A中查询

7.在B中结束事物

8.A中查询

实际上是对表加锁了,所以序列化效率低。

锁

概述

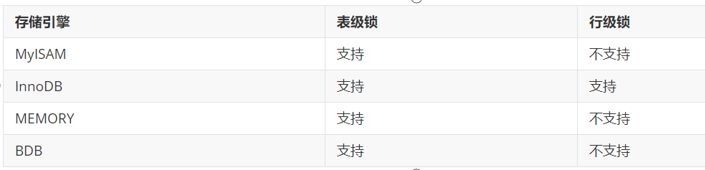

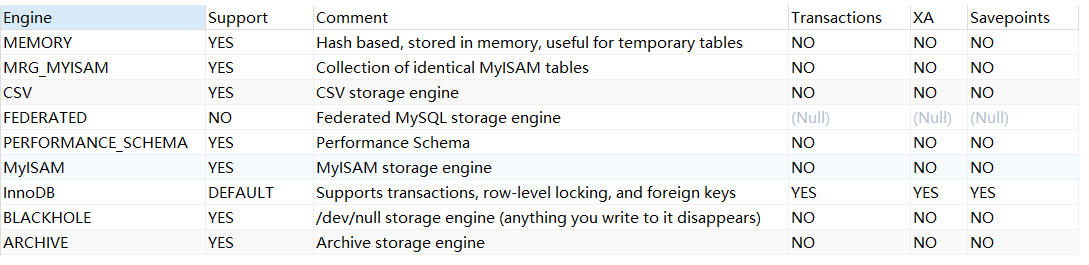

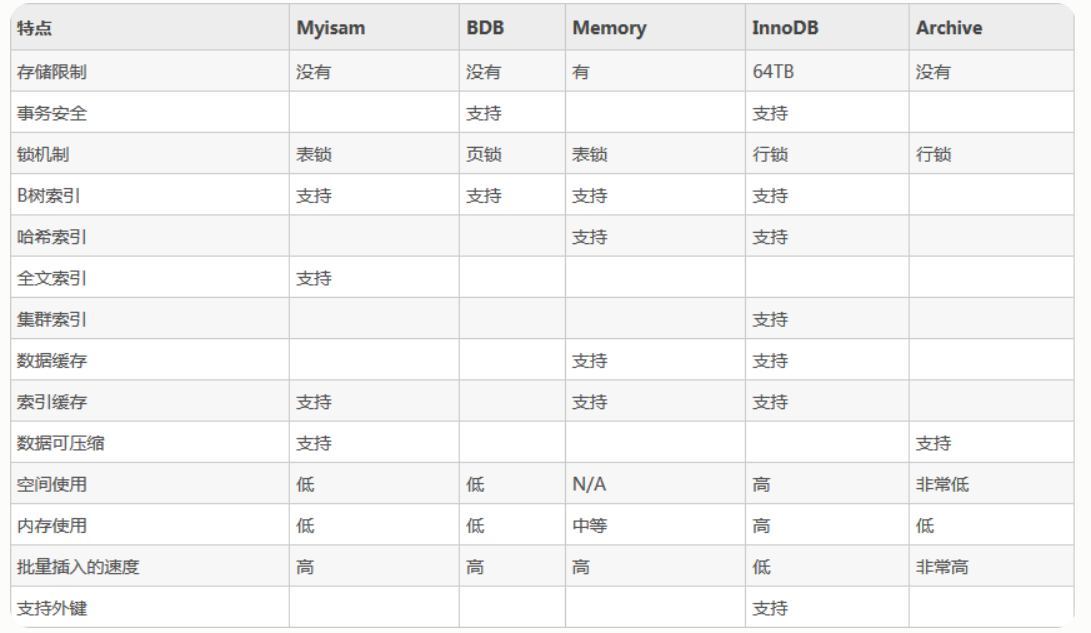

相对其他数据库而言,MySQL的锁机制比较简单,其最显著的特点是不同的存储引擎支持不同的锁机制。下表中罗列出了各存储引擎对锁的支持情况:

从上述特点可见,很难笼统地说哪种锁更好,只能就具体应用的特点来说哪种锁更合适!仅从锁的角度来说:表级锁更适合于以查询为主,只有少量按索引条件更新数据的应用,如Web 应用;

而行级锁则更适合于有大量按索引条件并发更新少量不同数据,同时又有并查询的应用,如一些在线事务处理(OLTP)系统。

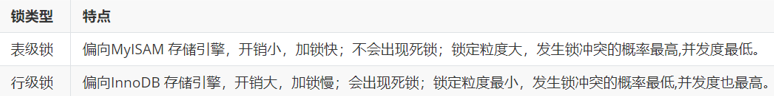

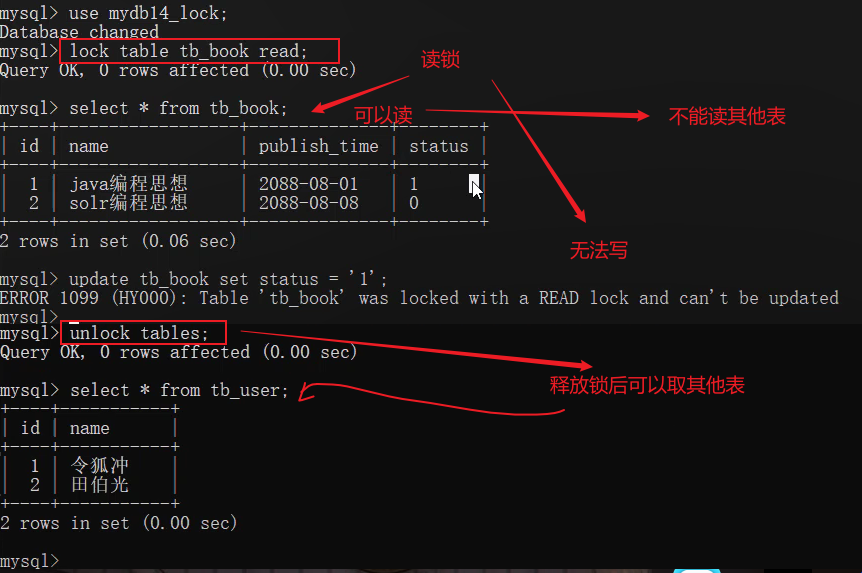

MyISAM表锁

MyISAM 存储引擎只支持表锁

如何加表锁:

MyISAM

在执行查询语句(SELECT)前,会自动给涉及的所有表加读锁,

在执行更新操作(UPDATE、DELETE、INSERT 等)前,会自动给涉及的表加写锁,

这个过程并不需要用户干预,因此,用户一般不需要直接用 LOCK TABLE 命令给 MyISAM 表显式加锁。

1 | 加读锁 : lock table table_name read; |

表锁特点:

1) 对MyISAM 表的读操作,不会阻塞其他用户对同一表的读请求,但会阻塞对同一表的写请求;

2) 对MyISAM 表的写操作,则会阻塞其他用户对同一表的读和写操作;

简而言之,就是读锁会阻塞写,但是不会阻塞读。而写锁,则既会阻塞读,又会阻塞写。

此外,MyISAM 的读写锁调度是写优先,这也是MyISAM不适合做写为主的表的存储引擎的原因。因为写锁后,其他线程不能做任何操作,大量的更新会使查询很难得到锁,从而造成永远阻塞。

1 | -- MySQL的锁机制 |

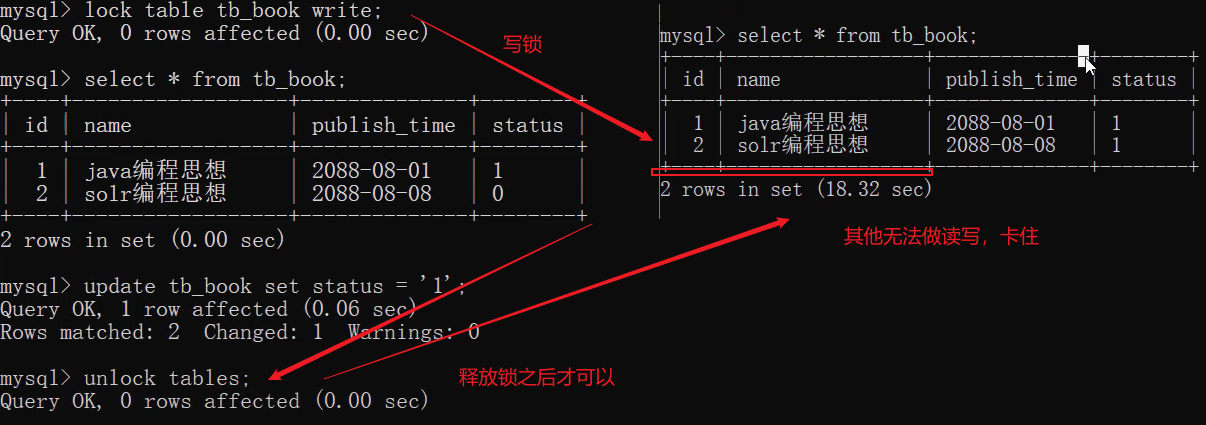

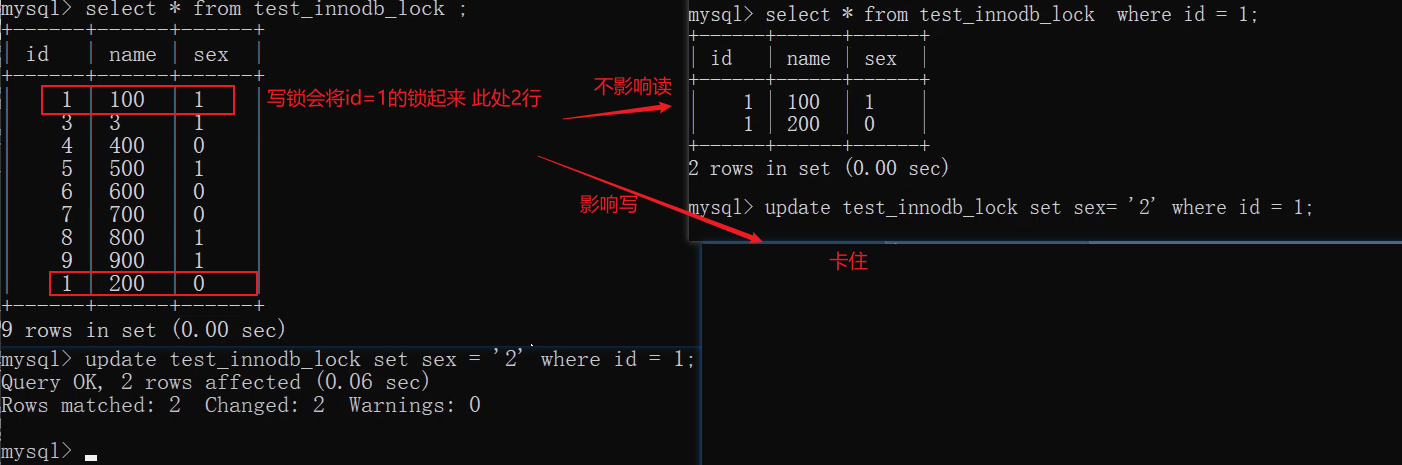

InnoDB行锁

行锁特点 :偏向InnoDB 存储引擎,开销大,加锁慢;会出现死锁;锁定粒度最小,发生锁冲突的概率最低,并发度也最高。

InnoDB 与 MyISAM 的最大不同有两点:一是支持事务;二是 采用了行级锁。

InnoDB 实现了以下两种类型的行锁。

- 共享锁(S):又称为读锁,简称S锁,共享锁就是多个事务对于同一数据可以共享一把锁,都能访问到数据,但是只能读不能修改。

- 排他锁(X):又称为写锁,简称X锁,排他锁就是不能与其他锁并存,如一个事务获取了一个数据行的排他锁,其他事务就不能再获取该行的其他锁,包括共享锁和排他锁,但是获取排他锁的事务是可以对数据就行读取和修改。

对于UPDATE、DELETE和INSERT语句,InnoDB会自动给涉及数据集加排他锁(X);

对于普通SELECT语句,InnoDB不会加任何锁;

1 | 共享锁(S):SELECT * FROM table_name WHERE ... LOCK IN SHARE MODE |

案例:

1 | -- 行锁 |

日志

在任何一种数据库中,都会有各种各样的日志,记录着数据库工作的方方面面,以帮助数据库管理员追踪数据库曾经发生过的各种事件。MySQL 也不例外。

错误日志

错误日志是 MySQL 中最重要的日志之一,它记录了当 mysqld 启动和停止时,以及服务器在运行过程中发生任何严重错误时的相关信息。当数据库出现任何故障导致无法正常使用时,可以首先查看此日志。

该日志是默认开启的 , 默认存放目录为 mysql 的数据目录, 默认的日志文件名为 hostname.err(hostname是主机名)。

查看日志位置指令 : show variables like 'log_error%';

二进制日志-binlog

二进制日志(BINLOG)记录了所有的 DDL(数据定义语言)语句和 DML(数据操纵语言)语句,但是不包括数据查询语句。此日志对于灾难时的数据恢复起着极其重要的作用,MySQL的主从复制, 就是通过该binlog实现的。

二进制日志,MySQl8.0默认已经开启,低版本的MySQL的需要通过配置文件开启,并配置MySQL日志的格式。

Windows系统:my.ini Linux系统:my.cnf

1 | #配置开启binlog日志, 日志的文件前缀为 mysqlbin -----> 生成的文件名如 : mysqlbin.000001,mysqlbin.000002 |

STATEMENT 该日志格式在日志文件中记录的都是SQL语句(statement),每一条对数据进行修改的SQL都会记录在日志文件中,通过Mysql提供的mysqlbinlog工具,可以清晰的查看到每条语句的文本。主从复制的时候,从库(slave)会将日志解析为原文本,并在从库重新执行一次。

ROW

该日志格式在日志文件中记录的是每一行的数据变更,而不是记录SQL语句。比如,执行SQL语句 : update tb_book set status='1' , 如果是STATEMENT 日志格式,在日志中会记录一行SQL文件; 如果是ROW,由于是对全表进行更新,也就是每一行记录都会发生变更,ROW 格式的日志中会记录每一行的数据变更。

MIXED

混合了STATEMENT 和 ROW两种格式。

1 | -- 查看MySQL是否开启了binlog日志 |

查询日志

查询日志中记录了客户端的所有操作语句,而二进制日志不包含查询数据的SQL语句。

默认情况下, 查询日志是未开启的。如果需要开启查询日志,可以设置以下配置 :

1 | #该选项用来开启查询日志 , 可选值 : 0 或者 1 ; 0 代表关闭, 1 代表开启 |

操作:

1 | -- 查看MySQL是否开启了查询日志 |

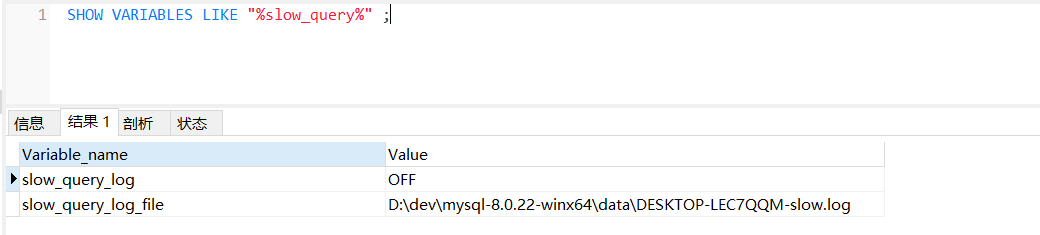

慢查询日志

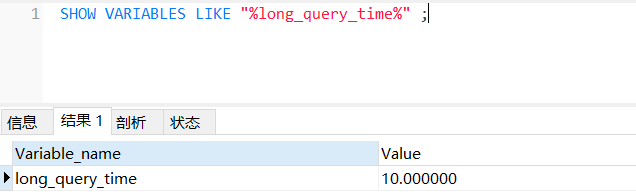

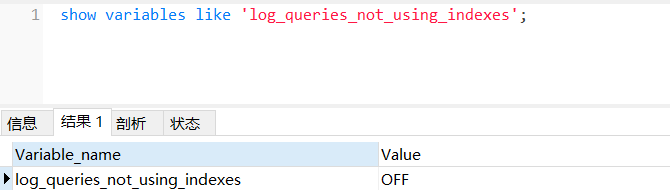

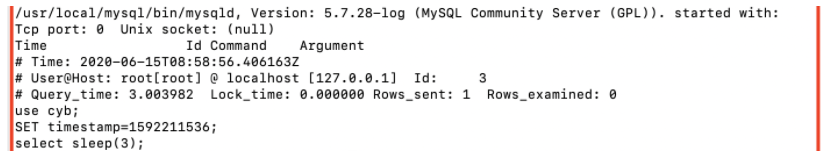

慢查询日志记录了所有执行时间超过参数 long_query_time 设置值并且扫描记录数不小于 min_examined_row_limit 的所有的SQL语句的日志。long_query_time 默认为 10 秒,最小为 0, 精度可以到微秒。

1 | # 该参数用来控制慢查询日志是否开启, 可取值: 1 和 0 , 1 代表开启, 0 代表关闭 |

也可以用命令开启

1 | -- 查看MySQL是否开启了慢查询日志 |

数据的备份和还原

实操-数据的备份和还原

在服务器进行数据传输、数据存储和数据交换,就有可能产生数据故障。比如发生意外停机或存储介质损坏。这时,如果没有采取数据备份和数据恢复手段与措施,就会导致数据的丢失,造成的损失是无法弥补与估量的。

命令行方式

- 备份格式

1 | mysqldump -u用户名 -p密码 数据库 > 文件的路径 |

- 还原格式

1 | SOURCE 导入文件的路径 |

注意:还原的时候需要先登录MySQL,并创建数据库和选中对应的数据库

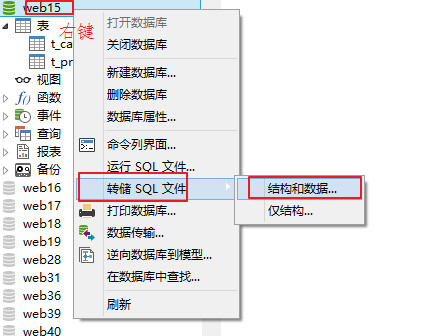

使用navicat备份和还原

- 备份

- 还原

会使用navicat操作就行了, 工作里面一般是运维在处理, 运维处理的话一般使用定时任务自动备份.

数据库设计三大范式

数据库设计三大范式

好的数据库设计对数据的存储性能和后期的程序开发,都会产生重要的影响。

建立科学的,规范的数据库就需要满足一些规则来优化数据的设计和存储,这些规则就称为范式。

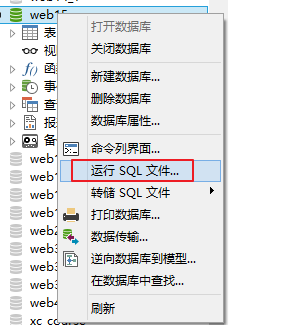

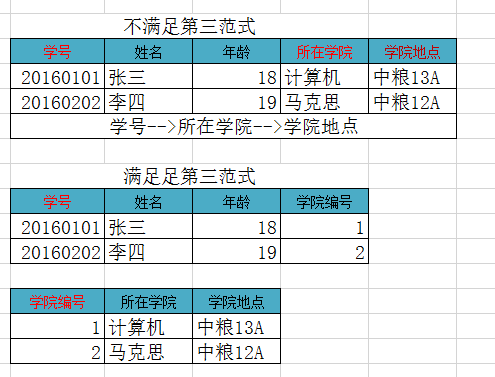

1NF

概述

数据库表的每一列都是不可分割的原子数据项,不能是集合、数组等非原子数据项。即表中的某个列有多个值时,必须拆分为不同的列。简而言之,第一范式每一列不可再拆分,称为原子性

应用

总结

如果不遵守第一范式,查询出数据还需要进一步处理(查询不方便)。遵守第一范式,需要什么字段的数据就查询什么数据(方便查询)

2NF

概述

在满足第一范式的前提下,表中的每一个字段都完全依赖于主键。所谓完全依赖是指不能存在仅依赖主键一部分的列。简而言之,第二范式就是在第一范式的基础上所有列完全依赖于主键列。当存在一个复合主键包含多个主键列的时候,才会发生不符合第二范式的情况。比如有一个主键有两个列,不能存在这样的属性,它只依赖于其中一个列,这就是不符合第二范式。

简而言之,第二范式需要满足:

- 一张表只描述一件事情

- 表中的每一个列都依赖于主键

应用

总结

如果不准守第二范式,数据冗余,相同数据无法区分。遵守第二范式减少数据冗余,通过主键区分相同数据。

3NF

概述

在满足第二范式的前提下,表中的每一列都直接依赖于主键,而不是通过其它的列来间接依赖于主键。简而言之,第三范式就是所有列不依赖于其它非主键列,也就是在满足2NF的基础上,任何非主列不得传递依赖于主键。所谓传递依赖,指的是如果存在”A → B → C”的决定关系,则C传递依赖于A。因此,满足第三范式的数据库表应该不存在如下依赖关系:主键列 → 非主键列x → 非主键列y

应用

总结

如果不准守第三范式,可能会有相同数据无法区分,修改数据的时候多张表都需要修改(不方便修改)。遵守第三范式通过id可以区分相同数据,修改数据的时候只需要修改一张表(方便修改)。

小结

🔖MySQL再次进阶

函数

在MySQL中,为了提高代码重用性和隐藏实现细节,MySQL提供了很多函数。函数可以理解为别人封装好的模板代码

聚合函数

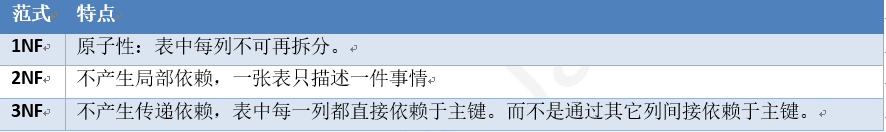

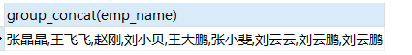

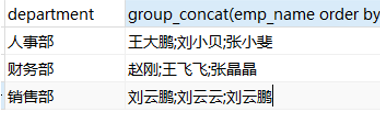

在MySQL中,聚合函数主要由:count,sum,min,max,avg,这些聚合函数我们之前都学过,不再重复。这里我们学习另外一个函数:group_concat(),该函数用户实现行的合并

group_concat()

group_concat()函数首先根据group by指定的列进行分组,并且用分隔符分隔,将同一个分组中的值连接起来,返回一个字符串结果。

1 | group_concat([distinct] 字段名 [order by 排序字段 asc/desc] [separator '分隔符']) |

说明:

(1)使用distinct可以排除重复值; (2)如果需要对结果中的值进行排序,可以使用order by子句; (3)separator是一个字符串值,默认为逗号

准备数据:

1 | create database mydb4; |

操作:

1 | -- 将所有员工的名字合并成一行 |

1 | -- 指定分隔符合并 |

1 | -- 指定排序方式和分隔符 |

数学函数

| 函数名 | 描述 | 实例 |

|---|---|---|

ABS(x) |

返回 x 的绝对值 | 返回 -1 的绝对值:SELECT ABS(-1) – 返回1 |

CEIL(x) |

返回大于或等于 x 的最小整数 | SELECT CEIL(1.5) – 返回2 |

FLOOR(x) |

返回小于或等于 x 的最大整数 | 小于或等于 1.5 的整数:SELECT FLOOR(1.5) – 返回1 |

GREATEST(expr1, expr2, expr3, ...) |

返回列表中的最大值 | 返回以下数字列表中的最大值:SELECT GREATEST(3, 12, 34, 8, 25); – 34 返回以下字符串列表中的最大值:SELECT GREATEST(“Google”, “Runoob”, “Apple”); – Runoob |

LEAST(expr1, expr2, expr3, ...) |

返回列表中的最小值 | 返回以下数字列表中的最小值:SELECT LEAST(3, 12, 34, 8, 25); – 3 返回以下字符串列表中的最小值:SELECT LEAST(“Google”, “Runoob”, “Apple”); – Apple |

MAX(expression) |

返回字段 expression 中的最大值 | 返回数据表 Products 中字段 Price 的最大值: SELECT MAX(Price) AS LargestPrice FROM Products; |

MIN(expression) |

返回字段 expression 中的最小值 | 返回数据表 Products 中字段 Price 的最小值: SELECT MIN(Price) AS MinPrice FROM Products; |

| MOD(x,y) | 返回 x 除以 y 以后的余数 | 5 除于 2 的余数:SELECT MOD(5,2) – 1 |

| PI() | 返回圆周率(3.141593) | SELECT PI() –3.141593 |

| POW(x,y) | 返回 x 的 y 次方 | 2 的 3 次方:SELECT POW(2,3) – 8 |

| RAND() | 返回 0 到 1 的随机数 | SELECT RAND() –0.93099315644334 |

ROUND(x) |

返回离 x 最近的整数(遵循四舍五入) | SELECT ROUND(1.23456) –1 |

ROUND(x,y) |

返回指定位数的小数(遵循四舍五入) | SELECT ROUND(1.23456,3) –1.235 |

| TRUNCATE(x,y) | 返回数值 x 保留到小数点后 y 位的值(与 ROUND 最大的区别是不会进行四舍五入) | SELECT TRUNCATE(1.23456,3) – 1.234 |

字符串函数

| 函数 | 描述 | 实例 |

|---|---|---|

| CHAR_LENGTH(s) | 返回字符串 s 的字符数,注意length(返回的是字节的长度,汉字会有区别,utf8一个汉字3个字节) | 返回字符串 RUNOOB 的字符数: SELECT CHAR_LENGTH(“RUNOOB”) AS LengthOfString; |

| CHARACTER_LENGTH(s) | 返回字符串 s 的字符数,相当于char_length的简写 | 返回字符串 RUNOOB 的字符数: SELECT CHARACTER_LENGTH(“RUNOOB”) AS LengthOfString; |

| CONCAT(s1,s2…sn) | 字符串 s1,s2 等多个字符串合并为一个字符串 | 合并多个字符串: SELECT CONCAT(“SQL “, “Runoob “, “Gooogle “, “Facebook”) AS ConcatenatedString; |

| CONCAT_WS(x, s1,s2…sn) | 同 CONCAT(s1,s2,…) 函数,但是每个字符串之间要加上 x,x 可以是分隔符 | 合并多个字符串,并添加分隔符: SELECT CONCAT_WS(“-“, “SQL”, “Tutorial”, “is”, “fun!”)AS ConcatenatedString; |

| FIELD(s,s1,s2…) | 返回第一个字符串 s 在字符串列表(s1,s2…)中的位置 | 返回字符串 c 在列表值中的位置: SELECT FIELD(“c”, “a”, “b”, “c”, “d”, “e”); |

| LTRIM(s) | 去掉字符串 s 开始处的空格 | 去掉字符串 RUNOOB开始处的空格: SELECT LTRIM(“ RUNOOB”) AS LeftTrimmedString;– RUNOOB |

| MID(s,n,len) | 从字符串 s 的 n 位置截取长度为 len 的子字符串,同 SUBSTRING(s,n,len) | 从字符串 RUNOOB 中的第 2 个位置截取 3个 字符: SELECT MID(“RUNOOB”, 2, 3) AS ExtractString; – UNO |

| POSITION(s1 IN s) | 从字符串 s 中获取 s1 的开始位置 | 返回字符串 abc 中 b 的位置: SELECT POSITION(‘b’ in ‘abc’) – 2 |

| REPLACE(s,s1,s2) | 将字符串 s2 替代字符串 s 中的字符串 s1 | 将字符串 abc 中的字符 a 替换为字符 x: SELECT REPLACE(‘abc’,’a’,’x’) –xbc |

| REVERSE(s) | 将字符串s的顺序反过来 | 将字符串 abc 的顺序反过来: SELECT REVERSE(‘abc’) – cba |

| RIGHT(s,n) | 返回字符串 s 的后 n 个字符 | 返回字符串 runoob 的后两个字符: SELECT RIGHT(‘runoob’,2) – ob |

| RTRIM(s) | 去掉字符串 s 结尾处的空格 | 去掉字符串 RUNOOB 的末尾空格: SELECT RTRIM(“RUNOOB “) AS RightTrimmedString; – RUNOOB |

| STRCMP(s1,s2) | 比较字符串 s1 和 s2,如果 s1 与 s2 相等返回 0 ,如果 s1>s2 返回 1,如果 s1<s2 返回 -1 | 比较字符串: SELECT STRCMP(“runoob”, “runoob”); – 0 |

| SUBSTR(s, start, length) | 从字符串 s 的 start 位置截取长度为 length 的子字符串,和substring一样 | 从字符串 RUNOOB 中的第 2 个位置截取 3个 字符: SELECT SUBSTR(“RUNOOB”, 2, 3) AS ExtractString; – UNO |

| SUBSTRING(s, start, length) | 从字符串 s 的 start 位置截取长度为 length 的子字符串 | 从字符串 RUNOOB 中的第 2 个位置截取 3个 字符: SELECT SUBSTRING(“RUNOOB”, 2, 3) AS ExtractString; – UNO |

| TRIM(s) | 去掉字符串 s 开始和结尾处的空格 | 去掉字符串 RUNOOB 的首尾空格: SELECT TRIM(‘ RUNOOB ‘) AS TrimmedString; |

| UCASE(s) | 将字符串转换为大写,和UPPER一样 | 将字符串 runoob 转换为大写: SELECT UCASE(“runoob”); – RUNOOB |

| UPPER(s) | 将字符串转换为大写 | 将字符串 runoob 转换为大写: SELECT UPPER(“runoob”); – RUNOOB |

| LCASE(s) | 将字符串 s 的所有字母变成小写字母,和LOWER一样 | 字符串 RUNOOB 转换为小写: SELECT LCASE(‘RUNOOB’) – runoob |

| LOWER(s) | 将字符串 s 的所有字母变成小写字母 | 字符串 RUNOOB 转换为小写: SELECT LOWER(‘RUNOOB’) – runoob |

日期函数

| 函数名 | 描述 | 实例 |

|---|---|---|

| UNIX_TIMESTAMP() | 返回从1970-01-01 00:00:00到当前毫秒值 | select UNIX_TIMESTAMP() -> 1632729059 |

| UNIX_TIMESTAMP(DATE_STRING) | 将制定日期转为毫秒值时间戳 | SELECT UNIX_TIMESTAMP(‘2011-12-07 13:01:03’); |

| FROM_UNIXTIME(BIGINT UNIXTIME[, STRING FORMAT]) | 将毫秒值时间戳转为指定格式日期 | SELECT FROM_UNIXTIME(1598079966,’%Y-%m-%d %H:%i:%s’); (1598079966,’%Y-%m-%d %H:%i:%s’); -> 2020-08-22 15-06-06 |

| CURDATE() | 返回当前日期 | SELECT CURDATE();-> 2018-09-19 |

| CURRENT_DATE() | 返回当前日期 | SELECT CURRENT_DATE();-> 2018-09-19 |

| CURRENT_TIME | 返回当前时间 | SELECT CURRENT_TIME();-> 19:59:02 |

| CURTIME() | 返回当前时间 | SELECT CURTIME();-> 19:59:02 |

| CURRENT_TIMESTAMP() | 返回当前日期和时间 | SELECT CURRENT_TIMESTAMP()-> 2018-09-19 20:57:43 |

| DATE() | 从日期或日期时间表达式中提取日期值 | SELECT DATE(“2017-06-15”); -> 2017-06-15 |

| DATEDIFF(d1,d2) | 计算日期 d1->d2 之间相隔的天数 | SELECT DATEDIFF(‘2001-01-01’,’2001-02-02’)-> -32 |

| TIMEDIFF(time1, time2) | 计算时间差值 | SELECT TIMEDIFF(“13:10:11”, “13:10:10”);-> 00:00:01 |

| DATE_FORMAT(d,f) | 按表达式 f的要求显示日期 d | SELECT DATE_FORMAT(‘2011-11-11 11:11:11’,’%Y-%m-%d %r’)-> 2011-11-11 11:11:11 AM |

| STR_TO_DATE(string, format_mask) | 将字符串转变为日期 | SELECT STR_TO_DATE(“August 10 2017”, “%M %d %Y”);-> 2017-08-10 |

| DATE_SUB(date,INTERVAL expr type) | 函数从日期减去指定的时间间隔。 | Orders 表中 OrderDate 字段减去 2 天:SELECT OrderId,DATE_SUB(OrderDate,INTERVAL 2 DAY) AS OrderPayDateFROM Orders |

| ADDDATE/DATE_ADD(d,INTERVAL expr type) | 计算起始日期 d 加上一个时间段后的日期,type 值可以是:MICROSECOND SECOND MINUTE HOUR DAY WEEK MONTH QUARTER YEAR DAY_MINUTE DAY_HOUR YEAR_MONTH |

SELECT DATE_ADD(“2017-06-15”, INTERVAL 10 DAY); -> 2017-06-25 SELECT DATE_ADD(“2017-06-15 09:34:21”, INTERVAL 15 MINUTE); -> 2017-06-15 09:49:21 SELECT DATE_ADD(“2017-06-15 09:34:21”, INTERVAL -3 HOUR); ->2017-06-15 06:34:21 SELECT DATE_ADD(“2017-06-15 09:34:21”, INTERVAL -3 HOUR); ->2017-04-15 |

| DATE_ADD(d,INTERVAL expr type) | 计算起始日期 d 加上一个时间段后的日期,type 值可以是:SECOND_MICROSECOND MINUTE_MICROSECOND MINUTE_SECOND HOUR_MICROSECOND HOUR_SECOND HOUR_MINUTE DAY_MICROSECOND DAY_SECOND DAY_MINUTE DAY_HOUR YEAR_MONTH |

SELECT DATE_ADD(“2017-06-15”, INTERVAL 10 DAY); -> 2017-06-25 SELECT DATE_ADD(“2017-06-15 09:34:21”, INTERVAL 15 MINUTE); -> 2017-06-15 09:49:21 SELECT DATE_ADD(“2017-06-15 09:34:21”, INTERVAL -3 HOUR); ->2017-06-15 06:34:21 SELECT DATE_ADD(“2017-06-15 09:34:21”, INTERVAL -3 HOUR); ->2017-04-15 |

| EXTRACT(type FROM d) | 从日期 d 中获取指定的值,type 指定返回的值。type可取值为: MICROSECOND SECOND MINUTE HOUR |

SELECT EXTRACT(MINUTE FROM ‘2011-11-11 11:11:11’) -> 11 |

| LAST_DAY(d) | 返回给给定日期的那一月份的最后一天 | SELECT LAST_DAY(“2017-06-20”);-> 2017-06-30 |

| MAKEDATE(year, day-of-year) | 基于给定参数年份 year 和所在年中的天数序号 day-of-year 返回一个日期 | SELECT MAKEDATE(2017, 3);-> 2017-01-03 |

| YEAR(d) | 返回年份 | SELECT YEAR(“2017-06-15”);-> 2017 |

| MONTH(d) | 返回日期d中的月份值,1 到 12 | SELECT MONTH(‘2011-11-11 11:11:11’)->11 |

| DAY(d) | 返回日期值 d 的日期部分 | SELECT DAY(“2017-06-15”); -> 15 |

| HOUR(t) | 返回 t 中的小时值 | SELECT HOUR(‘1:2:3’)-> 1 |

| MINUTE(t) | 返回 t 中的分钟值 | SELECT MINUTE(‘1:2:3’)-> 2 |

| SECOND(t) | 返回 t 中的秒钟值 | SELECT SECOND(‘1:2:3’)-> 3 |

| QUARTER(d) | 返回日期d是第几季节,返回 1 到 4 | SELECT QUARTER(‘2011-11-11 11:11:11’)-> 4 |

| MONTHNAME(d) | 返回日期当中的月份名称,如 November | SELECT MONTHNAME(‘2011-11-11 11:11:11’)-> November |

| MONTH(d) | 返回日期d中的月份值,1 到 12 | SELECT MONTH(‘2011-11-11 11:11:11’)->11 |

| DAYNAME(d) | 返回日期 d 是星期几,如 Monday,Tuesday | SELECT DAYNAME(‘2011-11-11 11:11:11’)->Friday |

| DAYOFMONTH(d) | 计算日期 d 是本月的第几天 | SELECT DAYOFMONTH(‘2011-11-11 11:11:11’)->11 |

| DAYOFWEEK(d) | 日期 d 今天是星期几,1 星期日,2 星期一,以此类推 | SELECT DAYOFWEEK(‘2011-11-11 11:11:11’)->6 |

| DAYOFYEAR(d) | 计算日期 d 是本年的第几天 | SELECT DAYOFYEAR(‘2011-11-11 11:11:11’)->315 |

| WEEK(d) | 计算日期 d 是本年的第几个星期,范围是 0 到 53 | SELECT WEEK(‘2011-11-11 11:11:11’)-> 45 |

| WEEKDAY(d) | 日期 d 是星期几,0 表示星期一,1 表示星期二 | SELECT WEEKDAY(“2017-06-15”);-> 3 |

| WEEKOFYEAR(d) | 计算日期 d 是本年的第几个星期,范围是 0 到 53 | SELECT WEEKOFYEAR(‘2011-11-11 11:11:11’)-> 45 |

| YEARWEEK(date, mode) | 返回年份及第几周(0到53),mode 中 0 表示周天,1表示周一,以此类推 | SELECT YEARWEEK(“2017-06-15”);-> 201724 |

| NOW() | 返回当前日期和时间 | SELECT NOW()-> 2018-09-19 20:57:43 |

控制流函数

if逻辑判断语句

| 格式 | 解释 | 案例 |

|---|---|---|

| IF(expr,v1,v2) | 如果表达式 expr 成立,返回结果 v1;否则,返回结果 v2。 | SELECT IF(1 > 0,’正确’,’错误’) ->正确 |

| IFNULL(v1,v2) | 如果 v1 的值不为 NULL,则返回 v1,否则返回 v2。 | SELECT IFNULL(null,’Hello Word’)->Hello Word |

| ISNULL(expression) | 判断表达式是否为 NULL | SELECT ISNULL(NULL);->1 |

| NULLIF(expr1, expr2) | 比较两个字符串,如果字符串 expr1 与 expr2 相等 返回 NULL,否则返回 expr1 | SELECT NULLIF(25, 25);-> |

case when语句

1 | CASE expression |

CASE 表示函数开始,END 表示函数结束。如果 condition1 成立,则返回 result1, 如果 condition2 成立,则返回 result2,当全部不成立则返回 result,而当有一个成立之后,后面的就不执行了

1 | select case 100 when 50 then 'tom' when 100 then 'mary'else 'tim' end ; |

操作例子:

1 | use mydb4; |

窗口函数🆕

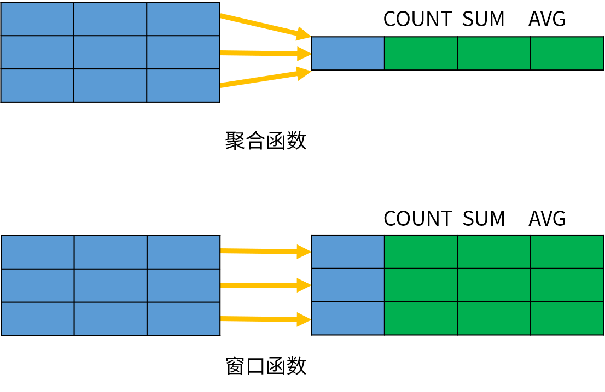

介绍

MySQL 8.0 新增窗口函数,窗口函数又被称为开窗函数,与Oracle 窗口函数类似,属于MySQL的一大特点.

非聚合窗口函数是相对于聚函数来说的。聚合函数是对一组数据计算后返回单个值(即分组),非聚合函数一次只会处理一行数据。窗口聚合函数在行记录上计算某个字段的结果时,可将窗口范围内的数据输入到聚合函数中,并不改变行数。

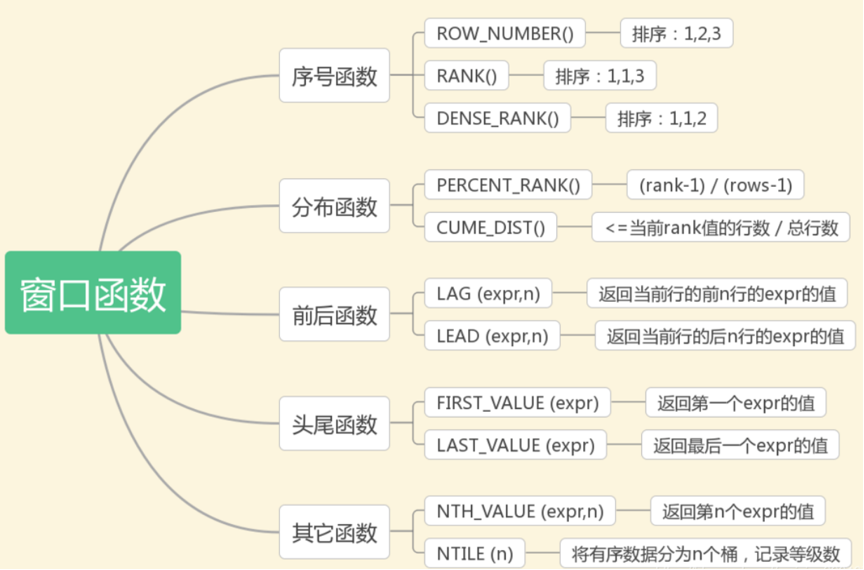

类别

另外还有开窗聚合函数: SUM,AVG,MIN,MAX

语法结构

1 | window_function ( expr ) OVER ( |

其中,window_function 是窗口函数的名称;expr 是参数,有些函数不需要参数;OVER子句包含三个选项:

- 分区(PARTITION BY):PARTITION BY选项用于将数据行拆分成多个分区(组),它的作用类似于GROUP BY分组。如果省略了 PARTITION BY,所有的数据作为一个组进行计算

- 排序(ORDER BY):OVER 子句中的ORDER BY选项用于指定分区内的排序方式,与 ORDER BY 子句的作用类似

- 窗口大小(frame_clause):frame_clause选项用于在当前分区内指定一个计算窗口,也就是一个与当前行相关的数据子集。

序号函数

可以用来实现分组排序,并添加序号。

1 | row_number()|rank()|dense_rank() over ( |

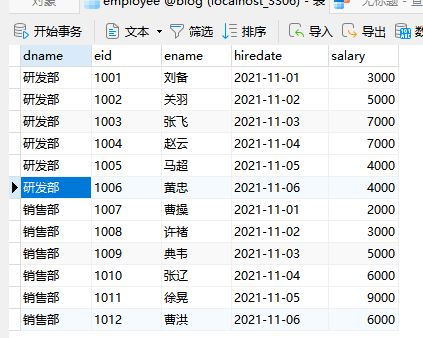

准备数据

1 | use mydb4; |

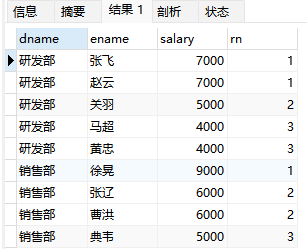

ROW_NUMBER()

排序:1,2,3

1 | -- 对每个部门的员工按照薪资排序,并给出排名 |

可以发现薪资一样,但是有第一第二名,是连续的按顺序的。

RANK()

排序:1,1,3

1 | -- 对每个部门的员工按照薪资排序,并给出排名 rank |

可以发现如果薪资一样,排序序号不是连续的。

DENSE_RANK()

排序:1,1,2

1 | -- 对每个部门的员工按照薪资排序,并给出排名 dense-rank |

可以发现薪资一样,是并列第一,而且是连续的排名,这种应该更符合平常的思维。

1 | --求出每个部门薪资排在前三名的员工- 分组求TOPN |

取每组的前三名,也很有用

1 | -- 对所有员工进行全局排序(不分组) |

不加partition by是所有的拿来排序

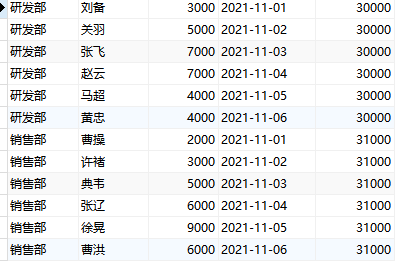

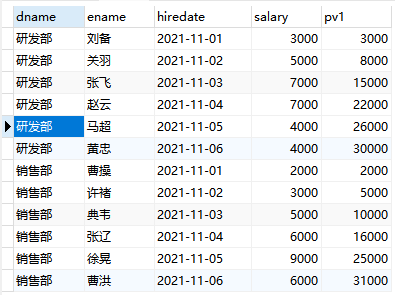

开窗聚合函数

在窗口中每条记录动态地应用聚合函数(SUM()、AVG()、MAX()、MIN()、COUNT()),可以动态计算在指定的窗口内的各种聚合函数值。

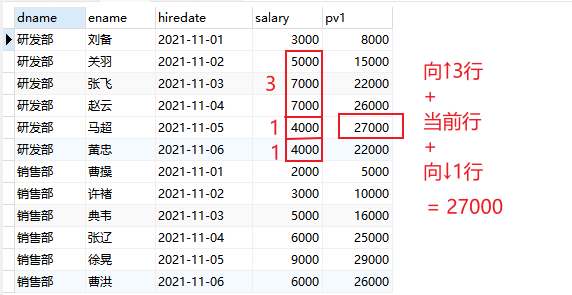

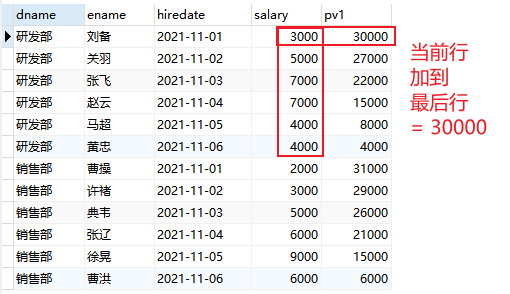

1 | -- 每个部门从入职到现在的工资成本 |

1 | -- 每个部门从入职到现在的工资成本,可以计算占比 |

1 | -- 每个部门从入职到现在的工资成本,可以控制范围 |

1 | -- 每个部门从入职到现在的工资成本 |

1 | -- 每个部门从入职到现在的工资成本 |

1 | -- 每个部门从入职到现在的工资成本 |

以上sum同理可以求平均值avg,最大值max,最小值min

分布函数

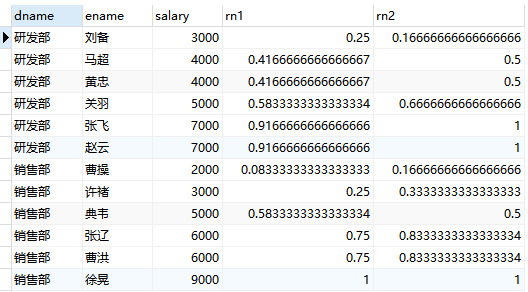

CUME_DIST

用途:分组内小于、等于当前rank值的行数 / 分组内总行数

应用场景:查询小于等于当前薪资(salary)的比例

1 | select |

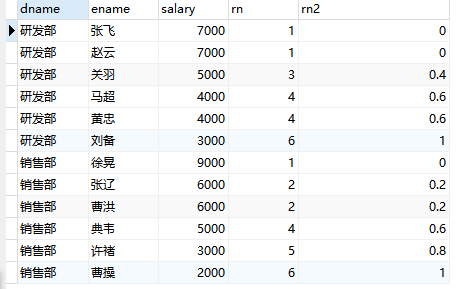

PERCENT_RANK

用途:每行按照公式(rank-1) / (rows-1)进行计算。其中,rank为RANK()函数产生的序号,rows为当前窗口的记录总行数

应用场景:不常用

1 | select |

前后函数

LAG

用途:返回位于当前行的前n行(LAG(expr,n))或后n行(LEAD(expr,n))的expr的值

应用场景:查询前1名同学的成绩和当前同学成绩的差值

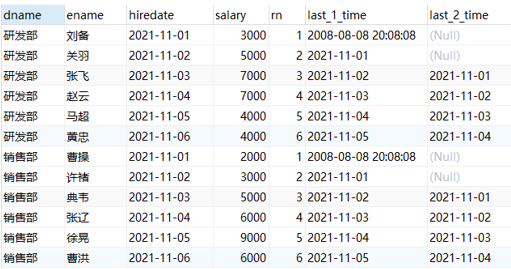

1 | -- lag的用法 |

把上1行的值给当前行

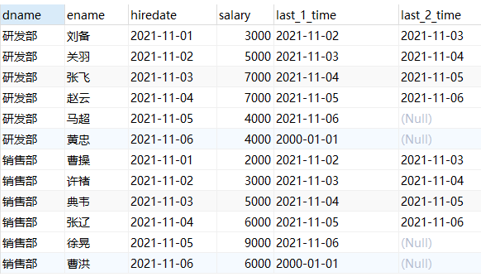

LEAD

1 | -- lead的用法 |

把下1行的值给当前行

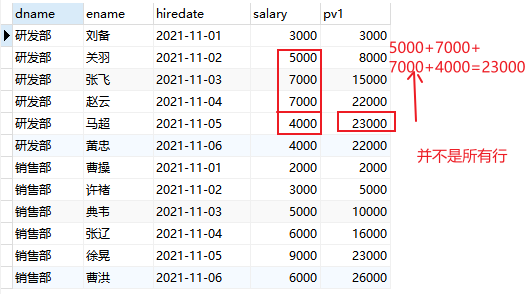

头尾函数

FIRST_VALUE和LAST_VALUE

用途:返回第一个(FIRST_VALUE(expr))或最后一个(LAST_VALUE(expr))expr的值

应用场景:截止到当前,按照日期排序查询第1个入职和最后1个入职员工的薪资

1 | -- 注意, 如果不指定ORDER BY,则进行排序混乱,会出现错误的结果 |

其他函数

NTH_VALUE(expr, n)

用途:返回窗口中第n个expr的值。expr可以是表达式,也可以是列名

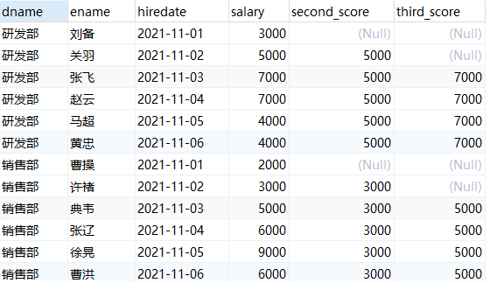

应用场景:截止到当前薪资,显示每个员工的薪资中排名第2或者第3的薪资

1 | -- 查询每个部门截止目前薪资排在第二和第三的员工信息 |

second_score第一行为NULL的原因: 截至到当前,排名第二的,还没有,只有3000一行,所以为NULL

NTILE(n)

用途:将分区中的有序数据分为n个等级,记录等级数

应用场景:将每个部门员工按照入职日期分成3组

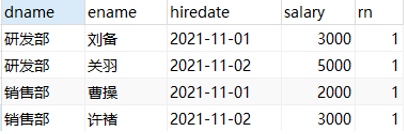

1 | -- 根据入职日期将每个部门的员工分成3组 |

1 | -- 取出每个部门的第一组员工 |

自定义函数

MySQL存储函数(自定义函数),函数一般用于计算和返回一个值,可以将经常需要使用的计算或功能写成一个函数。存储函数和存储过程一样,都是在数据库中定义一些 SQL 语句的集合。

存储函数与存储过程的区别

1.存储函数有且只有一个返回值,而存储过程可以有多个返回值,也可以没有返回值。

2.存储函数只能有输入参数,而且不能带in, 而存储过程可以有多个in,out,inout参数。

3.存储过程中的语句功能更强大,存储过程可以实现很复杂的业务逻辑,而函数有很多限制,如不能在函数中使用insert,update,delete,create等语句;

4.存储函数只完成查询的工作,可接受输入参数并返回一个结果,也就是函数实现的功能针对性比较强。

5.存储过程可以调用存储函数。但函数不能调用存储过程。

6.存储过程一般是作为一个独立的部分来执行(call调用)。而函数可以作为查询语句的一个部分来调用.

语法

1 | create function func_name ([param_name type[,...]]) |

例子

1 | create database mydb9_function; |

视图

介绍

视图(view)是一个虚拟表,非真实存在,其本质是根据SQL语句获取动态的数据集,并为其命名,用户使用时只需使用视图名称即可获取结果集,并可以将其当作表来使用。

数据库中只存放了视图的定义,而并没有存放视图中的数据。这些数据存放在原来的表中。

使用视图查询数据时,数据库系统会从原来的表中取出对应的数据。因此,视图中的数据是依赖于原来的表中的数据的。一旦表中的数据发生改变,显示在视图中的数据也会发生改变。

作用

简化代码,可以把重复使用的查询封装成视图重复使用,同时可以使复杂的查询易于理解和使用。

安全原因,如果一张表中有很多数据,很多信息不希望让所有人看到,此时可以使用视图视,如:社会保险基金表,可以用视图只显示姓名,地址,而不显示社会保险号和工资数等,可以对不同的用户,设定不同的视图。

创建视图

语法

1 | create [or replace] [algorithm = {undefined | merge | temptable}] |

数据准备

创建 数据库mydb6_view,然后在该数据库下执行sql脚本view_data.sql 导入数据

1 | create database mydb6_view; |

修改视图

修改视图是指修改数据库中已存在的表的定义。当基本表的某些字段发生改变时,可以通过修改视图来保持视图和基本表之间一致。MySQL中通过CREATE OR REPLACE VIEW语句和ALTER VIEW语句来修改视图。

1 | alter view 视图名 as select语句 |

更新视图

某些视图是可更新的。也就是说,可以对视图做UPDATE、DELETE或INSERT操作,以更新基表(源表)的内容。对于可更新的视图,在视图中的行和基表中的行之间必须具有一对一的关系。如果视图包含下述结构中的任何一种,那么它就是不可更新的:

- 聚合函数(SUM(), MIN(), MAX(), COUNT()等)

- DISTINCT

- GROUP BY

- HAVING

- UNION或UNION ALL

- 位于选择列表中的子查询

- JOIN

- FROM子句中的不可更新视图

- WHERE子句中的子查询,引用FROM子句中的表。

- 仅引用文字值(在该情况下,没有要更新的基本表)

视图中虽然可以更新数据,但是有很多的限制。一般情况下,最好将视图作为查询数据的虚拟表,而不要通过视图更新数据。因为,使用视图更新数据时,如果没有全面考虑在视图中更新数据的限制,就可能会造成数据更新失败。

1 | -- ---------更新视图------- |

重命名视图

1 | -- rename table 视图名 to 新视图名; |

删除视图

删除视图时,只能删除视图的定义,不会删除数据。

1 | -- drop view 视图名[,视图名…]; |

视图练习

1 | -- 1:查询部门平均薪水最高的部门名称 |

存储过程

介绍

MySQL5.0开始支持存储过程,存储过程就是多条SQL的封装实现某个复杂逻辑的功能,类似java的方法,可重用。

有输入输出,可以声明变量,有if、case、while等控制语句。

速度快,首次执行需要编译和优化,后续调用直接执行。

入门案例

1 | 语法: |

变量

局部变量

用户自定义,在begin/end块中有效

1 | 语法:声明变量 declare var_name type [default var_value]; |

还可以用select into赋值

1 | select col_name [...] into var_name[,...] |

用户变量

用户自定义,当前会话(连接)有效。类比java的成员变量

1 | 语法: |

系统变量

系统变量又分为全局变量与会话变量

全局变量在MYSQL启动的时候由服务器自动将它们初始化为默认值,这些默认值可以通过更改my.ini这个文件来更改。

会话变量在每次建立一个新的连接的时候,由MYSQL来初始化。MYSQL会将当前所有全局变量的值复制一份。来做为会话变量。

也就是说,如果在建立会话以后,没有手动更改过会话变量与全局变量的值,那所有这些变量的值都是一样的。

全局变量与会话变量的区别就在于,对全局变量的修改会影响到整个服务器,但是对会话变量的修改,只会影响到当前的会话(也就是当前的数据库连接)。

有些系统变量的值是可以利用语句来动态进行更改的,但是有些系统变量的值却是只读的,对于那些可以更改的系统变量,我们可以利用set语句进行更改。

- 全局变量

由系统提供,在整个数据库有效

1 | 语法: |

- 会话变量

由系统提供,当前会话(连接)有效

1 | 语法: |

参数传递

in

入参,相当于Java给方法传的形参

1 | -- 【传单个】封装有参数的存储过程,传入员工编号,查找员工信息 |

out

出参,相当于返回值,返回给调用者。

1 | -- ---------传出参数:out--------------------------------- |

inout

参数传进去,经过修改,会再传出来,拿到修改后的值。 值被加工了。

1 | -- 传入员工名,拼接部门号,传入薪资,求出年薪 |

流程控制

分支语句-if

1 | -- 语法 |

分支语句-case

CASE是另一个条件判断的语句,类似于编程语言中的switch语法

1 | -- 语法一(类比java的switch): |

循环语句-while

leave 类似于 break,跳出,结束当前所在的循环

iterate类似于 continue,继续,结束本次循环,继续下一次

1 | 【标签:】while 循环条件 do |

循环语句-repeat

1 | [标签:]repeat |

循环语句-loop

1 | [标签:] loop |

游标cursor

游标(cursor)是用来存储查询结果集的数据类型 , 在存储过程和函数中可以使用光标对结果集进行循环的处理(拿到结果集的每一行)。光标的使用包括光标的声明、OPEN、FETCH 和 CLOSE.

1 | -- 声明语法 |

操作:

1 | use mysql7_procedure; |

最后往下fetch,报错no data,退出存过。所以我们要进一步做异常处理。

异常处理句柄handler

MySql存储过程也提供了对异常处理的功能:通过定义HANDLER来完成异常声明的实现.

官方文档:https://dev.mysql.com/doc/refman/5.7/en/declare-handler.html

1 | DECLARE handler_action HANDLER |

在语法中,变量声明、游标声明、handler声明是必须按照先后顺序书写的,否则创建存储过程出错。

1 | use mysql7_procedure; |

存过练习

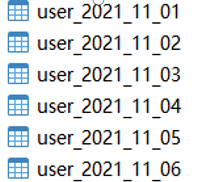

创建下个月的每天对应的表user_2021_11_01、user_2021_11_02、…

需求描述: 我们需要用某个表记录很多数据,比如记录某某用户的搜索、购买行为(注意,此处是假设用数据库保存),当每天记录较多时,如果把所有数据都记录到一张表中太庞大,需要分表,我们的要求是,每天一张表,存当天的统计数据,就要求提前生产这些表——每月月底创建下一个月每天的表!

需要的知识点:

1 | PREPARE stmt_name FROM preparable_stmt |

实现:

1 | -- 思路:循环构建表名 user_2021_11_01 到 user_2020_11_30;并执行create语句。 |

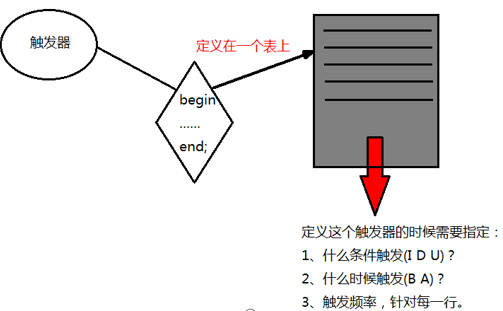

触发器

介绍

触发器,就是一种特殊的存储过程。触发器和存储过程一样是一个能够完成特定功能、存储在数据库服务器上的SQL片段,但是触发器无需调用,当对数据库表中的数据执行DML操作时自动触发这个SQL片段的执行,无需手动条用。

在MySQL中,只有执行insert,delete,update操作时才能触发触发器的执行。(修改A表->B表自动记录数据)

触发器的这种特性可以协助应用在数据库端确保数据的完整性 , 日志记录 , 数据校验等操作 。

使用别名 OLD 和 NEW 来引用触发器中发生变化的记录内容,这与其他的数据库是相似的。现在触发器还只支持行级触发,不支持语句级触发。

特性

1、什么条件会触发:I、D、U

2、什么时候触发:在增删改前(B)或者后(A)

3、触发频率:针对每一行执行

4、触发器定义在表上,附着在表上

语法

1、创建只有一个执行语句的触发器

1 | create trigger 触发器名 before|after 触发事件 |

2、创建有多个执行语句的触发器

1 | create trigger 触发器名 before|after 触发事件 |

例子

1 | -- 数据准备 |

NEW与OLD

MySQL 中定义了 NEW 和 OLD,用来表示触发器的所在表中,触发了触发器的那一行数据,来引用触发器中发生变化的记录内容,具体地:

| 触发器类型 | 触发器类型NEW 和 OLD的使用** |

|---|---|

| INSERT 型触发器 | NEW 表示将要或者已经新增的数据 |

| UPDATE 型触发器 | OLD 表示修改之前的数据 , NEW 表示将要或已经修改后的数据 |

| DELETE 型触发器 | OLD 表示将要或者已经删除的数据 |

使用方法:NEW.columnName(columnName为相应数据表某一列名)

1 | create trigger trigger_test3 after insert |

查看删除触发器

1 | # 查看触发器 |

- MYSQL中触发器中不能对本表进行 insert ,update ,delete 操作,以免递归循环触发

- 尽量少使用触发器,假设触发器触发每次执行1s,insert table 500条数据,那么就需要触发500次触发器,光是触发器执行的时间就花费了500s,而insert 500条数据一共是1s,那么这个insert的效率就非常低了。

- 触发器是针对每一行的;对增删改非常频繁的表上切记不要使用触发器,因为它会非常消耗资源。

本质是一张表修改影响另一张表,不用触发器的话,可以用java后台代码实现。

🔖MySQL表设计

层级数据表结构设计

概述

层级结构也称树形结构,是数据元素之间存在着的一种 一对多 的数据结构,可应用在从属关系、并列关系。生活中有很多这样的例子。如:

我们在京东或淘宝购物提交订单时选择的收货人地址,都是先选所在的省,再选市,然后再到县或区。一个省下有多个市,一个市下有多个县或区,它们的这种结构就跟树的分叉一样,主干可以有很多分叉,每个分支也可以拥有很多分叉。我们可以把树的每一个分叉都看成一个节点,每一个节点可能有它的子节集合,也可能有它的父节点。

面对不同的项目业务需求,复杂且多层级关系,如何设计出一种比较好的数据库表结构来存储数据,以便快速的查询或插入与更新数据呢?

解决方案

对于层级结构的数据,我们有以下四种解决方案。接下来分别演示这4个方案及分析它们的优缺点

- Adjacency List (邻接表)是一种链式存储结构,这种表结构中用一字段来表示上级ID

- Path Enumeration 路径枚举,存储数据时,把路径信息也存到一个列中

- Nested Sets 嵌套集合, 利用集合区间的特性,存储数据时还要存储它的左右边界值,查询效率快

- Closure Table 闭包表, 最广泛的一种,适应多种场景,存储数据时,把所有的路径信息也保存下来。缺点是存储数据量较大

案例和实现

针对公司中存在的等级制度,即老板管理各部门经理,经理管理其部门下的组长,组长管理其下的组员等。

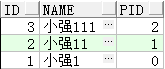

Adjacency List

表设计

1 | CREATE TABLE emp( |

查询

- 查询小强11的直接下属有哪些人?小强11的编号为2。

1 | ‐‐这个比较简单 |

- 查询小强11的下属有哪些人?小强11的编号为2。

1 | ‐‐1. 首先得查询出直接下属 |

- Oracle中的归查询

查询小强11及其所有的下属,小强11的编号为2

1 | select * from emp |

查询小强111及所有上司,小强111的编号为3

1 | select * from emp |

- 如果再来一个跨级查询,则无法实现

维护

- 插入数据

1 | insert into emp (id,name,pid) values(16,'小强XXX',5); |

- 修改数据

移动某个节点到指定的节点下。比如 小强1122 升职了,这时我们只要一条语句就可以搞定

1 | update emp set pid=2 where id=8; |

- 删除数据

1 | ‐‐ 删除的数据本身及其的包含子节点 |

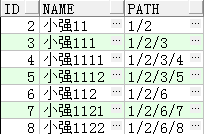

Path Enumeration

只存储当前节点信息,及节点所在的路径

表设计

1 | CREATE TABLE emp2( |

查询

查询小强11的下属有哪些人。

1 | select * from emp2 where path like (select path from emp2 where name='小强11') || '%'; |

维护

- 插入数据,我们给小强11再加入一个子节点

1 | insert into emp2 (id,name) values(16,'小强XX'); |

- 修改数据

移动某个节点到指定的节点下。比如 小强1122 升了1级

1 | ‐‐ 首先找小强1122的路径 |

- 删除数据

1 | ‐‐ 删除时,如果该节点下有其它子节点(不删除),那么要先更新子节点的path路径值。 |

Nested Sets

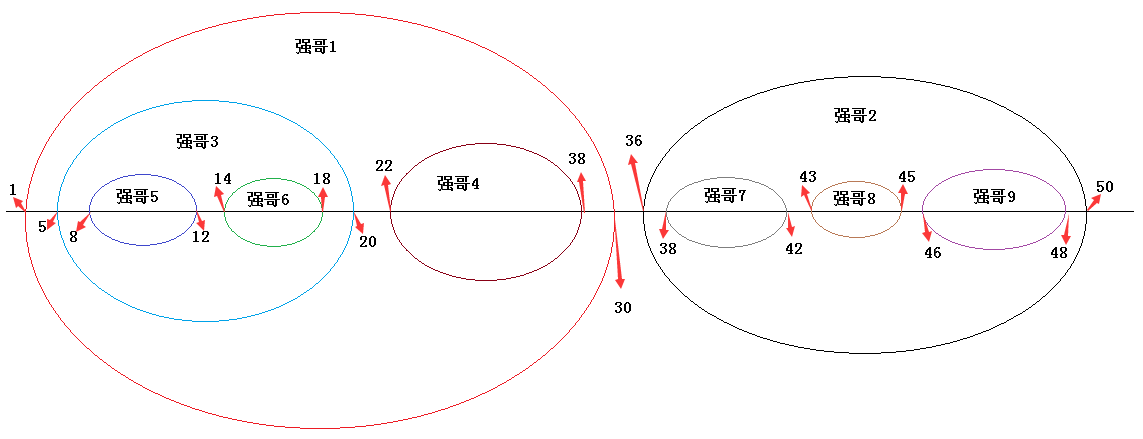

首先我们通过下图来理解一下什么是【嵌套集合】

结构如下

1 | ‐‐强哥1 |

表设计

1 | CREATE TABLE emp3( |

查询

- 查询强哥1的所有下属

1 | select e2.* from emp3 e1, emp3 e2 |

- 查询强哥5的所有上级

1 | select e2.* from emp3 e1, emp3 e2 |

- 向下越级查询,查询强哥1的所有下下级员工

1 | select e2.* from emp3 e1, emp3 e2 |

- 向上越级查询,查询强哥5的上二级领导

1 | select e2.* from emp3 e1, emp3 e2 |

维护

嵌套集合的这种结构维护(插入新的节点,或移动节点)起来非常复杂,如果只是加入一个末端节点(叶子节点),则需要扩展相关的nleft的值。如果不是末端节点,则整个结构都得重新计算。以下演示加入末端节点

1 | ‐‐扩展要插入的节点的右边值 |

Closure Table

这是一种简单又方便的存储层级结构的方案。每添加一个节点时都存储它的所有路径信息,存储数据量较大

表设计

1 | create table emp4( |

结构如下

1 | ‐‐小强01 |

查询

- 查询小强1的所有下属

1 | select e.* |

- 越级查询小强1的所有二级下属

1 | select e.* |

- 查询小强13所有上级领导

1 | select m.* |

- 越级查询小强13上二级导

1 | select m.* |

维护

- 插入数据,添加一个新员工 小强21,该员工与 小强13 同等级,同一个领导

1 | insert into emp4 (id,name) values(21, '小强21'); |

- 移动节点

把小强8 (编号为8) 移动到 小强3(编号为3) 下

1 | ‐‐ 删除所有跟小强8有关的节点及这些节点的上级节点关系 |

- 删除数据

删除的数据是叶子节点

1 | ‐‐ 先删除关系 |

删除的数据包含有子节点

1 | delete from emprelationship where cid in ( |

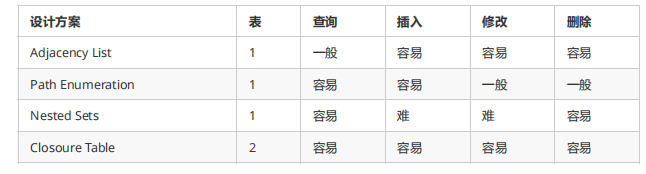

总结

介绍完了这4个方案,下面我们来总结一下每一种方案的优缺点:

- Adjacency List: 层次结构无深度限制,可以随意添加,修改与删除。但查询只能查询自己本身及下一级结构的数据,无法越级查询。这种结构比较常用

- Path Enumeration: 存储路径的方式在进行多级查询的时候很方便,而在查询直接上下级的时候稍微复杂一点。缺点,那就是path的大小决定于列的类型长度,理论上是不能无限层级的扩展,且产生冗余数据。

- Nested Sets: 在左右列上添加索引后查询速度最快,可越级查询,但缺点是插入与修改的时候比较复杂。适合一旦创建,只做查询用,不做维护的数据。

- Closure Table: 查询很方便,可以随意越级查询,维护起来也比较容易,一目了然,用途最广。存储数据时需要用到2张表,如果层次结构较多,由于每个节点都要存储它的所有路径,因此存储的开销比较大

最后,到底该用哪一种还得看业务需求再做决定

🔖MySQL扩容

数据库平滑扩容

学习目标

目标1:理解传统扩容实现方案 目标2:理解平滑扩容双写方案 目标3:掌握数据库2N扩容方案 目标4:实现数据库双主同步 目标5:掌握ShardingJDBC路由以及动态扩容技术 目标6:掌握KeepAlived+MariaDB数据库高可用方案

扩容方案剖析

数据库容量不足,数据库数据量特别大,DAO层响应时间久等都需要扩容

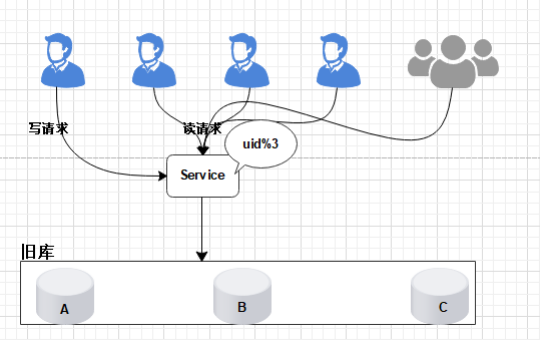

扩容问题

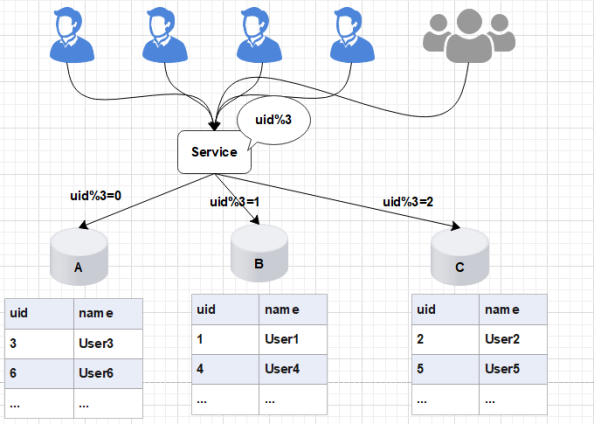

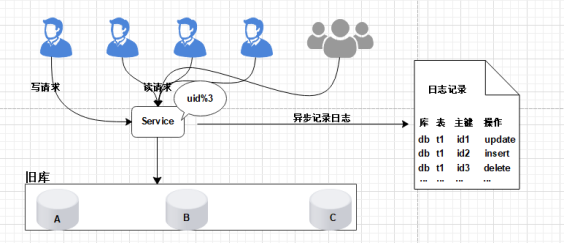

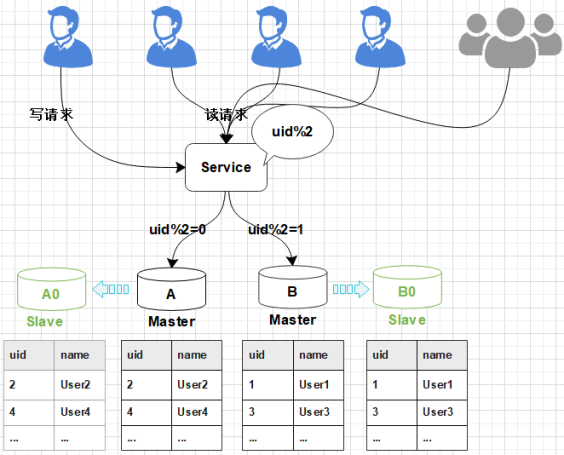

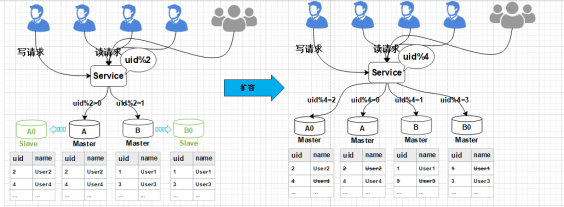

在项目初期,我们部署了三个数据库A、B、C,此时数据库的规模可以满足我们的业务需求。为了将数据做到平均分配,我们在Service服务层使用uid%3进行取模分片,从而将数据平均分配到三个数据库中。

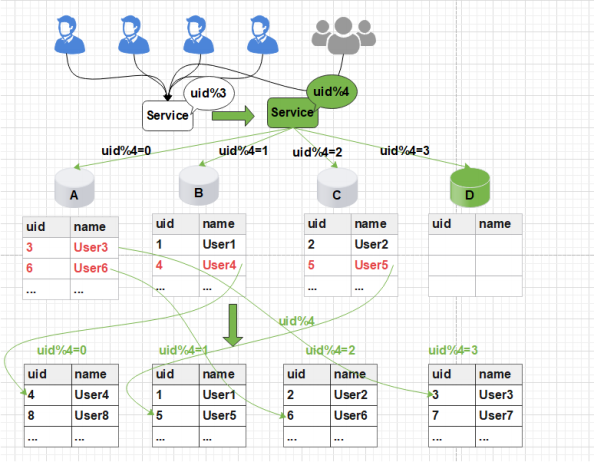

如图所示:

后期随着用户量的增加,用户产生的数据信息被源源不断的添加到数据库中,最终达到数据库的最佳存储容量。如果此时继续向数据库中新增数据,会导致数据库的CRUD等基本操作变慢,进而影响整个服务的响应速度。

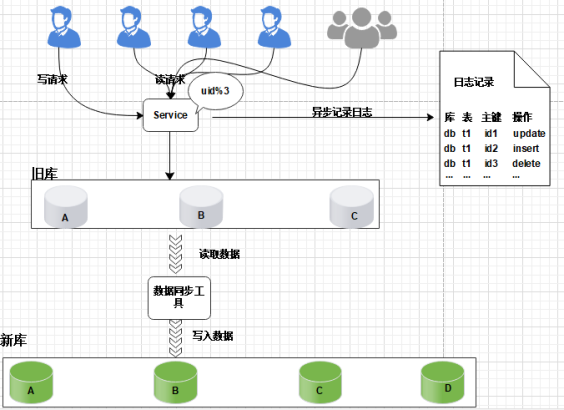

这时,我们需要增加新的节点,对数据库进行水平扩容,那么加入新的数据库D后,数据库的规模由原来的3个变为4个。

如图所示:

此时由于分片规则发生了变化(uid%3 变为uid%4),导致大部分的数据,无法命中原有的数据,需要重新进行分配,要做大量的数据迁移处理。

比如之前uid如果是uid=3取模3%3=0, 是分配在A库上,新加入D库后, uid=3取模3%4=3,分配在D库上

新增一个节点, 大概会有90%的数据需要迁移, 这样会面临大量的数据压力,并且对服务造成极大的不稳定性。

提问:如果数据量持续增大,分2个库性能扛不住了,该怎么办呢?

回答:继续水平拆分,拆成更多的库,降低单库数据量,增加库主库实例(机器)数量,提高性能。

最终问题抛出:分成x个库后,随着数据量的增加,要增加到y个库,数据库扩容的过程中,能否平滑,持续对外提供服务,保证服务的可用性,是本文要讨论的问题。

停机方案

- 发布公告 为了进行数据的重新拆分,在停止服务之前,我们需要提前通知用户,比如:我们的服务会在yyyy-MM-dd进行升级,给您带来的不便敬请谅解。

- 停止服务 关闭Service

- 新建y个库,做好高可用

- 离线数据迁移(拆分,重新分配数据)【耗时】 将旧库中的数据按照Service层的算法(%x升级为%y)(开发一个数据库迁移工具),将数据拆分,重新分配数据

- 数据校验 开发定制一个程序对旧库和新库中的数据进行校验,比对

- 更改配置 修改Service层的配置算法,也就是将原来的uid%3变为uid%4

- 恢复服务 重启Service服务

- 回滚预案 针对上述的每个步骤都要有数据回滚预案,一旦某个环节(如:数据迁移,恢复服务等)执行失败,立刻进行回滚,重新再来

停止服务之后, 能够保证迁移工作的正常进行, 但是服务停止,伤害用户体验, 并造成了时间压力,必须在指定的时间内完成迁移。

停机方案用户体验差,停机时间太长,不符合高可用的理念

技术同学压力大,所有工作要在规定时间内做完,根据经验,压力越大约容易出错(这一点很致命)

如果有问题第一时间没检查出来,启动了服务,运行一段时间后再发现有问题,难以回滚,需要回档,可能会丢失一部分数据

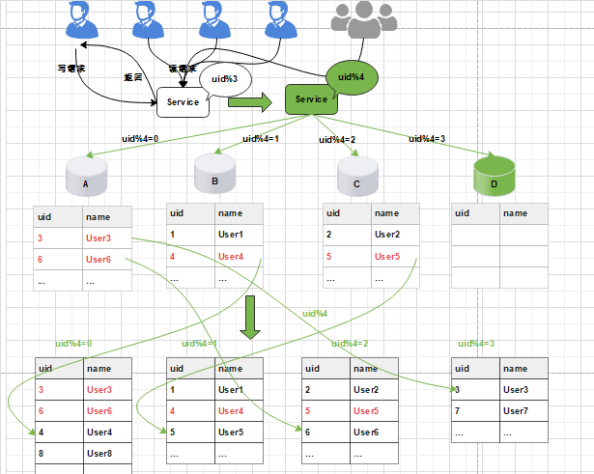

停写方案

- 支持读写分离 数据库支持读写分离,在扩容之前,每个数据库都提供了读写功能,数据重新分配的过程中,将每个数据库设置为只读状态,关闭写的功能

- 升级公告 为了进行数据的重新拆分,在停写之前,我们需要提前通知用户,比如:我们的服务会在yyyyMM-dd进行升级,给您带来的不便敬请谅解。

- 中断写操作,隔离写数据源(或拦截返回统一提示) 在Service层对所有的写请求进行拦截,统一返回提示信息,如:服务正在升级中,只对外提供读服务、

- 数据同步处理

将旧库中的数据按照Service层的算法,将数据重新分配,迁移(复制数据)

- 数据校验 开发定制一个程序对旧库中的数据进行备份,使用备份的数据和重新分配后的数据进行校验,比对

- 更改配置 通过配置中心,修改Service层的配置算法,也就是将原来的uid%3变为uid%4,这个过程不需要重启服务

- 恢复写操作 设置数据库恢复读写功能,去除Service层的拦截提示

- 数据清理 使用delete语句对冗余数据进行删除

- 回滚预案 针对上述的每个步骤都要有数据回滚预案,一旦某个环节(如:数据迁移等)执行失败,立刻进行回滚,重新再来

缺点:在数据的复制过程需要消耗大量的时间,停写时间太长,数据需要先复制,再清理冗余数据

优点,不需要停机,缺点是不能写入还是影响了用户体验。而且停写复制也是很耗时的。

日志方案

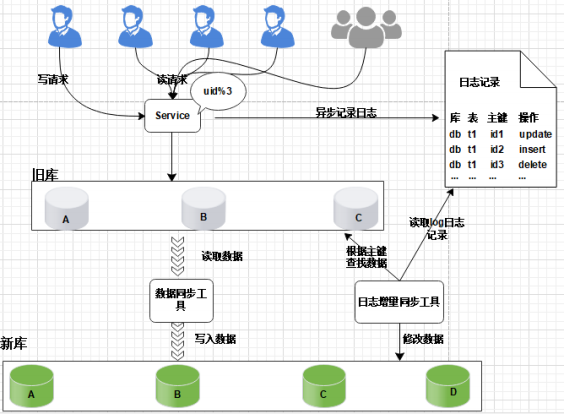

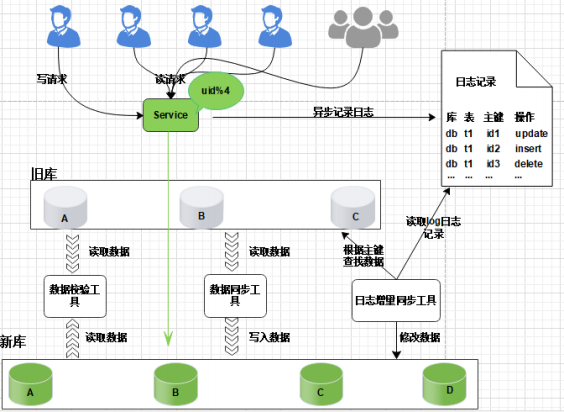

核心是通过日志进行数据库的同步迁移, 主要操作步骤如下:

- 数据迁移之前, 业务应用访问旧的数据库节点。

- 日志记录 在升级之前, 记录“对旧数据库上的数据修改”的日志(这里修改包括增、删、改),这个日志不需要记录详细的数据信息,主要记录: (1)修改的库; (2)修改的表; (3)修改的唯一主键; (4)修改操作类型。

日志记录不用关注新增了哪些信息,修改的数据格式,只需要记录以上数据信息,这样日志格式是固定的, 这样能保证方案的通用性。 服务升级日志记录功能风险较小:

写和修改接口是少数, 改动点少;

升级只是增加了一些日志,采用异步方式实现, 对业务功能没有太多影响。

- 数据迁移: 研发定制数据迁移工具, 作用是把旧库中的数据迁移至新库中。

整个过程仍然采用旧库进行对外服务。 数据同步工具实现复杂度不高。 只对旧库进行读取操作, 如果同步出现问题, 都可以对新库进行回滚操作。 可以限速或分批迁移执行, 不会有时间压力。(不然极端情况,一直有增删改操作,同步工具会不断同步数据)

数据迁移完成之后, 并不能切换至新库提供服务。 因为旧库依然对线上提供服务, 库中的数据随时会发生变化, 但这些变化的数据并没有同步到新库中, 旧库和新库数据不一致, 所以不能直接进行切换, 需要将数据同步完整。

- 日志增量迁移

研发一个日志迁移工具,把上面迁移数据过程中的差异数据追平,处理步骤:

- 读取log日志,获取具体是哪个库、表和主键发生了变化修改;

- 把旧库中的主键记录读取出来

- 根据主键ID,把新库中的记录替换掉

这样可以最大程度的保障数据的一致性。风险分析:

- 整个过程, 仍然是旧库对线上提供服务;

- 日志迁移工具实现的复杂度较低;

- 任何时间发现问题, 可以重新再来,有充分的容错空间;

- 可以限速重放处理日志, 处理过程不会因为对线上影响造成时间压力。

但是, 日志增量同步完成之后, 还不能切换到新的数据库。 因为日志增量同步过程中,旧库中可能有数据发生变化, 导致数据不一致,所以需要进一步读取日志, 追平数据记录; 日志增量同步过程随时可能会产生新的数据, 新库与旧库的数据追平也会是一个无限逼近的过程。

- 数据校验 准备好数据校验工具,将旧库和新库中的数据进行比对,直到数据完全一致。

- 切换新库 数据比对完成之后, 将流量转移切换至新库, 至此新库提供服务, 完成迁移。

但是在极限情况下, 即便通过上面的数据校验处理, 也有可能出现99.99%数据一致, 不能保障完全一致,这个时候可以在旧库做一个readonly只读功能, 或者将流量屏蔽降级,等待日志增量同步工具完全追平后, 再进行新库的切换。

至此,完成日志方案的迁移扩容处理, 整个过程能够持续对线上提供服务, 只会短暂的影响服务的可用性。

这种方案的弊端,是操作繁琐,需要适配多个同步处理工具,成本较高, 需要制定个性化业务的同步处理, 不具备普遍性,耗费的时间周期也较长

要开发很多定制化的同步工具,不通用。开发成本周期高。繁琐复杂

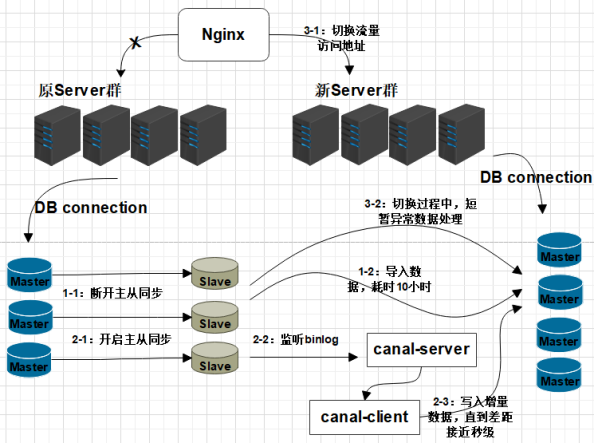

双写方案(中小型数据)

双写方案可通过canal或mq做实现。

- 增加新库,按照现有节点, 增加对应的数量。

- 数据迁移:避免增量影响, 先断开主从,再导入(耗时较长), 同步完成并做校验

- 增量同步:开启Canal同步服务, 监听从节点数据库, 再开启主从同步,从节点收到数据后会通过 Canal服务, 传递至新的DB节点。

- 切换新库:通过Nginx,切换访问流量至新的服务。

- 修复切换异常数据:在切换过程中, 如果出现,Canal未同步,但已切换至新库的请求(比如下单,修改了资金, 但还未同步 ), 可以通过定制程序, 读取检测异常日志,做自动修复或人工处理。 针对此种情况, 最好是在凌晨用户量小的时候, 或专门停止外网访问,进行切换,减少异常数据的产生。

- 数据校验:为保障数据的完全一致, 有必要对数据的数量完整性做校验。

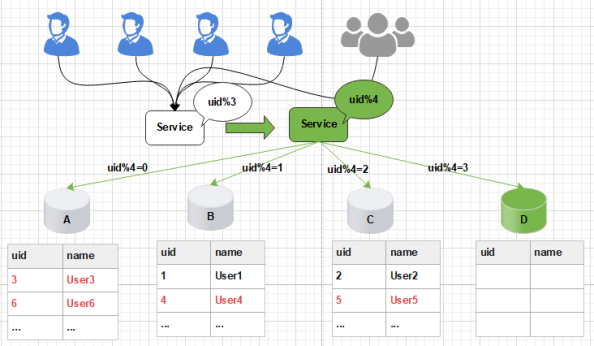

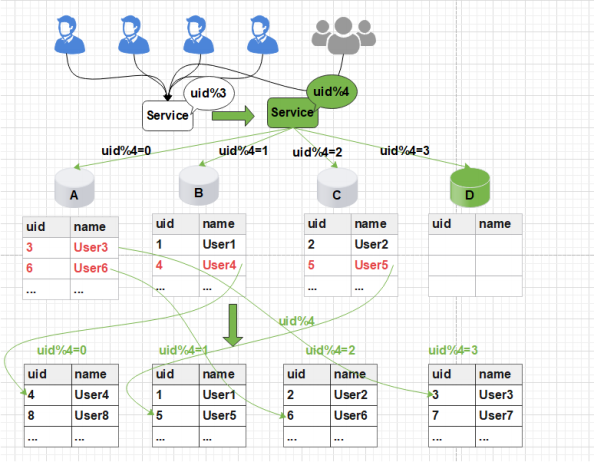

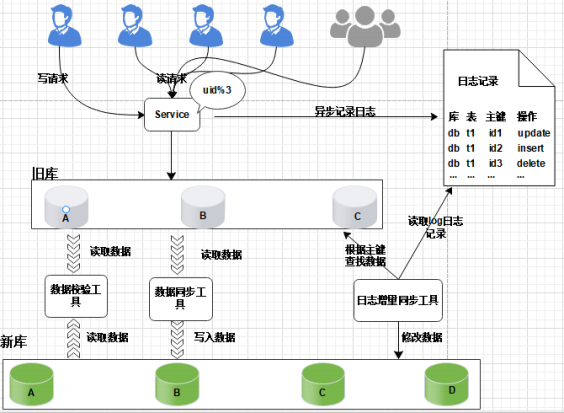

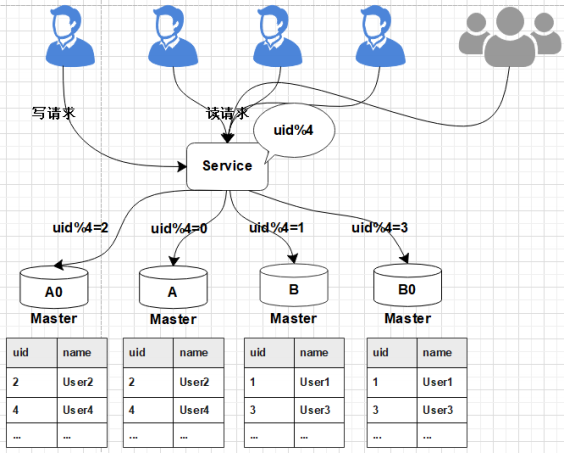

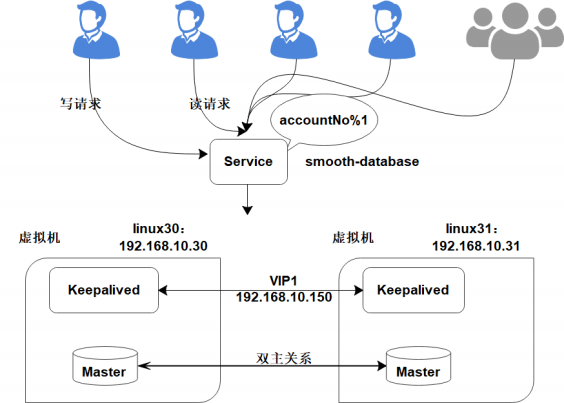

平滑2N方案(大数据量)

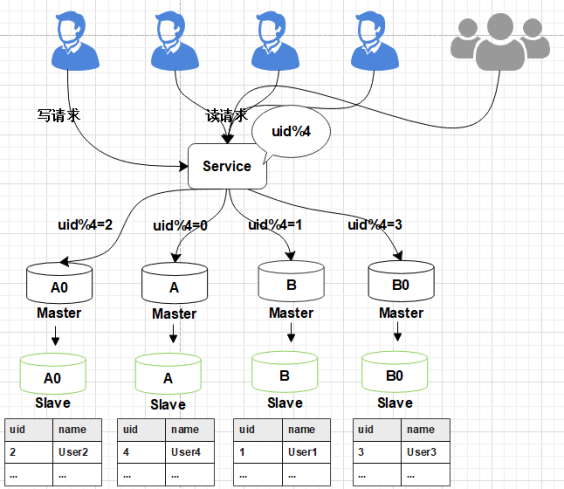

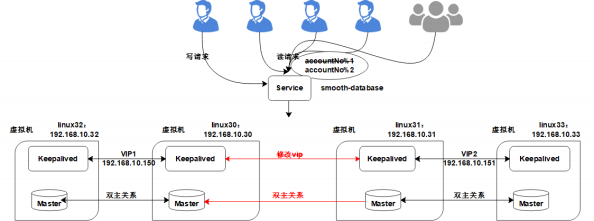

- 线上数据库,为了保障其高可用,一般每台主库会配置一台从库,主库负责读写,从库负责读取。 下图所示,A,B是主库,A0和B0是从库。

- 当需要扩容的时候,我们把A0和B0升级为新的主库节点,如此由2个分库变为4个分库。同时在上 层的分片配置,做好映射,规则如下:

把uid%4=0和uid%4=2的数据分别分配到A和A0主库中

把uid%4=1和uid%4=3的数据分配到B和B0主库中

- 因为A和A0库的数据相同,B和B0数据相同,此时无需做数据迁移。只需调整变更一下分片配置即可,通过配置中心更新,不需要重启。

由于之前uid%2的数据是分配在2个库里面,扩容之后需要分布到4个库中,但由于旧数据仍存在(uid%4=0的节点,还有一半uid%4=2的数据),所以需要对冗余数据做一次清理。 这个清理,并不会影响线上数据的一致性,可以随时随地进行。

- 处理完成之后,为保证数据的高可用,以及将来下一步的扩容需求。 可以为现有的主库再次分配一个从库。

平滑2N主要是存在数据冗余的问题

平滑2N扩容方案实践

实现应用服务级别的动态扩容

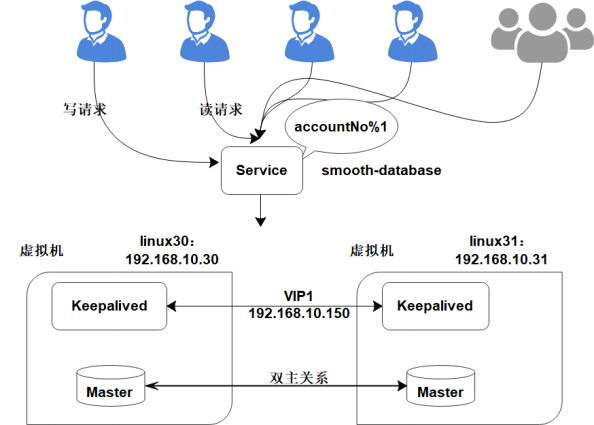

扩容前部署架构

keepalived作用:1、健康监测 2、故障转移(vrrp,虚拟路由冗余协议)

MariaDB服务安装

MariaDB数据库管理系统是MySQL的一个分支,主要由开源社区在维护,采用GPL授权许可。开发这个分支的原因之一是:甲骨文公司收购了MySQL后,有将MySQL闭源的潜在风险,因此社区采用分支的方式来避开这个风险。

- 切换阿里云镜像服务(YUM安装过慢可以切换)

1 | [root@linux30 ~]# yum -y install wget |

- 配置YUM源

1 | [root@linux30 ~]# vi /etc/yum.repos.d/mariadb-10.2.repo |

增加以下内容:

1 | [mariadb] |

- 执行安装

1 | [root@linux30 ~]# yum -y install mariadb mariadb-server MariaDB-client MariaDB-common |

- 如果之前已经安装, 需要先删除(如果之前没有安装, 可以忽略此步骤)

- 停止Mariadb服务

1 | [root@localhost yum.repos.d]# ps -ef | grep mysql |

- 卸载Mariadb服务

1 | yum -y remove Maria* |

- 删除数据与配置:

1 | rm -rf /var/lib/mysql/* |

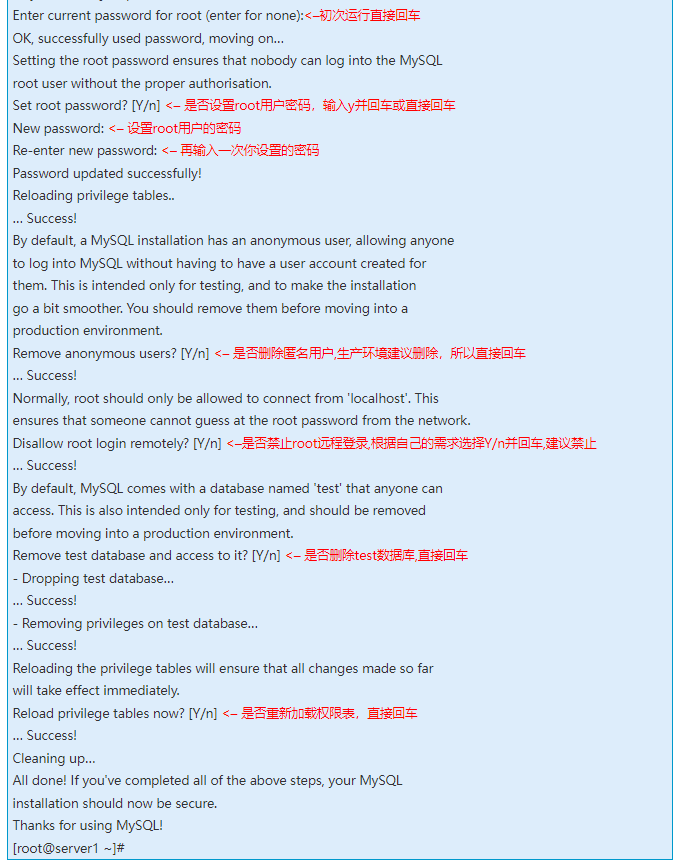

- 启动MariaDB后,执行安全配置向导命令,可根据安全配置向导提高数据库的安全性

1 | [root@linux30 ~]# systemctl start mariadb |

- 开启用户远程连接权限

将连接用户root开启远程连接权限;

1 | 登录 |

MariaDB双主同步

- 在linux30增加配置:

在/etc/my.cnf中添加以下配置:

1 | [root@linux30 ~]# vi /etc/my.cnf |

注意, linux30自增为奇数位:

auto-increment-offset=1 主键自增基数, 从1开始。

auto-increment-increment=2 主键自增偏移量,每次为2。

- 在linux31增加配置:

修改/etc/my.cnf:

1 | [root@linux31 ~]# vi /etc/my.cnf |

linux31自增为偶数位:

auto-increment-offset=2 主键自增基数, 从2开始。

auto-increment-increment=2 主键自增偏移量,每次为2。

配置修改完成后, 重启数据库。

- 同步授权配置

在linux30创建replica用于主从同步的用户:

1 | [root@linux30 ~]# mysql -uroot -p123456 |

查询日志文件与偏移量,开启同步时需使用:

1 | MariaDB [(none)]> show master status; |

同样, 在linux31创建replica用于主从同步的用户:

1 | [root@linux31 ~]# mysql -uroot -p123456 |

查询日志文件与偏移量:

1 | MariaDB [(none)]> show master status; |

- 配置主从同步信息

在linux30中执行:

1 | MariaDB [(none)]> change master to master_host='192.168.10.31',master_user='replica', master_password='replica', master_port=3306, master_log_file='mysql-bin.000001', master_log_pos=328, master_connect_retry=30; |

在linux31中执行:

1 | # 如果报错要停止slave |

- 开启双主同步

在linux30和linux31中分别执行:

1 | MariaDB [(none)]> start slave; # stop/reset slave 停止主从关系 |

在linux30查询同步信息:

MariaDB [(none)]> show slave status\G;

1 | *************************** 1. row *************************** |

在linux31查询同步信息:

1 | MariaDB [(none)]> show slave status\G; |

Slave_IO_Running和Slave_SQL_Running 都是Yes,说明双主同步配置成功

KeepAlived安装与高可用配置

- 在linux30与linux31两台节点安装keepalived:

1 | [root@linux30 ~]# yum -y install keepalived |

- 关闭防火墙

1 | [root@linux30 ~]# systemctl stop firewalld |

- 设置主机名称:

linux30节点:

1 | [root@linux30 ~]# hostnamectl set-hostname linux30 |

linux31节点:

1 | [root@linux31 ~]# hostnamectl set-hostname linux31 |

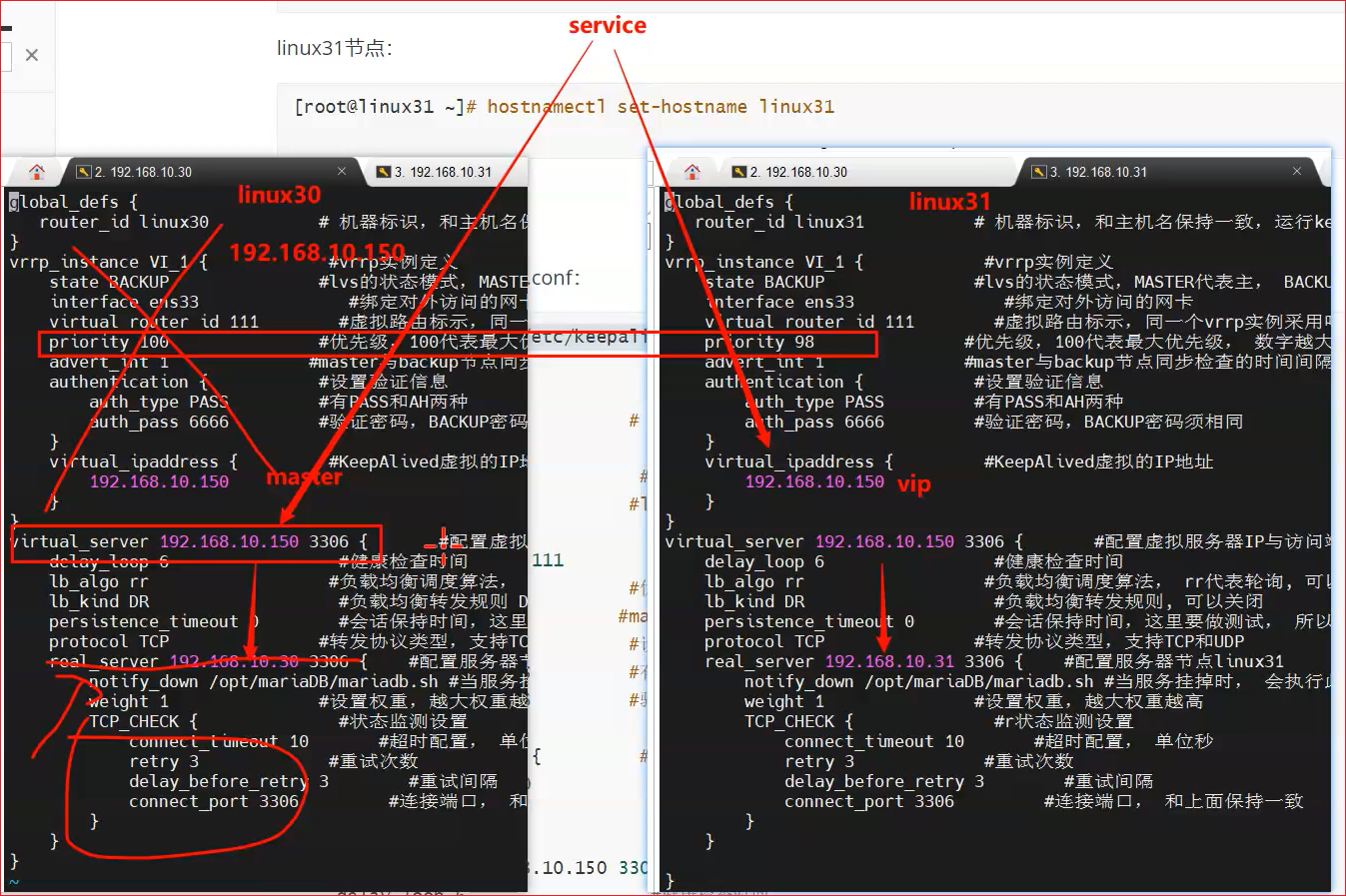

- linux30节点配置

/etc/keepalived/keepalived.conf:

1 | [root@linux30 ~]# vi /etc/keepalived/keepalived.conf |

创建关闭脚本mariadb.sh

1 | [root@linux30 mariaDB]# vi /opt/mariaDB/mariadb.sh |

加入执行权限:

1 | [root@linux30 mariaDB]# chmod a+x mariadb.sh |

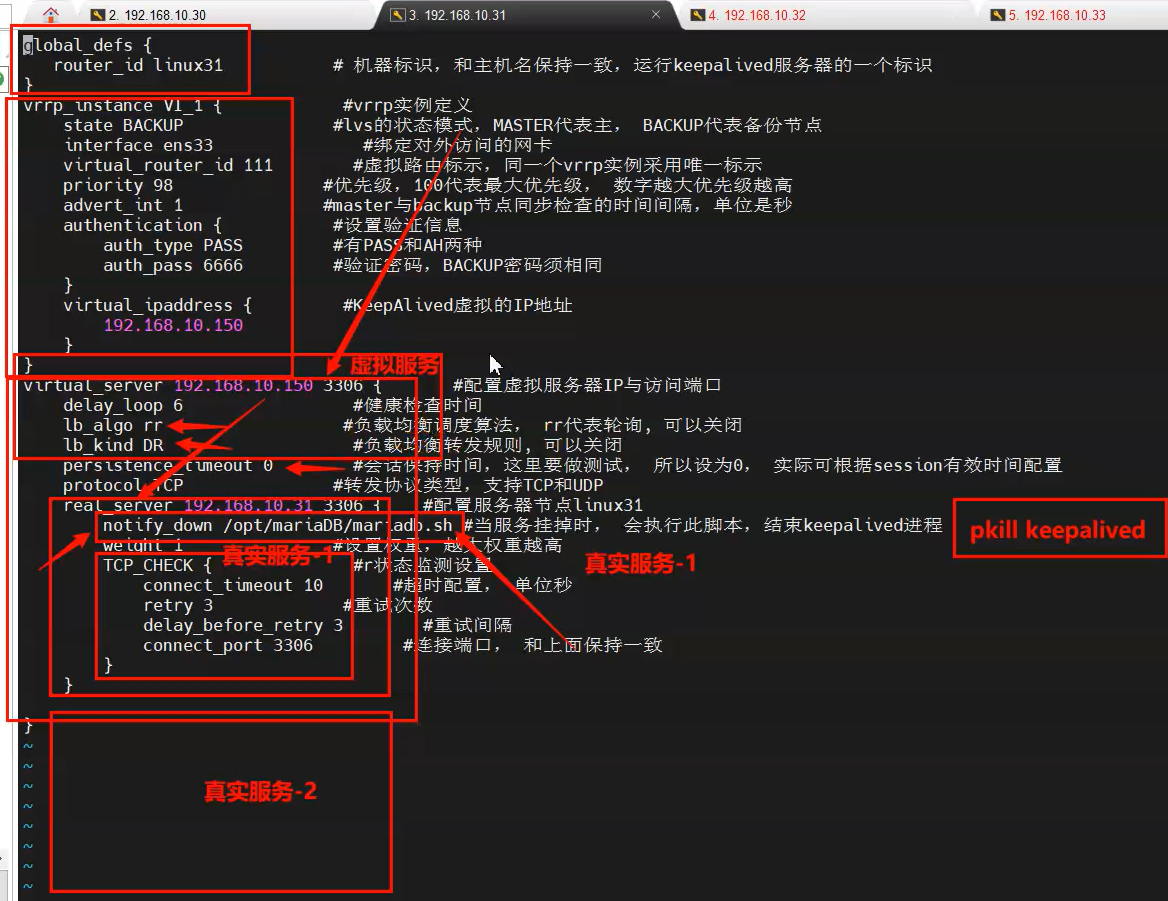

- linux31节点配置:

1 | [root@linux31 ~]# vi /etc/keepalived/keepalived.conf |

和linux30的差异项:

1 | router_id linux31 # 机器标识,和主机名保持一致 |

注意, 两台节点都设为BACKUP

1 | virtual_router_id 111 #同一个vrrp实例采用唯一标示 |

如果不想重启后, 争夺备用节点的VIP, 可以设置此项

1 | nopreempt #不主动抢占资源 |

注意:这个配置只能设置在backup主机上,而且这个主机优先级要比另外一台高

- 验证高可用

停止主节点MariaDB服务, 验证是否自动切换。

1 | [root@linux30 mariaDB]# systemctl start keepalived |

搭建应用服务工程

ShardingJDBC的介绍

是ShardingSphere 下的一个产品

定位为轻量级 Java 框架,在 Java 的 JDBC 层提供的额外服务。 它使用客户端直连数据库,以 jar包形式提供服务,无需额外部署和依赖,可理解为增强版的 JDBC 驱动,完全兼容 JDBC 和各种ORM 框架。

- 适用于任何基于 JDBC 的 ORM 框架,如:JPA, Hibernate, Mybatis, Spring JDBC Template 或直接使用 JDBC。

- 支持任何第三方的数据库连接池,如:DBCP, C3P0, BoneCP, Druid, HikariCP 等。

- 支持任意实现 JDBC 规范的数据库,目前支持 MySQL,Oracle,SQLServer,PostgreSQL 以及任何遵循 SQL92 标准的数据库

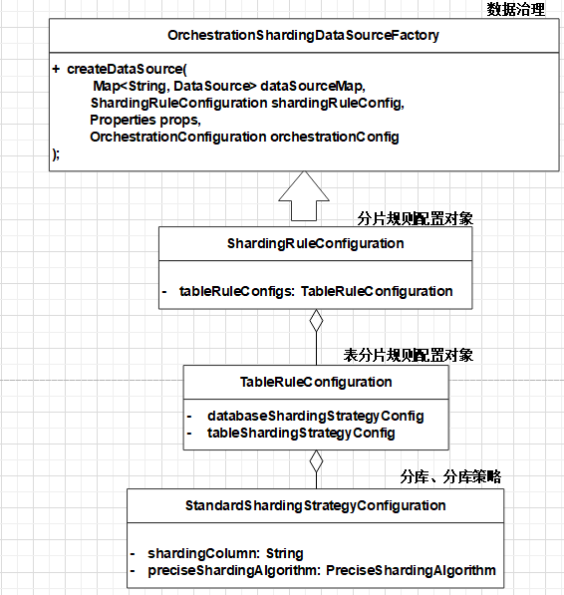

ShardingJDBC初始化流程

1)配置ShardingRuleConfiguration对象

2)配置表分片规则TableRuleConfiguration对象,设置分库、分表策略

3)通过Factory对象将Rule对象与DataSource对象装配

4)ShardingJDBC使用DataSource对象进行分库

ShardingJDBC集成配置

1)maven依赖

1 | <properties> |

2)规则配置application.yml

1 | server: |

3)创建DataSource

1 | package com.itcast.database.smooth.config; |

4)用到的枚举类

1 | package com.itcast.database.smooth.config; |

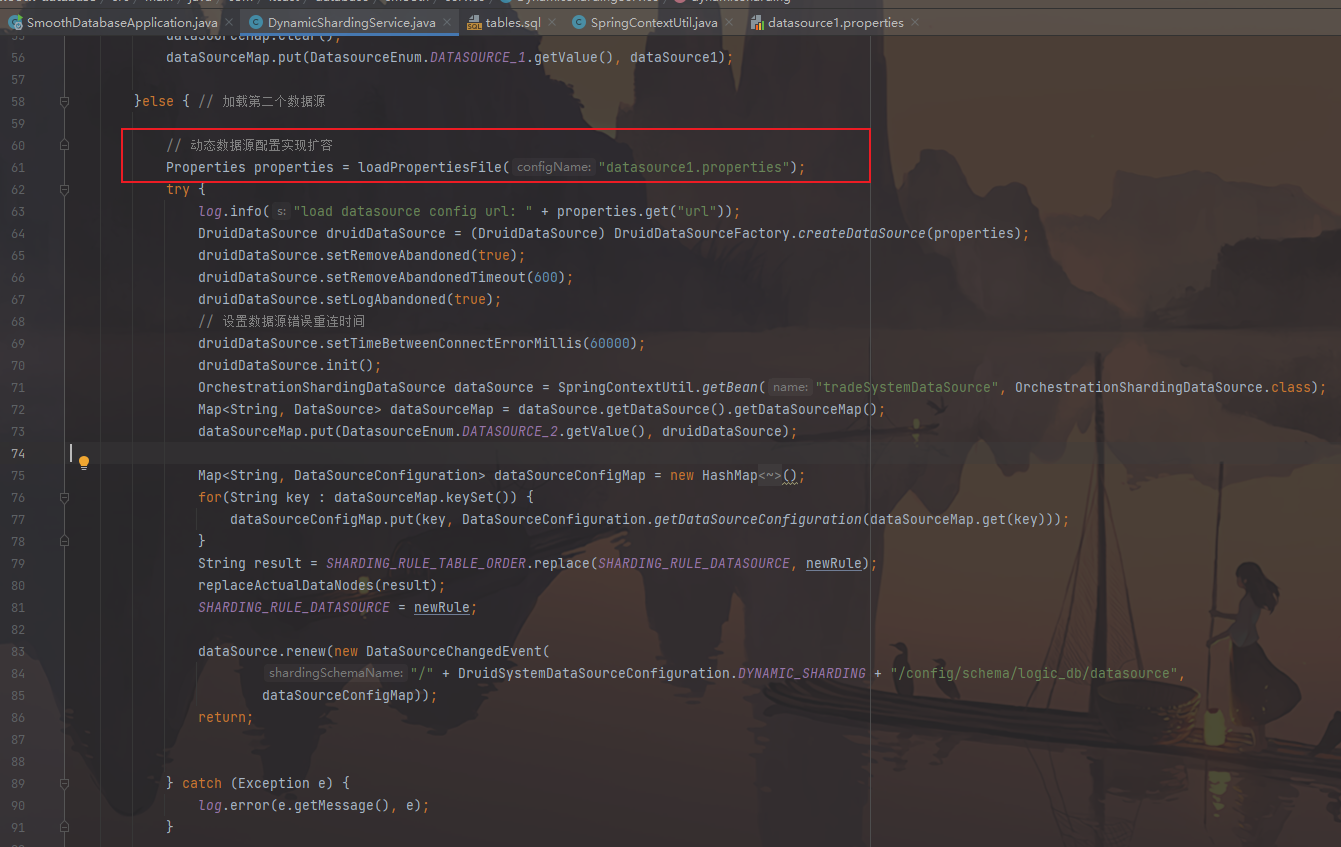

6) 动态分片服务

1 | /** |

分库规则

1 | package com.itcast.database.smooth.config; |

分表规则

这里只做了分库,没有分表

1 | package com.itcast.database.smooth.config; |

第二个数据源访问

1 | /** |

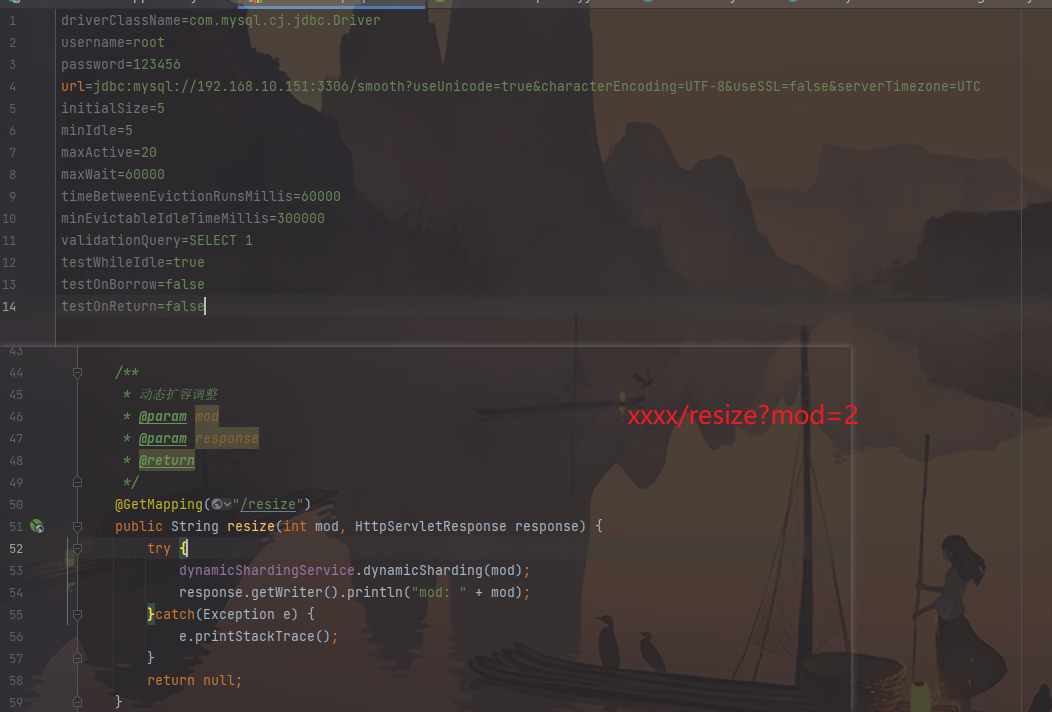

datasource1.properties

1 | driverClassName=com.mysql.cj.jdbc.Driver |

验证应用服务高可用

- 4.1 新增一条数据

- 4.2 停止linux30数据库,新增一条数据

- 4.3 重启linux30数据库和keepalived,新增一条数据

注意事项

Sharding JDBC, Mycat, Drds 等产品都是分布式数据库中间件, 相比直接的数据源操作, 会存在一些限制, Sharding JDBC在使用时, 要注意以下问题:

- 有限支持子查询

- 不支持HAVING

- 不支持OR,UNION 和 UNION ALL

- 不支持特殊INSERT

- 每条INSERT语句只能插入一条数据,不支持VALUES后有多行数据的语句

- 不支持DISTINCT聚合

- 不支持dual虚拟表查询

- 不支持SELECT LAST_INSERT_ID(), 不支持自增序列

- 不支持CASE WHEN

实现数据库的秒级平滑2N扩容

扩容部署架构:

新增数据库VIP

- 在linux31节点, 增加VIP

修改/etc/keepalived/keepalived.conf

1 | [root@linux31 mariaDB]# vi /etc/keepalived/keepalived.conf |

注意配置项:

1 | virtual_router_id 112 #虚拟路由标示,同一个vrrp实例采用唯一标示 |

应用服务增加动态数据源

- 修改应用服务配置, 增加新的数据源, 指向新设置的VIP: 192.168.10.151

- 通过应用服务接口, 动态扩容调整

解除原双主同步

mysql -uroot -p123456

- 进入linux30:

1 | MariaDB [(none)]> stop slave; |

- 进入linux31:

1 | MariaDB [(none)]> stop slave; |

- 通过应用服务接口验证数据是否解除同步

安装MariaDB扩容服务器

- 新建两台虚拟机, 分别为linux32和linux33。 2. 在linux32和linux33两台节点上安装MariaDB服务 参考2.1.1 MariaDB服务安装

- 配置linux32与linux30,实现新的双主同步

- linux32节点, 修改/etc/my.cnf:

1 | [root@linux32 ~]# vi /etc/my.cnf |

- 重启linux32数据库

1 | [root@linux32 ~]# service mariadb restart |

- 创建replica用于主从同步的用户:

1 | [root@linux32 ~]# mysql -uroot -p123456 |

- 在linux30节点,进行数据全量备份:

1 | [root@linux30 mariaDB]# mysqldump -uroot -p123456 --routines --single_transaction --master-data=2 --databases smooth > linux30.sql |

- 查看并记录master status信息

1 | MariaDB [(none)]> show master status; |

- 将备份的linux30.sql通过scp命令拷贝至linux32节点。

1 | [root@linux30 mariaDB]# scp linux30.sql root@192.168.10.32:/opt/mariaDB |

- 将数据还原至linux32节点:

1 | [root@linux32 mariaDB]# mysql -uroot -p123456 < /opt/mariaDB/linux30.sql |

- 配置主从同步信息

根据上面的master status信息, 在linux32中执行:

1 | MariaDB [(none)]> change master to master_host='192.168.10.30',master_user='replica', master_password='replica', master_port=3306, master_log_file='mysql-bin.000004', master_log_pos=3133, master_connect_retry=30; |

- 开启主从同步:

1 | MariaDB [(none)]> start slave; |

如果出现问题, 复原主从同步信息:

1 | MariaDB [(none)]> reset slave; |

- 检查同步状态信息:

1 | MariaDB [(none)]> show slave status \G; |

- 配置linux30与linux32节点的同步

查看linux32的日志信息:

1 | MariaDB [(none)]> show master status; |

在linux30节点, 配置同步信息:

1 | MariaDB [(none)]> reset slave; |

- 配置linux33与linux31的双主同步

1.linux33节点, 修改/etc/my.cnf:

1 | [root@linux33 ~]# vi /etc/my.cnf |

- 重启linux33数据库

1 | [root@linux33 ~]# service mariadb restart |

- 创建replica用于主从同步的用户:

1 | [root@linux33 ~]# mysql -uroot -p123456 |

- 在linux31节点,进行数据全量备份:

1 | [root@linux31 mariaDB]# mysqldump -uroot -p123456 --routines --single_transaction --master-data=2 --databases smooth > linux31.sql |

- 查看并记录master status信息

1 | [root@linux31 mariaDB]# mysql -uroot -p123456 |

- 将备份的linux31.sql通过scp命令拷贝至linux33节点。

1 | [root@linux31 mariaDB]# scp linux31.sql root@192.168.10.33:/opt/mariaDB |

- 将数据还原至linux33节点:

1 | [root@linux33 mariaDB]# mysql -uroot -p123456 < /opt/mariaDB/linux31.sql |

- 配置主从同步信息

根据上面的master status信息, 在linux33中执行

1 | [root@linux33 mariaDB]# mysql -uroot -p123456 |

- 开启主从同步:

1 | MariaDB [(none)]> start slave; |

注意, 如果出现问题, 复原主从同步信息:

1 | MariaDB [(none)]> reset slave; |

- 检查同步状态信息:

1 | MariaDB [(none)]> show slave status \G; |

- 配置linux31与linux33节点的同步

查看linux33的日志信息:

1 | MariaDB [(none)]> show master status; |

在linux31节点, 配置同步信息:

1 | [root@linux31 mariaDB]# mysql -uroot -p123456 |

增加KeepAlived服务实现高可用

- 确保新增的linux32和linux33节点安装Keepalived服务。

- 修改linux32节点配置

1 | [root@linux32 mariaDB]# vi /etc/keepalived/keepalived.conf |

注意里面IP配置正确, 修改完成后重启服务。

1 | [root@linux32 mariaDB]# systemctl restart keepalived |

创建关闭脚本mariadb.sh

1 | [root@linux32 mariaDB]# vi /opt/mariaDB/mariadb.sh |

加入执行权限:

1 | chmod a+x mariadb.sh |

- 修改linux33节点配置

1 | [root@linux33 mariaDB]# vi /etc/keepalived/keepalived.conf |

创建关闭脚本mariadb.sh

1 | [root@linux33 mariaDB]# vi /opt/mariaDB/mariadb.sh |

给所有的用户组加入执行权限

1 | chmod a+x mariadb.sh |

- 修改完后重启Keepalived服务。

1 | [root@linux33 mariaDB]# systemctl restart keepalived |

清理数据并验证

- 通过应用服务动态扩容接口做调整和验证

- 在linux30节点清理数据 根据取模规则, 保留accountNo为偶数的数据

1 | delete from smooth.t_trade_order where accountNo % 2 != 0; |

- 在linux31节点清理数据 根据取模规则, 保留accountNo为奇数的数据

1 | delete from smooth.t_trade_order where accountNo % 2 != 1; |

🔖MySQL调优

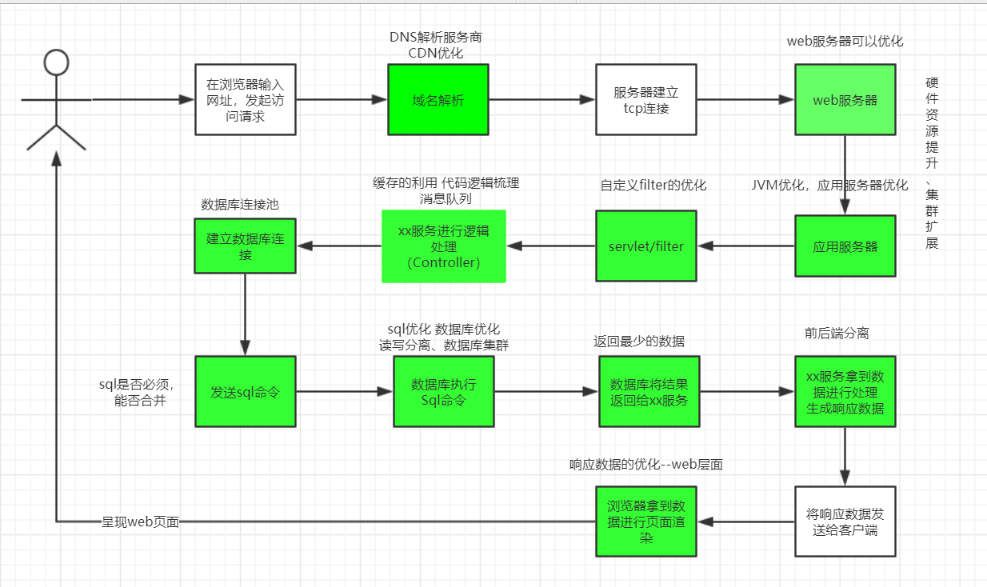

Web优化

背景

老板说系统反应慢,要求提高速度,怎么办?

客户反馈系统响应太慢,体验差,怎么办?

问题:

性能优化时常见的事,概念广,在web应用中,不管前后端,或是单点/分布式系统。都涉及性能调优。

Web访问流程性能优化

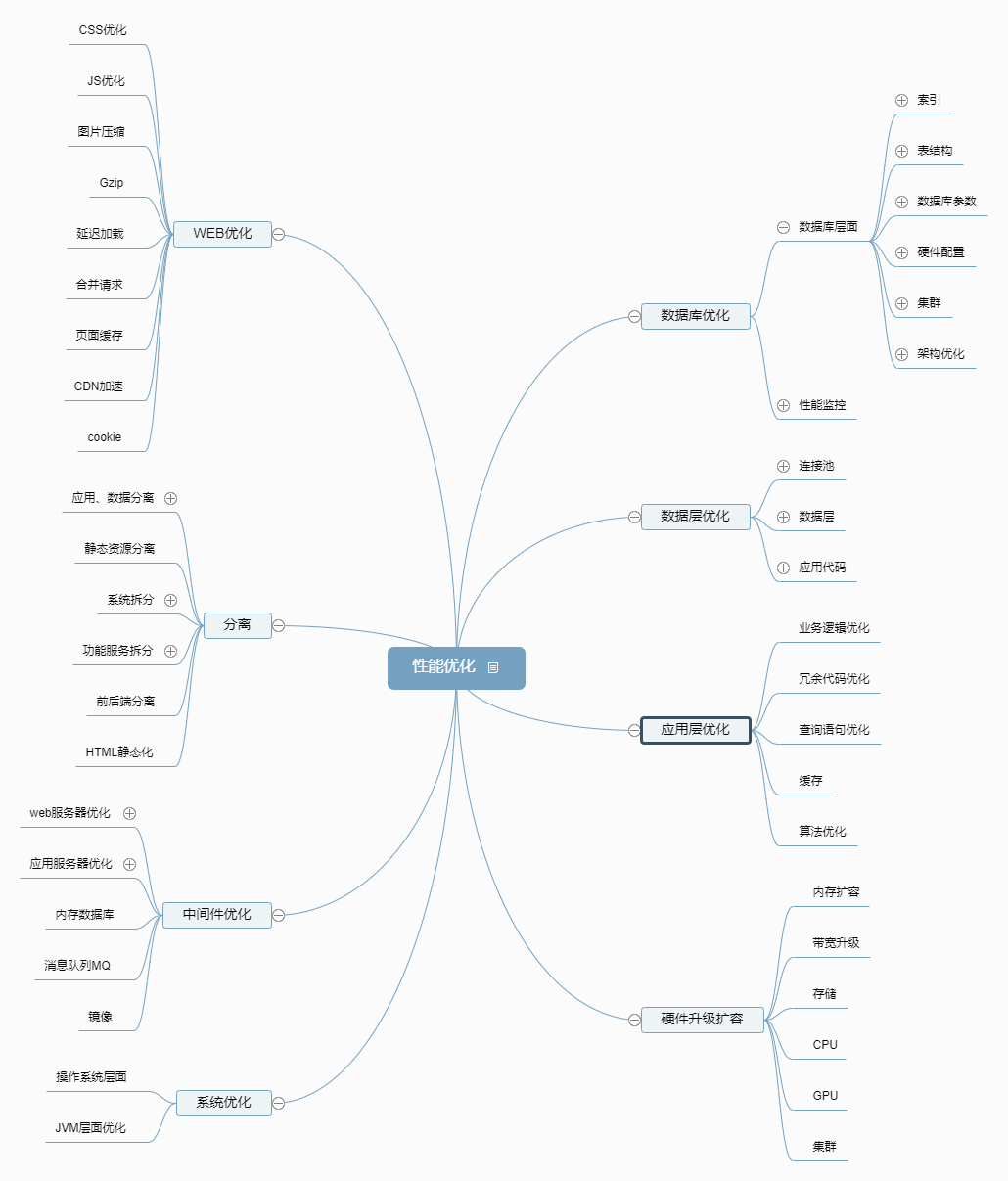

性能优化脑图

原则

- 适度优化,切忌过度优化

- 先优化最大瓶颈,事半功倍

- 依据数据而不是凭空猜测

- 性能优化是持久战,道高一尺魔高一丈

- 深入理解业务

数据库性能优化法则

木桶理论

木桶理论和性能优化有何关系 性能优化应该首先要找到系统的短板在哪里,优先对短板进行优化处理。 性能优化中短板举例 大多数情况性能最慢的设备会是瓶颈点:

- 如下载时网络速度可能会是瓶颈点

- 本地复制文件时硬盘可能会是瓶颈点

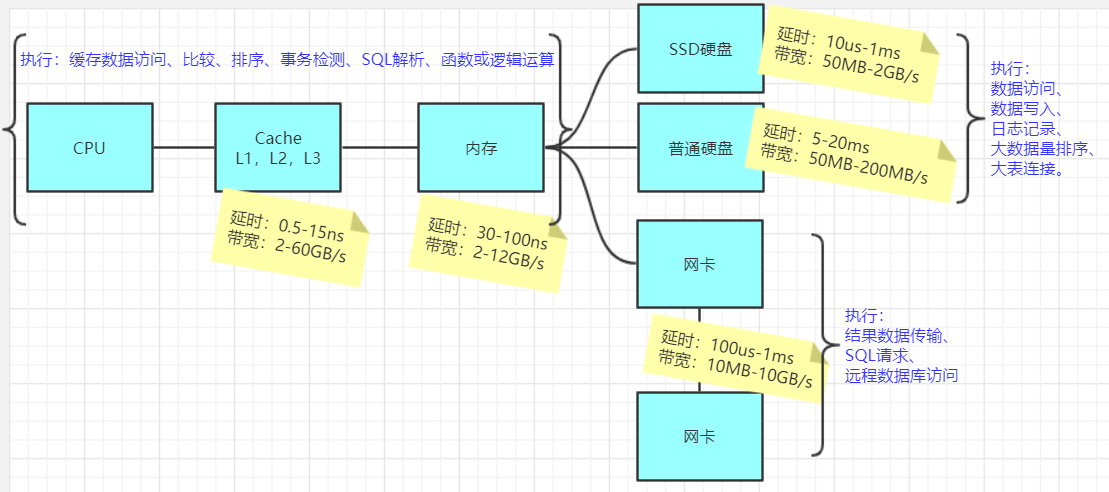

数据库IO各层性能分析

数据库本质: 数据库本质上是查找磁盘物理文件的过程,而这个过程必然涉及到IO操作。

数据库IO短板分析

因此,为了快速找到SQL的性能瓶颈点,我们有必要了解下数据库相关IO的性能情况,也就是计算机系统的硬件基本性能指标,下图展示的当前主流计算机性能指标数据。

相关指标:

- 延时(响应时间):表示硬件的突发处理能力;

- 带宽(吞吐量):代表硬件持续处理能力。

性能从高到低排序:

- CPU > Cache(L1-L2-L3) > 内存 > SSD硬盘 > 网络 > 普通硬盘

优化从倒序去优化,符合木桶理论,也就是短板最可能出现在磁盘。也就是漏斗法则中的先优化磁盘访问,效果最明显。

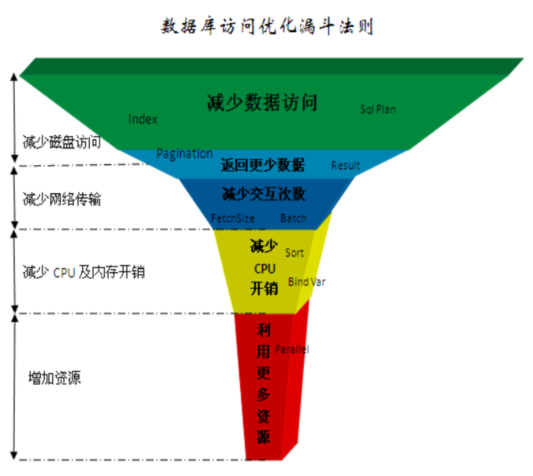

数据库优化漏斗法则

这个优化法则归纳为5个层次:

- 减少数据访问(减少磁盘访问)

- 返回更少数据(减少网络传输或磁盘访问)

- 减少交互次数(减少网络传输)

- 减少服务器CPU开销(减少CPU及内存开销)

- 利用更多资源(增加资源)

说明

- 由于每一层优化法则都是解决其对应硬件的性能问题,所以带来的性能提升比例也不一样。

- 针对低速设备问题的可优化手段更多,优化成本也更低。

- 任何一个SQL的性能优化都应该按这个规则由上到下来诊断问题并提出解决方案,而不应该首先想到的是增加资源解决问题。

优化效果

案例引入

案例演示:在表里插入1000条数据

执行时间变化:235.945s—-> 1.685s

性能变化:同样都是插入1000条数据,为什么性能变化接近200倍?

MySQL架构设计

引言

查询语句:

1 | select * from user_info where id = 1; |

返回结果为:o

1 | +----+----------+----------+--------+------+---------------------+---------------------+ |

问题:

- 思考:一条SQL查询语句是如何执行的?

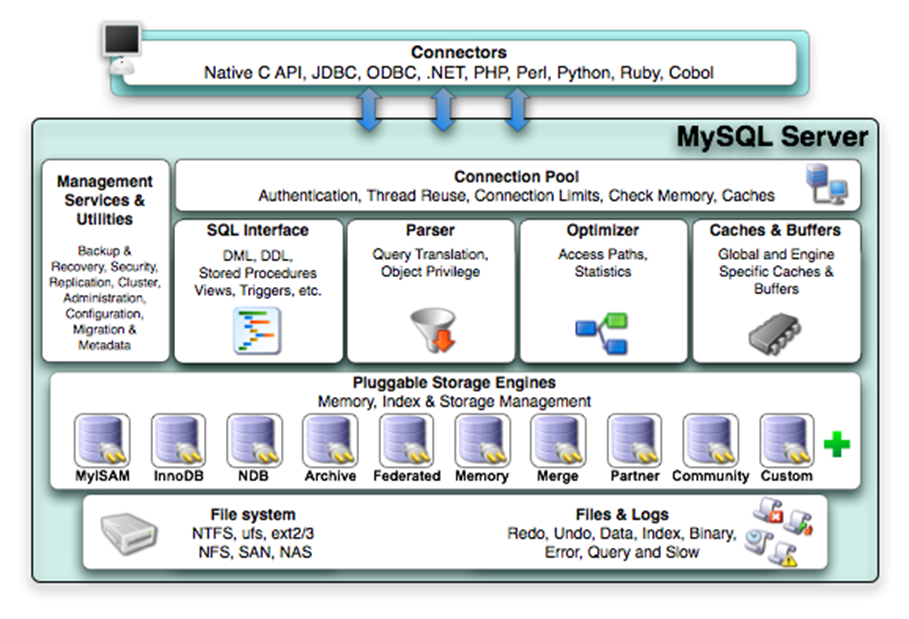

Server层

MySQL 架构可以分为 Server层 和 Engine层两部分:

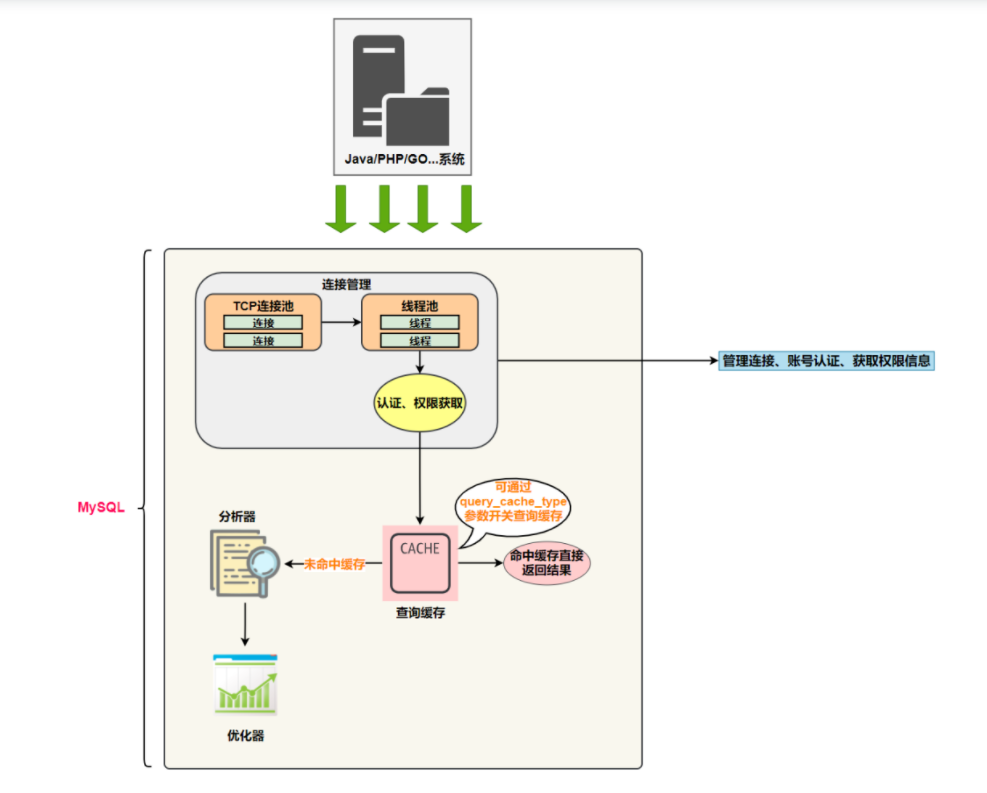

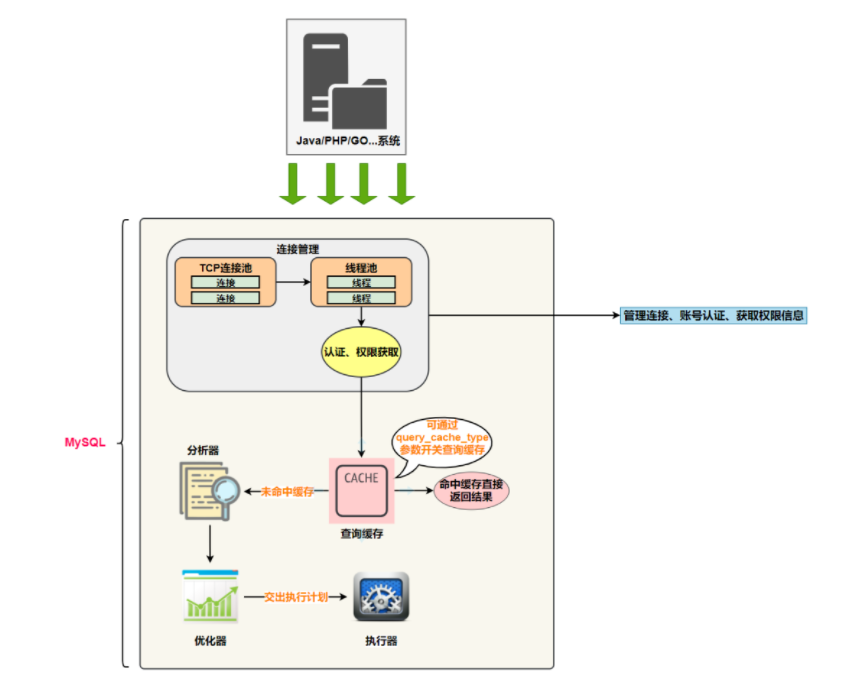

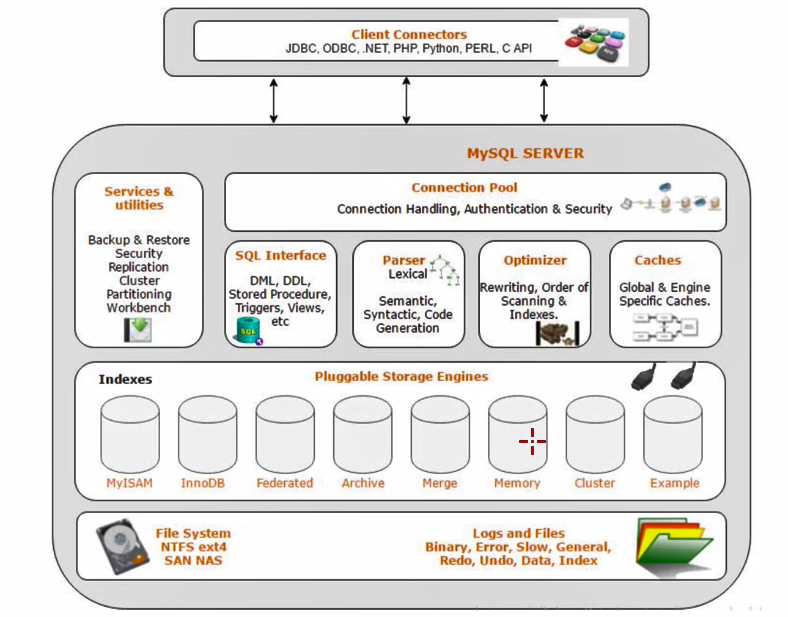

MySQL 的逻辑架构图

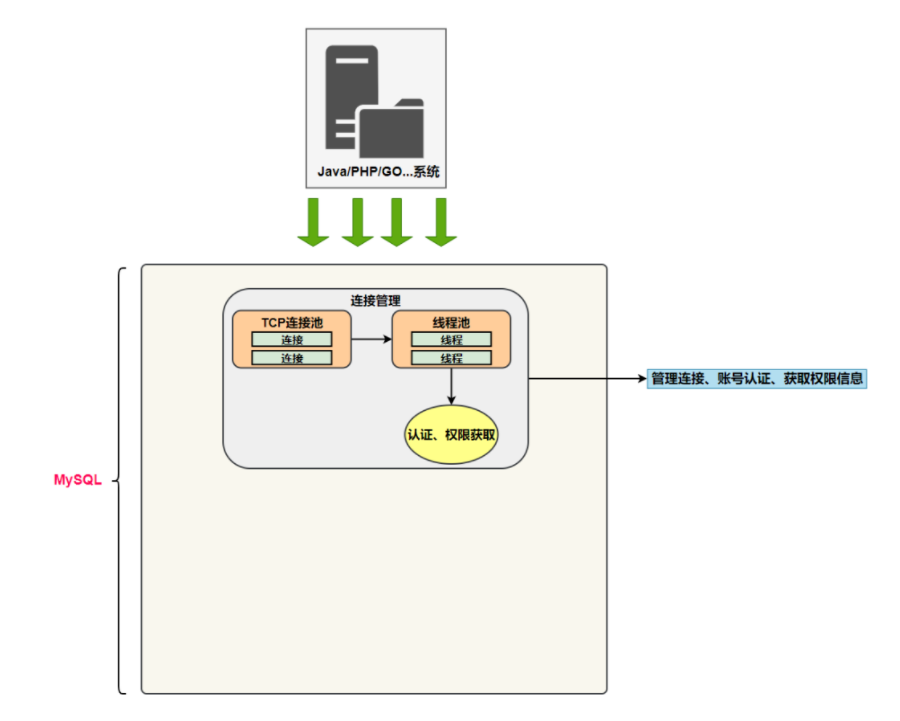

连接器(Connector)

Mysql作为服务器,一个客户端的Sql连接过来就需要分配一个线程进行处理,这个线程会专门负责监听请求并读取数据。这部分的线程和连接管理都是有一个连接器,专门负责跟客户端建立连接、权限认证、维持和管理连接。

思考:

(1)一个客户端只会和MySQL服务器建立一个连接吗?

(2)只能有一个客户端和MySQL服务器建立连接吗?

答:

多个系统都可以和MySQL服务器建立连接,每个系统建立的连接肯定不止一个。

所以,为了解决TCP无限创建与TCP频繁创建销毁带来的资源耗尽、性能下降问题。

MySQL服务器里有专门的TCP连接池限制接数,采用长连接模式复用TCP连接,来解决上述问题。

TCP连接收到请求后,必须要分配给一个线程去执行,所以还会有个线程池,去走后面的流程。

连接器负责跟客户端建立连接、获取权限、维持和管理连接。

连接命令一般是这么写的:

1 | mysql -h$ip -P$port -u$user -p |

在完成 经典TCP 握手后,连接器会基于用户名和密码来验证身份。

- 验证不通过:”Access denied for user”错误

- 验证通过:连接器会到权限表里面查出拥有的权限,之后,这个连接里面的权限判断逻辑,都将依赖于此时读到的权限

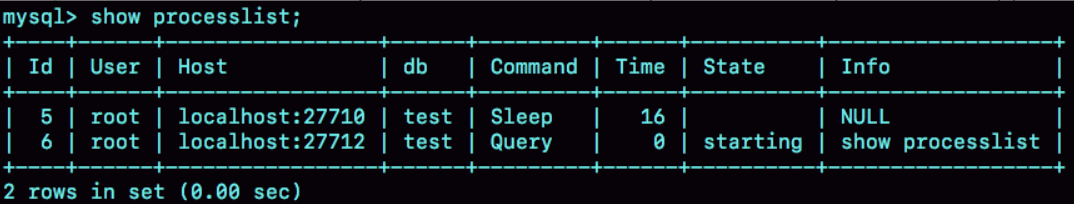

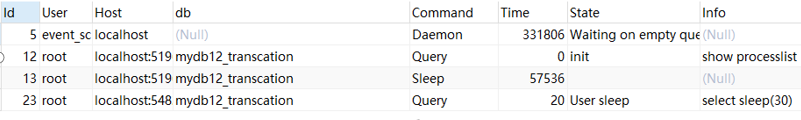

1 | show processlist -- 查看连接状态 |

图中的 Command 列显示为“Sleep”的这一行,就表示现在系统里面有一个空闲连接。

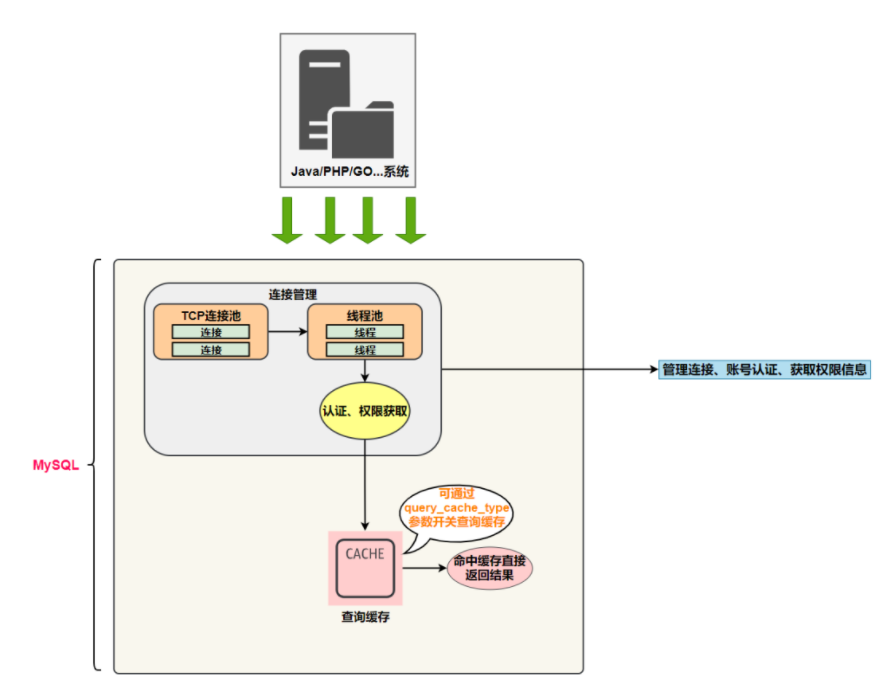

查询缓存(Query Cache)

经过了连接管理,现在MySQL服务器已经获取到SQL字符串。

执行逻辑就会来到第二步:查询缓存

查询语句,MySQL服务器会使用select SQL字符串作为key,去缓存中获取:

- 缓存命中,直接返回结果

- 缓存未命中:执行后面的阶段,执行完成后,执行结果会被存入查询缓存中

缓存中数据:key:(查询的语句) value:(查询的结果)

注意:但是大多数情况下建议不要使用查询缓存,为什么呢?因为查询缓存往往弊大于利

- 查询缓存的失效非常频繁,只要有对一个表的更新,这个表上所有的查询缓存都会被清空

- 5.x版本可以按需使用”的方式。可以将参数 query_cache_type 设置成 DEMAND,这样对于默认的 SQL 语句都不使用查询缓存。而对于确定要使用查询缓存的语句,可以用 SQL_CACHE 显式指定例:

1 | mysql> select SQL_CACHE * from T where ID=10; |

- MySQL 8.0 版本直接将查询缓存的整块功能删掉了,也就是说 8.0 开始彻底没有这个功能了

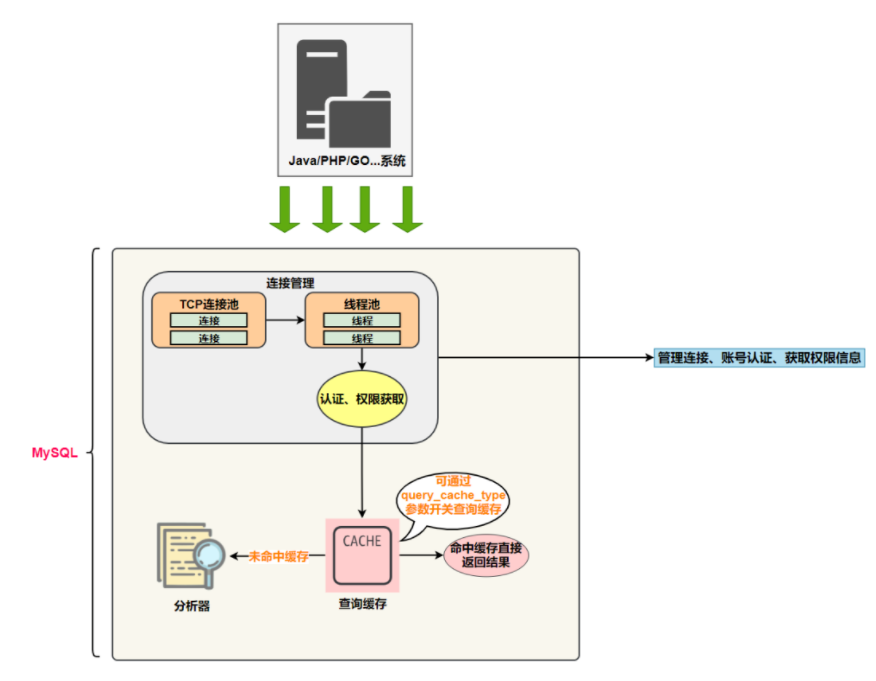

分析器(Analyzer)

缓存如果未命中,就要开始真正执行语句了

首先,MySQL 需要知道要做什么,因此需要对 SQL 语句做解析

- 词法分析